LLM を超えて: 小規模言語モデルが AI の未来である理由がここにあります

Open AI の ChatGPT のリリースにより、大規模言語モデル (LLM) が登場しました。それ以来、いくつかの企業も LLM を立ち上げましたが、現在は小規模言語モデル (SLM) に傾いている企業が増えています。

SLM は勢いを増していますが、SLM とは何ですか?また、LLM との違いは何ですか?

小規模言語モデルとは何ですか?

小規模言語モデル (SLM) は、パラメーターが少ない人工知能モデルの一種です (これは、トレーニング中に学習されたモデルの値であると考えてください)。より大きな対応物と同様に、SLM はテキストを生成し、他のタスクを実行できます。ただし、SLM はトレーニングに使用するデータセットが少なく、パラメーターも少なく、トレーニングと実行に必要な計算能力も少なくなります。

SLM は主要な機能に焦点を当てており、フットプリントが小さいため、さまざまなデバイスに導入できます。モバイル デバイスのようなハイエンド ハードウェアを備えていない場合。たとえば、Google の Nano は、モバイル デバイス上で動作する、ゼロから構築されたオンデバイス SLM です。同社によれば、Nano はサイズが小さいため、ネットワーク接続の有無にかかわらずローカルで実行できます。

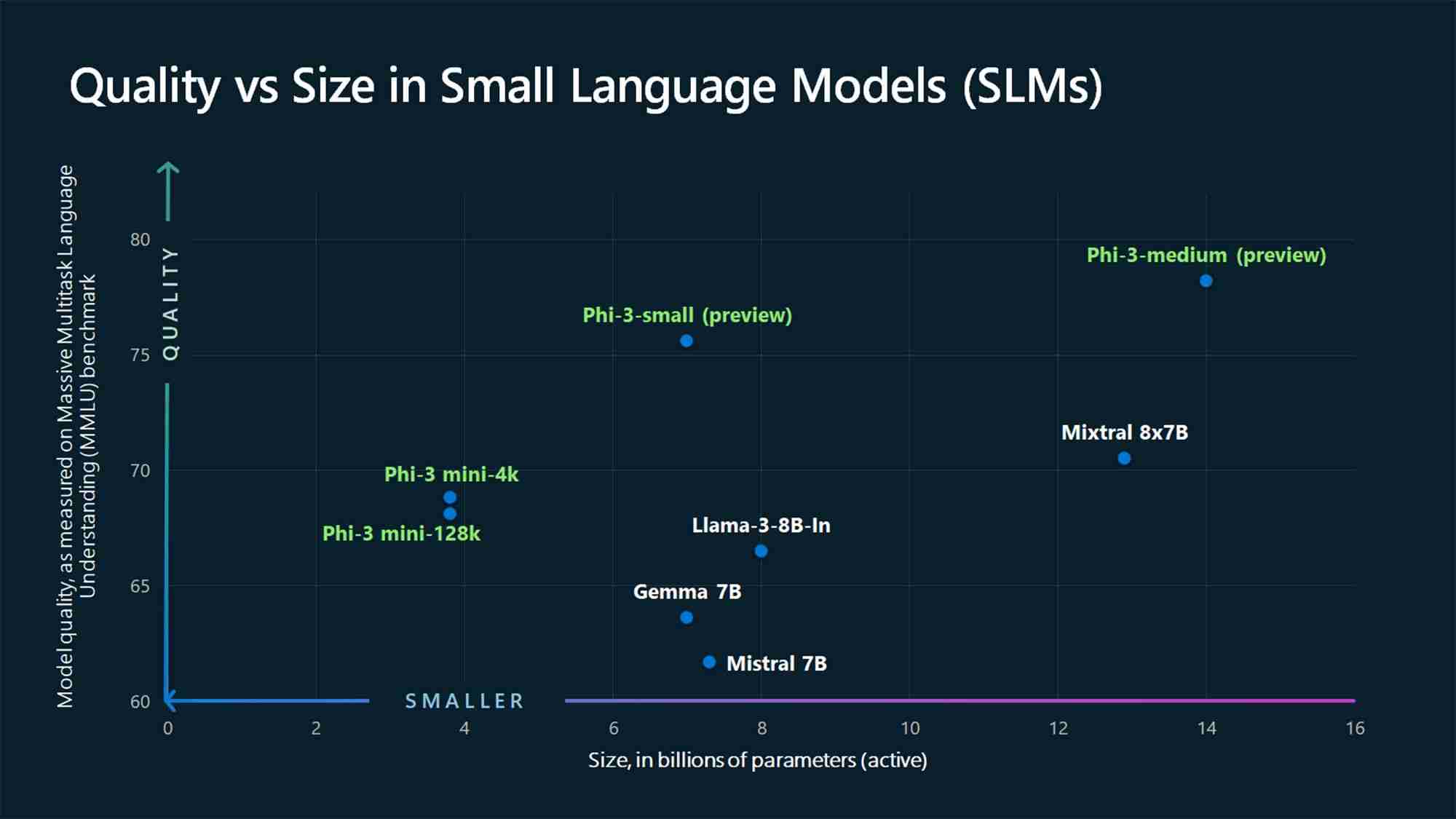

Nano 以外にも、AI 分野では有力企業や今後の企業から多数の SLM が提供されています。人気のある SLM には、Microsoft の Phi-3、OpenAI の GPT-4o mini、Anthropic の Claude 3 Haiku、Meta の Llama 3、Mistral AI の Mixtral 8x7B などがあります。

他のオプションも利用できます。これらは LLM だと思われるかもしれませんが、実際にはそうではありません。 SLM。これは、ほとんどの企業がポートフォリオで複数の言語モデルをリリースし、LLM と SLM の両方を提供するマルチモデル アプローチを採用していることを考慮すると、特に当てはまります。一例として GPT-4 があり、GPT-4、GPT-4o (Omni)、GPT-4o mini などのさまざまなモデルがあります。

小規模言語モデルと大規模言語モデル

SLM について議論するとき、その大きな対応物である LLM を無視することはできません。 SLM と LLM の主な違いは、パラメーターの観点から測定されるモデル サイズです。

この記事の執筆時点では、モデルに使用すべきパラメーターの最大数について AI 業界で合意はありません。 SLM と見なされるには超過するか、LLM と見なされるために必要な最小数を超えます。ただし、SLM には通常、数百万から数十億のパラメータがありますが、LLM にはさらに多く、数兆にも達します。

たとえば、2020 年にリリースされた GPT-3 には 1,750 億のパラメータがあります (そしてGPT-4 モデルは約 1 兆 7,600 億個あると噂されています)、一方、Microsoft の 2024 年の Phi-3-mini、Phi-3-small、および Phi-3-medium SLM は、それぞれ 38 億個、7 億個、140 億個のパラメーターを測定します。

SLM と LLM を区別するもう 1 つの要因は、トレーニングに使用されるデータの量です。 SLM は少量のデータでトレーニングされますが、LLM は大規模なデータセットを使用します。この違いは、複雑なタスクを解決するモデルの能力にも影響します。

トレーニングでは大規模なデータが使用されるため、LLM は高度な推論を必要とするさまざまなタイプの複雑なタスクを解決するのに適していますが、SLM はより単純なタスクに適しています。タスク。 LLM とは異なり、SLM は使用するトレーニング データが少なくなりますが、LLM にある機能の多くを小さなパッケージで実現するには、使用するデータの品質が高くなる必要があります。

小さな言語モデルが未来である理由

ほとんどのユースケースでは、SLM は企業や消費者がさまざまなタスクを実行するために使用する主流モデルになるのに適しています。確かに、LLM には利点があり、複雑なタスクの解決など、特定の使用例により適しています。ただし、次の理由により、ほとんどのユースケースでは SLM が将来の選択肢となります。

1. トレーニングとメンテナンスのコストが低い

SLM は、LLM よりもトレーニングに必要なデータが少ないため、トレーニング データ、財務、またはその両方が限られている個人および中小企業にとって、最も実行可能なオプションです。 LLM は大量のトレーニング データを必要とし、ひいてはトレーニングと実行の両方に膨大な計算リソースを必要とします。

これを大局的に考えると、OpenAI の CEO、サム アルトマンは、トレーニングに 1 億ドル以上かかったと認めました。 MITのイベントで講演中のGPT-4(Wiredによる)。別の例は、Meta の OPT-175B LLM です。 CNBC によると、Meta は 992 個の NVIDIA A100 80GB GPU を使用してトレーニングされたと述べており、そのコストは 1 台あたり約 10,000 ドルです。エネルギーや給与などの他の経費を含まない場合、コストは約 900 万ドルになります。

このような数字では、中小企業が LLM をトレーニングするのは現実的ではありません。対照的に、SLM はリソースの面で参入障壁が低く、運営コストも低いため、より多くの企業がこれを採用するでしょう。

2. パフォーマンスの向上

パフォーマンスももう 1 つの問題です。 SLM はそのコンパクトなサイズにより LLM に勝る領域です。 SLM は遅延が少なく、リアルタイム アプリケーションなど、より高速な応答が必要なシナリオに適しています。たとえば、デジタル アシスタントなどの音声応答システムでは、より迅速な応答が好まれます。

デバイス上で実行する (これについては後ほど説明します) ということは、リクエストがオンライン サーバーに行ったり戻ったりする必要がないことも意味します。

3. より正確

生成 AI に関しては、変わらないことが 1 つあります。それは、ゴミが入ってゴミが出るということです。現在の LLM は、生のインターネット データの大規模なデータセットを使用してトレーニングされています。したがって、すべての状況で正確であるとは限りません。これは ChatGPT や同様のモデルの問題の 1 つであり、AI チャットボットの発言すべてを信頼すべきではない理由です。一方、SLM は LLM よりも高品質のデータを使用してトレーニングされるため、精度が高くなります。

SLM は、特定のタスクやドメインに焦点を当てたトレーニングでさらに微調整することもでき、それらのタスクやドメインの精度が向上します。

4. オンデバイスで実行可能

SLM は LLM よりも必要な計算能力が低いため、エッジ コンピューティングのケースに最適です。これらは、大きな計算能力やリソースを持たないスマートフォンや自動運転車などのエッジ デバイスに導入できます。 Google の Nano モデルはデバイス上で実行できるため、アクティブなインターネット接続がない場合でも機能します。

この機能は、企業と消費者の両方に有利な状況をもたらします。まず、ユーザー データがクラウドに送信されるのではなくローカルで処理されるため、プライバシーが確保されます。これは、スマートフォンに AI が統合され、私たちに関するほぼすべての詳細が含まれるようになるにつれて重要になります。 AI タスクを処理するために大規模なサーバーを展開して実行する必要がないため、企業にとってもメリットがあります。

SLM は、Open AI、Google、Microsoft、 Anthropic、Metaなどからはそんなモデルがリリースされています。これらのモデルは、私たちのほとんどが LLM を使用する単純なタスクにより適しています。したがって、LLM は未来です。

しかし、LLM はどこにも行きません。代わりに、医学研究など、さまざまなドメインの情報を組み合わせて新しいものを生み出す高度なアプリケーションに使用されることになります。

-

8 LLMの本質的な無料および有料API推奨事項LLMSの力の活用:大規模な言語モデルのAPIのガイド 今日のダイナミックなビジネスランドスケープでは、API(アプリケーションプログラミングインターフェイス)がAI機能の統合と利用方法に革命をもたらしています。 それらは重要な橋として機能し、大規模な言語モデル(LLM)を多様なソフトウェアエコ...AI 2025-04-21に投稿されました

8 LLMの本質的な無料および有料API推奨事項LLMSの力の活用:大規模な言語モデルのAPIのガイド 今日のダイナミックなビジネスランドスケープでは、API(アプリケーションプログラミングインターフェイス)がAI機能の統合と利用方法に革命をもたらしています。 それらは重要な橋として機能し、大規模な言語モデル(LLM)を多様なソフトウェアエコ...AI 2025-04-21に投稿されました -

ユーザーガイド:FALCON 3-7B指示モデルTIIのファルコン3:オープンソースの革新的な飛躍ai TIIのAIの再定義の野心的な追求は、Advanced Falcon 3モデルで新たな高みに達します。 この最新のイテレーションは、新しいパフォーマンスベンチマークを確立し、オープンソースAIの機能を大幅に進めます。 Falcon 3...AI 2025-04-20に投稿しました

ユーザーガイド:FALCON 3-7B指示モデルTIIのファルコン3:オープンソースの革新的な飛躍ai TIIのAIの再定義の野心的な追求は、Advanced Falcon 3モデルで新たな高みに達します。 この最新のイテレーションは、新しいパフォーマンスベンチマークを確立し、オープンソースAIの機能を大幅に進めます。 Falcon 3...AI 2025-04-20に投稿しました -

deepseek-v3対gpt-4oおよびllama 3.3 70b:明らかにされた最強のAIモデルThe evolution of AI language models has set new standards, especially in the coding and programming landscape. Leading the c...AI 2025-04-18に投稿されました

deepseek-v3対gpt-4oおよびllama 3.3 70b:明らかにされた最強のAIモデルThe evolution of AI language models has set new standards, especially in the coding and programming landscape. Leading the c...AI 2025-04-18に投稿されました -

トップ5 AIインテリジェントな予算編成ツールAIで金融の自由のロックを解除:インドのトップ予算編成アプリ あなたはあなたのお金がどこに行くのか絶えず疑問に思ってうんざりしていますか? 法案はあなたの収入をむさぼり食うようですか? 人工知能(AI)は強力なソリューションを提供します。 AI予算編成ツールは、リアルタイムの財務洞察、パーソナ...AI 2025-04-17に投稿されました

トップ5 AIインテリジェントな予算編成ツールAIで金融の自由のロックを解除:インドのトップ予算編成アプリ あなたはあなたのお金がどこに行くのか絶えず疑問に思ってうんざりしていますか? 法案はあなたの収入をむさぼり食うようですか? 人工知能(AI)は強力なソリューションを提供します。 AI予算編成ツールは、リアルタイムの財務洞察、パーソナ...AI 2025-04-17に投稿されました -

Excel Sumproduct機能の詳細な説明 - データ分析学校Excelの等式関数:データ分析Powerhouse 合理化されたデータ分析のためのExcelの等式関数の力のロックを解除します。この汎用性のある関数は、合計と乗算機能を簡単に組み合わせて、対応する範囲または配列全体の追加、減算、および分割に拡張します。 傾向を分析するか、複雑な計算に取り組む...AI 2025-04-16に投稿されました

Excel Sumproduct機能の詳細な説明 - データ分析学校Excelの等式関数:データ分析Powerhouse 合理化されたデータ分析のためのExcelの等式関数の力のロックを解除します。この汎用性のある関数は、合計と乗算機能を簡単に組み合わせて、対応する範囲または配列全体の追加、減算、および分割に拡張します。 傾向を分析するか、複雑な計算に取り組む...AI 2025-04-16に投稿されました -

詳細な調査は完全にオープンで、ChatGptとユーザーの利点がありますOpenaiの深い研究:AI研究のためのゲームチェンジャー Openaiは、すべてのChatGPTと加入者の深い研究を解き放ち、研究効率の大幅な後押しを約束しています。 Gemini、Grok 3、Perplexityなどの競合他社から同様の機能をテストした後、Openaiの深い研究を優れた選...AI 2025-04-16に投稿されました

詳細な調査は完全にオープンで、ChatGptとユーザーの利点がありますOpenaiの深い研究:AI研究のためのゲームチェンジャー Openaiは、すべてのChatGPTと加入者の深い研究を解き放ち、研究効率の大幅な後押しを約束しています。 Gemini、Grok 3、Perplexityなどの競合他社から同様の機能をテストした後、Openaiの深い研究を優れた選...AI 2025-04-16に投稿されました -

Amazon Nova Today Real Experience and Review -AnalyticsVidhyaAmazonがNovaを発表する:強化されたAIおよびコンテンツ作成のための最先端の基礎モデル Amazonの最近のRe:Invent 2024イベントは、AIとコンテンツの作成に革命をもたらすように設計された、最も高度な基礎モデルのスイートであるNovaを紹介しました。この記事では、Novaの...AI 2025-04-16に投稿されました

Amazon Nova Today Real Experience and Review -AnalyticsVidhyaAmazonがNovaを発表する:強化されたAIおよびコンテンツ作成のための最先端の基礎モデル Amazonの最近のRe:Invent 2024イベントは、AIとコンテンツの作成に革命をもたらすように設計された、最も高度な基礎モデルのスイートであるNovaを紹介しました。この記事では、Novaの...AI 2025-04-16に投稿されました -

ChatGPTタイミングタスク関数を使用する5つの方法ChatGptの新しいスケジュールされたタスク:ai で一日を自動化する ChatGptは最近、ゲームを変える機能:スケジュールされたタスクを導入しました。 これにより、ユーザーはオフライン中であっても、所定の時期に通知または応答を受信して、繰り返しプロンプトを自動化できます。毎日のキュレ...AI 2025-04-16に投稿されました

ChatGPTタイミングタスク関数を使用する5つの方法ChatGptの新しいスケジュールされたタスク:ai で一日を自動化する ChatGptは最近、ゲームを変える機能:スケジュールされたタスクを導入しました。 これにより、ユーザーはオフライン中であっても、所定の時期に通知または応答を受信して、繰り返しプロンプトを自動化できます。毎日のキュレ...AI 2025-04-16に投稿されました -

3つのAIチャットボットのうち、同じプロンプトに応答するのはどれですか?Claude、ChatGpt、Geminiなどのオプションを使用して、チャットボットを選択すると圧倒的に感じることができます。ノイズを切り抜けるために、同一のプロンプトを使用して3つすべてをテストに入れて、どちらが最良の応答を提供するかを確認します。すべてのツールと同様に、出力はそれを使用す...AI 2025-04-15に投稿されました

3つのAIチャットボットのうち、同じプロンプトに応答するのはどれですか?Claude、ChatGpt、Geminiなどのオプションを使用して、チャットボットを選択すると圧倒的に感じることができます。ノイズを切り抜けるために、同一のプロンプトを使用して3つすべてをテストに入れて、どちらが最良の応答を提供するかを確認します。すべてのツールと同様に、出力はそれを使用す...AI 2025-04-15に投稿されました -

chatgptで十分で、専用のAIチャットマシンは必要ありません新しいAIチャットボットが毎日起動している世界では、どちらが正しい「1つ」であるかを決定するのは圧倒的です。しかし、私の経験では、CHATGPTは、プラットフォーム間を切り替える必要なく、私が投げたすべてのものを、少し迅速なエンジニアリングで処理します。 スペシャリストAIチャットボットは、多く...AI 2025-04-14に投稿されました

chatgptで十分で、専用のAIチャットマシンは必要ありません新しいAIチャットボットが毎日起動している世界では、どちらが正しい「1つ」であるかを決定するのは圧倒的です。しかし、私の経験では、CHATGPTは、プラットフォーム間を切り替える必要なく、私が投げたすべてのものを、少し迅速なエンジニアリングで処理します。 スペシャリストAIチャットボットは、多く...AI 2025-04-14に投稿されました -

インドのAIの瞬間:生成AIにおける中国と米国との競争インドのAI野心:2025アップデート 中国と米国が生成AIに多額の投資をしているため、インドは独自のGenaiイニシアチブを加速しています。 インドの多様な言語的および文化的景観に対応する先住民族の大手言語モデル(LLMS)とAIツールの緊急の必要性は否定できません。 この記事では、インドの急...AI 2025-04-13に投稿されました

インドのAIの瞬間:生成AIにおける中国と米国との競争インドのAI野心:2025アップデート 中国と米国が生成AIに多額の投資をしているため、インドは独自のGenaiイニシアチブを加速しています。 インドの多様な言語的および文化的景観に対応する先住民族の大手言語モデル(LLMS)とAIツールの緊急の必要性は否定できません。 この記事では、インドの急...AI 2025-04-13に投稿されました -

気流とDockerを使用してCSVのインポートをPostgreSQLに自動化するこのチュートリアルは、Apache Airflow、Docker、およびPostgreSQLを使用して堅牢なデータパイプラインを構築して、CSVファイルからデータベースへのデータ転送を自動化することを示しています。 効率的なワークフロー管理のために、DAG、タスク、演算子などのコアエアフローの概念...AI 2025-04-12に投稿されました

気流とDockerを使用してCSVのインポートをPostgreSQLに自動化するこのチュートリアルは、Apache Airflow、Docker、およびPostgreSQLを使用して堅牢なデータパイプラインを構築して、CSVファイルからデータベースへのデータ転送を自動化することを示しています。 効率的なワークフロー管理のために、DAG、タスク、演算子などのコアエアフローの概念...AI 2025-04-12に投稿されました -

Swarm Intelligence Algorithms:3つのPython実装Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...AI 2025-03-24に投稿されました

Swarm Intelligence Algorithms:3つのPython実装Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...AI 2025-03-24に投稿されました -

ラグ&微調整によりLLMをより正確にする方法Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...AI 2025-03-24に投稿されました

ラグ&微調整によりLLMをより正確にする方法Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...AI 2025-03-24に投稿されました -

Google Geminiとは何ですか? GoogleのChatGptのライバルについて知る必要があるすべてGoogle recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...AI 2025-03-23に投稿されました

Google Geminiとは何ですか? GoogleのChatGptのライバルについて知る必要があるすべてGoogle recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...AI 2025-03-23に投稿されました

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning