如何在電腦上使用 Nvidia 的 RTX AI 聊天機器人聊天

Nvidia 推出了 Chat with RXT,这是一款可在您的 PC 上运行的 AI 聊天机器人,并提供与 ChatGPT 类似的功能等等!您只需要一个 Nvidia RTX GPU,就可以开始使用 Nvidia 的新 AI 聊天机器人了。

什么是 Nvidia Chat with RTX?

Nvidia Chat with RTX 是一款 AI 软件,可让您在计算机上本地运行大型语言模型 (LLM)。因此,您可以随时离线使用 Chat with RTX,而不是在线使用 ChatGPT 等 AI 聊天机器人。

Chat with RTX 使用 TensorRT-LLM、RTX 加速和量化的 Mistral 7-B LLM 来提供与其他在线 AI 聊天机器人相同的快速性能和质量响应。它还提供检索增强生成 (RAG),允许聊天机器人读取您的文件并根据您提供的数据启用自定义答案。这允许您自定义聊天机器人以提供更个性化的体验。

如果您想尝试使用 RTX 进行 Nvidia Chat,请按以下步骤在您的计算机上下载、安装和配置它。

如何下载并安装 RTX 聊天

Nvidia 使在计算机上本地运行 LLM 变得更加容易。要使用 RTX 运行 Chat,您只需下载并安装该应用程序,就像使用任何其他软件一样。但是,Chat with RTX 确实有一些正确安装和使用的最低规格要求。

RTX 30 系列或 40 系列 GPU 16GB RAM 100GB 可用内存空间 Windows 11如果您的电脑确实满足最低系统要求,您可以继续安装该应用程序。

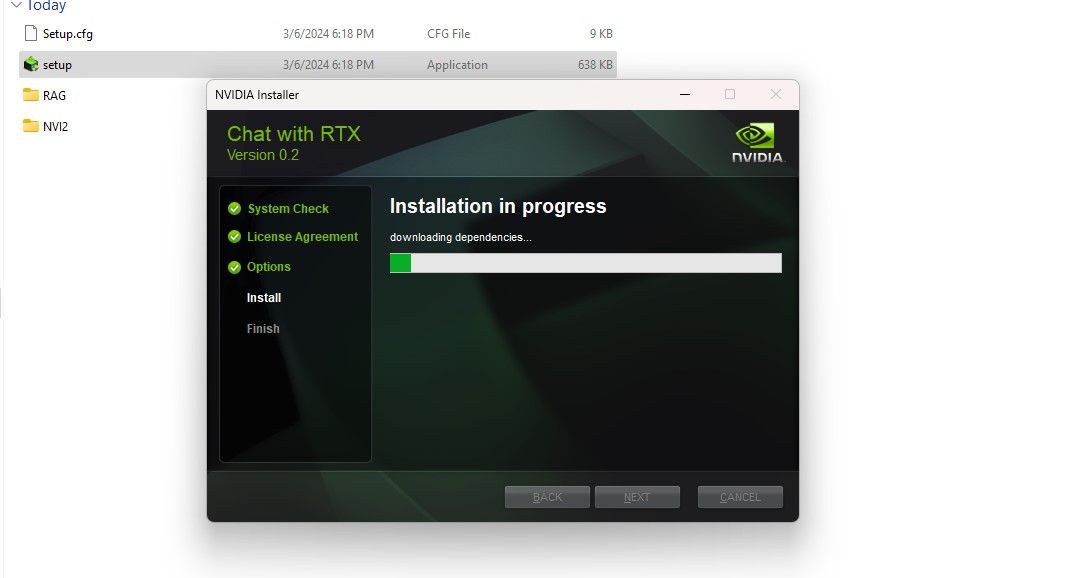

第 1 步:下载 Chat with RTX ZIP 文件。下载:Chat with RTX(免费 — 35GB 下载)第 2 步:右键单击并选择文件存档工具(如 7Zip)来解压缩 ZIP 文件或双击该文件并选择全部提取。步骤3:打开解压的文件夹并双击setup.exe。按照屏幕上的说明进行操作,并在自定义安装过程中选中所有复选框。点击下一步后,安装程序将下载并安装LLM和所有依赖项。

Chat with RTX安装将需要一些时间才能完成,因为它下载并安装大量数据。安装过程完成后,点击关闭,就完成了。现在,您可以试用该应用程序了。

如何使用 Nvidia Chat with RTX

尽管您可以像常规在线 AI 聊天机器人一样使用 Chat with RTX,但我强烈建议您检查其 RAG 功能,该功能使您能够根据需要自定义其输出在您授予访问权限的文件上。

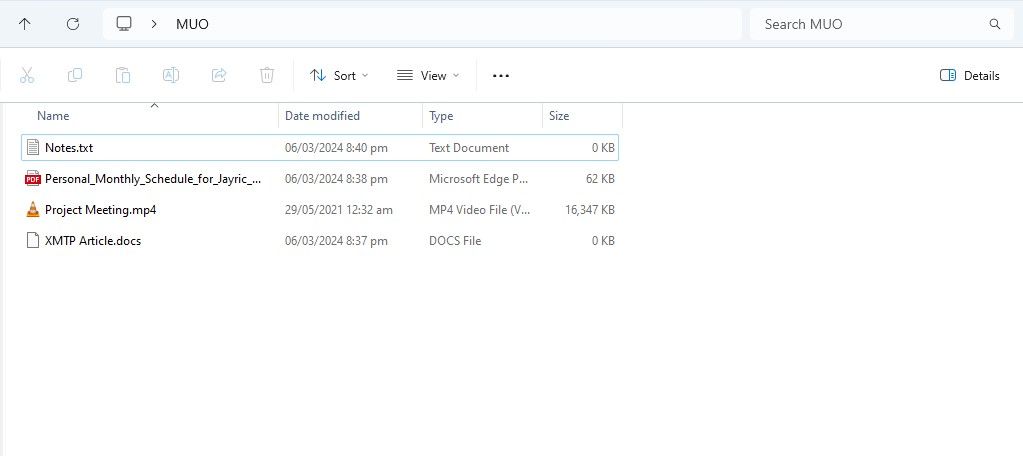

第 1 步:创建 RAG 文件夹

要开始在 Chat with RTX 上使用 RAG,请创建一个新文件夹来存储您希望 AI 分析的文件。

创建后,将数据文件放入该文件夹中。您存储的数据可以涵盖许多主题和文件类型,例如文档、PDF、文本和视频。但是,您可能希望限制放置在此文件夹中的文件数量,以免影响性能。要搜索的数据越多,意味着使用 RTX 聊天将需要更长的时间才能返回特定查询的响应(但这也取决于硬件)。

现在您的数据库已准备就绪,您可以设置 Chat with RTX 并开始使用它来回答您的问题和疑问。

第 2 步:设置环境

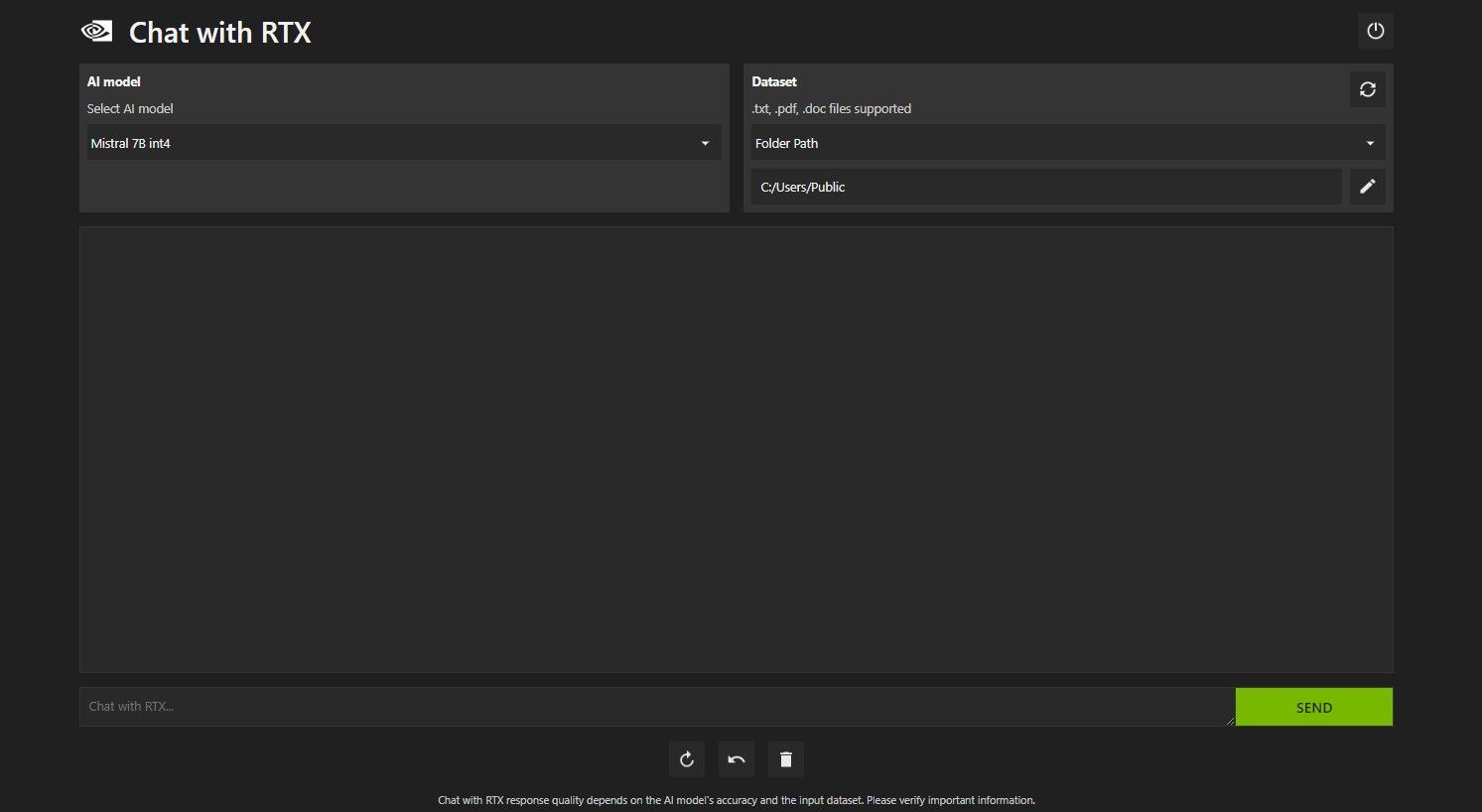

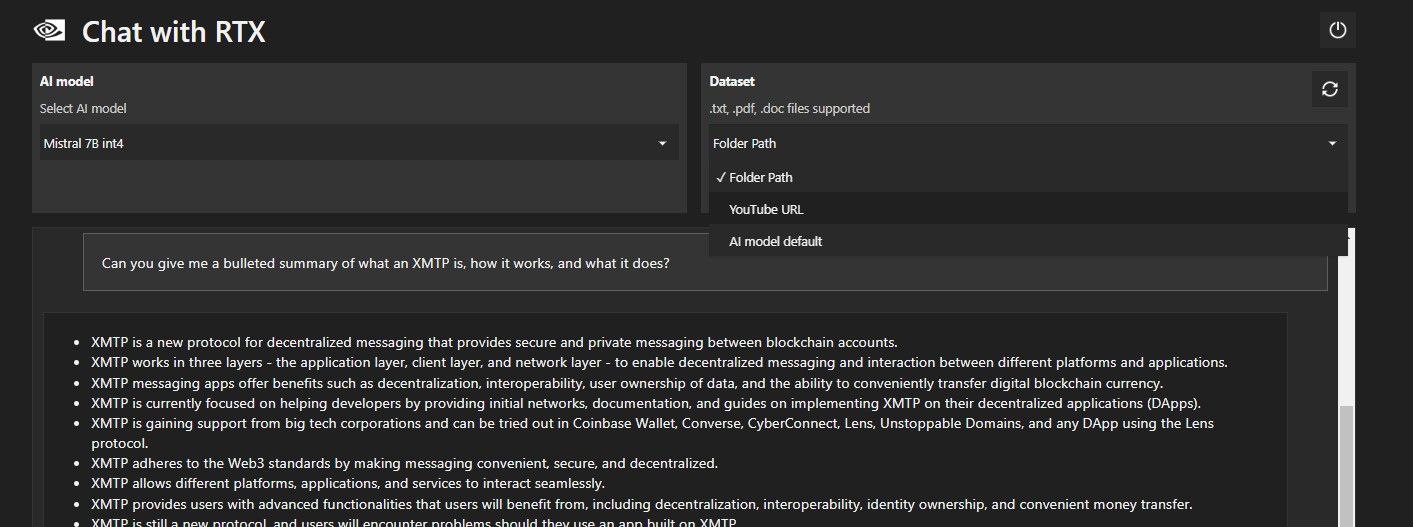

使用 RTX 打开聊天。它应该如下图所示。

在“数据集”下,确保选择“文件夹路径”选项。现在,单击下面的编辑图标(钢笔图标),然后选择包含您希望 Chat with RTX 读取的所有文件的文件夹。如果有其他选项可用,您还可以更改 AI 模型(在撰写本文时,仅 Mistral 7B 可用)。

您现在可以使用 Chat with RTX 了。

第 3 步:通过 RTX 聊天询问您的问题!

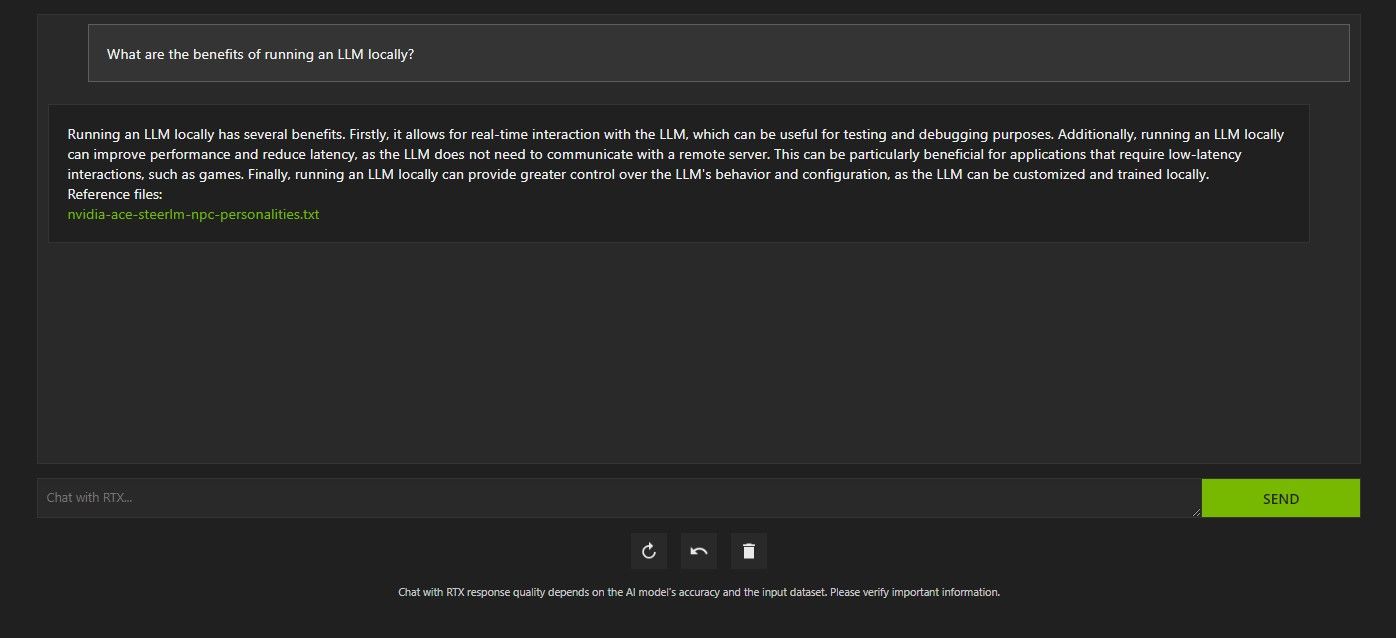

使用RTX查询Chat有多种方式。第一个是像常规人工智能聊天机器人一样使用它。我向 Chat with RTX 询问了使用本地法学硕士的好处,并对它的回答感到满意。虽然不是很深入,但是足够准确。

但由于 Chat with RTX 具有 RAG 功能,因此您还可以将其用作个人 AI 助理。

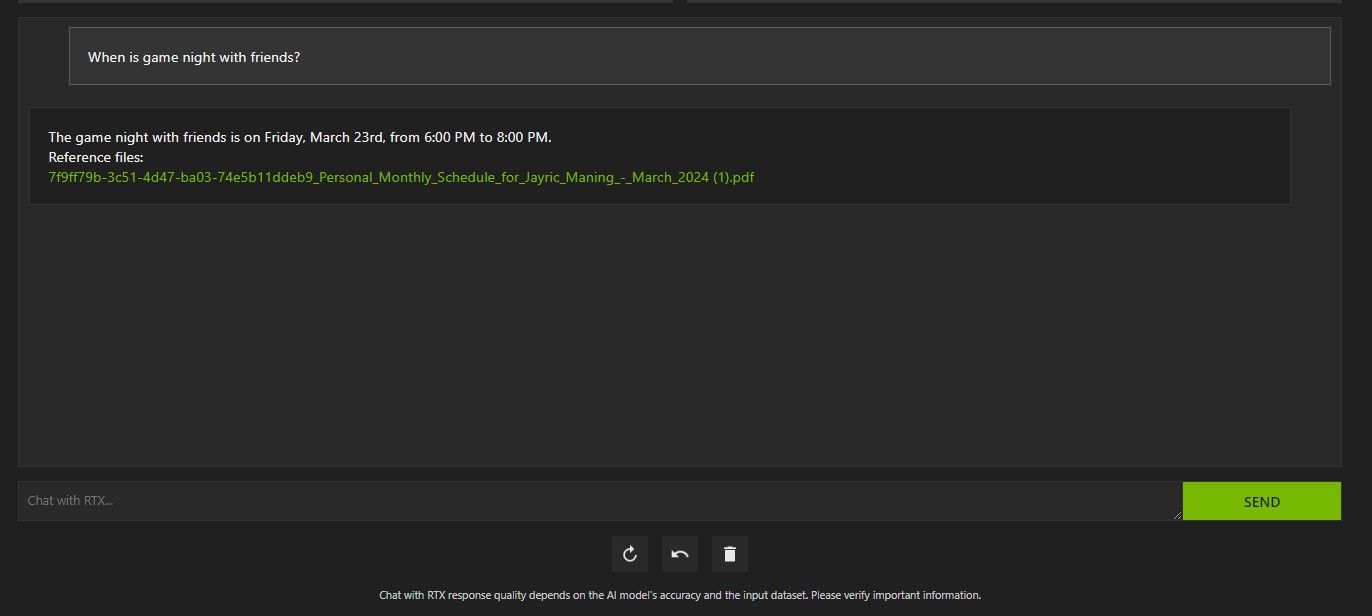

上面,我使用了 Chat with RTX 来询问我的日程安排。数据来自一个 PDF 文件,其中包含我的日程安排、日历、事件、工作等。在本例中,Chat with RTX 已从数据中提取了正确的日历数据;您必须保持数据文件和日历日期更新,这样的功能才能正常工作,直到与其他应用程序集成为止。

您可以通过多种方式使用 Chat with RTX 的 RAG 来发挥自己的优势。例如,您可以使用它来阅读法律文件并给出摘要,生成与您正在开发的程序相关的代码,获取有关您太忙而无法观看的视频的要点,等等!

第 4 步:奖励功能

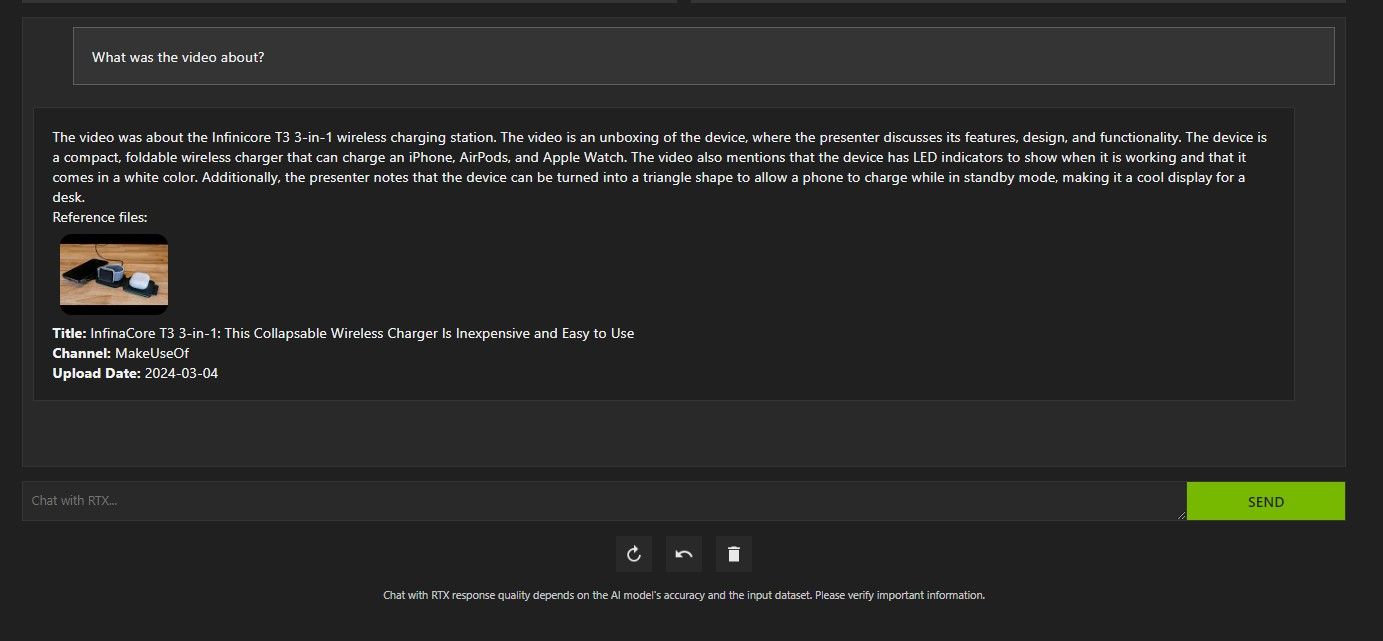

除了本地数据文件夹之外,您还可以使用 Chat with RTX 来分析 YouTube 视频。为此,请在数据集下将文件夹路径更改为 YouTube URL。

复制您要分析的 YouTube 网址并将其粘贴到下拉菜单下方。那就问走吧!

Chat with RTX 的 YouTube 视频分析非常好,提供了准确的信息,因此可以方便地进行研究、快速分析等。

Nvidia 与 RTX 的对话有什么好处吗?

ChatGPT 提供 RAG 功能。一些本地人工智能聊天机器人的系统要求明显较低。那么,Nvidia Chat with RTX 值得使用吗?

答案是肯定的!尽管有竞争,但与 RTX 聊天还是值得使用的。

使用 Nvidia Chat 与 RTX 的最大卖点之一是它能够使用 RAG,而无需将文件发送到第三方服务器。通过在线服务自定义 GPT 可能会暴露您的数据。但由于 Chat with RTX 在本地运行且无需互联网连接,因此在 Chat with RTX 上使用 RAG 可确保您的敏感数据安全且只能在您的 PC 上访问。

对于其他运行 Mistral 7B 的本地运行的 AI 聊天机器人,Chat with RTX 的性能更好、更快。尽管性能提升的很大一部分来自于使用更高端的 GPU,但与运行聊天优化的 LLM 的其他方式相比,Nvidia TensorRT-LLM 和 RTX 加速的使用使得在 Chat with RTX 上运行 Mistral 7B 的速度更快。

值得注意的是,我们目前使用的 Chat with RTX 版本是一个演示版本。 Chat with RTX 的后续版本可能会变得更加优化并带来性能提升。

如果我没有 RTX 30 或 40 系列 GPU 怎么办?

Chat with RTX 是一种在本地运行 LLM 的简单、快速且安全的方式,无需互联网连接。如果您也有兴趣运行 LLM 或本地课程,但没有 RTX 30 或 40 系列 GPU,则可以尝试其他本地运行 LLM 的方法。其中最流行的两个是 GPT4ALL 和 Text Gen WebUI。如果您想在本地运行 LLM 获得即插即用的体验,请尝试 GPT4ALL。但如果您更倾向于技术,通过 Text Gen WebUI 运行法学硕士将提供更好的微调和灵活性。

-

群智能算法:三個Python實現Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...人工智慧 發佈於2025-03-24

群智能算法:三個Python實現Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...人工智慧 發佈於2025-03-24 -

如何通過抹布和微調使LLM更準確Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...人工智慧 發佈於2025-03-24

如何通過抹布和微調使LLM更準確Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...人工智慧 發佈於2025-03-24 -

什麼是Google Gemini?您需要了解的有關Google Chatgpt競爭對手的一切Google recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...人工智慧 發佈於2025-03-23

什麼是Google Gemini?您需要了解的有關Google Chatgpt競爭對手的一切Google recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...人工智慧 發佈於2025-03-23 -

與DSPY提示的指南DSPY(聲明性的自我改善語言程序)通過抽象及時工程的複雜性來徹底改變LLM應用程序的開發。 本教程提供了使用DSPY的聲明方法來構建強大的AI應用程序的綜合指南。 [2 抓取DSPY的聲明方法,用於簡化LLM應用程序開發。 了解DSPY如何自動化提示工程並優化複雜任務的性能。 探索實用的D...人工智慧 發佈於2025-03-22

與DSPY提示的指南DSPY(聲明性的自我改善語言程序)通過抽象及時工程的複雜性來徹底改變LLM應用程序的開發。 本教程提供了使用DSPY的聲明方法來構建強大的AI應用程序的綜合指南。 [2 抓取DSPY的聲明方法,用於簡化LLM應用程序開發。 了解DSPY如何自動化提示工程並優化複雜任務的性能。 探索實用的D...人工智慧 發佈於2025-03-22 -

自動化博客到Twitter線程本文详细介绍了使用Google的Gemini-2.0 LLM,Chromadb和Shiplit自动化长效内容的转换(例如博客文章)。 手动线程创建耗时;此应用程序简化了该过程。 [2 [2 使用Gemini-2.0,Chromadb和Shatlit自动化博客到twitter线程转换。 获得实用的经...人工智慧 發佈於2025-03-11

自動化博客到Twitter線程本文详细介绍了使用Google的Gemini-2.0 LLM,Chromadb和Shiplit自动化长效内容的转换(例如博客文章)。 手动线程创建耗时;此应用程序简化了该过程。 [2 [2 使用Gemini-2.0,Chromadb和Shatlit自动化博客到twitter线程转换。 获得实用的经...人工智慧 發佈於2025-03-11 -

人工免疫系統(AIS):python示例的指南本文探討了人造免疫系統(AIS),這是受人類免疫系統識別和中和威脅的非凡能力啟發的計算模型。 我們將深入研究AIS的核心原理,檢查諸如克隆選擇,負面選擇和免疫網絡理論之類的關鍵算法,並用Python代碼示例說明其應用。 [2 抗體:識別並結合特定威脅(抗原)。在AIS中,這些代表了問題的潛在解決方...人工智慧 發佈於2025-03-04

人工免疫系統(AIS):python示例的指南本文探討了人造免疫系統(AIS),這是受人類免疫系統識別和中和威脅的非凡能力啟發的計算模型。 我們將深入研究AIS的核心原理,檢查諸如克隆選擇,負面選擇和免疫網絡理論之類的關鍵算法,並用Python代碼示例說明其應用。 [2 抗體:識別並結合特定威脅(抗原)。在AIS中,這些代表了問題的潛在解決方...人工智慧 發佈於2025-03-04 -

試著向 ChatGPT 詢問這些關於您自己的有趣問題有没有想过 ChatGPT 了解您的哪些信息?随着时间的推移,它如何处理您提供给它的信息?我在不同的场景中使用过 ChatGPT 堆,在特定的交互后看看它会说什么总是很有趣。✕ 删除广告 所以,为什么不尝试向 ChatGPT 询问其中一些问题来看看它对你的真实看法是什么? 我理想生活中的...人工智慧 發佈於2024-11-22

試著向 ChatGPT 詢問這些關於您自己的有趣問題有没有想过 ChatGPT 了解您的哪些信息?随着时间的推移,它如何处理您提供给它的信息?我在不同的场景中使用过 ChatGPT 堆,在特定的交互后看看它会说什么总是很有趣。✕ 删除广告 所以,为什么不尝试向 ChatGPT 询问其中一些问题来看看它对你的真实看法是什么? 我理想生活中的...人工智慧 發佈於2024-11-22 -

您仍然可以透過以下方式嘗試神秘的 GPT-2 聊天機器人如果您對人工智慧模型或聊天機器人感興趣,您可能已經看過有關神秘的 GPT-2 聊天機器人及其有效性的討論。 在這裡,我們解釋什麼是 GPT-2 聊天機器人以及如何使用存取它。 什麼是 GPT-2 聊天機器人? 2024年4月下旬,一個名為gpt2-chatbot的神秘AI模型在LLM測試和基準測試...人工智慧 發佈於2024-11-08

您仍然可以透過以下方式嘗試神秘的 GPT-2 聊天機器人如果您對人工智慧模型或聊天機器人感興趣,您可能已經看過有關神秘的 GPT-2 聊天機器人及其有效性的討論。 在這裡,我們解釋什麼是 GPT-2 聊天機器人以及如何使用存取它。 什麼是 GPT-2 聊天機器人? 2024年4月下旬,一個名為gpt2-chatbot的神秘AI模型在LLM測試和基準測試...人工智慧 發佈於2024-11-08 -

ChatGPT 的 Canvas 模式很棒:有 4 種使用方法ChatGPT 的新 Canvas 模式為世界領先的生成式 AI 工具中的寫作和編輯增添了額外的維度。自從 ChatGPT Canvas 推出以來,我一直在使用它,並找到了幾種不同的方法來使用這個新的 AI 工具。 ✕ 刪除廣告 1 文本編輯 ChatGPT Canvas 是如果你想編輯...人工智慧 發佈於2024-11-08

ChatGPT 的 Canvas 模式很棒:有 4 種使用方法ChatGPT 的新 Canvas 模式為世界領先的生成式 AI 工具中的寫作和編輯增添了額外的維度。自從 ChatGPT Canvas 推出以來,我一直在使用它,並找到了幾種不同的方法來使用這個新的 AI 工具。 ✕ 刪除廣告 1 文本編輯 ChatGPT Canvas 是如果你想編輯...人工智慧 發佈於2024-11-08 -

ChatGPT 的自訂 GPT 如何暴露您的資料以及如何確保其安全ChatGPT 的自訂 GPT 功能允許任何人為幾乎任何你能想到的東西創建自訂 AI 工具;創意、技術、遊戲、自訂 GPT 都可以做到。更好的是,您可以與任何人分享您的自訂 GPT 創建。 但是,透過分享您的自訂 GPT,您可能會犯下一個代價高昂的錯誤,將您的資料暴露給全球數千人。 什麼是自訂...人工智慧 發佈於2024-11-08

ChatGPT 的自訂 GPT 如何暴露您的資料以及如何確保其安全ChatGPT 的自訂 GPT 功能允許任何人為幾乎任何你能想到的東西創建自訂 AI 工具;創意、技術、遊戲、自訂 GPT 都可以做到。更好的是,您可以與任何人分享您的自訂 GPT 創建。 但是,透過分享您的自訂 GPT,您可能會犯下一個代價高昂的錯誤,將您的資料暴露給全球數千人。 什麼是自訂...人工智慧 發佈於2024-11-08 -

ChatGPT 可協助您在 LinkedIn 上找到工作的 10 種方式LinkedIn 个人资料的“关于”部分有 2,600 个可用字符,是阐述您的背景、技能、热情和未来目标的绝佳空间。查看您的 LinkedIn 简历,作为您的专业背景、技能和抱负的简明摘要。 向 ChatGPT 提供您所有获胜品质的列表,或将您的简历复制粘贴到其中。要求聊天机器人使用这些信息撰写...人工智慧 發佈於2024-11-08

ChatGPT 可協助您在 LinkedIn 上找到工作的 10 種方式LinkedIn 个人资料的“关于”部分有 2,600 个可用字符,是阐述您的背景、技能、热情和未来目标的绝佳空间。查看您的 LinkedIn 简历,作为您的专业背景、技能和抱负的简明摘要。 向 ChatGPT 提供您所有获胜品质的列表,或将您的简历复制粘贴到其中。要求聊天机器人使用这些信息撰写...人工智慧 發佈於2024-11-08 -

查看這 6 個鮮為人知的 AI 應用程序,它們可提供獨特的體驗目前,大多数人都听说过 ChatGPT 和 Copilot,这两款引领 AI 热潮的开创性生成式 AI 应用程序。但是您知道吗,大量鲜为人知的 AI 工具可以提供精彩的、独特的经历?这里有六个最好的。 1 Ditto Music Ditto 不是您可以用来创建独特歌曲的众多 AI 音乐生成器之一,而...人工智慧 發佈於2024-11-08

查看這 6 個鮮為人知的 AI 應用程序,它們可提供獨特的體驗目前,大多数人都听说过 ChatGPT 和 Copilot,这两款引领 AI 热潮的开创性生成式 AI 应用程序。但是您知道吗,大量鲜为人知的 AI 工具可以提供精彩的、独特的经历?这里有六个最好的。 1 Ditto Music Ditto 不是您可以用来创建独特歌曲的众多 AI 音乐生成器之一,而...人工智慧 發佈於2024-11-08 -

這 7 個跡象表明我們已經達到人工智慧的巔峰无论您在网上查找什么,都有网站、服务和应用程序宣称他们使用人工智能使其成为最佳选择。我不了解你的情况,但它的持续存在已经让人厌倦了。 因此,虽然人工智能肯定会留在我们的日常生活中,但有几个迹象表明我们已经达到了人工智能炒作的顶峰。 1 公众兴趣有限 虽然人工智能在科技圈受到了广泛关注,但重要的是要...人工智慧 發佈於2024-11-08

這 7 個跡象表明我們已經達到人工智慧的巔峰无论您在网上查找什么,都有网站、服务和应用程序宣称他们使用人工智能使其成为最佳选择。我不了解你的情况,但它的持续存在已经让人厌倦了。 因此,虽然人工智能肯定会留在我们的日常生活中,但有几个迹象表明我们已经达到了人工智能炒作的顶峰。 1 公众兴趣有限 虽然人工智能在科技圈受到了广泛关注,但重要的是要...人工智慧 發佈於2024-11-08 -

4 個適合教師、講師和老闆的 AI 檢查 ChatGPT 偵測器工具随着 ChatGPT 能力的进步,区分哪些内容是人类编写的,哪些内容是人工智能生成的变得越来越困难。这使得老师和老板很难识别哪些内容是人手写的,哪些内容是通过 ChatGPT 生成的。 如果您很难区分,这里有最好的 ChatGPT 检测工具 我们如何测试每个 ChatGPT 检查工具 有很多...人工智慧 發佈於2024-11-08

4 個適合教師、講師和老闆的 AI 檢查 ChatGPT 偵測器工具随着 ChatGPT 能力的进步,区分哪些内容是人类编写的,哪些内容是人工智能生成的变得越来越困难。这使得老师和老板很难识别哪些内容是人手写的,哪些内容是通过 ChatGPT 生成的。 如果您很难区分,这里有最好的 ChatGPT 检测工具 我们如何测试每个 ChatGPT 检查工具 有很多...人工智慧 發佈於2024-11-08 -

ChatGPT 的高級語音功能正在向更多用戶推出如果您曾經想與 ChatGPT 進行全面對話,現在您可以。也就是說,只要你付費就可以獲得使用ChatGPT的特權。更多付費用戶正在存取 ChatGPT 的高級語音模式 (AVM),該模式旨在使與 ChatGPT 的互動感覺更加自然。 高級語音來到 ChatGPT Plus 和 Teams Ope...人工智慧 發佈於2024-11-08

ChatGPT 的高級語音功能正在向更多用戶推出如果您曾經想與 ChatGPT 進行全面對話,現在您可以。也就是說,只要你付費就可以獲得使用ChatGPT的特權。更多付費用戶正在存取 ChatGPT 的高級語音模式 (AVM),該模式旨在使與 ChatGPT 的互動感覺更加自然。 高級語音來到 ChatGPT Plus 和 Teams Ope...人工智慧 發佈於2024-11-08

學習中文

- 1 走路用中文怎麼說? 走路中文發音,走路中文學習

- 2 坐飛機用中文怎麼說? 坐飞机中文發音,坐飞机中文學習

- 3 坐火車用中文怎麼說? 坐火车中文發音,坐火车中文學習

- 4 坐車用中文怎麼說? 坐车中文發音,坐车中文學習

- 5 開車用中文怎麼說? 开车中文發音,开车中文學習

- 6 游泳用中文怎麼說? 游泳中文發音,游泳中文學習

- 7 騎自行車用中文怎麼說? 骑自行车中文發音,骑自行车中文學習

- 8 你好用中文怎麼說? 你好中文發音,你好中文學習

- 9 謝謝用中文怎麼說? 谢谢中文發音,谢谢中文學習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning