титульная страница > программирование > Почему мой сеанс Google Colab завершился сбоем при запуске модели Llama?

титульная страница > программирование > Почему мой сеанс Google Colab завершился сбоем при запуске модели Llama?

Почему мой сеанс Google Colab завершился сбоем при запуске модели Llama?

Я пытаюсь использовать модель мета-ламы/Llama-2-7b-hf и запустить ее локально у себя, но во время процесса сеанс прервался.

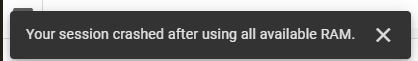

Я пытаюсь использовать модель мета-ламы/Llama-2-7b-hf и запустить ее локально у себя. Для этого я использую Google Colab и получил ключ доступа от Hugging Face. Я использую их библиотеку трансформеров для необходимых задач. Первоначально я использовал стек времени выполнения графического процессора T4 в Google Colab, который обеспечивал 12,7 ГБ системной оперативной памяти, 15,0 ГБ оперативной памяти графического процессора и 78,2 ГБ дискового пространства. Несмотря на эти ресурсы, мой сеанс прервался, и я столкнулся со следующей ошибкой:

Впоследствии я перешел на стек среды выполнения TPU V2, который предлагает 334,6 ГБ системной оперативной памяти и 225,3 ГБ дискового пространства, но проблема не исчезла.

Вот мой код:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

-

Как проверить, содержит ли строка какие-либо подстроки из массива в JavaScript?Поиск подстрок в строке с помощью массивов JavaScriptЧтобы определить, содержит ли строка какие-либо подстроки из массива, JavaScript предлагает гибки...программирование Опубликовано 6 ноября 2024 г.

Как проверить, содержит ли строка какие-либо подстроки из массива в JavaScript?Поиск подстрок в строке с помощью массивов JavaScriptЧтобы определить, содержит ли строка какие-либо подстроки из массива, JavaScript предлагает гибки...программирование Опубликовано 6 ноября 2024 г. -

Laravel Livewire: что это такое и как использовать его в своем веб-приложенииLivewire — один из наиболее важных проектов в экосистеме Laravel, специально предназначенный для фронтенд-разработки. Недавно был выпущен Livewire v3,...программирование Опубликовано 6 ноября 2024 г.

Laravel Livewire: что это такое и как использовать его в своем веб-приложенииLivewire — один из наиболее важных проектов в экосистеме Laravel, специально предназначенный для фронтенд-разработки. Недавно был выпущен Livewire v3,...программирование Опубликовано 6 ноября 2024 г. -

Могут ли вызовы методов через нулевые указатели выполняться в C++ без сбоев?Неожиданное поведение вызова методов через нулевые указатели в C. В предоставленном фрагменте кода метод вызывается через нулевой указатель, но Удивит...программирование Опубликовано 6 ноября 2024 г.

Могут ли вызовы методов через нулевые указатели выполняться в C++ без сбоев?Неожиданное поведение вызова методов через нулевые указатели в C. В предоставленном фрагменте кода метод вызывается через нулевой указатель, но Удивит...программирование Опубликовано 6 ноября 2024 г. -

Как вычитать списки в Python?Вычитание списков: вычисление разницыСписки в Python могут содержать различные элементы. Для выполнения математических операций со списками, таких как...программирование Опубликовано 6 ноября 2024 г.

Как вычитать списки в Python?Вычитание списков: вычисление разницыСписки в Python могут содержать различные элементы. Для выполнения математических операций со списками, таких как...программирование Опубликовано 6 ноября 2024 г. -

Как проверить, пуст ли генератор в Python?Обнаружение пустой инициализации генератораВ Python генераторы — это итераторы, которые выдают значения по одному. Таким образом, определить, пуст ли ...программирование Опубликовано 6 ноября 2024 г.

Как проверить, пуст ли генератор в Python?Обнаружение пустой инициализации генератораВ Python генераторы — это итераторы, которые выдают значения по одному. Таким образом, определить, пуст ли ...программирование Опубликовано 6 ноября 2024 г. -

## Хотите эффективно вызывать Java из Python? Исследуйте Py4J как альтернативу JPype!Вызов Java из Python: Py4J как альтернатива JPypeВызов Java-кода из Python имеет несколько потенциальных решений. Один из вариантов, JPype, может быть...программирование Опубликовано 6 ноября 2024 г.

## Хотите эффективно вызывать Java из Python? Исследуйте Py4J как альтернативу JPype!Вызов Java из Python: Py4J как альтернатива JPypeВызов Java-кода из Python имеет несколько потенциальных решений. Один из вариантов, JPype, может быть...программирование Опубликовано 6 ноября 2024 г. -

Маленький Свул ДБВ Small Swoole Db 2.3 представлены левые соединения : $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $...программирование Опубликовано 6 ноября 2024 г.

Маленький Свул ДБВ Small Swoole Db 2.3 представлены левые соединения : $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $...программирование Опубликовано 6 ноября 2024 г. -

Как можно оптимизировать функцию __mm_add_epi32_inplace_purego с помощью инструкций ассемблера для повышения производительности операций позиционного подсчета населения?Оптимизация __mm_add_epi32_inplace_purego с использованием ассемблераЭтот вопрос направлен на оптимизацию внутреннего цикла функции __mm_add_epi32_inp...программирование Опубликовано 6 ноября 2024 г.

Как можно оптимизировать функцию __mm_add_epi32_inplace_purego с помощью инструкций ассемблера для повышения производительности операций позиционного подсчета населения?Оптимизация __mm_add_epi32_inplace_purego с использованием ассемблераЭтот вопрос направлен на оптимизацию внутреннего цикла функции __mm_add_epi32_inp...программирование Опубликовано 6 ноября 2024 г. -

Навигация с помощью React Router React Js Часть A Руководство по маршрутизации в приложениях ReactДобро пожаловать обратно в нашу серию React! В предыдущих статьях мы рассмотрели такие важные понятия, как компоненты, состояние, реквизиты и обработк...программирование Опубликовано 6 ноября 2024 г.

Навигация с помощью React Router React Js Часть A Руководство по маршрутизации в приложениях ReactДобро пожаловать обратно в нашу серию React! В предыдущих статьях мы рассмотрели такие важные понятия, как компоненты, состояние, реквизиты и обработк...программирование Опубликовано 6 ноября 2024 г. -

Можно ли использовать file_get_contents() для загрузки файлов по HTTP?Загрузка файлов с помощью file_get_contents() с использованием контекста HTTP-потокаЗагрузку файлов через веб-форму можно легко выполнить с помощью ра...программирование Опубликовано 6 ноября 2024 г.

Можно ли использовать file_get_contents() для загрузки файлов по HTTP?Загрузка файлов с помощью file_get_contents() с использованием контекста HTTP-потокаЗагрузку файлов через веб-форму можно легко выполнить с помощью ра...программирование Опубликовано 6 ноября 2024 г. -

UseEffect в ReactДобро пожаловать в мир React Hooks! Сегодня мы углубимся в один из самых популярных хуков: useEffect. Не волнуйтесь, мы сделаем это весело и легко для...программирование Опубликовано 6 ноября 2024 г.

UseEffect в ReactДобро пожаловать в мир React Hooks! Сегодня мы углубимся в один из самых популярных хуков: useEffect. Не волнуйтесь, мы сделаем это весело и легко для...программирование Опубликовано 6 ноября 2024 г. -

Как создать современную платформу данных на бесплатном уровне Google Cloud PlatformЯ опубликовал на Medium.com серию из семи бесплатных общедоступных статей «Как построить современную платформу данных на бесплатном уровне Google Clou...программирование Опубликовано 6 ноября 2024 г.

Как создать современную платформу данных на бесплатном уровне Google Cloud PlatformЯ опубликовал на Medium.com серию из семи бесплатных общедоступных статей «Как построить современную платформу данных на бесплатном уровне Google Clou...программирование Опубликовано 6 ноября 2024 г. -

пост #f борюсьЭтот пост о моих трудностях с программированием и обучением А. Я могу оставаться сосредоточенным только час, максимум два часа. б. Я очень легко отвл...программирование Опубликовано 6 ноября 2024 г.

пост #f борюсьЭтот пост о моих трудностях с программированием и обучением А. Я могу оставаться сосредоточенным только час, максимум два часа. б. Я очень легко отвл...программирование Опубликовано 6 ноября 2024 г. -

Лучшие расширения Chrome для веб-разработчиков в 410 лучших расширений Chrome для веб-разработчиков в 2024 году К 2024 году расширения Chrome стали неотъемлемой частью набора инструментов веб...программирование Опубликовано 6 ноября 2024 г.

Лучшие расширения Chrome для веб-разработчиков в 410 лучших расширений Chrome для веб-разработчиков в 2024 году К 2024 году расширения Chrome стали неотъемлемой частью набора инструментов веб...программирование Опубликовано 6 ноября 2024 г. -

Как вкладывать маршруты с помощью React Router v4/v5: упрощенное руководствоВложенные маршруты с React Router v4/v5: упрощенное руководствоПри работе с React Router вложение маршрутов является важным методом организации навига...программирование Опубликовано 6 ноября 2024 г.

Как вкладывать маршруты с помощью React Router v4/v5: упрощенное руководствоВложенные маршруты с React Router v4/v5: упрощенное руководствоПри работе с React Router вложение маршрутов является важным методом организации навига...программирование Опубликовано 6 ноября 2024 г.

Изучайте китайский

- 1 Как сказать «гулять» по-китайски? 走路 Китайское произношение, 走路 Изучение китайского языка

- 2 Как сказать «Сесть на самолет» по-китайски? 坐飞机 Китайское произношение, 坐飞机 Изучение китайского языка

- 3 Как сказать «сесть на поезд» по-китайски? 坐火车 Китайское произношение, 坐火车 Изучение китайского языка

- 4 Как сказать «поехать на автобусе» по-китайски? 坐车 Китайское произношение, 坐车 Изучение китайского языка

- 5 Как сказать «Ездить» по-китайски? 开车 Китайское произношение, 开车 Изучение китайского языка

- 6 Как будет плавание по-китайски? 游泳 Китайское произношение, 游泳 Изучение китайского языка

- 7 Как сказать «кататься на велосипеде» по-китайски? 骑自行车 Китайское произношение, 骑自行车 Изучение китайского языка

- 8 Как поздороваться по-китайски? 你好Китайское произношение, 你好Изучение китайского языка

- 9 Как сказать спасибо по-китайски? 谢谢Китайское произношение, 谢谢Изучение китайского языка

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning