Llama モデルの実行中に Google Colab セッションがクラッシュしたのはなぜですか?

2024 年 8 月 27 日に公開

metal-llama/Llama-2-7b-hf モデルを使用して、社内でローカルに実行しようとしていますが、プロセス中にセッションがクラッシュしました。

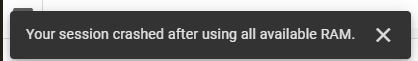

metal-llama/Llama-2-7b-hf モデルを使用して、自分の敷地内でローカルに実行しようとしています。これを行うために、私は Google Colab を使用しており、Hugging Face からアクセス キーを取得しています。私は必要なタスクに同社の変圧器ライブラリを利用しています。最初は、12.7 GB のシステム RAM、15.0 GB の GPU RAM、78.2 GB のディスク容量を提供する Google Colab の T4 GPU ランタイム スタックを使用しました。これらのリソースにもかかわらず、セッションがクラッシュし、次のエラーが発生しました:

その後、334.6 GB のシステム RAM と 225.3 GB のディスク容量を提供する TPU V2 ランタイム スタックに切り替えましたが、問題は解決しませんでした。

これが私のコードです:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

リリースステートメント

この記事は次の場所に転載されています: https://dev.to/riddhi_007f87a3b86e45bf61/why-did-my-google-colab-session-crash-while-running-the-llama-model-4bce?1 侵害がある場合は、 Study_golang@163 .comdelete に連絡してください

最新のチュートリアル

もっと>

-

Laravel Livewire: それとは何か、そしてそれを Web アプリで使用する方法Livewire は、特にフロントエンド開発を対象とした Laravel エコシステムの中で最も重要なプロジェクトの 1 つです。 Livewire v3 が最近リリースされたので、Livewire とは何なのか、またそのアーキテクチャにどのようなプロジェクトが適合するのかを見てみましょう。 Liv...プログラミング 2024 年 11 月 6 日に公開

Laravel Livewire: それとは何か、そしてそれを Web アプリで使用する方法Livewire は、特にフロントエンド開発を対象とした Laravel エコシステムの中で最も重要なプロジェクトの 1 つです。 Livewire v3 が最近リリースされたので、Livewire とは何なのか、またそのアーキテクチャにどのようなプロジェクトが適合するのかを見てみましょう。 Liv...プログラミング 2024 年 11 月 6 日に公開 -

Null ポインターを介したメソッド呼び出しは C++ でクラッシュせずに実行できますか?C での Null ポインターを介したメソッド呼び出しの予期しない動作 提供されたコード スニペットでは、メソッドは Null ポインターを介して呼び出されますが、驚くべきことに、メソッド呼び出しはクラッシュすることなく実行されているようです。この異常な動作により、次のような疑問が生じます。これは ...プログラミング 2024 年 11 月 6 日に公開

Null ポインターを介したメソッド呼び出しは C++ でクラッシュせずに実行できますか?C での Null ポインターを介したメソッド呼び出しの予期しない動作 提供されたコード スニペットでは、メソッドは Null ポインターを介して呼び出されますが、驚くべきことに、メソッド呼び出しはクラッシュすることなく実行されているようです。この異常な動作により、次のような疑問が生じます。これは ...プログラミング 2024 年 11 月 6 日に公開 -

Pythonでリストを減算する方法?リストの減算: 差分の計算Python のリストにはさまざまな要素を含めることができます。リストに対して減算などの数学的演算を実行するには、特定の方法またはテクニックを使用します。あるリストから別のリストを減算する方法を見てみましょう。要素ごとの減算にリスト内包表記を使用する1 つのアプローチは、リ...プログラミング 2024 年 11 月 6 日に公開

Pythonでリストを減算する方法?リストの減算: 差分の計算Python のリストにはさまざまな要素を含めることができます。リストに対して減算などの数学的演算を実行するには、特定の方法またはテクニックを使用します。あるリストから別のリストを減算する方法を見てみましょう。要素ごとの減算にリスト内包表記を使用する1 つのアプローチは、リ...プログラミング 2024 年 11 月 6 日に公開 -

Pythonでジェネレーターが空かどうかを確認する方法は?空のジェネレーターの初期化の検出Python では、ジェネレーターは一度に 1 つずつ値を生成する反復子です。そのため、ジェネレーターが最初から空であるかどうかを判断するのは困難な場合があります。リストやタプルとは異なり、ジェネレーターには固有の長さや isEmpty メソッドがありません。課題への...プログラミング 2024 年 11 月 6 日に公開

Pythonでジェネレーターが空かどうかを確認する方法は?空のジェネレーターの初期化の検出Python では、ジェネレーターは一度に 1 つずつ値を生成する反復子です。そのため、ジェネレーターが最初から空であるかどうかを判断するのは困難な場合があります。リストやタプルとは異なり、ジェネレーターには固有の長さや isEmpty メソッドがありません。課題への...プログラミング 2024 年 11 月 6 日に公開 -

## Python から Java を効率的に呼び出したいですか? JPype の代替として Py4J を試してみましょう!Python から Java を呼び出す: JPype の代替としての Py4JPython から Java コードを呼び出すには、いくつかの解決策が考えられます。オプションの 1 つである JPype はコンパイルが難しく、最近リリースされていないため非アクティブに見えます。ただし、代替ソリューシ...プログラミング 2024 年 11 月 6 日に公開

## Python から Java を効率的に呼び出したいですか? JPype の代替として Py4J を試してみましょう!Python から Java を呼び出す: JPype の代替としての Py4JPython から Java コードを呼び出すには、いくつかの解決策が考えられます。オプションの 1 つである JPype はコンパイルが難しく、最近リリースされていないため非アクティブに見えます。ただし、代替ソリューシ...プログラミング 2024 年 11 月 6 日に公開 -

スモールスウールDBSmall Swoole Db 2.3 で左結合が導入されました : $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector->where(...プログラミング 2024 年 11 月 6 日に公開

スモールスウールDBSmall Swoole Db 2.3 で左結合が導入されました : $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector->where(...プログラミング 2024 年 11 月 6 日に公開 -

位置人口カウント操作のパフォーマンスを向上させるために、アセンブリ命令を使用して __mm_add_epi32_inplace_purego 関数を最適化するにはどうすればよいですか?アセンブリを使用した __mm_add_epi32_inplace_purego の最適化この質問は、バイト配列の位置ポピュレーション カウントを実行する __mm_add_epi32_inplace_purego 関数の内部ループを最適化することを目的としています。目標は、アセンブリ命令を利用して...プログラミング 2024 年 11 月 6 日に公開

位置人口カウント操作のパフォーマンスを向上させるために、アセンブリ命令を使用して __mm_add_epi32_inplace_purego 関数を最適化するにはどうすればよいですか?アセンブリを使用した __mm_add_epi32_inplace_purego の最適化この質問は、バイト配列の位置ポピュレーション カウントを実行する __mm_add_epi32_inplace_purego 関数の内部ループを最適化することを目的としています。目標は、アセンブリ命令を利用して...プログラミング 2024 年 11 月 6 日に公開 -

React Router を使用したナビゲーション React Js パート A React アプリケーションでのルーティングのガイドReact シリーズへようこそ!以前の投稿では、コンポーネント、状態、小道具、イベント処理などの重要な概念について説明しました。ここで、React Router を使用して React アプリケーションのルーティングを調べてみましょう。ルーティングを使用すると、アプリ内のさまざまなビューまたはコンポ...プログラミング 2024 年 11 月 6 日に公開

React Router を使用したナビゲーション React Js パート A React アプリケーションでのルーティングのガイドReact シリーズへようこそ!以前の投稿では、コンポーネント、状態、小道具、イベント処理などの重要な概念について説明しました。ここで、React Router を使用して React アプリケーションのルーティングを調べてみましょう。ルーティングを使用すると、アプリ内のさまざまなビューまたはコンポ...プログラミング 2024 年 11 月 6 日に公開 -

file_get_contents() は HTTP ファイルのアップロードに使用できますか?HTTP ストリーム コンテキストを使用した file_get_contents() によるファイルのアップロードWeb フォーム経由のファイルのアップロードは、cURL 拡張機能を使用してシームレスに実行できます。ただし、HTTP ストリーム コンテキストと組み合わせて PHP の file_ge...プログラミング 2024 年 11 月 6 日に公開

file_get_contents() は HTTP ファイルのアップロードに使用できますか?HTTP ストリーム コンテキストを使用した file_get_contents() によるファイルのアップロードWeb フォーム経由のファイルのアップロードは、cURL 拡張機能を使用してシームレスに実行できます。ただし、HTTP ストリーム コンテキストと組み合わせて PHP の file_ge...プログラミング 2024 年 11 月 6 日に公開 -

React での UseEffectReact Hooks の世界へようこそ!今日は、最も人気のあるフックの 1 つである useEffect について詳しく説明します。楽しく分かりやすく説明していきますので、ご安心ください。それでは、始めましょう! ? ? useEffectとは何ですか useEffect は、機能コンポーネントで...プログラミング 2024 年 11 月 6 日に公開

React での UseEffectReact Hooks の世界へようこそ!今日は、最も人気のあるフックの 1 つである useEffect について詳しく説明します。楽しく分かりやすく説明していきますので、ご安心ください。それでは、始めましょう! ? ? useEffectとは何ですか useEffect は、機能コンポーネントで...プログラミング 2024 年 11 月 6 日に公開 -

Google Cloud Platform の無料枠で最新のデータ プラットフォームを構築する方法私は、Medium.com で一連の 7 つの無料公開記事「Google Cloud Platform の無料枠で最新のデータ プラットフォームを構築する方法」をリリースしました。 リード記事は、https://medium.com/@markwkiehl/building-a-data-plat...プログラミング 2024 年 11 月 6 日に公開

Google Cloud Platform の無料枠で最新のデータ プラットフォームを構築する方法私は、Medium.com で一連の 7 つの無料公開記事「Google Cloud Platform の無料枠で最新のデータ プラットフォームを構築する方法」をリリースしました。 リード記事は、https://medium.com/@markwkiehl/building-a-data-plat...プログラミング 2024 年 11 月 6 日に公開 -

Web 開発者向けのトップ Chrome 拡張機能 42024 年の Web 開発者向け Chrome 拡張機能トップ 10 2024 年に向けて、Chrome 拡張機能はウェブ開発者のツールキットに不可欠な部分となり、ブラウザー内で強力な機能を提供します。この記事では、今年 Web 開発コミュニティで話題になっている Chrome ...プログラミング 2024 年 11 月 6 日に公開

Web 開発者向けのトップ Chrome 拡張機能 42024 年の Web 開発者向け Chrome 拡張機能トップ 10 2024 年に向けて、Chrome 拡張機能はウェブ開発者のツールキットに不可欠な部分となり、ブラウザー内で強力な機能を提供します。この記事では、今年 Web 開発コミュニティで話題になっている Chrome ...プログラミング 2024 年 11 月 6 日に公開 -

React Router v4/v5 でルートをネストする方法: 簡易ガイドReact Router v4/v5 でのネストされたルート: 簡易ガイドReact Router を使用する場合、ネストされたルートは整理するための重要なテクニックですアプリケーションのナビゲーション。ただし、初心者は、ネストされたルートの設定で課題に直面することがよくあります。この記事は、Rea...プログラミング 2024 年 11 月 6 日に公開

React Router v4/v5 でルートをネストする方法: 簡易ガイドReact Router v4/v5 でのネストされたルート: 簡易ガイドReact Router を使用する場合、ネストされたルートは整理するための重要なテクニックですアプリケーションのナビゲーション。ただし、初心者は、ネストされたルートの設定で課題に直面することがよくあります。この記事は、Rea...プログラミング 2024 年 11 月 6 日に公開 -

MySQL で UTF8 文字エンコーディングを使用してテーブルの書式設定を保持するにはどうすればよいですか?UTF8 文字エンコーディングによる MySQL コマンド ラインの書式設定の強化データベース テーブルに格納されているスウェーデン語およびノルウェー語の文字列を操作しているときに、データのクエリ時にテーブルの書式設定で問題が発生する可能性があります。 問題ステートメントデフォルトでは、「set n...プログラミング 2024 年 11 月 6 日に公開

MySQL で UTF8 文字エンコーディングを使用してテーブルの書式設定を保持するにはどうすればよいですか?UTF8 文字エンコーディングによる MySQL コマンド ラインの書式設定の強化データベース テーブルに格納されているスウェーデン語およびノルウェー語の文字列を操作しているときに、データのクエリ時にテーブルの書式設定で問題が発生する可能性があります。 問題ステートメントデフォルトでは、「set n...プログラミング 2024 年 11 月 6 日に公開

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning