Titelseite > Programmierung > Warum stürzte meine Google Colab-Sitzung ab, während ich das Llama-Modell ausführte?

Titelseite > Programmierung > Warum stürzte meine Google Colab-Sitzung ab, während ich das Llama-Modell ausführte?

Warum stürzte meine Google Colab-Sitzung ab, während ich das Llama-Modell ausführte?

Ich versuche, das Meta-Lama/Llama-2-7b-hf-Modell zu verwenden und es lokal in meinen Räumlichkeiten auszuführen, aber die Sitzung ist während des Vorgangs abgestürzt.

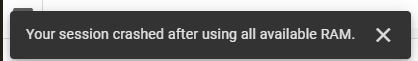

Ich versuche, das Modell meta-llama/Llama-2-7b-hf zu verwenden und es lokal in meinen Räumlichkeiten auszuführen. Dazu verwende ich Google Colab und habe einen Zugangsschlüssel von Hugging Face erhalten. Ich nutze ihre Transformers-Bibliothek für die notwendigen Aufgaben. Ursprünglich habe ich den T4-GPU-Laufzeitstapel von Google Colab verwendet, der 12,7 GB System-RAM, 15,0 GB GPU-RAM und 78,2 GB Festplattenspeicher bereitstellte. Trotz dieser Ressourcen stürzte meine Sitzung ab und es trat der folgende Fehler auf:

Anschließend wechselte ich zum TPU V2-Laufzeitstapel, der 334,6 GB System-RAM und 225,3 GB Festplattenspeicher bietet, aber das Problem blieb bestehen.

Hier ist mein Code:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

-

Können Methodenaufrufe über Nullzeiger in C++ ohne Absturz ausgeführt werden?Unerwartetes Verhalten beim Aufrufen von Methoden über Nullzeiger in C Im bereitgestellten Codeausschnitt wird eine Methode über einen Nullzeiger aufg...Programmierung Veröffentlicht am 06.11.2024

Können Methodenaufrufe über Nullzeiger in C++ ohne Absturz ausgeführt werden?Unerwartetes Verhalten beim Aufrufen von Methoden über Nullzeiger in C Im bereitgestellten Codeausschnitt wird eine Methode über einen Nullzeiger aufg...Programmierung Veröffentlicht am 06.11.2024 -

Wie subtrahiere ich Listen in Python?Listen subtrahieren: Den Unterschied berechnenListen in Python können verschiedene Elemente enthalten. Um mathematische Operationen an Listen durchzuf...Programmierung Veröffentlicht am 06.11.2024

Wie subtrahiere ich Listen in Python?Listen subtrahieren: Den Unterschied berechnenListen in Python können verschiedene Elemente enthalten. Um mathematische Operationen an Listen durchzuf...Programmierung Veröffentlicht am 06.11.2024 -

Wie überprüfe ich in Python, ob ein Generator leer ist?Erkennen leerer GeneratorinitialisierungIn Python sind Generatoren Iteratoren, die Werte einzeln liefern. Daher kann es eine Herausforderung sein, von...Programmierung Veröffentlicht am 06.11.2024

Wie überprüfe ich in Python, ob ein Generator leer ist?Erkennen leerer GeneratorinitialisierungIn Python sind Generatoren Iteratoren, die Werte einzeln liefern. Daher kann es eine Herausforderung sein, von...Programmierung Veröffentlicht am 06.11.2024 -

## Möchten Sie Java effizient aus Python aufrufen? Entdecken Sie Py4J als JPype-Alternative!Aufruf von Java aus Python: Py4J als Alternative zu JPypeDer Aufruf von Java-Code aus Python bietet mehrere mögliche Lösungen. Eine Option, JPype, kan...Programmierung Veröffentlicht am 06.11.2024

## Möchten Sie Java effizient aus Python aufrufen? Entdecken Sie Py4J als JPype-Alternative!Aufruf von Java aus Python: Py4J als Alternative zu JPypeDer Aufruf von Java-Code aus Python bietet mehrere mögliche Lösungen. Eine Option, JPype, kan...Programmierung Veröffentlicht am 06.11.2024 -

Kleine Swoole DbSmall Swoole Db 2.3 führt Left Joins ein: $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector->...Programmierung Veröffentlicht am 06.11.2024

Kleine Swoole DbSmall Swoole Db 2.3 führt Left Joins ein: $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector->...Programmierung Veröffentlicht am 06.11.2024 -

Wie kann die Funktion __mm_add_epi32_inplace_purego mithilfe von Montageanweisungen optimiert werden, um eine bessere Leistung bei Operationen zur Zählung der Positionspopulation zu erzielen?Optimieren von __mm_add_epi32_inplace_purego mithilfe von AssemblyDiese Frage zielt darauf ab, die innere Schleife der Funktion __mm_add_epi32_inplace...Programmierung Veröffentlicht am 06.11.2024

Wie kann die Funktion __mm_add_epi32_inplace_purego mithilfe von Montageanweisungen optimiert werden, um eine bessere Leistung bei Operationen zur Zählung der Positionspopulation zu erzielen?Optimieren von __mm_add_epi32_inplace_purego mithilfe von AssemblyDiese Frage zielt darauf ab, die innere Schleife der Funktion __mm_add_epi32_inplace...Programmierung Veröffentlicht am 06.11.2024 -

Navigieren mit React Router React Js Teil A Leitfaden zum Routing in React-AnwendungenWillkommen zurück zu unserer React-Reihe! In früheren Beiträgen haben wir wesentliche Konzepte wie Komponenten, Status, Requisiten und Ereignisbehandl...Programmierung Veröffentlicht am 06.11.2024

Navigieren mit React Router React Js Teil A Leitfaden zum Routing in React-AnwendungenWillkommen zurück zu unserer React-Reihe! In früheren Beiträgen haben wir wesentliche Konzepte wie Komponenten, Status, Requisiten und Ereignisbehandl...Programmierung Veröffentlicht am 06.11.2024 -

Kann file_get_contents() für HTTP-Datei-Uploads verwendet werden?Hochladen von Dateien mit file_get_contents() unter Verwendung des HTTP-Stream-KontextsDas Hochladen von Dateien über ein Webformular kann mithilfe de...Programmierung Veröffentlicht am 06.11.2024

Kann file_get_contents() für HTTP-Datei-Uploads verwendet werden?Hochladen von Dateien mit file_get_contents() unter Verwendung des HTTP-Stream-KontextsDas Hochladen von Dateien über ein Webformular kann mithilfe de...Programmierung Veröffentlicht am 06.11.2024 -

UseEffect in ReactWillkommen in der Welt der React Hooks! Heute tauchen wir in einen der beliebtesten Hooks ein: useEffect. Machen Sie sich keine Sorgen, wir machen es ...Programmierung Veröffentlicht am 06.11.2024

UseEffect in ReactWillkommen in der Welt der React Hooks! Heute tauchen wir in einen der beliebtesten Hooks ein: useEffect. Machen Sie sich keine Sorgen, wir machen es ...Programmierung Veröffentlicht am 06.11.2024 -

So bauen Sie eine moderne Datenplattform auf der kostenlosen Stufe der Google Cloud Platform aufIch habe eine Reihe von sieben kostenlosen öffentlichen Artikeln auf Medium.com veröffentlicht: „So bauen Sie eine moderne Datenplattform auf der kost...Programmierung Veröffentlicht am 06.11.2024

So bauen Sie eine moderne Datenplattform auf der kostenlosen Stufe der Google Cloud Platform aufIch habe eine Reihe von sieben kostenlosen öffentlichen Artikeln auf Medium.com veröffentlicht: „So bauen Sie eine moderne Datenplattform auf der kost...Programmierung Veröffentlicht am 06.11.2024 -

Beitrag #f kämpftIn diesem Beitrag geht es um meine bisherigen Schwierigkeiten beim Codieren und Lernen A. Ich kann nur vielleicht eine Stunde, maximal zwei Stunden, k...Programmierung Veröffentlicht am 06.11.2024

Beitrag #f kämpftIn diesem Beitrag geht es um meine bisherigen Schwierigkeiten beim Codieren und Lernen A. Ich kann nur vielleicht eine Stunde, maximal zwei Stunden, k...Programmierung Veröffentlicht am 06.11.2024 -

Top Chrome-Erweiterungen für Webentwickler in 4Top 10 Chrome-Erweiterungen für Webentwickler im Jahr 2024 Im Laufe des Jahres 2024 sind Chrome-Erweiterungen zu einem integralen Bestandteil...Programmierung Veröffentlicht am 06.11.2024

Top Chrome-Erweiterungen für Webentwickler in 4Top 10 Chrome-Erweiterungen für Webentwickler im Jahr 2024 Im Laufe des Jahres 2024 sind Chrome-Erweiterungen zu einem integralen Bestandteil...Programmierung Veröffentlicht am 06.11.2024 -

So verschachteln Sie Routen mit React Router v4/v5: Eine vereinfachte AnleitungVerschachtelte Routen mit React Router v4/v5: Eine vereinfachte AnleitungBei der Arbeit mit React Router ist das Verschachteln von Routen eine entsche...Programmierung Veröffentlicht am 06.11.2024

So verschachteln Sie Routen mit React Router v4/v5: Eine vereinfachte AnleitungVerschachtelte Routen mit React Router v4/v5: Eine vereinfachte AnleitungBei der Arbeit mit React Router ist das Verschachteln von Routen eine entsche...Programmierung Veröffentlicht am 06.11.2024 -

Wie bleibt die Tabellenformatierung in MySQL mit UTF8-Zeichenkodierung erhalten?Verbesserung der MySQL-Befehlszeilenformatierung durch UTF8-ZeichenkodierungBeim Arbeiten mit schwedischen und norwegischen Zeichenfolgen, die in eine...Programmierung Veröffentlicht am 06.11.2024

Wie bleibt die Tabellenformatierung in MySQL mit UTF8-Zeichenkodierung erhalten?Verbesserung der MySQL-Befehlszeilenformatierung durch UTF8-ZeichenkodierungBeim Arbeiten mit schwedischen und norwegischen Zeichenfolgen, die in eine...Programmierung Veröffentlicht am 06.11.2024 -

CSS-Box-ModellDas CSS-Box-Modell ist ein grundlegendes Konzept in der Webentwicklung, das die Grundlage für Layout und Design im Web bildet. Es bestimmt die Größe d...Programmierung Veröffentlicht am 06.11.2024

CSS-Box-ModellDas CSS-Box-Modell ist ein grundlegendes Konzept in der Webentwicklung, das die Grundlage für Layout und Design im Web bildet. Es bestimmt die Größe d...Programmierung Veröffentlicht am 06.11.2024

Chinesisch lernen

- 1 Wie sagt man „gehen“ auf Chinesisch? 走路 Chinesische Aussprache, 走路 Chinesisch lernen

- 2 Wie sagt man auf Chinesisch „Flugzeug nehmen“? 坐飞机 Chinesische Aussprache, 坐飞机 Chinesisch lernen

- 3 Wie sagt man auf Chinesisch „einen Zug nehmen“? 坐火车 Chinesische Aussprache, 坐火车 Chinesisch lernen

- 4 Wie sagt man auf Chinesisch „Bus nehmen“? 坐车 Chinesische Aussprache, 坐车 Chinesisch lernen

- 5 Wie sagt man „Fahren“ auf Chinesisch? 开车 Chinesische Aussprache, 开车 Chinesisch lernen

- 6 Wie sagt man Schwimmen auf Chinesisch? 游泳 Chinesische Aussprache, 游泳 Chinesisch lernen

- 7 Wie sagt man auf Chinesisch „Fahrrad fahren“? 骑自行车 Chinesische Aussprache, 骑自行车 Chinesisch lernen

- 8 Wie sagt man auf Chinesisch Hallo? 你好Chinesische Aussprache, 你好Chinesisch lernen

- 9 Wie sagt man „Danke“ auf Chinesisch? 谢谢Chinesische Aussprache, 谢谢Chinesisch lernen

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning