为什么我的 Google Colab 会话在运行 Llama 模型时崩溃?

发布于2024-08-27

我正在尝试使用 meta-llama/Llama-2-7b-hf 模型并在我的场所本地运行它,但会话在此过程中崩溃了。

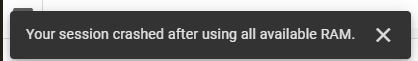

我正在尝试使用 meta-llama/Llama-2-7b-hf 模型并在我的场所本地运行它。为此,我使用 Google Colab 并从 Hugging Face 获取了访问密钥。我正在利用他们的变压器库来完成必要的任务。最初,我在 Google Colab 上使用 T4 GPU 运行时堆栈,它提供 12.7 GB 系统 RAM、15.0 GB GPU RAM 和 78.2 GB 磁盘空间。尽管有这些资源,我的会话还是崩溃了,并且遇到了以下错误:

随后,我切换到 TPU V2 运行时堆栈,它提供 334.6 GB 的系统 RAM 和 225.3 GB 的磁盘空间,但问题仍然存在。

这是我的代码:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

版本声明

本文转载于:https://dev.to/riddhi_007f87a3b86e45bf61/why-did-my-google-colab-session-crash-while-running-the-llama-model-4bce?1如有侵犯,请联系[email protected]删除

最新教程

更多>

-

React 中的 UseEffect欢迎来到 React Hooks 的世界!今天,我们将深入探讨最流行的挂钩之一:useEffect。别担心,我们会让它变得有趣且易于理解。那么,让我们开始吧! ? ?什么是useEffect useEffect 是一个 React Hook,允许您在功能组件中执行副作用。副作用是在组件外部发生的操作...编程 发布于2024-11-06

React 中的 UseEffect欢迎来到 React Hooks 的世界!今天,我们将深入探讨最流行的挂钩之一:useEffect。别担心,我们会让它变得有趣且易于理解。那么,让我们开始吧! ? ?什么是useEffect useEffect 是一个 React Hook,允许您在功能组件中执行副作用。副作用是在组件外部发生的操作...编程 发布于2024-11-06 -

如何在 Google Cloud Platform 免费层上构建现代数据平台我在 Medium.com 上发布了一系列七篇免费公开文章“如何在 Google Cloud Platform 免费层上构建现代数据平台”。 主要文章位于:https://medium.com/@markwkiehl/building-a-data-platform-on-gcp-0427500f...编程 发布于2024-11-06

如何在 Google Cloud Platform 免费层上构建现代数据平台我在 Medium.com 上发布了一系列七篇免费公开文章“如何在 Google Cloud Platform 免费层上构建现代数据平台”。 主要文章位于:https://medium.com/@markwkiehl/building-a-data-platform-on-gcp-0427500f...编程 发布于2024-11-06 -

面向 Web 开发人员的热门 Chrome 扩展 42024 年最适合 Web 开发者的 10 款 Chrome 扩展 随着 2024 年的进展,Chrome 扩展程序已成为 Web 开发人员工具包中不可或缺的一部分,在浏览器中提供强大的功能。在这篇文章中,我们将探讨今年在 Web 开发社区掀起波澜的 10 大 Chrome 扩展程...编程 发布于2024-11-06

面向 Web 开发人员的热门 Chrome 扩展 42024 年最适合 Web 开发者的 10 款 Chrome 扩展 随着 2024 年的进展,Chrome 扩展程序已成为 Web 开发人员工具包中不可或缺的一部分,在浏览器中提供强大的功能。在这篇文章中,我们将探讨今年在 Web 开发社区掀起波澜的 10 大 Chrome 扩展程...编程 发布于2024-11-06 -

如何使用 React Router v4/v5 嵌套路由:简化指南React Router v4/v5 的嵌套路由:简化指南使用 React Router 时,嵌套路由是组织的关键技术您的应用程序的导航。然而,新手经常面临设置嵌套路由的挑战。本文旨在简化使用 React Router v4/v5 的过程。React Router v4 在路由嵌套方式上引入了重大转...编程 发布于2024-11-06

如何使用 React Router v4/v5 嵌套路由:简化指南React Router v4/v5 的嵌套路由:简化指南使用 React Router 时,嵌套路由是组织的关键技术您的应用程序的导航。然而,新手经常面临设置嵌套路由的挑战。本文旨在简化使用 React Router v4/v5 的过程。React Router v4 在路由嵌套方式上引入了重大转...编程 发布于2024-11-06 -

如何使用 UTF8 字符编码保留 MySQL 中的表格式?使用 UTF8 字符编码增强 MySQL 命令行格式使用存储在数据库表中的瑞典语和挪威语字符串时,查询数据时可能会遇到表格式问题使用不同的字符集。问题陈述默认情况下,使用“set names latin1;”产生失真的输出: ----------------------------------- ...编程 发布于2024-11-06

如何使用 UTF8 字符编码保留 MySQL 中的表格式?使用 UTF8 字符编码增强 MySQL 命令行格式使用存储在数据库表中的瑞典语和挪威语字符串时,查询数据时可能会遇到表格式问题使用不同的字符集。问题陈述默认情况下,使用“set names latin1;”产生失真的输出: ----------------------------------- ...编程 发布于2024-11-06 -

我如何编写 CSS 选择器有很多 CSS 方法,但我讨厌它们。有些多(顺风等),有些少(BEM、OOCSS 等)。但归根结底,它们都有缺陷。 当然,人们使用这些方法有充分的理由,并且解决的许多问题我也遇到过。因此,在这篇文章中,我想写下我自己的关于如何保持 CSS 组织的指南。 这不是一个任何人都可以开始使用的完整描述的 C...编程 发布于2024-11-06

我如何编写 CSS 选择器有很多 CSS 方法,但我讨厌它们。有些多(顺风等),有些少(BEM、OOCSS 等)。但归根结底,它们都有缺陷。 当然,人们使用这些方法有充分的理由,并且解决的许多问题我也遇到过。因此,在这篇文章中,我想写下我自己的关于如何保持 CSS 组织的指南。 这不是一个任何人都可以开始使用的完整描述的 C...编程 发布于2024-11-06 -

为什么输入元素不支持 HTML5 中的 ::after 伪元素?::before 和 ::after 的伪元素兼容性在 HTML5 中,::before 和 ::after 伪元素可以使用附加内容(例如图标或复选标记)增强元素。然而,并非所有元素都完全支持这些伪元素。输入元素和 ::after在提供的示例中,::after 伪元素不是显示在输入元素上。这是因为类...编程 发布于2024-11-06

为什么输入元素不支持 HTML5 中的 ::after 伪元素?::before 和 ::after 的伪元素兼容性在 HTML5 中,::before 和 ::after 伪元素可以使用附加内容(例如图标或复选标记)增强元素。然而,并非所有元素都完全支持这些伪元素。输入元素和 ::after在提供的示例中,::after 伪元素不是显示在输入元素上。这是因为类...编程 发布于2024-11-06 -

如何使用 PHP 确定特定时区的星期几?在 PHP 中确定指定时区的星期几在 PHP 中处理日期和时间时,处理起来可能具有挑战性时区并计算具体值,例如星期几。本文将指导您完成使用 PHP 查找特定时区中的星期几的过程。了解用户的时区要确定用户的时区,您需要使用 PHP 函数 date_default_timezone_get()。此函数返...编程 发布于2024-11-06

如何使用 PHP 确定特定时区的星期几?在 PHP 中确定指定时区的星期几在 PHP 中处理日期和时间时,处理起来可能具有挑战性时区并计算具体值,例如星期几。本文将指导您完成使用 PHP 查找特定时区中的星期几的过程。了解用户的时区要确定用户的时区,您需要使用 PHP 函数 date_default_timezone_get()。此函数返...编程 发布于2024-11-06 -

如何在 Go 通道中有效地生成不同的值?在 Go Channel 中高效生成不同值在 Go 中,Channel 为并发通信提供了强大的机制。但是,在使用通道时,您可能会遇到需要过滤掉重复值或确保仅发出不同值的情况。本文探讨了创建仅输出唯一值的通道的有效方法。生成不同值的挑战考虑以下场景:您有一个通道接收多个值,并且您希望迭代它,同时仅打印...编程 发布于2024-11-06

如何在 Go 通道中有效地生成不同的值?在 Go Channel 中高效生成不同值在 Go 中,Channel 为并发通信提供了强大的机制。但是,在使用通道时,您可能会遇到需要过滤掉重复值或确保仅发出不同值的情况。本文探讨了创建仅输出唯一值的通道的有效方法。生成不同值的挑战考虑以下场景:您有一个通道接收多个值,并且您希望迭代它,同时仅打印...编程 发布于2024-11-06 -

如何使用 Tailwind CSS 设置 os Next.js要使用 Tailwind CSS 设置 Next.js,请按照以下步骤操作: 第 1 步:创建一个新的 Next.js 项目 如果您尚未创建 Next.js 项目,您可以使用 create-next-app 创建一个项目。 npx create-next-app@latest my-...编程 发布于2024-11-06

如何使用 Tailwind CSS 设置 os Next.js要使用 Tailwind CSS 设置 Next.js,请按照以下步骤操作: 第 1 步:创建一个新的 Next.js 项目 如果您尚未创建 Next.js 项目,您可以使用 create-next-app 创建一个项目。 npx create-next-app@latest my-...编程 发布于2024-11-06 -

如何解决 PHPmailer HTML 内容渲染问题?PHPmailer 无法渲染 HTML 内容使用 PHPmailer 发送电子邮件时,用户遇到 HTML 代码显示为原始文本的问题交货时。尽管使用了 IsHTML() 方法,所需的 HTML 内容仍然无法访问。潜在问题此行为背后的原因在于方法调用的顺序。与它的前身不同,PHPMailer 6 要求在...编程 发布于2024-11-06

如何解决 PHPmailer HTML 内容渲染问题?PHPmailer 无法渲染 HTML 内容使用 PHPmailer 发送电子邮件时,用户遇到 HTML 代码显示为原始文本的问题交货时。尽管使用了 IsHTML() 方法,所需的 HTML 内容仍然无法访问。潜在问题此行为背后的原因在于方法调用的顺序。与它的前身不同,PHPMailer 6 要求在...编程 发布于2024-11-06 -

如何使用 Java 从 HTML 文档中提取数据?Java HTML解析要从网站获取数据,首先必须了解HTML文档的结构。 HTML 元素使用标签进行组织,标签指定每个元素的类型和内容。例如,以下 HTML 表示具有特定 CSS 类的 div 标签:<div class="classname"></div>...编程 发布于2024-11-06

如何使用 Java 从 HTML 文档中提取数据?Java HTML解析要从网站获取数据,首先必须了解HTML文档的结构。 HTML 元素使用标签进行组织,标签指定每个元素的类型和内容。例如,以下 HTML 表示具有特定 CSS 类的 div 标签:<div class="classname"></div>...编程 发布于2024-11-06 -

为什么 Java 异常处理代码会产生“132Exception in thread main MyExc1”而不是“13Exception in thread main MyExc2”?Java中的异常处理:解开歧义在一个令人费解的Java异常处理场景中,一个大学问题提出了以下代码片段: // Exception Heirarchy class MyExc1 extends Exception {} class MyExc2 extends Exception {} class M...编程 发布于2024-11-06

为什么 Java 异常处理代码会产生“132Exception in thread main MyExc1”而不是“13Exception in thread main MyExc2”?Java中的异常处理:解开歧义在一个令人费解的Java异常处理场景中,一个大学问题提出了以下代码片段: // Exception Heirarchy class MyExc1 extends Exception {} class MyExc2 extends Exception {} class M...编程 发布于2024-11-06

学习中文

- 1 走路用中文怎么说?走路中文发音,走路中文学习

- 2 坐飞机用中文怎么说?坐飞机中文发音,坐飞机中文学习

- 3 坐火车用中文怎么说?坐火车中文发音,坐火车中文学习

- 4 坐车用中文怎么说?坐车中文发音,坐车中文学习

- 5 开车用中文怎么说?开车中文发音,开车中文学习

- 6 游泳用中文怎么说?游泳中文发音,游泳中文学习

- 7 骑自行车用中文怎么说?骑自行车中文发音,骑自行车中文学习

- 8 你好用中文怎么说?你好中文发音,你好中文学习

- 9 谢谢用中文怎么说?谢谢中文发音,谢谢中文学习

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning