为什么 Gemini 1.5 的 100 万代币上下文会改变游戏规则

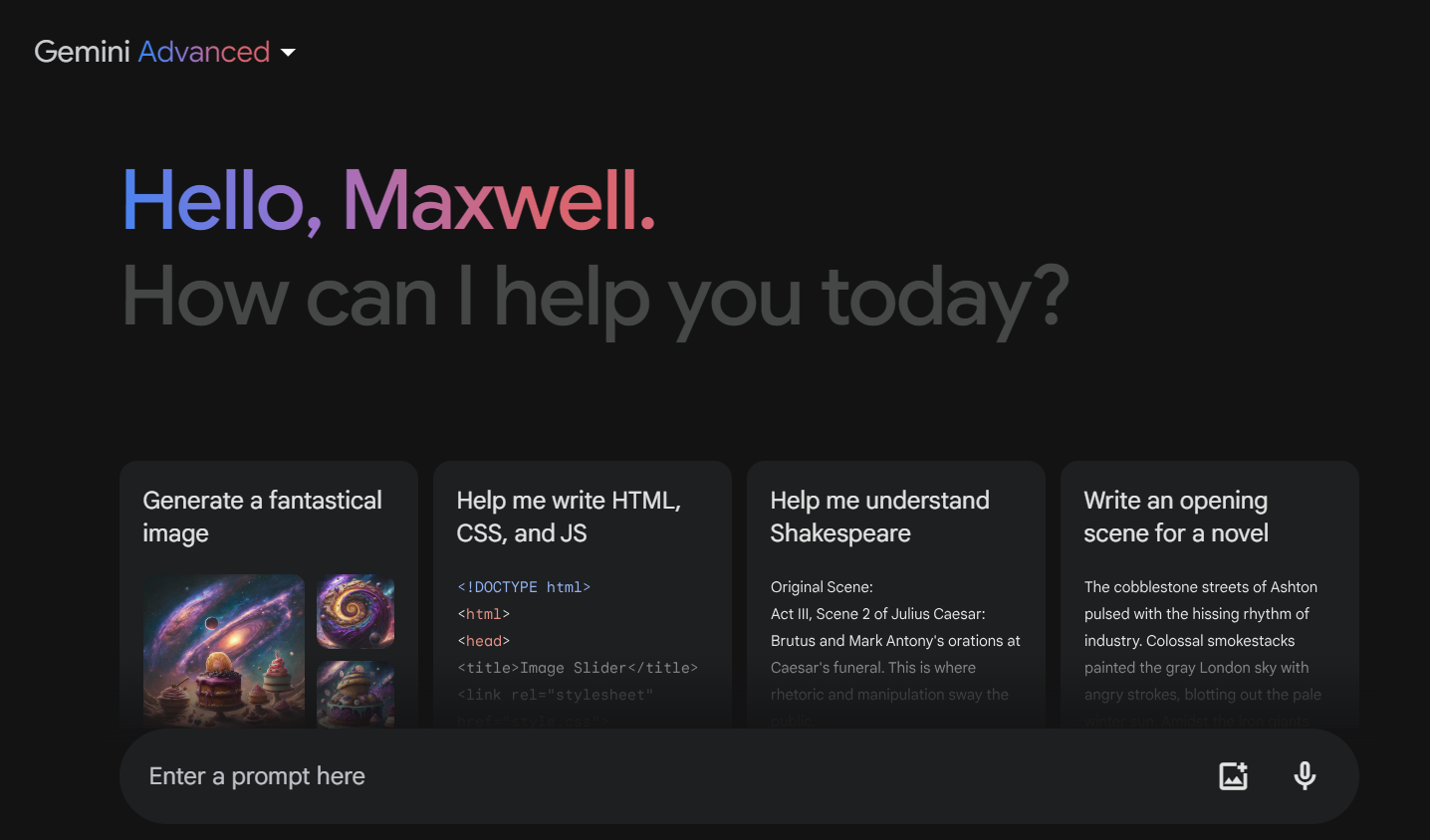

Google Gemini 1.5 现在配备了一个巨大的 100 万个代币上下文窗口,使其在 ChatGPT、Claude 和其他 AI 聊天机器人中的直接竞争对手相形见绌。

这听起来像是一次大规模升级,可以让双子座与众不同。全面了解它的范围有点困难,但双子座巨大的上下文窗口可能会改变游戏规则。

什么是上下文窗口?

在回答您的查询时,例如解释概念或总结文本,AI 模型在生成响应时可以考虑的数据量是有限的。它可以考虑的文本大小的限制称为上下文窗口。

这是另一种看待它的方式。假设您去杂货店购买杂货,但没有杂货清单。您在购物时记住的杂货数量的限制是您的上下文窗口。您记住的杂货越多,不打乱您的购物计划的机会就越大。同样,人工智能模型的上下文窗口越大,模型记住为您提供最佳结果所需的一切的机会就越大。

在撰写本文时,Anthropic 的 Claude 2.1 的 200k 上下文窗口是任何通用 AI 模型中最大的上下文窗口。其次是具有 128k 上下文窗口的 GPT-4 Turbo。 Google Gemini 1.5 带来了 100 万个上下文窗口,是市场上任何产品的四倍。这就引出了一个大问题:一百万个令牌上下文窗口有什么大不了的?

为什么 Gemini 1.5 的上下文窗口很重要

从更清晰的角度来看,Claude AI 的 200k 上下文窗口意味着它可以消化一本大约 15 万字的书,并且提供答案。那是巨大的。但 Google 的 Gemini 1.5 一次就能消化 700,000 个单词!

当您将大文本块输入 ChatGPT 或 Gemini 等 AI 聊天机器人时,它会尝试消化尽可能多的文本,但它能消化多少取决于其上下文窗口。因此,如果您的对话在只能处理 28k 字的模型上进行了 100k 字,然后开始提出要求其完全了解整个 100k 字对话的问题,那么您将使其失败。

想象一下,一部一小时长的电影只看了 20 分钟,却被要求解释整部电影。你的结果会有多好?你要么拒绝回答,要么干脆编造一些东西,这正是人工智能聊天机器人会做的事情,导致人工智能幻觉。

现在,如果您认为您从未需要向聊天机器人输入 10 万个单词,那么这并不是全部考虑因素。上下文窗口超越了您在单个提示中向 AI 模型提供的文本。人工智能模型会考虑您在聊天会话期间进行的整个对话,以确保他们的响应尽可能相关。

因此,即使您没有给它提供一本 100k 单词的书,您的来回对话和它提供的回复都会添加到上下文窗口计算中。想知道为什么 ChatGPT 或 Google 的 Gemini 总是忘记你之前在对话中告诉它的事情?它可能耗尽了上下文窗口空间并开始忘记东西。

较大的上下文窗口对于需要深入理解上下文的任务尤其重要,例如总结长文章、回答复杂问题或在生成的文本中保持连贯的叙述。想要写一本 5 万字且叙事自始至终一致的小说吗?想要一个可以“观看”一小时视频文件并回答问题的模型吗?您需要更大的上下文窗口!

简而言之,Gemini 1.5 更大的上下文窗口可能会显着提高其 AI 模型的性能,减少幻觉,并显着提高准确性和更好地遵循指令的能力。

Gemini 1.5能否不负众望?

如果一切按计划进行,Gemini 1.5 可能会超越市场上最好的人工智能模型。然而,考虑到谷歌在构建稳定的人工智能模型方面多次失败,谨慎行事是很重要的。单独增加模型的上下文窗口并不会自动使模型变得更好。

自发布以来,我已经使用 Claude 2.1 的 200k 上下文窗口几个月了,有一点我很清楚——更大的上下文窗口确实可以提高上下文敏感性,但是核心模型性能的问题可能会导致更大的背景本身就是一个问题。

Google Gemini 1.5 会给我们带来游戏规则改变者吗?目前,社交媒体上充斥着抢先体验用户对 Gemini 1.5 的热烈评论。然而,大多数 5 星级评论都源于仓促或简化的用例。 Google 的 Gemini 1.5 技术报告 [PDF] 是检查 Gemini 1.5 在野外表现的好地方。该报告显示,即使在“受控测试”期间,该模型也无法在其上下文窗口的大小范围内很好地检索文档的所有微小细节。

100万个token上下文窗口确实是一项令人印象深刻的技术壮举,但是如果不能可靠地检索文档的详细信息,那么更大的上下文窗口没有什么实用价值,甚至可能成为下降的原因准确性和幻觉。

-

LLM必备的8个免费与付费API推荐利用LLMS的力量:大型语言模型的API指南 在当今的动态业务格局中,API(应用程序编程接口)正在革新我们如何整合和利用AI功能。 它们充当必不可少的桥梁,无缝将大型语言模型(LLM)连接到不同的软件生态系统。 这种有效的数据交换和功能共享允许应用程序充分利用开放和封闭源LLM的功率。本文探讨...人工智能 发布于2025-04-21

LLM必备的8个免费与付费API推荐利用LLMS的力量:大型语言模型的API指南 在当今的动态业务格局中,API(应用程序编程接口)正在革新我们如何整合和利用AI功能。 它们充当必不可少的桥梁,无缝将大型语言模型(LLM)连接到不同的软件生态系统。 这种有效的数据交换和功能共享允许应用程序充分利用开放和封闭源LLM的功率。本文探讨...人工智能 发布于2025-04-21 -

使用指南:Falcon 3-7B Instruct模型中的革命性飞跃 关键功能和改进 可扩展的模型大小:有各种尺寸(1b,3b,7b和10b parameters),为各种应用程序提供了灵活性。 高级文本生成:文本生成中的异常功能,包括细微的上下文理解和特定于任务的应用程序。 本文是数据科学博客马拉松的一部分。 目录 架构设计 性能基准 [2 [2 使...人工智能 发布于2025-04-20

使用指南:Falcon 3-7B Instruct模型中的革命性飞跃 关键功能和改进 可扩展的模型大小:有各种尺寸(1b,3b,7b和10b parameters),为各种应用程序提供了灵活性。 高级文本生成:文本生成中的异常功能,包括细微的上下文理解和特定于任务的应用程序。 本文是数据科学博客马拉松的一部分。 目录 架构设计 性能基准 [2 [2 使...人工智能 发布于2025-04-20 -

DeepSeek-V3对比GPT-4o与Llama 3.3 70B:最强AI模型揭秘The evolution of AI language models has set new standards, especially in the coding and programming landscape. Leading the c...人工智能 发布于2025-04-18

DeepSeek-V3对比GPT-4o与Llama 3.3 70B:最强AI模型揭秘The evolution of AI language models has set new standards, especially in the coding and programming landscape. Leading the c...人工智能 发布于2025-04-18 -

盘点Top 5 AI智能预算工具通过AI解锁财务自由:印度的最高预算应用程序 您是否厌倦了不断想知道您的钱去了哪里? 账单似乎会吞噬您的收入吗? 人工智能(AI)提供了强大的解决方案。 AI预算工具提供实时财务见解,个性化建议和动态计划,使资金管理更简单,更准确。 有些甚至使用生成AI提供基于聊天的财务分析!本文探讨了印度可...人工智能 发布于2025-04-17

盘点Top 5 AI智能预算工具通过AI解锁财务自由:印度的最高预算应用程序 您是否厌倦了不断想知道您的钱去了哪里? 账单似乎会吞噬您的收入吗? 人工智能(AI)提供了强大的解决方案。 AI预算工具提供实时财务见解,个性化建议和动态计划,使资金管理更简单,更准确。 有些甚至使用生成AI提供基于聊天的财务分析!本文探讨了印度可...人工智能 发布于2025-04-17 -

Excel SUMPRODUCT函数详解 - 数据分析学院Excel的SumProduct函数:数据分析PowerHouse 解锁Excel的Sumproduct函数的功能,以用于简化数据分析。这种多功能功能毫不费力地结合了求和功能,扩展到跨相应范围或数组的加法,减法和分裂。 无论您是分析趋势还是解决复杂的计算,Sumproduct都会将数字转换为可...人工智能 发布于2025-04-16

Excel SUMPRODUCT函数详解 - 数据分析学院Excel的SumProduct函数:数据分析PowerHouse 解锁Excel的Sumproduct函数的功能,以用于简化数据分析。这种多功能功能毫不费力地结合了求和功能,扩展到跨相应范围或数组的加法,减法和分裂。 无论您是分析趋势还是解决复杂的计算,Sumproduct都会将数字转换为可...人工智能 发布于2025-04-16 -

深度研究全面开放,ChatGPT Plus用户福利Openai的深入研究:改变游戏的AI研究 Openai已为所有Chatgpt加上订户释放了深入的研究,并承诺在研究效率方面具有重大提高。 在测试了双子座,Grok 3和困惑等竞争对手的类似功能之后,我可以自信地将Openai的深入研究宣布为出色的选择。此博客深入研究了它的功能。 目录 什么是...人工智能 发布于2025-04-16

深度研究全面开放,ChatGPT Plus用户福利Openai的深入研究:改变游戏的AI研究 Openai已为所有Chatgpt加上订户释放了深入的研究,并承诺在研究效率方面具有重大提高。 在测试了双子座,Grok 3和困惑等竞争对手的类似功能之后,我可以自信地将Openai的深入研究宣布为出色的选择。此博客深入研究了它的功能。 目录 什么是...人工智能 发布于2025-04-16 -

亚马逊Nova Today真实体验与评测 - Analytics Vidhya亚马逊最近的回复:Invent 2024活动展示了Nova,这是其最先进的基础模型套件,旨在彻底改变AI和内容创建。本文深入研究了Nova的架构,通过动手实例探索其功能,并检查基准结果。 我们将介绍功能,评论,基准和对AI应用程序的影响。 [2 此探索将涵盖Amazon Nova的功能,详细的评论...人工智能 发布于2025-04-16

亚马逊Nova Today真实体验与评测 - Analytics Vidhya亚马逊最近的回复:Invent 2024活动展示了Nova,这是其最先进的基础模型套件,旨在彻底改变AI和内容创建。本文深入研究了Nova的架构,通过动手实例探索其功能,并检查基准结果。 我们将介绍功能,评论,基准和对AI应用程序的影响。 [2 此探索将涵盖Amazon Nova的功能,详细的评论...人工智能 发布于2025-04-16 -

ChatGPT定时任务功能的5种使用方法Chatgpt的新计划任务:使用AI 自动化您的一天 Chatgpt最近引入了一个改变游戏规则的功能:计划的任务。 这允许用户自动化重复提示,即使在离线时,也可以在预定时间接收通知或响应。想象一下每天策划的新闻通讯,自动化工作时间表或及时的习惯提醒 - 所有这些都是由Chatgpt自动处理的。...人工智能 发布于2025-04-16

ChatGPT定时任务功能的5种使用方法Chatgpt的新计划任务:使用AI 自动化您的一天 Chatgpt最近引入了一个改变游戏规则的功能:计划的任务。 这允许用户自动化重复提示,即使在离线时,也可以在预定时间接收通知或响应。想象一下每天策划的新闻通讯,自动化工作时间表或及时的习惯提醒 - 所有这些都是由Chatgpt自动处理的。...人工智能 发布于2025-04-16 -

三款AI聊机器人对同一提示的反应,哪个最佳?这是我发现的。在精心策划且详细的提示中扮演着质量良好的提示,在输出的质量中扮演任何cathbot生产的质量。与所有工具一样,输出仅与使用该工具的人的技能一样好。 AI聊天机器人没有什么不同。 有了这种理解,我指示每个模型创建一个针对个人理财的基本指南。这种方法使我能够评估多个相互联系的主题(特别是...人工智能 发布于2025-04-15

三款AI聊机器人对同一提示的反应,哪个最佳?这是我发现的。在精心策划且详细的提示中扮演着质量良好的提示,在输出的质量中扮演任何cathbot生产的质量。与所有工具一样,输出仅与使用该工具的人的技能一样好。 AI聊天机器人没有什么不同。 有了这种理解,我指示每个模型创建一个针对个人理财的基本指南。这种方法使我能够评估多个相互联系的主题(特别是...人工智能 发布于2025-04-15 -

ChatGPT足矣,无需专用AI聊机在一个新的AI聊天机器人每天启动的世界中,决定哪一个是正确的“一个”。但是,以我的经验,chatgpt处理了我所丢下的几乎所有内容,而无需在平台之间切换,只需稍有及时的工程。 在许多实践应用程序中可能会让您感到惊讶。它的范围令人印象深刻,使用户可以生成代码段,草稿求职信,甚至翻译语言。这种多功能性...人工智能 发布于2025-04-14

ChatGPT足矣,无需专用AI聊机在一个新的AI聊天机器人每天启动的世界中,决定哪一个是正确的“一个”。但是,以我的经验,chatgpt处理了我所丢下的几乎所有内容,而无需在平台之间切换,只需稍有及时的工程。 在许多实践应用程序中可能会让您感到惊讶。它的范围令人印象深刻,使用户可以生成代码段,草稿求职信,甚至翻译语言。这种多功能性...人工智能 发布于2025-04-14 -

印度AI时刻:与中美在生成AI领域竞赛印度的AI抱负:2025 Update 与中国和美国在生成AI上进行了大量投资,印度正在加快自己的Genai计划。 不可否认的是,迫切需要迎合印度各种语言和文化景观的土著大语模型(LLM)和AI工具。 本文探讨了印度新兴的Genai生态系统,重点介绍了2025年工会预算,公司参与,技能开发计划...人工智能 发布于2025-04-13

印度AI时刻:与中美在生成AI领域竞赛印度的AI抱负:2025 Update 与中国和美国在生成AI上进行了大量投资,印度正在加快自己的Genai计划。 不可否认的是,迫切需要迎合印度各种语言和文化景观的土著大语模型(LLM)和AI工具。 本文探讨了印度新兴的Genai生态系统,重点介绍了2025年工会预算,公司参与,技能开发计划...人工智能 发布于2025-04-13 -

使用Airflow和Docker自动化CSV到PostgreSQL的导入本教程演示了使用Apache气流,Docker和PostgreSQL构建强大的数据管道,以使数据传输从CSV文件自动化到数据库。 我们将介绍有效工作流程管理的核心气流概念,例如DAG,任务和操作员。 该项目展示了创建可靠的数据管道,该数据管线读取CSV数据并将其写入PostgreSQL数据库。我们...人工智能 发布于2025-04-12

使用Airflow和Docker自动化CSV到PostgreSQL的导入本教程演示了使用Apache气流,Docker和PostgreSQL构建强大的数据管道,以使数据传输从CSV文件自动化到数据库。 我们将介绍有效工作流程管理的核心气流概念,例如DAG,任务和操作员。 该项目展示了创建可靠的数据管道,该数据管线读取CSV数据并将其写入PostgreSQL数据库。我们...人工智能 发布于2025-04-12 -

群智能算法:三个Python实现Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...人工智能 发布于2025-03-24

群智能算法:三个Python实现Imagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...人工智能 发布于2025-03-24 -

如何通过抹布和微调使LLM更准确Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...人工智能 发布于2025-03-24

如何通过抹布和微调使LLM更准确Imagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...人工智能 发布于2025-03-24 -

什么是Google Gemini?您需要了解的有关Google Chatgpt竞争对手的一切Google recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...人工智能 发布于2025-03-23

什么是Google Gemini?您需要了解的有关Google Chatgpt竞争对手的一切Google recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...人工智能 发布于2025-03-23

学习中文

- 1 走路用中文怎么说?走路中文发音,走路中文学习

- 2 坐飞机用中文怎么说?坐飞机中文发音,坐飞机中文学习

- 3 坐火车用中文怎么说?坐火车中文发音,坐火车中文学习

- 4 坐车用中文怎么说?坐车中文发音,坐车中文学习

- 5 开车用中文怎么说?开车中文发音,开车中文学习

- 6 游泳用中文怎么说?游泳中文发音,游泳中文学习

- 7 骑自行车用中文怎么说?骑自行车中文发音,骑自行车中文学习

- 8 你好用中文怎么说?你好中文发音,你好中文学习

- 9 谢谢用中文怎么说?谢谢中文发音,谢谢中文学习

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning