Llama 모델을 실행하는 동안 Google Colab 세션이 충돌하는 이유는 무엇입니까?

2024-08-27에 게시됨

meta-llama/Llama-2-7b-hf 모델을 사용하여 내 구내에서 로컬로 실행하려고 하는데 프로세스 중에 세션이 중단되었습니다.

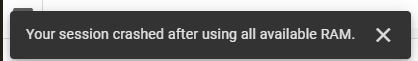

meta-llama/Llama-2-7b-hf 모델을 사용하여 내 구내에서 로컬로 실행하려고 합니다. 이를 위해 Google Colab을 사용하고 있으며 Hugging Face에서 액세스 키를 받았습니다. 필요한 작업을 위해 변압기 라이브러리를 활용하고 있습니다. 처음에는 12.7GB의 시스템 RAM, 15.0GB의 GPU RAM 및 78.2GB의 디스크 공간을 제공하는 Google Colab에서 T4 GPU 런타임 스택을 사용했습니다. 이러한 리소스에도 불구하고 세션이 중단되었으며 다음 오류가 발생했습니다.

그런 다음 334.6GB의 시스템 RAM과 225.3GB의 디스크 공간을 제공하는 TPU V2 런타임 스택으로 전환했지만 문제가 지속되었습니다.

내 코드는 다음과 같습니다.

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

릴리스 선언문

이 기사는 https://dev.to/riddhi_007f87a3b86e45bf61/why-did-my-google-colab-session-crash-while-running-the-llama-model-4bce?1에 재현되어 있습니다.1 침해가 있는 경우, 문의 Study_golang@163 .comdelete

최신 튜토리얼

더>

-

AdoptiumJDK 소스 코드를 Eclipse IDE에 로드AdoptiumJDK에는 설치 프로그램에 소스 코드 파일이 내장되어 있지 않으며 Eclipse IDE를 통해 기본 JDK 메서드를 사용하는 방법을 확인해야 하는 경우에는 불가능합니다. Eclipse IDE에서 소스 코드를 로드하려면 다음 단계를 따르세요. Adoptiu...프로그램 작성 2024-11-06에 게시됨

AdoptiumJDK 소스 코드를 Eclipse IDE에 로드AdoptiumJDK에는 설치 프로그램에 소스 코드 파일이 내장되어 있지 않으며 Eclipse IDE를 통해 기본 JDK 메서드를 사용하는 방법을 확인해야 하는 경우에는 불가능합니다. Eclipse IDE에서 소스 코드를 로드하려면 다음 단계를 따르세요. Adoptiu...프로그램 작성 2024-11-06에 게시됨 -

절대 위치와 상대 위치 지정: 왜 그렇게 다르게 행동합니까?절대 위치와 상대 위치 이해: 너비, 높이 등웹 페이지에서 위치 지정 요소를 다룰 때 개념 이해 절대 위치와 상대 위치의 차이가 중요합니다. 종종 의문이 제기되는 네 가지 핵심 사항을 살펴보겠습니다.1. 상대 너비와 절대 너비상대적으로 배치된 div는 자동으로 100%...프로그램 작성 2024-11-06에 게시됨

절대 위치와 상대 위치 지정: 왜 그렇게 다르게 행동합니까?절대 위치와 상대 위치 이해: 너비, 높이 등웹 페이지에서 위치 지정 요소를 다룰 때 개념 이해 절대 위치와 상대 위치의 차이가 중요합니다. 종종 의문이 제기되는 네 가지 핵심 사항을 살펴보겠습니다.1. 상대 너비와 절대 너비상대적으로 배치된 div는 자동으로 100%...프로그램 작성 2024-11-06에 게시됨 -

Python, Node j, PHP의 재보안 문자 인식을 위한 상위 모듈자동화 시대에는 대부분의 솔루션을 자유롭게 찾을 수 있습니다. 지금 당장 수학 문제를 해결하는 것이 아니라 데이터 구문 분석, 그리고 우리의 경우와 마찬가지로 recaptcha 인식도 가능합니다. 그런데 좋은 모듈을 어떻게 찾나요? 결국 기술에 접근할 수 있게 되면 성...프로그램 작성 2024-11-06에 게시됨

Python, Node j, PHP의 재보안 문자 인식을 위한 상위 모듈자동화 시대에는 대부분의 솔루션을 자유롭게 찾을 수 있습니다. 지금 당장 수학 문제를 해결하는 것이 아니라 데이터 구문 분석, 그리고 우리의 경우와 마찬가지로 recaptcha 인식도 가능합니다. 그런데 좋은 모듈을 어떻게 찾나요? 결국 기술에 접근할 수 있게 되면 성...프로그램 작성 2024-11-06에 게시됨 -

다음은 질문 형식과 핵심 내용에 초점을 맞춘 몇 가지 제목 옵션입니다. **옵션 1(직접적이고 간결하게):** * **PHP에서 다차원 배열을 효율적으로 반복하는 방법은 무엇입니까?** **옵션 2PHP에서 다차원 배열 반복다차원 배열은 구문 분석하기 어려울 수 있으며, 특히 다양한 수준의 깊이와 비순차적 인덱스를 처리할 때 더욱 그렇습니다. 다음과 같이 여러 아티스트와 해당 링크를 포함할 수 있는 이벤트 정보를 보유하는 배열을 고려해 보세요.array(2) {...프로그램 작성 2024-11-06에 게시됨

다음은 질문 형식과 핵심 내용에 초점을 맞춘 몇 가지 제목 옵션입니다. **옵션 1(직접적이고 간결하게):** * **PHP에서 다차원 배열을 효율적으로 반복하는 방법은 무엇입니까?** **옵션 2PHP에서 다차원 배열 반복다차원 배열은 구문 분석하기 어려울 수 있으며, 특히 다양한 수준의 깊이와 비순차적 인덱스를 처리할 때 더욱 그렇습니다. 다음과 같이 여러 아티스트와 해당 링크를 포함할 수 있는 이벤트 정보를 보유하는 배열을 고려해 보세요.array(2) {...프로그램 작성 2024-11-06에 게시됨 -

Linting을 통한 코드 품질 향상Whenever I start a new project, one of the first things I do is put in place a code linter. For the uninitiated, linters analyze your project and call...프로그램 작성 2024-11-06에 게시됨

Linting을 통한 코드 품질 향상Whenever I start a new project, one of the first things I do is put in place a code linter. For the uninitiated, linters analyze your project and call...프로그램 작성 2024-11-06에 게시됨 -

JavaScript에서 콜백 함수를 효과적으로 실행하는 방법은 무엇입니까?JavaScript에서 콜백 함수의 본질 이해JavaScript에서 콜백 함수는 다른 함수가 완료된 후 함수를 실행할 수 있는 편리한 메커니즘을 제공합니다. 그 실행. 개념은 간단하지만 콜백의 최적 구현이 때로는 불분명할 수 있습니다. 간단한 예를 살펴보겠습니다.var...프로그램 작성 2024-11-06에 게시됨

JavaScript에서 콜백 함수를 효과적으로 실행하는 방법은 무엇입니까?JavaScript에서 콜백 함수의 본질 이해JavaScript에서 콜백 함수는 다른 함수가 완료된 후 함수를 실행할 수 있는 편리한 메커니즘을 제공합니다. 그 실행. 개념은 간단하지만 콜백의 최적 구현이 때로는 불분명할 수 있습니다. 간단한 예를 살펴보겠습니다.var...프로그램 작성 2024-11-06에 게시됨 -

Vue 프레임워크 소개What is Vue? from the Vue website Vue is a "progressive" JavaScript framework for building user interfaces. It works by build...프로그램 작성 2024-11-06에 게시됨

Vue 프레임워크 소개What is Vue? from the Vue website Vue is a "progressive" JavaScript framework for building user interfaces. It works by build...프로그램 작성 2024-11-06에 게시됨 -

드라마 탈출: HydePHP가 WordPress 대안인 이유워드프레스 드라마 WordPress 생태계가 전례 없는 혼란에 직면하면서 많은 개발자와 사이트 소유자가 플랫폼 선택을 재고하고 있습니다. 최근 WordPress 공동 창업자인 Matt Mullenweg와 WP Engine 간의 갈등으로 인해 WordPr...프로그램 작성 2024-11-06에 게시됨

드라마 탈출: HydePHP가 WordPress 대안인 이유워드프레스 드라마 WordPress 생태계가 전례 없는 혼란에 직면하면서 많은 개발자와 사이트 소유자가 플랫폼 선택을 재고하고 있습니다. 최근 WordPress 공동 창업자인 Matt Mullenweg와 WP Engine 간의 갈등으로 인해 WordPr...프로그램 작성 2024-11-06에 게시됨 -

Go의 동시성 패턴 작업자 풀 및 팬아웃/팬인Go는 탁월한 동시성 모델로 유명하지만 많은 개발자는 고루틴과 채널에만 집중합니다. 그러나 작업자 풀 및 팬아웃/팬인과 같은 동시성 패턴은 실질적인 효율성을 제공합니다. 이 문서에서는 Go 애플리케이션의 처리량을 극대화하는 데 도움이 되는 고급 개념을 살펴보겠습니다....프로그램 작성 2024-11-06에 게시됨

Go의 동시성 패턴 작업자 풀 및 팬아웃/팬인Go는 탁월한 동시성 모델로 유명하지만 많은 개발자는 고루틴과 채널에만 집중합니다. 그러나 작업자 풀 및 팬아웃/팬인과 같은 동시성 패턴은 실질적인 효율성을 제공합니다. 이 문서에서는 Go 애플리케이션의 처리량을 극대화하는 데 도움이 되는 고급 개념을 살펴보겠습니다....프로그램 작성 2024-11-06에 게시됨 -

C++에서 단일 문자를 std::string으로 변환하는 방법은 무엇입니까?단일 문자에서 문자열 생성char 데이터 유형으로 표현되는 단일 문자를 다음으로 변환해야 할 수도 있습니다. 표준::문자열. 문자열에서 문자를 얻는 것은 간단합니다. 원하는 위치에서 문자열을 색인화하기만 하면 됩니다. 그러나 반대 프로세스에는 다른 접근 방식이 필요합니...프로그램 작성 2024-11-06에 게시됨

C++에서 단일 문자를 std::string으로 변환하는 방법은 무엇입니까?단일 문자에서 문자열 생성char 데이터 유형으로 표현되는 단일 문자를 다음으로 변환해야 할 수도 있습니다. 표준::문자열. 문자열에서 문자를 얻는 것은 간단합니다. 원하는 위치에서 문자열을 색인화하기만 하면 됩니다. 그러나 반대 프로세스에는 다른 접근 방식이 필요합니...프로그램 작성 2024-11-06에 게시됨 -

JavaScript 변수 이름에서 달러 기호의 중요성은 무엇입니까?JavaScript 변수 이름에서 달러 기호의 중요성프로그래밍 영역에서 코드 향상을 위해서는 명명 규칙 사용이 필수적입니다. 가독성과 모범 사례 준수. JavaScript에서 달러 기호($)는 특히 jQuery 객체를 참조하는 변수 이름의 접두사로 나타나는 경우가 많습...프로그램 작성 2024-11-06에 게시됨

JavaScript 변수 이름에서 달러 기호의 중요성은 무엇입니까?JavaScript 변수 이름에서 달러 기호의 중요성프로그래밍 영역에서 코드 향상을 위해서는 명명 규칙 사용이 필수적입니다. 가독성과 모범 사례 준수. JavaScript에서 달러 기호($)는 특히 jQuery 객체를 참조하는 변수 이름의 접두사로 나타나는 경우가 많습...프로그램 작성 2024-11-06에 게시됨 -

모바일 응답성을 위해 CSS 그리드 레이아웃의 열을 어떻게 재정렬할 수 있나요?CSS 그리드 레이아웃에서 열 순서 변경CSS 그리드 레이아웃에는 원하는 열 순서를 수정하는 다양한 기술이 있습니다. 특정 레이아웃. 이 질문은 데스크톱 레이아웃에서 원하는 열 순서를 유지하면서 열을 아래쪽으로 이동하는 등 모바일 레이아웃의 열을 재배열할 수 있는 가능...프로그램 작성 2024-11-06에 게시됨

모바일 응답성을 위해 CSS 그리드 레이아웃의 열을 어떻게 재정렬할 수 있나요?CSS 그리드 레이아웃에서 열 순서 변경CSS 그리드 레이아웃에는 원하는 열 순서를 수정하는 다양한 기술이 있습니다. 특정 레이아웃. 이 질문은 데스크톱 레이아웃에서 원하는 열 순서를 유지하면서 열을 아래쪽으로 이동하는 등 모바일 레이아웃의 열을 재배열할 수 있는 가능...프로그램 작성 2024-11-06에 게시됨 -

Hacktoberfest Week 온라인 경매 시스템개요 Hacktoberfest 3주차에 저는 작지만 유망한 프로젝트인 온라인 경매 시스템에 기여하기로 결정했습니다. 프로젝트는 아직 초기 단계이지만 이미 성장 가능성을 보여주고 있으며 코드베이스를 개선하는 데 도움을 줄 수 있는 기회를 보았습니다. 내 ...프로그램 작성 2024-11-06에 게시됨

Hacktoberfest Week 온라인 경매 시스템개요 Hacktoberfest 3주차에 저는 작지만 유망한 프로젝트인 온라인 경매 시스템에 기여하기로 결정했습니다. 프로젝트는 아직 초기 단계이지만 이미 성장 가능성을 보여주고 있으며 코드베이스를 개선하는 데 도움을 줄 수 있는 기회를 보았습니다. 내 ...프로그램 작성 2024-11-06에 게시됨 -

`Exception_ptr`을 사용하여 C++의 스레드 간에 예외를 어떻게 전파합니까?C에서 스레드 간 예외 전파 C에서 스레드 간 예외 전파 작업은 메인 스레드에서 호출된 함수가 여러 스레드를 생성할 때 발생합니다. CPU 집약적인 작업을 위한 작업자 스레드. 문제는 작업자 스레드에서 발생할 수 있는 예외를 처리하고 적절한 처리를 위해 이를 다시 메인...프로그램 작성 2024-11-06에 게시됨

`Exception_ptr`을 사용하여 C++의 스레드 간에 예외를 어떻게 전파합니까?C에서 스레드 간 예외 전파 C에서 스레드 간 예외 전파 작업은 메인 스레드에서 호출된 함수가 여러 스레드를 생성할 때 발생합니다. CPU 집약적인 작업을 위한 작업자 스레드. 문제는 작업자 스레드에서 발생할 수 있는 예외를 처리하고 적절한 처리를 위해 이를 다시 메인...프로그램 작성 2024-11-06에 게시됨 -

3D CSS 변환을 사용하여 Firefox에서 들쭉날쭉한 가장자리를 수정하는 방법은 무엇입니까?3D CSS 변환을 사용하는 Firefox의 들쭉날쭉한 가장자리CSS 변환을 사용하는 Chrome의 들쭉날쭉한 가장자리 문제와 유사하게 Firefox는 3D 변환에서도 이 문제를 나타냅니다. Chrome의 잠재적인 솔루션인 후면 가시성은 Firefox에서는 효과적이지 ...프로그램 작성 2024-11-06에 게시됨

3D CSS 변환을 사용하여 Firefox에서 들쭉날쭉한 가장자리를 수정하는 방법은 무엇입니까?3D CSS 변환을 사용하는 Firefox의 들쭉날쭉한 가장자리CSS 변환을 사용하는 Chrome의 들쭉날쭉한 가장자리 문제와 유사하게 Firefox는 3D 변환에서도 이 문제를 나타냅니다. Chrome의 잠재적인 솔루션인 후면 가시성은 Firefox에서는 효과적이지 ...프로그램 작성 2024-11-06에 게시됨

중국어 공부

- 1 "걷다"를 중국어로 어떻게 말하나요? 走路 중국어 발음, 走路 중국어 학습

- 2 "비행기를 타다"를 중국어로 어떻게 말하나요? 坐飞机 중국어 발음, 坐飞机 중국어 학습

- 3 "기차를 타다"를 중국어로 어떻게 말하나요? 坐火车 중국어 발음, 坐火车 중국어 학습

- 4 "버스를 타다"를 중국어로 어떻게 말하나요? 坐车 중국어 발음, 坐车 중국어 학습

- 5 운전을 중국어로 어떻게 말하나요? 开车 중국어 발음, 开车 중국어 학습

- 6 수영을 중국어로 뭐라고 하나요? 游泳 중국어 발음, 游泳 중국어 학습

- 7 자전거를 타다 중국어로 뭐라고 하나요? 骑自行车 중국어 발음, 骑自行车 중국어 학습

- 8 중국어로 안녕하세요를 어떻게 말해요? 你好중국어 발음, 你好중국어 학습

- 9 감사합니다를 중국어로 어떻게 말하나요? 谢谢중국어 발음, 谢谢중국어 학습

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning