Page de garde > La programmation > Développer des algorithmes efficaces - Mesurer l'efficacité des algorithmes à l'aide de la notation Big O

Page de garde > La programmation > Développer des algorithmes efficaces - Mesurer l'efficacité des algorithmes à l'aide de la notation Big O

Développer des algorithmes efficaces - Mesurer l'efficacité des algorithmes à l'aide de la notation Big O

La conception d'algorithmes consiste à développer un processus mathématique pour résoudre un problème. L'analyse d'algorithme consiste à prédire les performances d'un algorithme. Les deux chapitres précédents ont présenté les structures de données classiques (listes, piles, files d'attente, files d'attente prioritaires, ensembles et cartes) et les ont appliquées pour résoudre des problèmes. Ce chapitre utilisera une variété d'exemples pour présenter des techniques algorithmiques courantes (programmation dynamique, diviser pour mieux régner et retour en arrière) permettant de développer des algorithmes efficaces.

La notation Big O obtient une fonction permettant de mesurer la complexité temporelle de l'algorithme en fonction de la taille d'entrée. Vous pouvez ignorer les constantes multiplicatives et les termes non dominants dans la fonction. Supposons que deux algorithmes effectuent la même tâche, telle qu'une recherche (recherche linéaire ou recherche binaire). Quel est le meilleur? Pour répondre à cette question, vous pouvez implémenter ces algorithmes et exécuter les programmes pour obtenir le temps d'exécution. Mais cette approche pose deux problèmes :

- Premièrement, de nombreuses tâches s'exécutent simultanément sur un ordinateur. Le temps d'exécution d'un programme particulier dépend de la charge du système.

- Deuxièmement, le temps d'exécution dépend d'une entrée spécifique. Prenons par exemple la recherche linéaire et la recherche binaire. Si un élément à rechercher se trouve être le premier de la liste, la recherche linéaire trouvera l'élément plus rapidement que la recherche binaire.

Il est très difficile de comparer des algorithmes en mesurant leur temps d’exécution. Pour surmonter ces problèmes, une approche théorique a été développée pour analyser les algorithmes indépendamment des ordinateurs et des entrées spécifiques. Cette approche se rapproche de l'effet d'un changement sur la taille de l'entrée. De cette façon, vous pouvez voir à quelle vitesse le temps d'exécution d'un algorithme augmente à mesure que la taille d'entrée augmente, vous pouvez donc comparer deux algorithmes en examinant leurs taux de croissance.

Envisagez la recherche linéaire. L'algorithme de recherche linéaire compare la clé avec les éléments du tableau de manière séquentielle jusqu'à ce que la clé soit trouvée ou que le tableau soit épuisé. Si la clé ne se trouve pas dans le tableau, elle nécessite des comparaisons n pour un tableau de taille n. Si la clé est dans le tableau, cela nécessite en moyenne n/2 comparaisons. Le temps d’exécution de l’algorithme est proportionnel à la taille du tableau. Si vous doublez la taille du tableau, vous vous attendez à ce que le nombre de comparaisons double. L'algorithme croît à un rythme linéaire. Le taux de croissance a un ordre de grandeur de n. Les informaticiens utilisent la notation Big O pour représenter « l’ordre de grandeur ». En utilisant cette notation, la complexité de l'algorithme de recherche linéaire est O(n), prononcé comme « ordre de n ». Nous appelons un algorithme avec une complexité temporelle de O(n) un algorithme linéaire, et il présente un taux de croissance linéaire.

Pour une même taille d’entrée, le temps d’exécution d’un algorithme peut varier en fonction de l’entrée. Une entrée qui entraîne le temps d'exécution le plus court est appelée entrée dans le meilleur des cas, et une entrée qui entraîne le temps d'exécution le plus long est appelée entrée dans le pire des cas. Analyse du meilleur cas et

L'analyse du pire des cas consiste à analyser les algorithmes pour leur entrée dans le meilleur des cas et leur entrée dans le pire des cas. L’analyse du meilleur et du pire des cas n’est pas représentative, mais l’analyse du pire des cas est très utile. Vous pouvez être assuré que l'algorithme ne sera jamais plus lent que dans le pire des cas.

Une analyse de cas moyen tente de déterminer la durée moyenne parmi toutes les entrées possibles de même taille. L'analyse de cas moyens est idéale, mais difficile à réaliser, car pour de nombreux problèmes, il est difficile de déterminer les probabilités et les distributions relatives des diverses instances d'entrée. L'analyse du pire des cas est plus facile à réaliser, c'est pourquoi l'analyse est généralement effectuée pour le pire des cas.

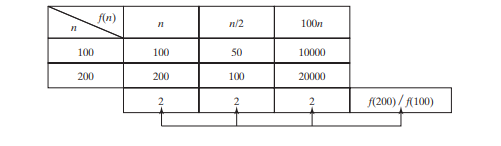

L'algorithme de recherche linéaire nécessite n comparaisons dans le pire des cas et n/2 comparaisons dans le cas moyen si vous recherchez presque toujours quelque chose dont vous savez qu'il figure dans la liste. En utilisant la notation Big O, les deux cas nécessitent un temps O(n). La constante multiplicative (1/2) peut être omise. L'analyse des algorithmes se concentre sur le taux de croissance. Les constantes multiplicatives n'ont aucun impact sur les taux de croissance. Le taux de croissance pour n/2 ou 100_n_ est le même que pour n, comme illustré dans le tableau ci-dessous, Taux de croissance. Par conséquent, O(n) = O(n/2) = O(100n).

Considérez l'algorithme permettant de trouver le nombre maximum dans un tableau de n éléments. Pour trouver le nombre maximum si n est 2, il faut une comparaison ; si n vaut 3, deux comparaisons. En général, il faut n - 1 comparaisons pour trouver le nombre maximum dans une liste de n éléments. L’analyse algorithmique est destinée aux entrées de grande taille. Si la taille d’entrée est petite, l’estimation de l’efficacité d’un algorithme n’a aucune importance. À mesure que n grandit, la partie n de l’expression n - 1 domine la complexité. La notation Big O vous permet d'ignorer la partie non dominante (par exemple, -1 dans le

expression n - 1) et mettez en surbrillance la partie importante (par exemple, n dans l'expression n - 1). Par conséquent, la complexité de cet algorithme est O(n).

La notation Big O estime le temps d'exécution d'un algorithme par rapport à la taille d'entrée. Si le temps n'est pas lié à la taille d'entrée, l'algorithme prend temps constant avec la notation O(1). Par exemple, une méthode qui récupère un élément à un index donné dans un tableau

prend un temps constant, car le temps n'augmente pas à mesure que la taille du tableau augmente.

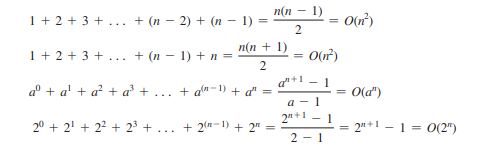

Les sommations mathématiques suivantes sont souvent utiles dans l'analyse d'algorithmes :

La complexité temporelle est une mesure du temps d'exécution utilisant la notation Big-O. De même, vous pouvez également mesurer la la complexité de l'espace à l'aide de la notation Big-O. La La complexité spatiale mesure la quantité d'espace mémoire utilisée par un algorithme. La complexité spatiale de la plupart des algorithmes présentés dans le livre est O(n). c'est-à-dire qu'ils présentent un taux de croissance linéaire par rapport à la taille de l'entrée. Par exemple, la complexité spatiale pour la recherche linéaire est O(n).

-

Comment vérifier si un objet a un attribut spécifique dans Python?Méthode pour déterminer l'existence de l'attribut d'objet Cette enquête cherche une méthode pour vérifier la présence d'un att...La programmation Publié le 2025-04-24

Comment vérifier si un objet a un attribut spécifique dans Python?Méthode pour déterminer l'existence de l'attribut d'objet Cette enquête cherche une méthode pour vérifier la présence d'un att...La programmation Publié le 2025-04-24 -

Comment Java's Map.Entry et SimpleEntry simplifient la gestion des paires de valeurs clés?Une collection complète pour les paires de valeur: introduisant la carte de Java.Entry et SimpleEntry dans Java, lors de la définition d'u...La programmation Publié le 2025-04-24

Comment Java's Map.Entry et SimpleEntry simplifient la gestion des paires de valeurs clés?Une collection complète pour les paires de valeur: introduisant la carte de Java.Entry et SimpleEntry dans Java, lors de la définition d'u...La programmation Publié le 2025-04-24 -

Méthode pour convertir correctement les caractères Latin1 en UTF8 dans UTF8 MySQL TableConvertir les caractères latins1 dans une table utf8 en utf8 Vous avez rencontré un problème où les caractères avec diacritique (par exemple, ...La programmation Publié le 2025-04-24

Méthode pour convertir correctement les caractères Latin1 en UTF8 dans UTF8 MySQL TableConvertir les caractères latins1 dans une table utf8 en utf8 Vous avez rencontré un problème où les caractères avec diacritique (par exemple, ...La programmation Publié le 2025-04-24 -

Pourquoi mon image d'arrière-plan CSS apparaît-elle?Troubleshoot: Image d'arrière-plan CSS n'apparaissant pas Vous avez rencontré un problème où votre image d'arrière-plan échoue mal...La programmation Publié le 2025-04-24

Pourquoi mon image d'arrière-plan CSS apparaît-elle?Troubleshoot: Image d'arrière-plan CSS n'apparaissant pas Vous avez rencontré un problème où votre image d'arrière-plan échoue mal...La programmation Publié le 2025-04-24 -

Guide de création de pages Fastapi Custom 404 PagePage personnalisée 404 non trouvé avec fastapi Pour créer une page 404 personnalisée, Fastapi propose plusieurs approches. La méthode appropri...La programmation Publié le 2025-04-24

Guide de création de pages Fastapi Custom 404 PagePage personnalisée 404 non trouvé avec fastapi Pour créer une page 404 personnalisée, Fastapi propose plusieurs approches. La méthode appropri...La programmation Publié le 2025-04-24 -

Comment résoudre \ "Refusé de charger le script ... \" Erreurs dues à la stratégie de sécurité du contenu d'Android?dévoiler le mystère: contenu des erreurs de directive de stratégie de sécurité rencontrant l'erreur énigmatique "refusé de charger le...La programmation Publié le 2025-04-24

Comment résoudre \ "Refusé de charger le script ... \" Erreurs dues à la stratégie de sécurité du contenu d'Android?dévoiler le mystère: contenu des erreurs de directive de stratégie de sécurité rencontrant l'erreur énigmatique "refusé de charger le...La programmation Publié le 2025-04-24 -

Comment convertir une colonne Pandas DataFrame au format DateTime et filtrer par date?Transformer la colonne Pandas DataFrame au format DateTime Scénario: Données dans un Pandas DataFrame existait souvent sous divers formats, ...La programmation Publié le 2025-04-24

Comment convertir une colonne Pandas DataFrame au format DateTime et filtrer par date?Transformer la colonne Pandas DataFrame au format DateTime Scénario: Données dans un Pandas DataFrame existait souvent sous divers formats, ...La programmation Publié le 2025-04-24 -

Comment puis-je générer efficacement des limaces adaptées à l'URL des chaînes Unicode en PHP?Créant une fonction pour la génération efficace des limaces Création de limaces, des représentations simplifiées des chaînes Unicode utilisées...La programmation Publié le 2025-04-24

Comment puis-je générer efficacement des limaces adaptées à l'URL des chaînes Unicode en PHP?Créant une fonction pour la génération efficace des limaces Création de limaces, des représentations simplifiées des chaînes Unicode utilisées...La programmation Publié le 2025-04-24 -

Comment rediriger plusieurs types d'utilisateurs (étudiants, enseignants et administrateurs) vers leurs activités respectives dans une application Firebase?Red: comment rediriger plusieurs types d'utilisateurs vers des activités respectives Comprendre le problème dans une application de vo...La programmation Publié le 2025-04-24

Comment rediriger plusieurs types d'utilisateurs (étudiants, enseignants et administrateurs) vers leurs activités respectives dans une application Firebase?Red: comment rediriger plusieurs types d'utilisateurs vers des activités respectives Comprendre le problème dans une application de vo...La programmation Publié le 2025-04-24 -

Comment puis-je créer efficacement des dictionnaires en utilisant la compréhension Python?Python Dictionary Comprehension Dans Python, les compréhensions du dictionnaire offrent un moyen concis de générer de nouveaux dictionnaires. Bi...La programmation Publié le 2025-04-24

Comment puis-je créer efficacement des dictionnaires en utilisant la compréhension Python?Python Dictionary Comprehension Dans Python, les compréhensions du dictionnaire offrent un moyen concis de générer de nouveaux dictionnaires. Bi...La programmation Publié le 2025-04-24 -

Comment résoudre l'utilisation \ "invalide de la fonction de groupe \" Erreur dans MySQL lors de la recherche de nombre maximum?Comment récupérer le nombre maximal en utilisant mysql dans MySQL, vous pouvez rencontrer un problème tout en essayant de trouver le nombre ma...La programmation Publié le 2025-04-24

Comment résoudre l'utilisation \ "invalide de la fonction de groupe \" Erreur dans MySQL lors de la recherche de nombre maximum?Comment récupérer le nombre maximal en utilisant mysql dans MySQL, vous pouvez rencontrer un problème tout en essayant de trouver le nombre ma...La programmation Publié le 2025-04-24 -

Comment les développeurs Java protègent-ils les informations d'identification de la base de données contre la décompilation?Protection des informations d'identification de la base de données de la décompilation dans java en java, les fichiers de classe décompilé...La programmation Publié le 2025-04-24

Comment les développeurs Java protègent-ils les informations d'identification de la base de données contre la décompilation?Protection des informations d'identification de la base de données de la décompilation dans java en java, les fichiers de classe décompilé...La programmation Publié le 2025-04-24 -

Comment gérer la saisie des utilisateurs dans le mode exclusif complet de Java?Gestion de la saisie de l'utilisateur en mode exclusif en plein écran en java introduction Lors de l'exécution d'une application...La programmation Publié le 2025-04-24

Comment gérer la saisie des utilisateurs dans le mode exclusif complet de Java?Gestion de la saisie de l'utilisateur en mode exclusif en plein écran en java introduction Lors de l'exécution d'une application...La programmation Publié le 2025-04-24 -

Comment puis-je maintenir le rendu de cellules JTable personnalisé après l'édition de cellules?En maintenant le rendu de cellules JTable après la modification de cellule dans un JTable, implémentant les capacités de rendu et d'éditio...La programmation Publié le 2025-04-24

Comment puis-je maintenir le rendu de cellules JTable personnalisé après l'édition de cellules?En maintenant le rendu de cellules JTable après la modification de cellule dans un JTable, implémentant les capacités de rendu et d'éditio...La programmation Publié le 2025-04-24 -

Quelle méthode est la plus efficace pour la détection ponctuelle en polygone: traçage des rayons ou path.contains_points de Matplotlib \?détection efficace de ponctuel en polygone dans python déterminer si un point se trouve dans un polygone est une tâche fréquente en géométrie de...La programmation Publié le 2025-04-24

Quelle méthode est la plus efficace pour la détection ponctuelle en polygone: traçage des rayons ou path.contains_points de Matplotlib \?détection efficace de ponctuel en polygone dans python déterminer si un point se trouve dans un polygone est une tâche fréquente en géométrie de...La programmation Publié le 2025-04-24

Étudier le chinois

- 1 Comment dit-on « marcher » en chinois ? 走路 Prononciation chinoise, 走路 Apprentissage du chinois

- 2 Comment dit-on « prendre l’avion » en chinois ? 坐飞机 Prononciation chinoise, 坐飞机 Apprentissage du chinois

- 3 Comment dit-on « prendre un train » en chinois ? 坐火车 Prononciation chinoise, 坐火车 Apprentissage du chinois

- 4 Comment dit-on « prendre un bus » en chinois ? 坐车 Prononciation chinoise, 坐车 Apprentissage du chinois

- 5 Comment dire conduire en chinois? 开车 Prononciation chinoise, 开车 Apprentissage du chinois

- 6 Comment dit-on nager en chinois ? 游泳 Prononciation chinoise, 游泳 Apprentissage du chinois

- 7 Comment dit-on faire du vélo en chinois ? 骑自行车 Prononciation chinoise, 骑自行车 Apprentissage du chinois

- 8 Comment dit-on bonjour en chinois ? 你好Prononciation chinoise, 你好Apprentissage du chinois

- 9 Comment dit-on merci en chinois ? 谢谢Prononciation chinoise, 谢谢Apprentissage du chinois

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning