Página delantera > Programación > Construyendo la nube de Ollama: escalando la inferencia local a la nube

Página delantera > Programación > Construyendo la nube de Ollama: escalando la inferencia local a la nube

Construyendo la nube de Ollama: escalando la inferencia local a la nube

Ollama es principalmente un contenedor de llama.cpp, diseñado para tareas de inferencia local. Por lo general, no es su primera opción si busca rendimiento o características de vanguardia, pero tiene sus usos, especialmente en entornos donde las dependencias externas son una preocupación.

Desarrollo local de IA

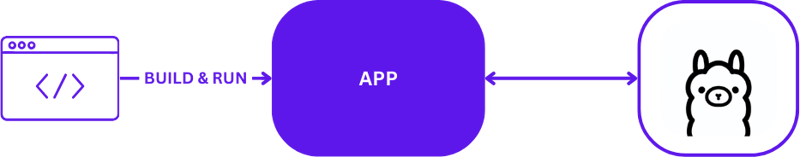

Cuando se utiliza Ollama para el desarrollo local de IA, la configuración es sencilla pero efectiva. Los desarrolladores suelen aprovechar Ollama para ejecutar tareas de inferencia directamente en sus máquinas locales. Aquí hay una representación visual de una configuración típica de desarrollo local usando Ollama:

Esta configuración permite a los desarrolladores probar e iterar rápidamente sin las complejidades de las comunicaciones del servidor remoto. Es ideal para las fases iniciales de creación de prototipos y desarrollo, donde la respuesta rápida es fundamental.

De lo local a la nube

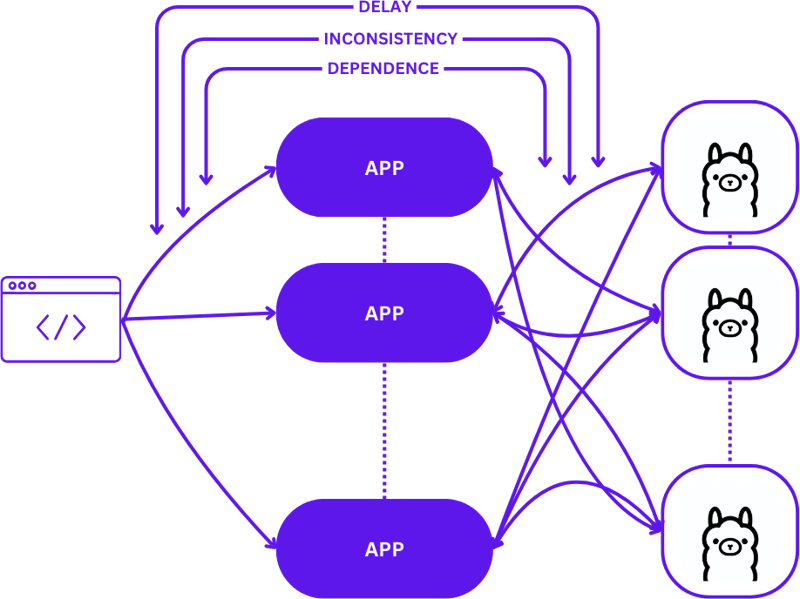

La transición de una configuración local a un entorno de nube escalable implica evolucionar desde una configuración simple 1:1 (una solicitud de usuario a un host de inferencia) a una configuración más compleja de muchos a muchos (múltiples solicitudes de usuario a múltiples hosts de inferencia) . Este cambio es necesario para mantener la eficiencia y la capacidad de respuesta a medida que aumenta la demanda.

Así es como se ve este escalamiento cuando se pasa del desarrollo local a la producción:

Adoptar un enfoque sencillo durante esta transición puede aumentar significativamente la complejidad de las aplicaciones, especialmente porque las sesiones deben mantener la coherencia en varios estados. Pueden surgir retrasos e ineficiencias si las solicitudes no se enrutan de manera óptima al mejor host de inferencia disponible.

Además, la naturaleza compleja de las aplicaciones distribuidas hace que sea difícil probarlas localmente, lo que puede ralentizar el proceso de desarrollo y aumentar el riesgo de fallos en los entornos de producción.

Sin servidor

La informática sin servidor abstrae los detalles de la infraestructura y la administración del servidor, lo que permite a los desarrolladores centrarse únicamente en el código y la lógica empresarial. Al desacoplar el manejo de solicitudes y el mantenimiento de la coherencia de la aplicación, la arquitectura sin servidor simplifica el escalamiento.

Este enfoque permite que la aplicación permanezca concentrada en ofrecer valor, resolviendo muchos desafíos de escalamiento comunes sin sobrecargar a los desarrolladores con complejidades de infraestructura.

Asamblea web

WebAssembly (Wasm) aborda el desafío de la gestión de dependencias al permitir la compilación de aplicaciones en módulos autónomos. Esto hace que las aplicaciones sean más fáciles de organizar y probar tanto localmente como en la nube, lo que garantiza la coherencia en diferentes entornos.

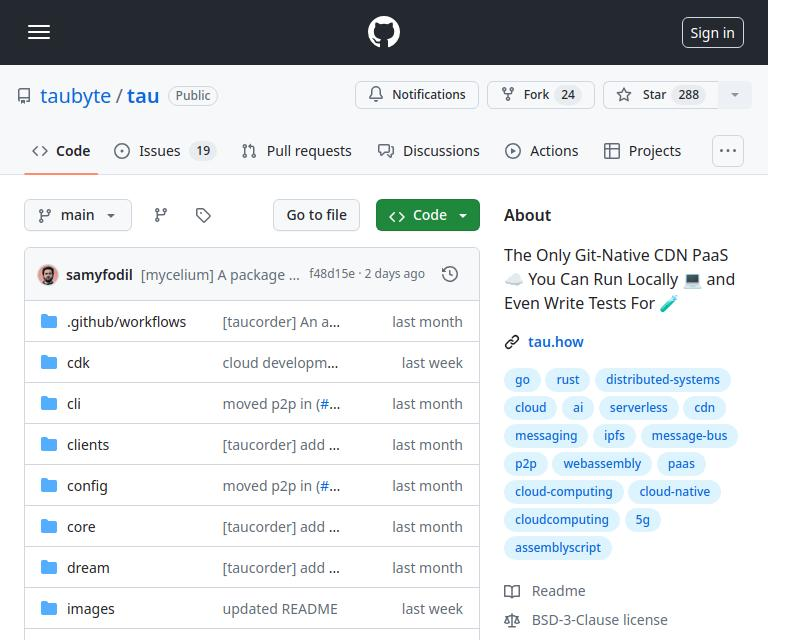

tau

Tau es un marco para construir plataformas de computación en la nube altamente escalables y de bajo mantenimiento. Destaca por su simplicidad y extensibilidad. Tau simplifica la implementación y admite la ejecución de una nube local para el desarrollo, lo que permite realizar pruebas de extremo a extremo (E2E) tanto de la infraestructura de la nube como de las aplicaciones que se ejecutan en ella.

Este enfoque, al que Taubyte se refiere como "Codificación local equivale a producción global", garantiza que lo que funciona localmente funcionará globalmente, lo que facilita significativamente los procesos de desarrollo e implementación.

Integrando Ollama en Tau con el sistema de complemento Orbit

El sistema de complementos de Tau, conocido como Orbit, simplifica significativamente convertir servicios en componentes manejables envolviéndolos en módulos host de WebAssembly. Este enfoque permite a Tau asumir las tareas de orquestación, agilizando el proceso de implementación y gestión.

Exportación de Funciones en Ollama

Para que las funciones de Ollama sean accesibles dentro del ecosistema de Tau, utilizamos el sistema Orbit para exportar las capacidades de Ollama como puntos finales invocables. Así es como puedes exportar un punto final en Go:

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

Para ver un ejemplo sencillo de funciones de exportación, puedes consultar el ejemplo de hello_world.

Una vez definidas, estas funciones, ahora llamadas vía satélite.Exportar, permiten la perfecta integración de Ollama en el entorno de Tau:

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

Pruebas de escritura para el complemento Ollama

Probar el complemento es sencillo y ágil. Así es como puedes escribir una prueba de función sin servidor en Go:

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

Utilizando el conjunto de pruebas de Tau y las herramientas de creación de Go, puedes crear tu complemento, implementarlo en un entorno de prueba y ejecutar las funciones sin servidor para verificar la funcionalidad:

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

Código

Puedes encontrar el código completo aquí https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/tau

¿Que sigue?

Ahora puede crear aplicaciones LLM con facilidad. Estos son los pasos para comenzar:

- Comience a usar dream localmente: configure su entorno local para desarrollar y probar su aplicación.

- Crea un proyecto: comienza un nuevo proyecto con Tau para aprovechar todo su potencial.

- Crea tu nube de producción: implementa tu proyecto en un entorno de nube de producción.

- Suelte el binario del complemento en la carpeta /tb/plugins.

- Importa tu proyecto a producción

- ¡Presumir!

-

¿Cómo verificar si un objeto tiene un atributo específico en Python?para determinar el atributo de objeto existencia Esta consulta busca un método para verificar la presencia de un atributo específico dentro de...Programación Publicado el 2025-03-01

¿Cómo verificar si un objeto tiene un atributo específico en Python?para determinar el atributo de objeto existencia Esta consulta busca un método para verificar la presencia de un atributo específico dentro de...Programación Publicado el 2025-03-01 -

¿Cómo resolver las discrepancias de la ruta del módulo en el mod utilizando la Directiva Reemplazar?Superación del módulo Discrepancia en el mod Al utilizar el mod, es posible encontrar un conflicto en el que un paquete de terceros importe ot...Programación Publicado el 2025-03-01

¿Cómo resolver las discrepancias de la ruta del módulo en el mod utilizando la Directiva Reemplazar?Superación del módulo Discrepancia en el mod Al utilizar el mod, es posible encontrar un conflicto en el que un paquete de terceros importe ot...Programación Publicado el 2025-03-01 -

¿Cómo insertar correctamente las blobs (imágenes) en MySQL usando PHP?Inserte blobs en bases de datos MySQL con php Al intentar almacenar una imagen en una base de datos MySQL, puede encontrar un asunto. Esta gu...Programación Publicado el 2025-03-01

¿Cómo insertar correctamente las blobs (imágenes) en MySQL usando PHP?Inserte blobs en bases de datos MySQL con php Al intentar almacenar una imagen en una base de datos MySQL, puede encontrar un asunto. Esta gu...Programación Publicado el 2025-03-01 -

Fit de objeto: la cubierta falla en IE y Edge, ¿cómo solucionar?Object-Fit: la portada falla en IE y Edge, ¿cómo solucionar? utilizando objeto-fit: cover; en CSS para mantener la altura de imagen consistent...Programación Publicado el 2025-03-01

Fit de objeto: la cubierta falla en IE y Edge, ¿cómo solucionar?Object-Fit: la portada falla en IE y Edge, ¿cómo solucionar? utilizando objeto-fit: cover; en CSS para mantener la altura de imagen consistent...Programación Publicado el 2025-03-01 -

¿Por qué Microsoft Visual C ++ no implementa correctamente la instanciación de la plantilla de dos fases?El misterio de la plantilla de dos fases "roto" instanciación en Microsoft Visual c declaración de problemas: usuarios comúnmente ...Programación Publicado el 2025-03-01

¿Por qué Microsoft Visual C ++ no implementa correctamente la instanciación de la plantilla de dos fases?El misterio de la plantilla de dos fases "roto" instanciación en Microsoft Visual c declaración de problemas: usuarios comúnmente ...Programación Publicado el 2025-03-01 -

¿Qué método es más eficiente para la detección de Point-in-Polygon: Ray Tracing o Matplotlib \ 's Rath.Contains_Points?Detección eficiente de Point-in-Polygon en python determinando si un punto se encuentra dentro de un polígono es una tarea frecuente en la geome...Programación Publicado el 2025-03-01

¿Qué método es más eficiente para la detección de Point-in-Polygon: Ray Tracing o Matplotlib \ 's Rath.Contains_Points?Detección eficiente de Point-in-Polygon en python determinando si un punto se encuentra dentro de un polígono es una tarea frecuente en la geome...Programación Publicado el 2025-03-01 -

FormaciónLos métodos son fns que se pueden llamar a los objetos Las matrices son objetos, por lo tanto, también tienen métodos en js. Slice (Begi...Programación Publicado el 2025-03-01

FormaciónLos métodos son fns que se pueden llamar a los objetos Las matrices son objetos, por lo tanto, también tienen métodos en js. Slice (Begi...Programación Publicado el 2025-03-01 -

¿Por qué cesan la ejecución de JavaScript cuando se usa el botón de retroceso de Firefox?Problema de historial de navegación: JavaScript deja de ejecutar después de usar el botón de retroceso de Firefox Los usuarios de Firefox pued...Programación Publicado el 2025-03-01

¿Por qué cesan la ejecución de JavaScript cuando se usa el botón de retroceso de Firefox?Problema de historial de navegación: JavaScript deja de ejecutar después de usar el botón de retroceso de Firefox Los usuarios de Firefox pued...Programación Publicado el 2025-03-01 -

¿Por qué no es una solicitud posterior a capturar la entrada en PHP a pesar del código válido?abordando la solicitud de solicitud de la publicación $ _Server ['php_self'];?> "Método =" post "> [&] la intenci...Programación Publicado el 2025-03-01

¿Por qué no es una solicitud posterior a capturar la entrada en PHP a pesar del código válido?abordando la solicitud de solicitud de la publicación $ _Server ['php_self'];?> "Método =" post "> [&] la intenci...Programación Publicado el 2025-03-01 -

¿Puedo migrar mi cifrado de MCRYPT a OpenSSL y descifrar datos cifrados de MCRYPT usando OpenSSL?actualizando mi biblioteca de cifrado de MCRYP En OpenSSL, ¿es posible descifrar datos encriptados con MCRYPT? Dos publicaciones diferentes propo...Programación Publicado el 2025-03-01

¿Puedo migrar mi cifrado de MCRYPT a OpenSSL y descifrar datos cifrados de MCRYPT usando OpenSSL?actualizando mi biblioteca de cifrado de MCRYP En OpenSSL, ¿es posible descifrar datos encriptados con MCRYPT? Dos publicaciones diferentes propo...Programación Publicado el 2025-03-01 -

¿Se pueden apilar múltiples elementos adhesivos uno encima del otro en CSS puro?¿Es posible tener múltiples elementos pegajosos apilados uno encima del otro en CSS puro? El comportamiento deseado se puede ver Aquí: https...Programación Publicado el 2025-03-01

¿Se pueden apilar múltiples elementos adhesivos uno encima del otro en CSS puro?¿Es posible tener múltiples elementos pegajosos apilados uno encima del otro en CSS puro? El comportamiento deseado se puede ver Aquí: https...Programación Publicado el 2025-03-01 -

¿Cómo recuperar la última biblioteca jQuery de Google API?recuperando la última biblioteca jQuery de Google APIS La URL de jQuery proporcionada en la pregunta es para la versión 1.2.6. Para recuperar ...Programación Publicado el 2025-03-01

¿Cómo recuperar la última biblioteca jQuery de Google API?recuperando la última biblioteca jQuery de Google APIS La URL de jQuery proporcionada en la pregunta es para la versión 1.2.6. Para recuperar ...Programación Publicado el 2025-03-01 -

¿Cuáles fueron las restricciones al usar Current_Timestamp con columnas de marca de tiempo en MySQL antes de la versión 5.6.5?en las columnas de la marca de tiempo con cursion_timestamp en predeterminado o en las cláusulas de actualización en las versiones mySql antes de ...Programación Publicado el 2025-03-01

¿Cuáles fueron las restricciones al usar Current_Timestamp con columnas de marca de tiempo en MySQL antes de la versión 5.6.5?en las columnas de la marca de tiempo con cursion_timestamp en predeterminado o en las cláusulas de actualización en las versiones mySql antes de ...Programación Publicado el 2025-03-01 -

¿Por qué no aparece mi imagen de fondo CSS?Solución de problemas: css La imagen de fondo que no aparece ha encontrado un problema en el que su imagen de fondo no se carga a pesar de las...Programación Publicado el 2025-03-01

¿Por qué no aparece mi imagen de fondo CSS?Solución de problemas: css La imagen de fondo que no aparece ha encontrado un problema en el que su imagen de fondo no se carga a pesar de las...Programación Publicado el 2025-03-01 -

¿Cómo puedo unir tablas de bases de datos con diferentes números de columnas?tablas combinadas con diferentes columnas ]] puede encontrar desafíos al intentar fusionar las tablas de la base de datos con diferentes column...Programación Publicado el 2025-03-01

¿Cómo puedo unir tablas de bases de datos con diferentes números de columnas?tablas combinadas con diferentes columnas ]] puede encontrar desafíos al intentar fusionar las tablas de la base de datos con diferentes column...Programación Publicado el 2025-03-01

Estudiar chino

- 1 ¿Cómo se dice "caminar" en chino? 走路 pronunciación china, 走路 aprendizaje chino

- 2 ¿Cómo se dice "tomar un avión" en chino? 坐飞机 pronunciación china, 坐飞机 aprendizaje chino

- 3 ¿Cómo se dice "tomar un tren" en chino? 坐火车 pronunciación china, 坐火车 aprendizaje chino

- 4 ¿Cómo se dice "tomar un autobús" en chino? 坐车 pronunciación china, 坐车 aprendizaje chino

- 5 ¿Cómo se dice conducir en chino? 开车 pronunciación china, 开车 aprendizaje chino

- 6 ¿Cómo se dice nadar en chino? 游泳 pronunciación china, 游泳 aprendizaje chino

- 7 ¿Cómo se dice andar en bicicleta en chino? 骑自行车 pronunciación china, 骑自行车 aprendizaje chino

- 8 ¿Cómo se dice hola en chino? 你好Pronunciación china, 你好Aprendizaje chino

- 9 ¿Cómo se dice gracias en chino? 谢谢Pronunciación china, 谢谢Aprendizaje chino

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning