Titelseite > Programmierung > Golang: Wie Beobachtbarkeit und Profilerstellung eine nahezu nicht nachweisbare Drosselung aufdeckten

Titelseite > Programmierung > Golang: Wie Beobachtbarkeit und Profilerstellung eine nahezu nicht nachweisbare Drosselung aufdeckten

Golang: Wie Beobachtbarkeit und Profilerstellung eine nahezu nicht nachweisbare Drosselung aufdeckten

In einem persönlichen Projekt mit Go, das Informationen über finanzielle Vermögenswerte von Bovespa erhält.

Das System nutzt intensiv die Parallelität und Parallelität mit Goroutinen und aktualisiert alle 8 Sekunden Asset-Informationen (zusammen mit Geschäftsberechnungen).

Anfangs erschienen keine Fehler oder Warnungen, aber ich bemerkte, dass die Ausführung einiger Goroutinen länger dauerte als andere.

Um genauer zu sein: Während die p99-Zeit bei 0,03 ms lag, stieg sie an einigen Stellen auf 0,9 ms. Dies veranlasste mich, das Problem weiter zu untersuchen.

Ich habe festgestellt, dass ich einen Semaphor-Goroutine-Pool verwende, der auf der Grundlage der Variablen GOMAXPROCS erstellt wurde.

Mir wurde jedoch klar, dass es bei diesem Ansatz ein Problem gab.

Wenn wir die Variable GOMAXPROCS verwenden, erfasst sie die Anzahl der im Container verfügbaren Kerne nicht korrekt. Wenn der Container weniger verfügbare Kerne hat als die Gesamtzahl der VM, wird die Gesamtzahl der VM berücksichtigt. Beispielsweise verfügt meine VM über 8 verfügbare Kerne, der Container jedoch nur über 4. Dies führte dazu, dass 8 Goroutinen zur gleichzeitigen Ausführung erstellt wurden, was zu einer Drosselung führte.

Nach langer Recherche über Nacht habe ich eine von Uber entwickelte Bibliothek gefunden, die die Variable GOMAXPROCS automatisch effizienter anpasst, unabhängig davon, ob sie sich in einem Container befindet oder nicht. Diese Lösung erwies sich als äußerst stabil und effizient: automaxprocs

Über-gehen

/

automaxprocs

Über-gehen

/

automaxprocs

Stellen Sie GOMAXPROCS automatisch so ein, dass es dem CPU-Kontingent des Linux-Containers entspricht.

automaxprocs

GOMAXPROCS automatisch so einstellen, dass es dem CPU-Kontingent des Linux-Containers entspricht.

Installation

go get -u go.uber.org/automaxprocs

Schnellstart

import _ "go.uber.org/automaxprocs"

func main() {

// Your application logic here.

}

Leistung

Daten, die vom internen Load Balancer von Uber gemessen wurden. Wir haben den Load Balancer mit 200 % CPU-Quote (d. h. 2 Kernen) ausgeführt:

| GOMAXPROCS | RPS | P50 (ms) | P99,9 (ms) |

|---|---|---|---|

| 1 | 28.893,18 | 1,46 | 19,70 |

| 2 (entspricht dem Kontingent) | 44.715,07 | 0,84 | 26,38 |

| 3 | 44.212,93 | 0,66 | 30.07 |

| 4 | 41.071,15 | 0,57 | 42,94 |

| 8 | 33.111,69 | 0,43 | 64,32 |

| Standard (24) | 22.191,40 | 0,45 | 76,19 |

Wenn GOMAXPROCS über das CPU-Kontingent hinaus erhöht wird, sehen wir, dass P50 leicht abnimmt, aber deutliche Steigerungen auf P99 zu verzeichnen sind. Wir sehen auch, dass auch die gesamten verarbeiteten RPS sinken.

Wenn GOMAXPROCS höher ist als das zugewiesene CPU-Kontingent, haben wir auch eine erhebliche Drosselung festgestellt:

$ cat /sys/fs/cgroup/cpu,cpuacct/system.slice/[...]/cpu.stat nr_periods 42227334 nr_throttled 131923 throttled_time 88613212216618

Sobald GOMAXPROCS auf das CPU-Kontingent reduziert wurde, sahen wir keine CPU-Drosselung.

Nach der Implementierung der Verwendung dieser Bibliothek wurde das Problem behoben und die p99-Zeit blieb nun konstant bei 0,02 ms. Diese Erfahrung verdeutlichte die Bedeutung von Beobachtbarkeit und Profilierung in gleichzeitigen Systemen.

Das Folgende ist ein sehr einfaches Beispiel, das jedoch den Unterschied in der Leistung zeigt.

Mit dem nativen Test- und Benckmak-Paket von Go habe ich zwei Dateien erstellt:

benchmarking_with_enhancement_test.go:

package main

import (

_ "go.uber.org/automaxprocs"

"runtime"

"sync"

"testing"

)

// BenchmarkWithEnhancement Função com melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

benchmarking_without_enhancement_test.go:

package main

import (

"runtime"

"sync"

"testing"

)

// BenchmarkWithoutEnhancement Função sem a melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithoutEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

Der Unterschied zwischen ihnen besteht darin, dass man den Uber-Bibliotheksimport verwendet.

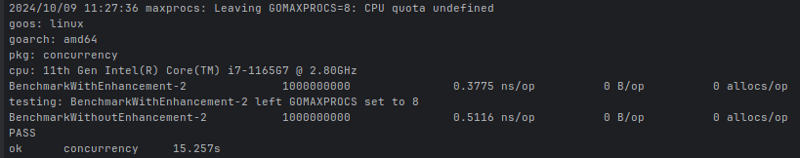

Beim Ausführen des Benchmarks unter der Annahme, dass 2 CPUs verwendet würden, war das Ergebnis:

ns/op: Gibt einen Durchschnitt in Nanosekunden an, wie lange es dauert, einen bestimmten Vorgang auszuführen.

Beachten Sie, dass die insgesamt verfügbare CPU meiner CPU 8 Kerne beträgt, und das ist es, was die runtime.NumCPU()-Eigenschaft zurückgegeben hat. Wie beim Ausführen des Benchmarks habe ich jedoch definiert, dass nur zwei CPUs verwendet werden würden, und die Datei, die Automaxprocs nicht verwendet, hat definiert, dass die Ausführungsbeschränkung gleichzeitig 8 Goroutinen betragen würde, während die effizienteste 2 wäre, weil Auf diese Weise wird die Ausführung durch die Verwendung einer geringeren Zuweisung effizienter.

Die Bedeutung der Beobachtbarkeit und Profilerstellung unserer Anwendungen ist also klar.

-

Wie kann man die Funktionsbeschränkungen von PHP 'Funktionen überwinden?Überwindung von PHP-Funktionsfunktionen Einschränkungen In PHP sind eine Funktion mit demselben Namen mehrmals ein No-no. Der Versuch, dies zu...Programmierung Gepostet am 2025-03-12

Wie kann man die Funktionsbeschränkungen von PHP 'Funktionen überwinden?Überwindung von PHP-Funktionsfunktionen Einschränkungen In PHP sind eine Funktion mit demselben Namen mehrmals ein No-no. Der Versuch, dies zu...Programmierung Gepostet am 2025-03-12 -

Wie füge ich Blobs (Bilder) mithilfe von PHP richtig in MySQL ein?Fügen Sie Blobs in mySQL -Datenbanken mit php beim Versuch, ein Bild in einer MySQL -Datenbank zu speichern, auf eine auf ein Bild zu speiche...Programmierung Gepostet am 2025-03-12

Wie füge ich Blobs (Bilder) mithilfe von PHP richtig in MySQL ein?Fügen Sie Blobs in mySQL -Datenbanken mit php beim Versuch, ein Bild in einer MySQL -Datenbank zu speichern, auf eine auf ein Bild zu speiche...Programmierung Gepostet am 2025-03-12 -

Wie begrenzt ich den Scroll-Bereich eines Elements in einem dynamisch großen übergeordneten Element?implementieren CSS -Höhenlimits für vertikale Scrolling -Elemente in einer interaktiven Schnittstelle und kontrollieren des Bildlaufverhaltens...Programmierung Gepostet am 2025-03-12

Wie begrenzt ich den Scroll-Bereich eines Elements in einem dynamisch großen übergeordneten Element?implementieren CSS -Höhenlimits für vertikale Scrolling -Elemente in einer interaktiven Schnittstelle und kontrollieren des Bildlaufverhaltens...Programmierung Gepostet am 2025-03-12 -

Wie sortiere ich ein 2D -Doppelarray nach der ersten Spalte in Java?sortieren 2D -Arrays mit Javas Arrays.sort () arrays.sort () ist eine vielseitige Sortierfunktion in Java, die für verschiedene Datentypen ver...Programmierung Gepostet am 2025-03-12

Wie sortiere ich ein 2D -Doppelarray nach der ersten Spalte in Java?sortieren 2D -Arrays mit Javas Arrays.sort () arrays.sort () ist eine vielseitige Sortierfunktion in Java, die für verschiedene Datentypen ver...Programmierung Gepostet am 2025-03-12 -

Warum zeigt keine Firefox -Bilder mithilfe der CSS `Content` -Eigenschaft an?Bilder mit Inhalts -URL in Firefox Es wurde ein Problem aufgenommen, an dem bestimmte Browser, speziell Firefox, nicht die Bilder mit der Inha...Programmierung Gepostet am 2025-03-12

Warum zeigt keine Firefox -Bilder mithilfe der CSS `Content` -Eigenschaft an?Bilder mit Inhalts -URL in Firefox Es wurde ein Problem aufgenommen, an dem bestimmte Browser, speziell Firefox, nicht die Bilder mit der Inha...Programmierung Gepostet am 2025-03-12 -

Gibt es einen Leistungsunterschied zwischen der Verwendung einer For-Each-Schleife und einem Iterator für die Sammlung durchquert in Java?für jede Schleife vs. Iterator: Effizienz in der Sammlung traversal Einführung beim Durchlaufen einer Sammlung in Java, die Auswahl an der...Programmierung Gepostet am 2025-03-12

Gibt es einen Leistungsunterschied zwischen der Verwendung einer For-Each-Schleife und einem Iterator für die Sammlung durchquert in Java?für jede Schleife vs. Iterator: Effizienz in der Sammlung traversal Einführung beim Durchlaufen einer Sammlung in Java, die Auswahl an der...Programmierung Gepostet am 2025-03-12 -

\ "während (1) gegen (;;): Beseitigt die Compiler -Optimierung Leistungsunterschiede? \"wob führt die Verwendung von (1) statt für (;;) zu einem Leistungsunterschied in Infinite führt Loops? Antwort: In den meisten modernen C...Programmierung Gepostet am 2025-03-12

\ "während (1) gegen (;;): Beseitigt die Compiler -Optimierung Leistungsunterschiede? \"wob führt die Verwendung von (1) statt für (;;) zu einem Leistungsunterschied in Infinite führt Loops? Antwort: In den meisten modernen C...Programmierung Gepostet am 2025-03-12 -

Warum fördern C und C ++ während arithmetischer Operationen "Short" zu "int"?Warum kurze für arithmetische Operationen in C und C? c und c erforderlich sein müssen, um kurz in die Int zu konvertieren, bevor man arithmet...Programmierung Gepostet am 2025-03-12

Warum fördern C und C ++ während arithmetischer Operationen "Short" zu "int"?Warum kurze für arithmetische Operationen in C und C? c und c erforderlich sein müssen, um kurz in die Int zu konvertieren, bevor man arithmet...Programmierung Gepostet am 2025-03-12 -

Python Read CSV -Datei UnicodEdeCodeError Ultimate Lösungunicode dekodieren Fehler in der CSV-Datei Reading Wenn versucht wird, eine CSV-Datei mit dem integrierten CSV-Modul zu lesen, können Sie eine...Programmierung Gepostet am 2025-03-12

Python Read CSV -Datei UnicodEdeCodeError Ultimate Lösungunicode dekodieren Fehler in der CSV-Datei Reading Wenn versucht wird, eine CSV-Datei mit dem integrierten CSV-Modul zu lesen, können Sie eine...Programmierung Gepostet am 2025-03-12 -

Was waren die Einschränkungen bei der Verwendung von Current_Timestamp mit Zeitstempelspalten in MySQL vor Version 5.6.5?Einschränkungen für Zeitstempelspalten mit Current_Timestamp in Standard- oder Aktualisierungsklauseln in MySQL -Versionen vor 5.6.5 Historisch ...Programmierung Gepostet am 2025-03-12

Was waren die Einschränkungen bei der Verwendung von Current_Timestamp mit Zeitstempelspalten in MySQL vor Version 5.6.5?Einschränkungen für Zeitstempelspalten mit Current_Timestamp in Standard- oder Aktualisierungsklauseln in MySQL -Versionen vor 5.6.5 Historisch ...Programmierung Gepostet am 2025-03-12 -

Warum wird die Anfrage nicht nach dem Erfassen von Eingaben in PHP trotz gültiger Code erfasst?adressieren nach Anfrage Fehlfunktion in php in dem vorgestellten Code -Snippet: action='' Die Intented -In -Intented -Aufnahme. Die Ausg...Programmierung Gepostet am 2025-03-12

Warum wird die Anfrage nicht nach dem Erfassen von Eingaben in PHP trotz gültiger Code erfasst?adressieren nach Anfrage Fehlfunktion in php in dem vorgestellten Code -Snippet: action='' Die Intented -In -Intented -Aufnahme. Die Ausg...Programmierung Gepostet am 2025-03-12 -

Kann ich meine Verschlüsselung von McRypt nach OpenSSL migrieren und mit OpenSSL von McRypt-verkürzten Daten entschlüsseln?Upgrade meiner Verschlüsselungsbibliothek von McRypt auf OpenSSL Kann ich meine Verschlüsselungsbibliothek von McRypt nach OpenSsl aufrüsten? ...Programmierung Gepostet am 2025-03-12

Kann ich meine Verschlüsselung von McRypt nach OpenSSL migrieren und mit OpenSSL von McRypt-verkürzten Daten entschlüsseln?Upgrade meiner Verschlüsselungsbibliothek von McRypt auf OpenSSL Kann ich meine Verschlüsselungsbibliothek von McRypt nach OpenSsl aufrüsten? ...Programmierung Gepostet am 2025-03-12 -

Wie kann man Ergebnisse mit Laravel eloquent paginieren?Paginationsergebnisse verwenden Laravel Eloquent Laravels eloquent ORM liefert eine bequeme Methode zum Abfragen und Abzügen von Daten aus Ihr...Programmierung Gepostet am 2025-03-12

Wie kann man Ergebnisse mit Laravel eloquent paginieren?Paginationsergebnisse verwenden Laravel Eloquent Laravels eloquent ORM liefert eine bequeme Methode zum Abfragen und Abzügen von Daten aus Ihr...Programmierung Gepostet am 2025-03-12 -

Warum hört die Ausführung von JavaScript ein, wenn die Firefox -Rückbutton verwendet wird?Navigational History Problem: JavaScript hört auf, nach der Verwendung von Firefox -Back -Schaltflächen auszuführen. Dieses Problem tritt in ande...Programmierung Gepostet am 2025-03-12

Warum hört die Ausführung von JavaScript ein, wenn die Firefox -Rückbutton verwendet wird?Navigational History Problem: JavaScript hört auf, nach der Verwendung von Firefox -Back -Schaltflächen auszuführen. Dieses Problem tritt in ande...Programmierung Gepostet am 2025-03-12 -

ArrayMethoden sind fns, die auf Objekte aufgerufen werden können Arrays sind Objekte, daher haben sie auch Methoden in js. Slice (Beginn): Ex...Programmierung Gepostet am 2025-03-12

ArrayMethoden sind fns, die auf Objekte aufgerufen werden können Arrays sind Objekte, daher haben sie auch Methoden in js. Slice (Beginn): Ex...Programmierung Gepostet am 2025-03-12

Chinesisch lernen

- 1 Wie sagt man „gehen“ auf Chinesisch? 走路 Chinesische Aussprache, 走路 Chinesisch lernen

- 2 Wie sagt man auf Chinesisch „Flugzeug nehmen“? 坐飞机 Chinesische Aussprache, 坐飞机 Chinesisch lernen

- 3 Wie sagt man auf Chinesisch „einen Zug nehmen“? 坐火车 Chinesische Aussprache, 坐火车 Chinesisch lernen

- 4 Wie sagt man auf Chinesisch „Bus nehmen“? 坐车 Chinesische Aussprache, 坐车 Chinesisch lernen

- 5 Wie sagt man „Fahren“ auf Chinesisch? 开车 Chinesische Aussprache, 开车 Chinesisch lernen

- 6 Wie sagt man Schwimmen auf Chinesisch? 游泳 Chinesische Aussprache, 游泳 Chinesisch lernen

- 7 Wie sagt man auf Chinesisch „Fahrrad fahren“? 骑自行车 Chinesische Aussprache, 骑自行车 Chinesisch lernen

- 8 Wie sagt man auf Chinesisch Hallo? 你好Chinesische Aussprache, 你好Chinesisch lernen

- 9 Wie sagt man „Danke“ auf Chinesisch? 谢谢Chinesische Aussprache, 谢谢Chinesisch lernen

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning