Encore.ts – schneller als ElysiaJS und Hono

Vor ein paar Monaten haben wir Encore.ts veröffentlicht – ein Open-Source-Backend-Framework für TypeScript.

Da es bereits viele Frameworks gibt, wollten wir einige der ungewöhnlichen Designentscheidungen, die wir getroffen haben, und wie sie zu bemerkenswerten Leistungszahlen führen, mitteilen.

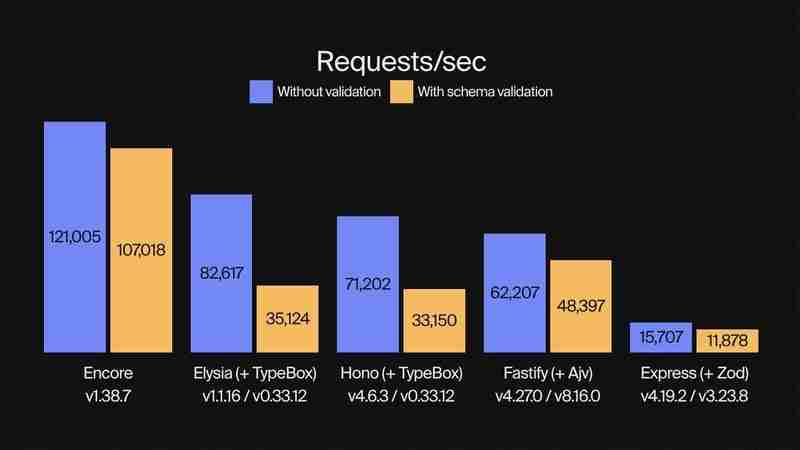

Leistungsbenchmarks

Wir haben bereits Benchmarks veröffentlicht, die zeigen, dass Encore.ts 9x schneller als Express und 2x schneller als Fastify ist.

Dieses Mal haben wir Encore.ts mit ElysiaJS und Hono verglichen, zwei modernen Hochleistungs-TypeScript-Frameworks.

Wir haben jedes Framework sowohl mit als auch ohne Schemavalidierung einem Benchmarking unterzogen und dabei TypeBox für die Validierung mit ElsyiaJS und Hono verwendet, da es sich um eine nativ unterstützte Validierungsbibliothek für diese Frameworks handelt. (Encore.ts verfügt über eine eigene integrierte Typvalidierung, die durchgängig funktioniert.)

Für jeden Benchmark haben wir das beste Ergebnis aus fünf Durchläufen erzielt. Jeder Lauf wurde durchgeführt, indem so viele Anfragen wie möglich mit 150 gleichzeitigen Arbeitern über einen Zeitraum von mehr als 10 Sekunden gestellt wurden. Die Lastgenerierung wurde mit oha durchgeführt, einem auf Rust und Tokio basierenden HTTP-Lasttest-Tool.

Genug geredet, schauen wir uns die Zahlen an!

Anfragen pro Sekunde: Encore.ts ist bei Verwendung der Typvalidierung dreimal schneller als ElysiaJS und Hono

(Schauen Sie sich den Benchmark-Code auf GitHub an.)

Abgesehen von der Leistung erreicht Encore.ts dies unter Beibehaltung der 100-prozentigen Kompatibilität mit Node.js.

So funktioniert es: Ausreißer-Entwurfsentscheidungen

Wie ist das möglich? Bei unseren Tests haben wir drei Hauptleistungsquellen identifiziert, die alle damit zusammenhängen, wie Encore.ts unter der Haube funktioniert.

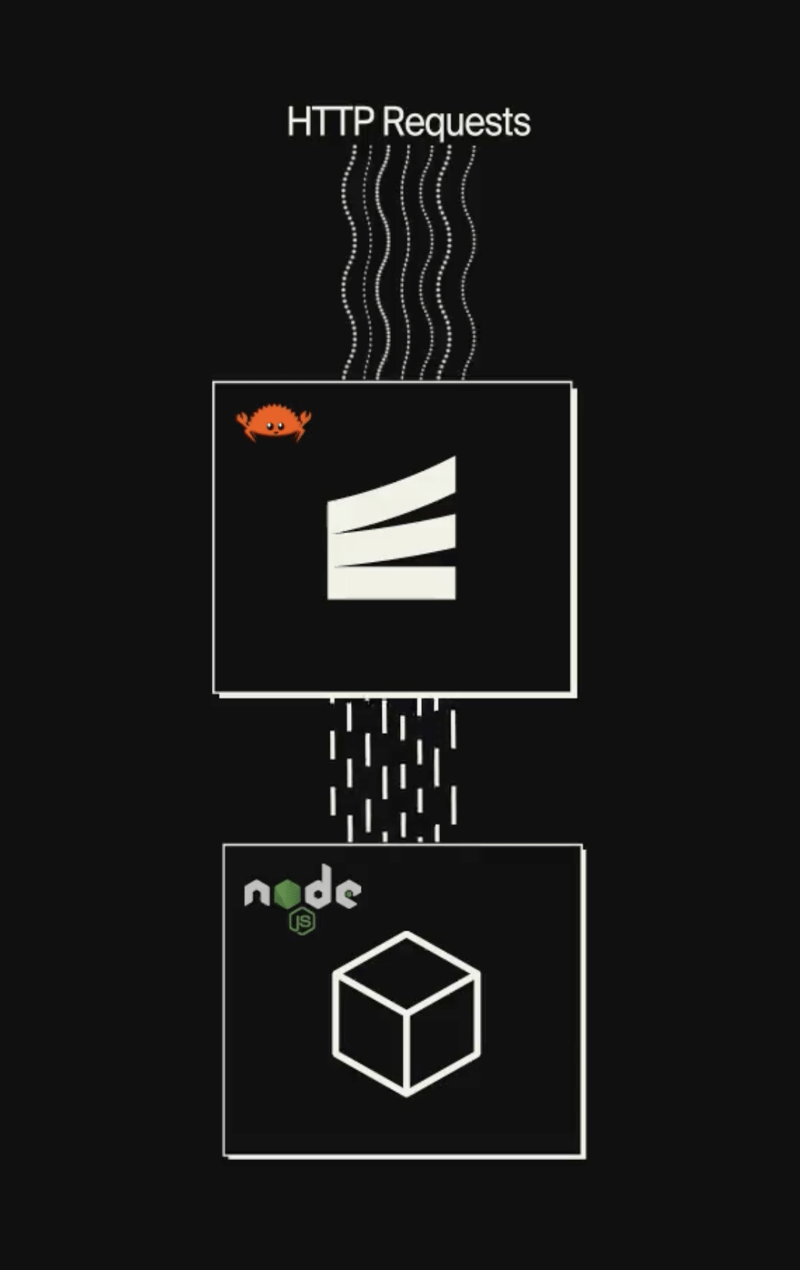

1. Encore.ts ist multithreaded und wird von einer Rust-Laufzeitumgebung unterstützt

Node.js führt JavaScript-Code mithilfe einer Single-Threaded-Ereignisschleife aus. Trotz seiner Single-Thread-Natur ist dies in der Praxis recht skalierbar, da es nicht blockierende I/O-Operationen verwendet und die zugrunde liegende V8-JavaScript-Engine (die auch Chrome antreibt) extrem optimiert ist.

Aber wissen Sie, was schneller ist als eine Single-Thread-Ereignisschleife? Eine mit mehreren Threads.

Encore.ts besteht aus zwei Teilen:

Ein TypeScript SDK, das Sie beim Schreiben von Backends mit Encore.ts verwenden.

Eine Hochleistungslaufzeit mit einer asynchronen Multithread-Ereignisschleife, geschrieben in Rust (unter Verwendung von Tokio und Hyper).

Die Encore-Runtime verarbeitet alle E/A-Vorgänge wie das Akzeptieren und Verarbeiten eingehender HTTP-Anfragen. Dies läuft als völlig unabhängige Ereignisschleife, die so viele Threads nutzt, wie die zugrunde liegende Hardware unterstützt.

Sobald die Anfrage vollständig verarbeitet und dekodiert wurde, wird sie an die Node.js-Ereignisschleife übergeben und nimmt dann die Antwort vom API-Handler entgegen und schreibt sie zurück an den Client.

(Bevor Sie es sagen: Ja, wir fügen eine Ereignisschleife in Ihre Ereignisschleife ein, sodass Sie eine Ereignisschleife ausführen können, während Sie eine Ereignisschleife ausführen.)

2. Encore.ts berechnet Anforderungsschemata vorab

Encore.ts wurde, wie der Name schon sagt, von Grund auf für TypeScript entwickelt. Sie können TypeScript jedoch nicht wirklich ausführen: Es muss zunächst in JavaScript kompiliert werden, indem alle Typinformationen entfernt werden. Dies bedeutet, dass die Typsicherheit zur Laufzeit viel schwieriger zu erreichen ist, was beispielsweise die Validierung eingehender Anforderungen erschwert, was dazu führt, dass Lösungen wie Zod stattdessen für die Definition von API-Schemas zur Laufzeit beliebt werden.

Encore.ts funktioniert anders. Mit Encore definieren Sie typsichere APIs mithilfe nativer TypeScript-Typen:

import { api } from "encore.dev/api";

interface BlogPost {

id: number;

title: string;

body: string;

likes: number;

}

export const getBlogPost = api(

{ method: "GET", path: "/blog/:id", expose: true },

async ({ id }: { id: number }) => Promise {

// ...

},

);

Encore.ts analysiert dann den Quellcode, um das Anforderungs- und Antwortschema zu verstehen, das jeder API-Endpunkt erwartet, einschließlich Dinge wie HTTP-Header, Abfrageparameter usw. Die Schemata werden dann verarbeitet, optimiert und als Protobuf-Datei gespeichert.

Wenn die Encore-Runtime gestartet wird, liest sie diese Protobuf-Datei und berechnet vorab einen Anforderungsdecoder und einen Antwortencoder, die für jeden API-Endpunkt optimiert sind, und zwar unter Verwendung der genauen Typdefinition, die jeder API-Endpunkt erwartet. Tatsächlich übernimmt Encore.ts sogar die Anforderungsvalidierung direkt in Rust und stellt so sicher, dass ungültige Anforderungen niemals die JS-Ebene berühren müssen, wodurch viele Denial-of-Service-Angriffe abgemildert werden.

Encores Verständnis des Anforderungsschemas erweist sich auch aus Leistungssicht als vorteilhaft. JavaScript-Laufzeiten wie Deno und Bun verwenden eine ähnliche Architektur wie die auf Rust basierende Laufzeit von Encore (tatsächlich verwendet Deno auch Rust Tokio Hyper), ihnen fehlt jedoch das Verständnis von Encore für das Anforderungsschema. Daher müssen sie die unverarbeiteten HTTP-Anfragen zur Ausführung an die Single-Threaded-JavaScript-Engine übergeben.

Encore.ts hingegen übernimmt einen viel größeren Teil der Anforderungsverarbeitung innerhalb von Rust und übergibt nur die dekodierten Anforderungsobjekte. Durch die Abwicklung eines größeren Teils des Anforderungslebenszyklus in Multithread-Rust wird die JavaScript-Ereignisschleife entlastet und kann sich auf die Ausführung der Anwendungsgeschäftslogik statt auf das Parsen von HTTP-Anforderungen konzentrieren, was zu einer noch größeren Leistungssteigerung führt.

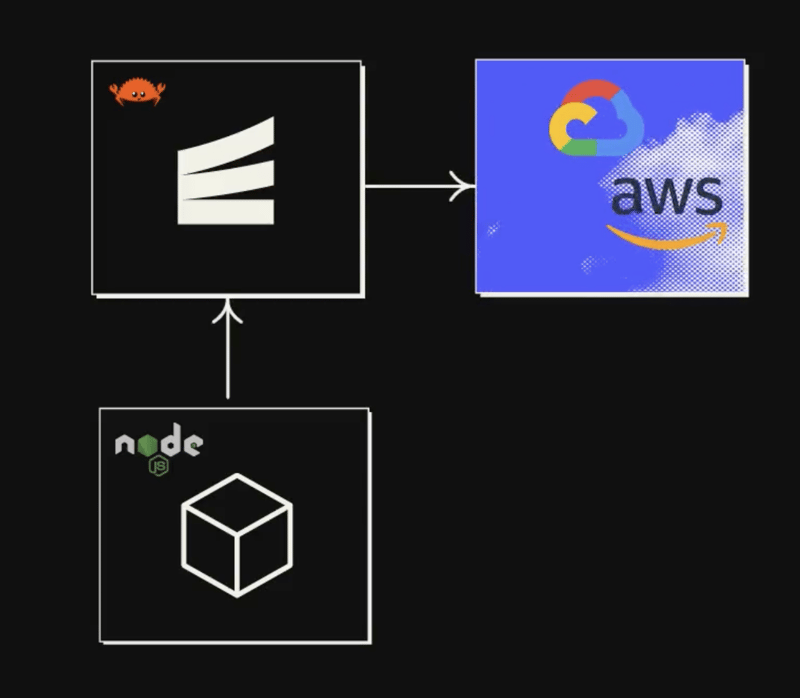

3. Encore.ts lässt sich in die Infrastruktur integrieren

Aufmerksamen Lesern ist vielleicht ein Trend aufgefallen: Der Schlüssel zur Leistung liegt darin, so viel Arbeit wie möglich aus der Single-Threaded-JavaScript-Ereignisschleife zu entlasten.

Wir haben uns bereits angeschaut, wie Encore.ts den Großteil des Anforderungs-/Antwortlebenszyklus an Rust verlagert. Was gibt es also noch zu tun?

Nun, Backend-Anwendungen sind wie Sandwiches. Sie haben die oberste Schicht, in der Sie eingehende Anfragen bearbeiten. Im Mittelpunkt stehen Ihre leckeren Toppings (also natürlich Ihre Geschäftslogik). Unten befindet sich Ihre knusprige Datenzugriffsebene, in der Sie Datenbanken abfragen, andere API-Endpunkte aufrufen und so weiter.

An der Geschäftslogik können wir nicht viel machen – das wollen wir schließlich in TypeScript schreiben! – aber es macht wenig Sinn, wenn alle Datenzugriffsvorgänge unsere JS-Ereignisschleife belasten. Wenn wir diese nach Rust verschieben würden, würden wir die Ereignisschleife weiter entlasten, um uns auf die Ausführung unseres Anwendungscodes konzentrieren zu können.

Das haben wir also getan.

Mit Encore.ts können Sie Infrastrukturressourcen direkt in Ihrem Quellcode deklarieren.

Um beispielsweise ein Pub/Sub-Thema zu definieren:

import { Topic } from "encore.dev/pubsub";

interface UserSignupEvent {

userID: string;

email: string;

}

export const UserSignups = new Topic("user-signups", {

deliveryGuarantee: "at-least-once",

});

// To publish:

await UserSignups.publish({ userID: "123", email: "[email protected]" });

"Welche Pub/Sub-Technologie wird also verwendet?"

— Alle!

Die Encore Rust-Laufzeitumgebung umfasst Implementierungen für die gängigsten Pub/Sub-Technologien, einschließlich AWS SQS SNS, GCP Pub/Sub und NSQ, wobei weitere geplant sind (Kafka, NATS, Azure Service Bus usw.). Sie können die Implementierung auf Ressourcenbasis in der Laufzeitkonfiguration beim Hochfahren der Anwendung angeben oder die Cloud-DevOps-Automatisierung von Encore dies für Sie erledigen lassen.

Über Pub/Sub hinaus umfasst Encore.ts Infrastrukturintegrationen für PostgreSQL-Datenbanken, Secrets, Cron-Jobs und mehr.

Alle diese Infrastrukturintegrationen werden in der Encore.ts Rust Runtime implementiert.

Das bedeutet, dass, sobald Sie .publish() aufrufen, die Nutzlast an Rust übergeben wird, der dafür sorgt, dass die Nachricht veröffentlicht wird, es bei Bedarf erneut versucht und so weiter. Das Gleiche gilt für Datenbankabfragen, das Abonnieren von Pub/Sub-Nachrichten und mehr.

Das Endergebnis ist, dass mit Encore.ts praktisch die gesamte Nicht-Geschäftslogik aus der JS-Ereignisschleife entlastet wird.

Im Wesentlichen erhalten Sie mit Encore.ts ein echtes Multithread-Backend „kostenlos“, während Sie dennoch in der Lage sind, Ihre gesamte Geschäftslogik in TypeScript zu schreiben.

Abschluss

Ob diese Leistung wichtig ist oder nicht, hängt von Ihrem Anwendungsfall ab. Wenn Sie ein kleines Hobbyprojekt erstellen, ist es weitgehend akademisch. Aber wenn Sie ein Produktions-Backend in die Cloud verlagern, kann das ziemlich große Auswirkungen haben.

Eine geringere Latenz hat einen direkten Einfluss auf die Benutzererfahrung. Um das Offensichtliche auszudrücken: Ein schnelleres Backend bedeutet ein schnelleres Frontend und damit zufriedenere Benutzer.

Höherer Durchsatz bedeutet, dass Sie die gleiche Anzahl von Benutzern mit weniger Servern bedienen können, was direkt zu niedrigeren Cloud-Rechnungen führt. Oder Sie können umgekehrt mehr Benutzer mit der gleichen Anzahl von Servern bedienen und so eine weitere Skalierung ohne Leistungsengpässe sicherstellen.

Obwohl wir voreingenommen sind, glauben wir, dass Encore eine ziemlich hervorragende und beste Lösung für die Erstellung leistungsstarker Backends in TypeScript bietet. Es ist schnell, typsicher und mit dem gesamten Node.js-Ökosystem kompatibel.

Und es ist alles Open Source, sodass Sie sich den Code ansehen und auf GitHub beitragen können.

Oder probieren Sie es einfach aus und teilen Sie uns Ihre Meinung mit!

-

Teilen Sie Datenframe -Proben einfach mit `df.to_dict ()` Methode freiwie man df.to_dict () zum Teilen von Beispieldatenrahmen einfach teile Wenn es darum geht, Fragen im Zusammenhang mit der Datenanalyse in Bezu...Programmierung Gepostet am 2025-04-15

Teilen Sie Datenframe -Proben einfach mit `df.to_dict ()` Methode freiwie man df.to_dict () zum Teilen von Beispieldatenrahmen einfach teile Wenn es darum geht, Fragen im Zusammenhang mit der Datenanalyse in Bezu...Programmierung Gepostet am 2025-04-15 -

Wie kann ich mit Decimal.Parse () Zahlen in exponentieller Notation analysieren?analysieren eine Nummer aus exponentieller Notation beim Versuch, eine in exponentielle Notation ausgedrückte String mit Decimal.parse zu anal...Programmierung Gepostet am 2025-04-15

Wie kann ich mit Decimal.Parse () Zahlen in exponentieller Notation analysieren?analysieren eine Nummer aus exponentieller Notation beim Versuch, eine in exponentielle Notation ausgedrückte String mit Decimal.parse zu anal...Programmierung Gepostet am 2025-04-15 -

Behandeln Sie Unicode- und Codierungsprobleme in Python und MySQLunicode und codieren in Python und mysql Bei der Behandlung mit Unicode -Daten, die Sie mit einem, das Sie ergaben, erfordern, haben Sie eine ...Programmierung Gepostet am 2025-04-15

Behandeln Sie Unicode- und Codierungsprobleme in Python und MySQLunicode und codieren in Python und mysql Bei der Behandlung mit Unicode -Daten, die Sie mit einem, das Sie ergaben, erfordern, haben Sie eine ...Programmierung Gepostet am 2025-04-15 -

Wie wiederhole ich Stringzeichen für die Einklingel in C#effizient?Wenn Sie nur das gleiche Zeichen wiederholen möchten, können Sie den String -Konstruktor verwenden, der ein Zeichen akzeptiert, und die Anzahl ...Programmierung Gepostet am 2025-04-15

Wie wiederhole ich Stringzeichen für die Einklingel in C#effizient?Wenn Sie nur das gleiche Zeichen wiederholen möchten, können Sie den String -Konstruktor verwenden, der ein Zeichen akzeptiert, und die Anzahl ...Programmierung Gepostet am 2025-04-15 -

Trigger versteckte JQuery -DateieingangselementmethodeAuslösen von Dateieingaben mit jQuery beim Versuch, ein Upload -Feld mit JQuery mit dem Trigger ('Click') auszulösen; Methode, Benutze...Programmierung Gepostet am 2025-04-15

Trigger versteckte JQuery -DateieingangselementmethodeAuslösen von Dateieingaben mit jQuery beim Versuch, ein Upload -Feld mit JQuery mit dem Trigger ('Click') auszulösen; Methode, Benutze...Programmierung Gepostet am 2025-04-15 -

Lösen Sie den \\ "String -Wert -Fehler \\" -Ausnahme, wenn MySQL Emoji einfügtdie falsche String -Wert -Ausnahme beheben, wenn er Emoji beim Versuch, eine Zeichenfolge mit Emoji -Zeichen in eine mysql -Datenbank einzufügen...Programmierung Gepostet am 2025-04-15

Lösen Sie den \\ "String -Wert -Fehler \\" -Ausnahme, wenn MySQL Emoji einfügtdie falsche String -Wert -Ausnahme beheben, wenn er Emoji beim Versuch, eine Zeichenfolge mit Emoji -Zeichen in eine mysql -Datenbank einzufügen...Programmierung Gepostet am 2025-04-15 -

SQL Server: Wählen Sie eine Funktion oder eine gespeicherte Prozedur?SQL Server -Funktionen und gespeicherte Prozeduren: Auswahlhandbuch In SQL Server hängt die Auswahl einer Funktion oder einer gespeicherten Pr...Programmierung Gepostet am 2025-04-15

SQL Server: Wählen Sie eine Funktion oder eine gespeicherte Prozedur?SQL Server -Funktionen und gespeicherte Prozeduren: Auswahlhandbuch In SQL Server hängt die Auswahl einer Funktion oder einer gespeicherten Pr...Programmierung Gepostet am 2025-04-15 -

Warum führt PHPs DateTime :: Modify ('+1 Monat') unerwartete Ergebnisse zu?Monate mit PHP DATETIME: Aufdeckung des beabsichtigten Verhaltens Wenn Sie mit der DateTime -Klasse von PHP die erwarteten Ergebnisse hinzufüg...Programmierung Gepostet am 2025-04-15

Warum führt PHPs DateTime :: Modify ('+1 Monat') unerwartete Ergebnisse zu?Monate mit PHP DATETIME: Aufdeckung des beabsichtigten Verhaltens Wenn Sie mit der DateTime -Klasse von PHP die erwarteten Ergebnisse hinzufüg...Programmierung Gepostet am 2025-04-15 -

Kann STD :: SHARED_PTR die Sicherheit des Objekt -Threads sicherstellen?Thread Sicherheitsüberlegungen mit std :: shared_ptr Das std :: Shared_ptr ist ein leistungsstarker Smart-Zeiger, der in multi-thread-Umgebung...Programmierung Gepostet am 2025-04-15

Kann STD :: SHARED_PTR die Sicherheit des Objekt -Threads sicherstellen?Thread Sicherheitsüberlegungen mit std :: shared_ptr Das std :: Shared_ptr ist ein leistungsstarker Smart-Zeiger, der in multi-thread-Umgebung...Programmierung Gepostet am 2025-04-15 -

Finden Sie qualitativ hochwertige Webdesign -InspirationIch habe vielleicht nur die Liste für Sie, Kumpel (wenn Sie weiter interessiert sind, habe ich mehr als 50 Websites zusammengestellt, die ich als W...Programmierung Gepostet am 2025-04-15

Finden Sie qualitativ hochwertige Webdesign -InspirationIch habe vielleicht nur die Liste für Sie, Kumpel (wenn Sie weiter interessiert sind, habe ich mehr als 50 Websites zusammengestellt, die ich als W...Programmierung Gepostet am 2025-04-15 -

Wie kann ich Variablen in C#sicher in dynamische Typen konvertieren?eine Variable in einen dynamischen Typ eine Variable des Typs des Typs an einen Variablen von Typ t, wobei t in einer Typvariable definiert is...Programmierung Gepostet am 2025-04-15

Wie kann ich Variablen in C#sicher in dynamische Typen konvertieren?eine Variable in einen dynamischen Typ eine Variable des Typs des Typs an einen Variablen von Typ t, wobei t in einer Typvariable definiert is...Programmierung Gepostet am 2025-04-15 -

Wie kann ich die Befehlszeilenparameter in Winforms effizient behandeln?Handle -Befehlszeilenparameter in WinForms Application WinForms -Anwendungen müssen häufig die Befehlszeilenparameter zwischen verschiedenen A...Programmierung Gepostet am 2025-04-15

Wie kann ich die Befehlszeilenparameter in Winforms effizient behandeln?Handle -Befehlszeilenparameter in WinForms Application WinForms -Anwendungen müssen häufig die Befehlszeilenparameter zwischen verschiedenen A...Programmierung Gepostet am 2025-04-15 -

Wie erfasst und streamen Sie Stdout in Echtzeit für die Ausführung von Chatbot -Befehl?Das Problem liegt im traditionellen Ansatz, der alle Stdout sammelt und es als einzige Antwort zurückgibt. Um dies zu überwinden, brauchen wir e...Programmierung Gepostet am 2025-04-15

Wie erfasst und streamen Sie Stdout in Echtzeit für die Ausführung von Chatbot -Befehl?Das Problem liegt im traditionellen Ansatz, der alle Stdout sammelt und es als einzige Antwort zurückgibt. Um dies zu überwinden, brauchen wir e...Programmierung Gepostet am 2025-04-15 -

Wie kann ich die letzte Zeile für jede eindeutige Kennung in PostgreSQL effizient abrufen?postgresql: Extrahieren der letzten Zeile für jede eindeutige Kennung In Postgresql können Sie Situationen begegnen, in denen Sie die Informat...Programmierung Gepostet am 2025-04-15

Wie kann ich die letzte Zeile für jede eindeutige Kennung in PostgreSQL effizient abrufen?postgresql: Extrahieren der letzten Zeile für jede eindeutige Kennung In Postgresql können Sie Situationen begegnen, in denen Sie die Informat...Programmierung Gepostet am 2025-04-15 -

10 JQuery, Mootools, Prototype Leichte Pop-up-SkripteDieser Beitrag zeigt eine Sammlung von Lightbox -Skripten und Plugins, die mit verschiedenen JavaScript -Bibliotheken erstellt wurden, einschließlich...Programmierung Gepostet am 2025-04-15

10 JQuery, Mootools, Prototype Leichte Pop-up-SkripteDieser Beitrag zeigt eine Sammlung von Lightbox -Skripten und Plugins, die mit verschiedenen JavaScript -Bibliotheken erstellt wurden, einschließlich...Programmierung Gepostet am 2025-04-15

Chinesisch lernen

- 1 Wie sagt man „gehen“ auf Chinesisch? 走路 Chinesische Aussprache, 走路 Chinesisch lernen

- 2 Wie sagt man auf Chinesisch „Flugzeug nehmen“? 坐飞机 Chinesische Aussprache, 坐飞机 Chinesisch lernen

- 3 Wie sagt man auf Chinesisch „einen Zug nehmen“? 坐火车 Chinesische Aussprache, 坐火车 Chinesisch lernen

- 4 Wie sagt man auf Chinesisch „Bus nehmen“? 坐车 Chinesische Aussprache, 坐车 Chinesisch lernen

- 5 Wie sagt man „Fahren“ auf Chinesisch? 开车 Chinesische Aussprache, 开车 Chinesisch lernen

- 6 Wie sagt man Schwimmen auf Chinesisch? 游泳 Chinesische Aussprache, 游泳 Chinesisch lernen

- 7 Wie sagt man auf Chinesisch „Fahrrad fahren“? 骑自行车 Chinesische Aussprache, 骑自行车 Chinesisch lernen

- 8 Wie sagt man auf Chinesisch Hallo? 你好Chinesische Aussprache, 你好Chinesisch lernen

- 9 Wie sagt man „Danke“ auf Chinesisch? 谢谢Chinesische Aussprache, 谢谢Chinesisch lernen

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning