لماذا تعطلت جلسة Google Colab الخاصة بي أثناء تشغيل نموذج Llama؟

أحاول استخدام نموذج meta-llama/Llama-2-7b-hf وتشغيله محليًا في مقر عملي ولكن الجلسة تعطلت أثناء العملية.

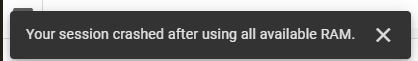

أحاول استخدام نموذج meta-llama/Llama-2-7b-hf وتشغيله محليًا في مقر عملي. للقيام بذلك، أستخدم Google Colab وحصلت على مفتاح الوصول من Hugging Face. أنا أستخدم مكتبة المحولات الخاصة بهم للمهام الضرورية. في البداية، استخدمت مكدس وقت تشغيل GPU T4 على Google Colab، والذي يوفر 12.7 جيجابايت من ذاكرة الوصول العشوائي للنظام، و15.0 جيجابايت من ذاكرة الوصول العشوائي GPU، و78.2 جيجابايت من مساحة القرص. على الرغم من هذه الموارد، تعطلت جلستي، وواجهت الخطأ التالي:

بعد ذلك، قمت بالتبديل إلى حزمة وقت التشغيل TPU V2، والتي توفر 334.6 جيجابايت من ذاكرة الوصول العشوائي للنظام و225.3 جيجابايت من مساحة القرص، ولكن المشكلة استمرت.

هذا هو الكود الخاص بي:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

-

كيفية التحقق مما إذا كانت السلسلة تحتوي على أي من السلاسل الفرعية من صفيف في JavaScript؟البحث عن سلاسل فرعية في سلسلة باستخدام مصفوفات جافا سكريبت لتحديد ما إذا كانت السلسلة تحتوي على أي من السلاسل الفرعية من مصفوفة، توفر جافا سكر...برمجة تم النشر بتاريخ 2024-11-06

كيفية التحقق مما إذا كانت السلسلة تحتوي على أي من السلاسل الفرعية من صفيف في JavaScript؟البحث عن سلاسل فرعية في سلسلة باستخدام مصفوفات جافا سكريبت لتحديد ما إذا كانت السلسلة تحتوي على أي من السلاسل الفرعية من مصفوفة، توفر جافا سكر...برمجة تم النشر بتاريخ 2024-11-06 -

Laravel Livewire: ما هو وكيفية استخدامه في تطبيق الويب الخاص بكيعد Livewire واحدًا من أهم المشاريع في نظام Laravel البيئي الذي يستهدف بشكل خاص تطوير الواجهة الأمامية. لقد تم إصدار Livewire v3 مؤخرًا، لذا دعونا نس...برمجة تم النشر بتاريخ 2024-11-06

Laravel Livewire: ما هو وكيفية استخدامه في تطبيق الويب الخاص بكيعد Livewire واحدًا من أهم المشاريع في نظام Laravel البيئي الذي يستهدف بشكل خاص تطوير الواجهة الأمامية. لقد تم إصدار Livewire v3 مؤخرًا، لذا دعونا نس...برمجة تم النشر بتاريخ 2024-11-06 -

هل يمكن تنفيذ استدعاءات الطريقة من خلال مؤشرات فارغة في C++ دون أن تتعطّل؟سلوك غير متوقع لأساليب الاتصال من خلال مؤشرات فارغة في لغة C في مقتطف التعليمات البرمجية المقدم، يتم استدعاء الطريقة من خلال مؤشر فارغ، ولكن م...برمجة تم النشر بتاريخ 2024-11-06

هل يمكن تنفيذ استدعاءات الطريقة من خلال مؤشرات فارغة في C++ دون أن تتعطّل؟سلوك غير متوقع لأساليب الاتصال من خلال مؤشرات فارغة في لغة C في مقتطف التعليمات البرمجية المقدم، يتم استدعاء الطريقة من خلال مؤشر فارغ، ولكن م...برمجة تم النشر بتاريخ 2024-11-06 -

كيفية طرح القوائم في بايثون؟قوائم الطرح: حساب الفرق يمكن أن تحتوي القوائم في بايثون على عناصر مختلفة. لإجراء عمليات حسابية على القوائم، مثل الطرح، نستخدم أساليب أو تقنيات...برمجة تم النشر بتاريخ 2024-11-06

كيفية طرح القوائم في بايثون؟قوائم الطرح: حساب الفرق يمكن أن تحتوي القوائم في بايثون على عناصر مختلفة. لإجراء عمليات حسابية على القوائم، مثل الطرح، نستخدم أساليب أو تقنيات...برمجة تم النشر بتاريخ 2024-11-06 -

كيفية التحقق مما إذا كان المولد فارغًا في بايثون؟اكتشاف تهيئة المولد الفارغة في بايثون، المولدات عبارة عن تكرارات تنتج قيمًا واحدة تلو الأخرى. على هذا النحو، فإن تحديد ما إذا كان المولد فارغً...برمجة تم النشر بتاريخ 2024-11-06

كيفية التحقق مما إذا كان المولد فارغًا في بايثون؟اكتشاف تهيئة المولد الفارغة في بايثون، المولدات عبارة عن تكرارات تنتج قيمًا واحدة تلو الأخرى. على هذا النحو، فإن تحديد ما إذا كان المولد فارغً...برمجة تم النشر بتاريخ 2024-11-06 -

## هل تريد استدعاء Java من Python بكفاءة؟ استكشف Py4J كبديل لـ JPype!استدعاء Java من Python: Py4J كبديل لـ JPype استدعاء Java من Python له العديد من الحلول المحتملة. أحد الخيارات، JPype، قد يكون من الصعب تجميعه ...برمجة تم النشر بتاريخ 2024-11-06

## هل تريد استدعاء Java من Python بكفاءة؟ استكشف Py4J كبديل لـ JPype!استدعاء Java من Python: Py4J كبديل لـ JPype استدعاء Java من Python له العديد من الحلول المحتملة. أحد الخيارات، JPype، قد يكون من الصعب تجميعه ...برمجة تم النشر بتاريخ 2024-11-06 -

سوول صغير ديسيبليقدم Small Swoole Db 2.3 الصلات اليسرى: $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector-&...برمجة تم النشر بتاريخ 2024-11-06

سوول صغير ديسيبليقدم Small Swoole Db 2.3 الصلات اليسرى: $selector = (new TableSelector('user')) ->leftJoin('post', 'messageOwner', 'message') ; $selector-&...برمجة تم النشر بتاريخ 2024-11-06 -

كيف يمكن تحسين وظيفة __mm_add_epi32_inplace_purego باستخدام تعليمات التجميع للحصول على أداء أفضل في عمليات عد السكان الموضعية؟تحسين __mm_add_epi32_inplace_purego باستخدام التجميع يسعى هذا السؤال إلى تحسين الحلقة الداخلية لوظيفة __mm_add_epi32_inplace_purego، التي تقوم بإج...برمجة تم النشر بتاريخ 2024-11-06

كيف يمكن تحسين وظيفة __mm_add_epi32_inplace_purego باستخدام تعليمات التجميع للحصول على أداء أفضل في عمليات عد السكان الموضعية؟تحسين __mm_add_epi32_inplace_purego باستخدام التجميع يسعى هذا السؤال إلى تحسين الحلقة الداخلية لوظيفة __mm_add_epi32_inplace_purego، التي تقوم بإج...برمجة تم النشر بتاريخ 2024-11-06 -

التنقل باستخدام جهاز التوجيه React React Js الجزء أ دليل التوجيه في تطبيقات Reactمرحبًا بك مرة أخرى في سلسلة React! في المنشورات السابقة، قمنا بتغطية المفاهيم الأساسية مثل المكونات والحالة والدعائم والتعامل مع الأحداث. حان الوق...برمجة تم النشر بتاريخ 2024-11-06

التنقل باستخدام جهاز التوجيه React React Js الجزء أ دليل التوجيه في تطبيقات Reactمرحبًا بك مرة أخرى في سلسلة React! في المنشورات السابقة، قمنا بتغطية المفاهيم الأساسية مثل المكونات والحالة والدعائم والتعامل مع الأحداث. حان الوق...برمجة تم النشر بتاريخ 2024-11-06 -

هل يمكن استخدام file_get_contents() لتحميل ملفات HTTP؟تحميل الملفات باستخدام file_get_contents() باستخدام سياق تدفق HTTP يمكن تحميل الملفات عبر نموذج ويب بسلاسة باستخدام امتداد cURL. ومع ذلك، من ا...برمجة تم النشر بتاريخ 2024-11-06

هل يمكن استخدام file_get_contents() لتحميل ملفات HTTP؟تحميل الملفات باستخدام file_get_contents() باستخدام سياق تدفق HTTP يمكن تحميل الملفات عبر نموذج ويب بسلاسة باستخدام امتداد cURL. ومع ذلك، من ا...برمجة تم النشر بتاريخ 2024-11-06 -

استخدم التأثير في Reactمرحبًا بك في عالم React Hooks! اليوم، سوف نتعمق في أحد أكثر الخطافات شيوعًا: useEffect. لا تقلق، سنجعل الأمر ممتعًا وسهل الفهم. لذلك، دعونا نبدأ! ...برمجة تم النشر بتاريخ 2024-11-06

استخدم التأثير في Reactمرحبًا بك في عالم React Hooks! اليوم، سوف نتعمق في أحد أكثر الخطافات شيوعًا: useEffect. لا تقلق، سنجعل الأمر ممتعًا وسهل الفهم. لذلك، دعونا نبدأ! ...برمجة تم النشر بتاريخ 2024-11-06 -

كيفية إنشاء منصة بيانات حديثة على الطبقة المجانية من Google Cloud Platformلقد قمت بإصدار سلسلة من سبع مقالات عامة مجانية على موقع Medium.com بعنوان "كيفية إنشاء منصة بيانات حديثة على الطبقة المجانية من Google Cloud ...برمجة تم النشر بتاريخ 2024-11-06

كيفية إنشاء منصة بيانات حديثة على الطبقة المجانية من Google Cloud Platformلقد قمت بإصدار سلسلة من سبع مقالات عامة مجانية على موقع Medium.com بعنوان "كيفية إنشاء منصة بيانات حديثة على الطبقة المجانية من Google Cloud ...برمجة تم النشر بتاريخ 2024-11-06 -

مشاركة #f تكافحيتناول هذا المنشور معاناتي مع البرمجة والتعلم حتى الآن أ. أنا فقط قادر على الاستمرار في التركيز لمدة ساعة أو ساعتين كحد أقصى. ب. أنا أتشتت انتباهي بس...برمجة تم النشر بتاريخ 2024-11-06

مشاركة #f تكافحيتناول هذا المنشور معاناتي مع البرمجة والتعلم حتى الآن أ. أنا فقط قادر على الاستمرار في التركيز لمدة ساعة أو ساعتين كحد أقصى. ب. أنا أتشتت انتباهي بس...برمجة تم النشر بتاريخ 2024-11-06 -

أهم ملحقات Chrome لمطوري الويب في 4أفضل 10 ملحقات لمتصفح Chrome لمطوري الويب في عام 2024 مع تقدمنا حتى عام 2024، أصبحت ملحقات Chrome جزءًا لا يتجزأ من مجموعة أدوات مطور الوي...برمجة تم النشر بتاريخ 2024-11-06

أهم ملحقات Chrome لمطوري الويب في 4أفضل 10 ملحقات لمتصفح Chrome لمطوري الويب في عام 2024 مع تقدمنا حتى عام 2024، أصبحت ملحقات Chrome جزءًا لا يتجزأ من مجموعة أدوات مطور الوي...برمجة تم النشر بتاريخ 2024-11-06 -

كيفية تداخل المسارات باستخدام React Router v4/v5: دليل مبسطالمسارات المتداخلة باستخدام React Router v4/v5: دليل مبسط عند العمل مع React Router، تعد مسارات التداخل تقنية حاسمة للتنظيم الملاحة التطبيق ال...برمجة تم النشر بتاريخ 2024-11-06

كيفية تداخل المسارات باستخدام React Router v4/v5: دليل مبسطالمسارات المتداخلة باستخدام React Router v4/v5: دليل مبسط عند العمل مع React Router، تعد مسارات التداخل تقنية حاسمة للتنظيم الملاحة التطبيق ال...برمجة تم النشر بتاريخ 2024-11-06

دراسة اللغة الصينية

- 1 كيف تقول "المشي" باللغة الصينية؟ 走路 نطق الصينية، 走路 تعلم اللغة الصينية

- 2 كيف تقول "استقل طائرة" بالصينية؟ 坐飞机 نطق الصينية، 坐飞机 تعلم اللغة الصينية

- 3 كيف تقول "استقل القطار" بالصينية؟ 坐火车 نطق الصينية، 坐火车 تعلم اللغة الصينية

- 4 كيف تقول "استقل الحافلة" باللغة الصينية؟ 坐车 نطق الصينية، 坐车 تعلم اللغة الصينية

- 5 كيف أقول القيادة باللغة الصينية؟ 开车 نطق الصينية، 开车 تعلم اللغة الصينية

- 6 كيف تقول السباحة باللغة الصينية؟ 游泳 نطق الصينية، 游泳 تعلم اللغة الصينية

- 7 كيف يمكنك أن تقول ركوب الدراجة باللغة الصينية؟ 骑自行车 نطق الصينية، 骑自行车 تعلم اللغة الصينية

- 8 كيف تقول مرحبا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 9 كيف تقول شكرا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning