كيفية تنزيل وتثبيت Llama 2 محليًا

مع أخذ ذلك في الاعتبار، قمنا بإنشاء دليل خطوة بخطوة حول كيفية استخدام Text-Generation-WebUI لتحميل Llama 2 LLM محليًا على جهاز الكمبيوتر الخاص بك.

لماذا تثبيت Llama 2 محليًا

هناك العديد من الأسباب التي تجعل الأشخاص يختارون تشغيل Llama 2 مباشرة. البعض يفعل ذلك لأسباب تتعلق بالخصوصية، والبعض الآخر للتخصيص، والبعض الآخر لإمكانيات عدم الاتصال بالإنترنت. إذا كنت تبحث عن Llama 2 أو تضبطه أو تدمجه في مشاريعك، فقد لا يكون الوصول إلى Llama 2 عبر واجهة برمجة التطبيقات (API) مناسبًا لك. الهدف من تشغيل LLM محليًا على جهاز الكمبيوتر الخاص بك هو تقليل الاعتماد على أدوات الذكاء الاصطناعي التابعة لجهات خارجية واستخدام الذكاء الاصطناعي في أي وقت وفي أي مكان، دون القلق بشأن تسرب البيانات الحساسة المحتملة للشركات والمؤسسات الأخرى.

مع ذلك، فلنبدأ بالدليل خطوة بخطوة لتثبيت Llama 2 محليًا.

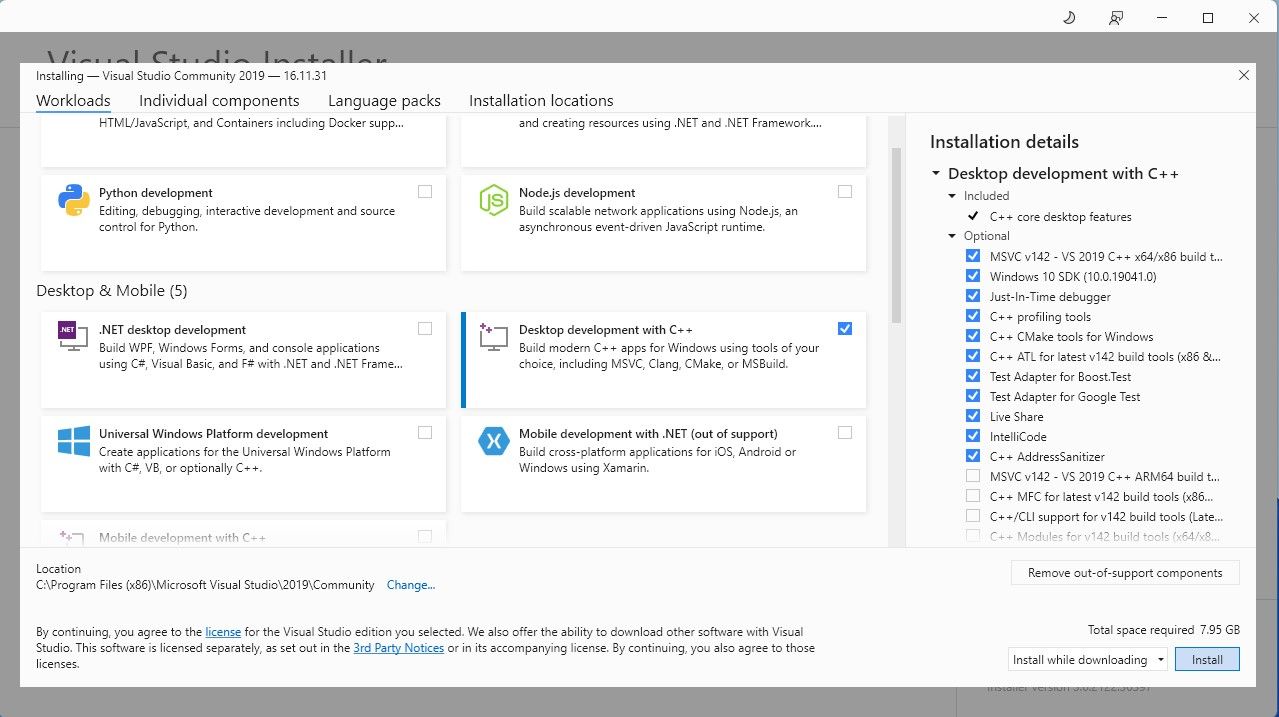

الخطوة 1: تثبيت أداة إنشاء Visual Studio 2019

لتبسيط الأمور، سنستخدم أداة تثبيت بنقرة واحدة لـ Text-Generation-WebUI (البرنامج المستخدم لتحميل Llama 2 باستخدام واجهة المستخدم الرسومية) . ومع ذلك، لكي يعمل هذا المثبت، تحتاج إلى تنزيل أداة إنشاء Visual Studio 2019 وتثبيت الموارد اللازمة.

تنزيل:Visual Studio 2019 (مجاني)

تابع وقم بتنزيل إصدار المجتمع من البرنامج. الآن قم بتثبيت Visual Studio 2019، ثم افتح البرنامج. بمجرد فتحه، حدد مربع تطوير سطح المكتب باستخدام لغة C واضغط على تثبيت.

الآن بعد أن قمت بتثبيت تطوير سطح المكتب باستخدام لغة C، حان الوقت لتنزيل برنامج التثبيت Text-Generation-WebUI بنقرة واحدة.

الخطوة 2: تثبيت Text-Generation-WebUI

برنامج التثبيت بنقرة واحدة Text-Generation-WebUI هو برنامج نصي يقوم تلقائيًا بإنشاء المجلدات المطلوبة وإعداد بيئة Conda وجميع المتطلبات الضرورية لتشغيل نموذج الذكاء الاصطناعي.

لتثبيت البرنامج النصي، قم بتنزيل برنامج التثبيت بنقرة واحدة من خلال النقر على Code > Download ZIP.

تنزيل: Text-Generation-WebUI Installer (مجاني)

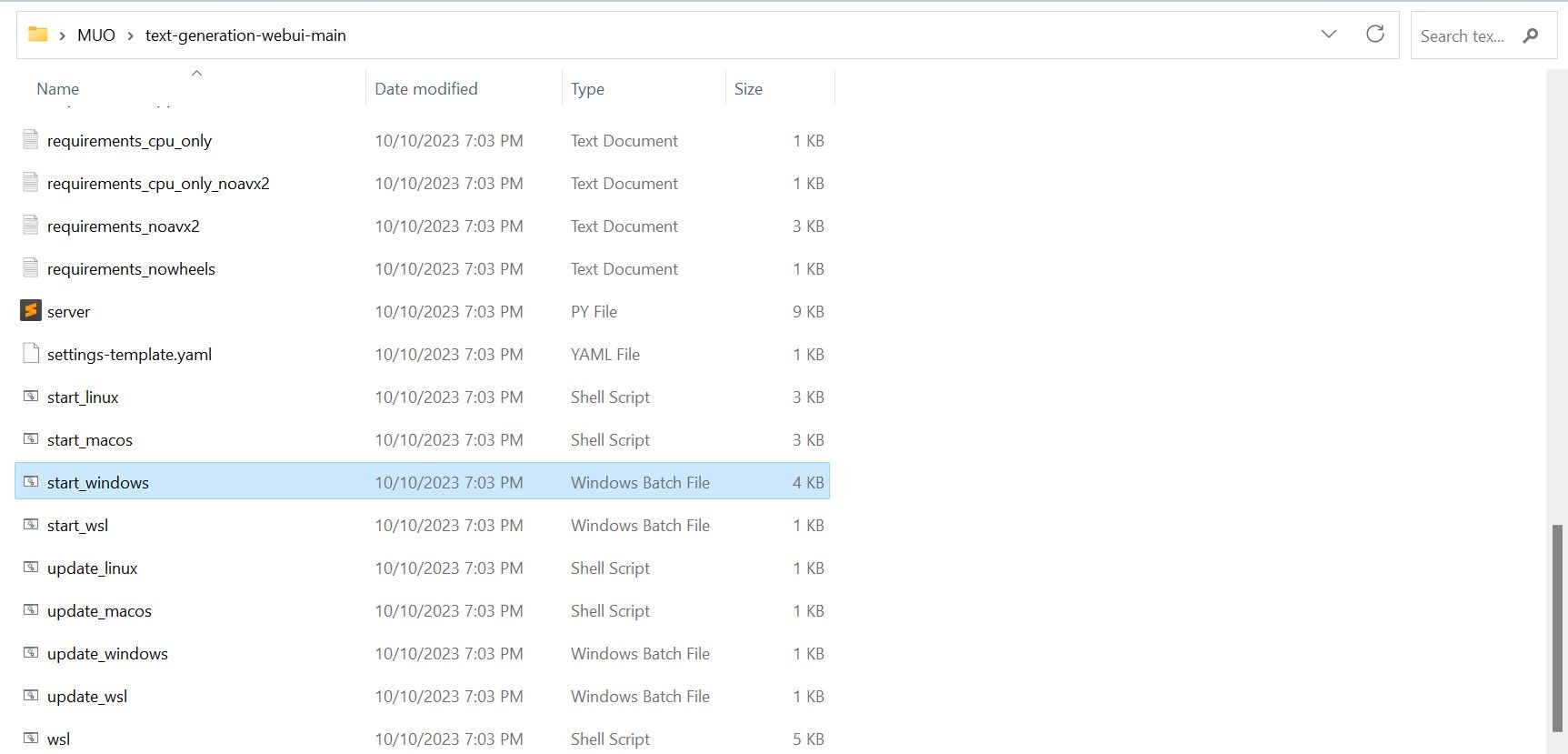

بمجرد التنزيل، قم باستخراج الملف المضغوط إلى موقعك المفضل، ثم افتح المجلد المستخرج. داخل المجلد، قم بالتمرير لأسفل وابحث عن برنامج التشغيل المناسب لنظام التشغيل الخاص بك. قم بتشغيل البرامج بالنقر المزدوج فوق البرنامج النصي المناسب. إذا كنت تستخدم نظام التشغيل Windows، فحدد ملف دفعي start_windows لنظام التشغيل MacOS، وحدد start_macos shell script لنظام التشغيل Linux، وstart_linux shell script.

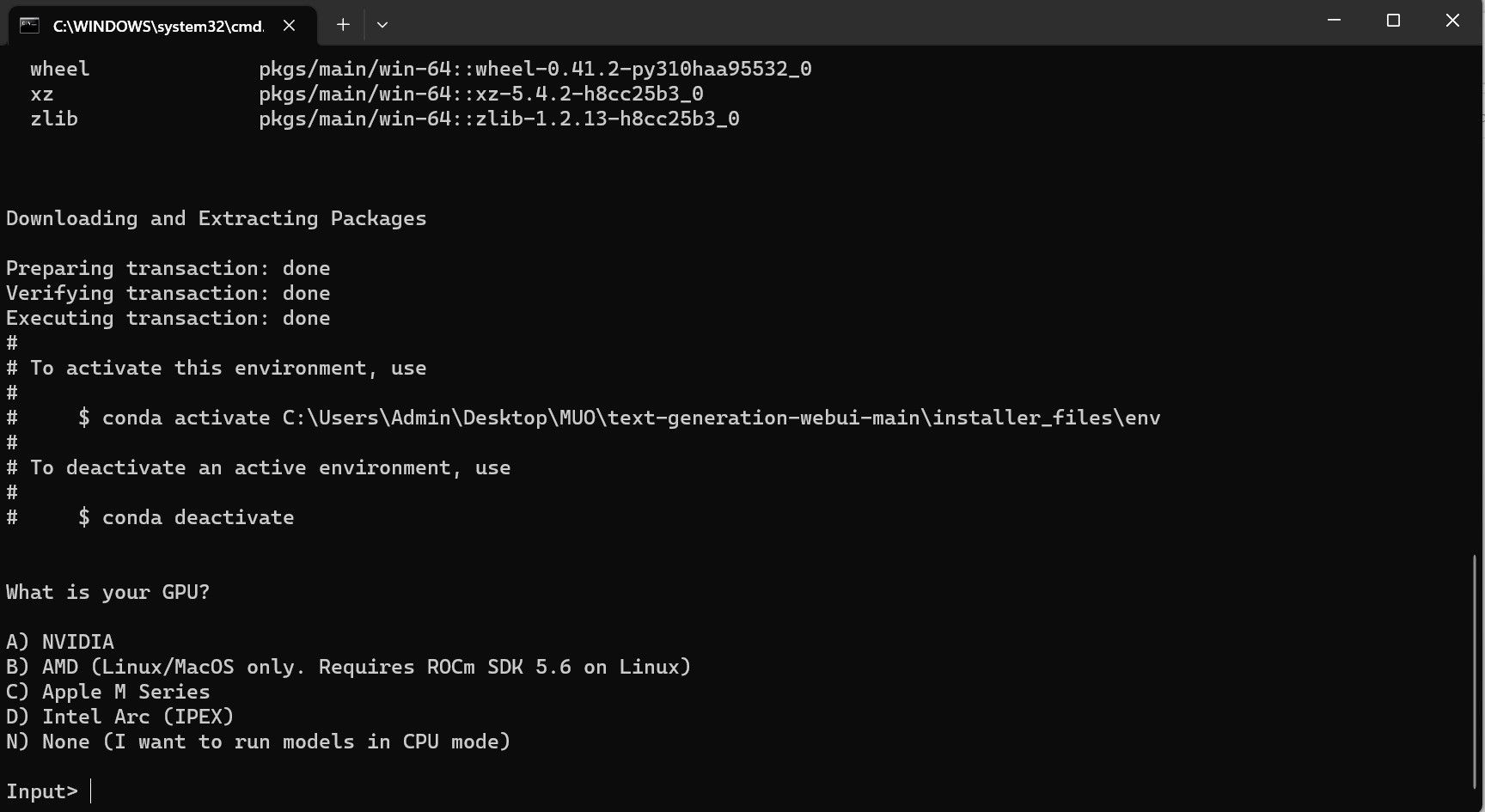

قد يقوم برنامج مكافحة الفيروسات الخاص بك بإنشاء تنبيه؛ هذا جيد. المطالبة هي مجرد نتيجة إيجابية خاطئة لمكافحة الفيروسات لتشغيل ملف دفعي أو برنامج نصي. انقر فوق "تشغيل" على أي حال. سيتم فتح المحطة وبدء الإعداد. في وقت مبكر، سيتوقف الإعداد مؤقتًا ويسألك عن وحدة معالجة الرسومات التي تستخدمها. حدد النوع المناسب من وحدة معالجة الرسومات المثبتة على جهاز الكمبيوتر الخاص بك واضغط على زر الإدخال. بالنسبة لأولئك الذين ليس لديهم بطاقة رسومات مخصصة، حدد لا شيء (أريد تشغيل النماذج في وضع وحدة المعالجة المركزية). ضع في اعتبارك أن التشغيل على وضع وحدة المعالجة المركزية (CPU) أبطأ بكثير مقارنةً بتشغيل النموذج باستخدام وحدة معالجة رسومات مخصصة.

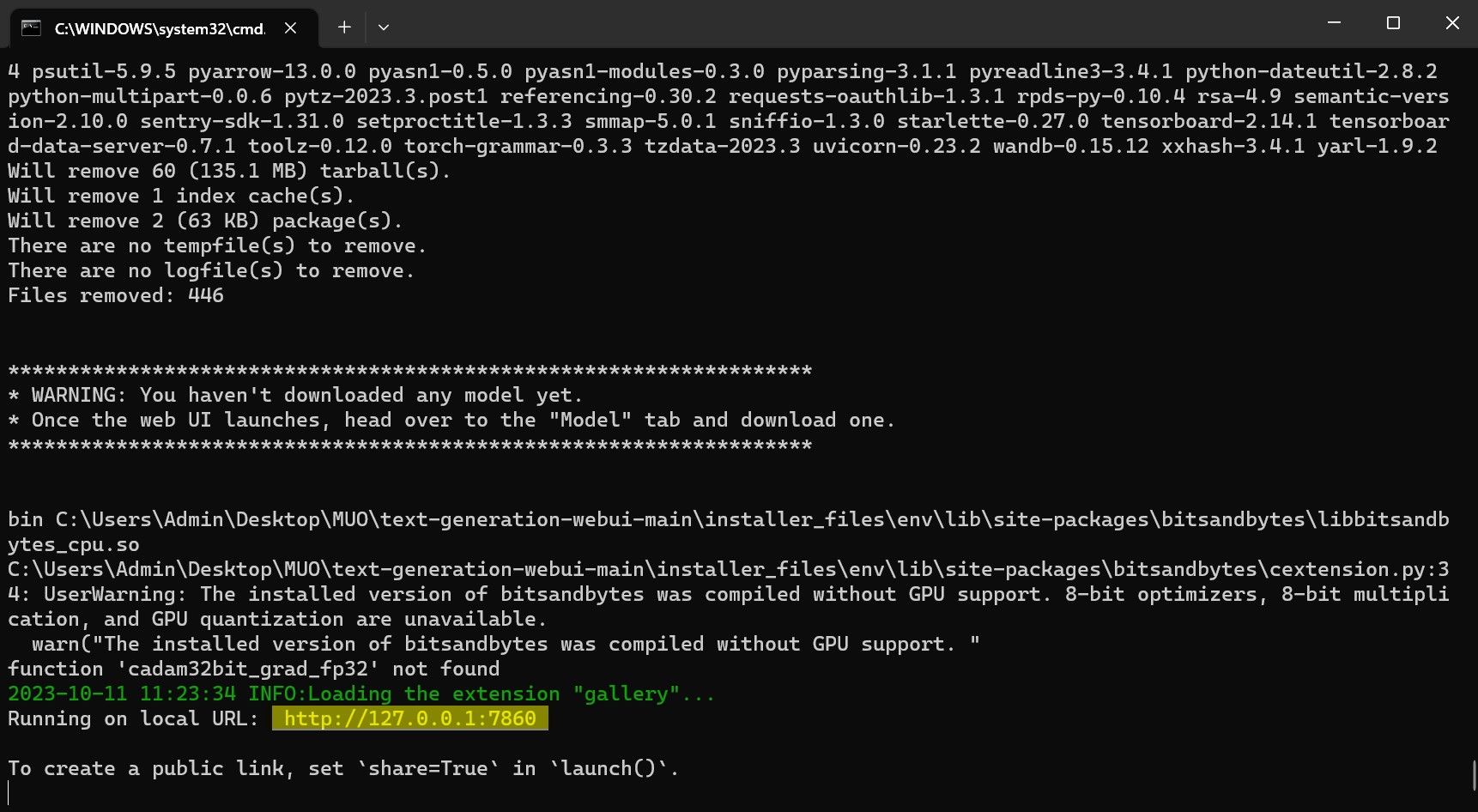

بمجرد اكتمال الإعداد، يمكنك الآن تشغيل Text-Generation-WebUI محليًا. يمكنك القيام بذلك عن طريق فتح متصفح الويب المفضل لديك وإدخال عنوان IP المقدم على عنوان URL.

بمجرد اكتمال الإعداد، يمكنك الآن تشغيل Text-Generation-WebUI محليًا. يمكنك القيام بذلك عن طريق فتح متصفح الويب المفضل لديك وإدخال عنوان IP المقدم على عنوان URL. واجهة WebUI جاهزة الآن للاستخدام.

واجهة WebUI جاهزة الآن للاستخدام.

ومع ذلك، فإن البرنامج مجرد محمل نموذج. لنقم بتنزيل Llama 2 لبدء تشغيل أداة تحميل النموذج.

الخطوة 3: تنزيل نموذج Llama 2

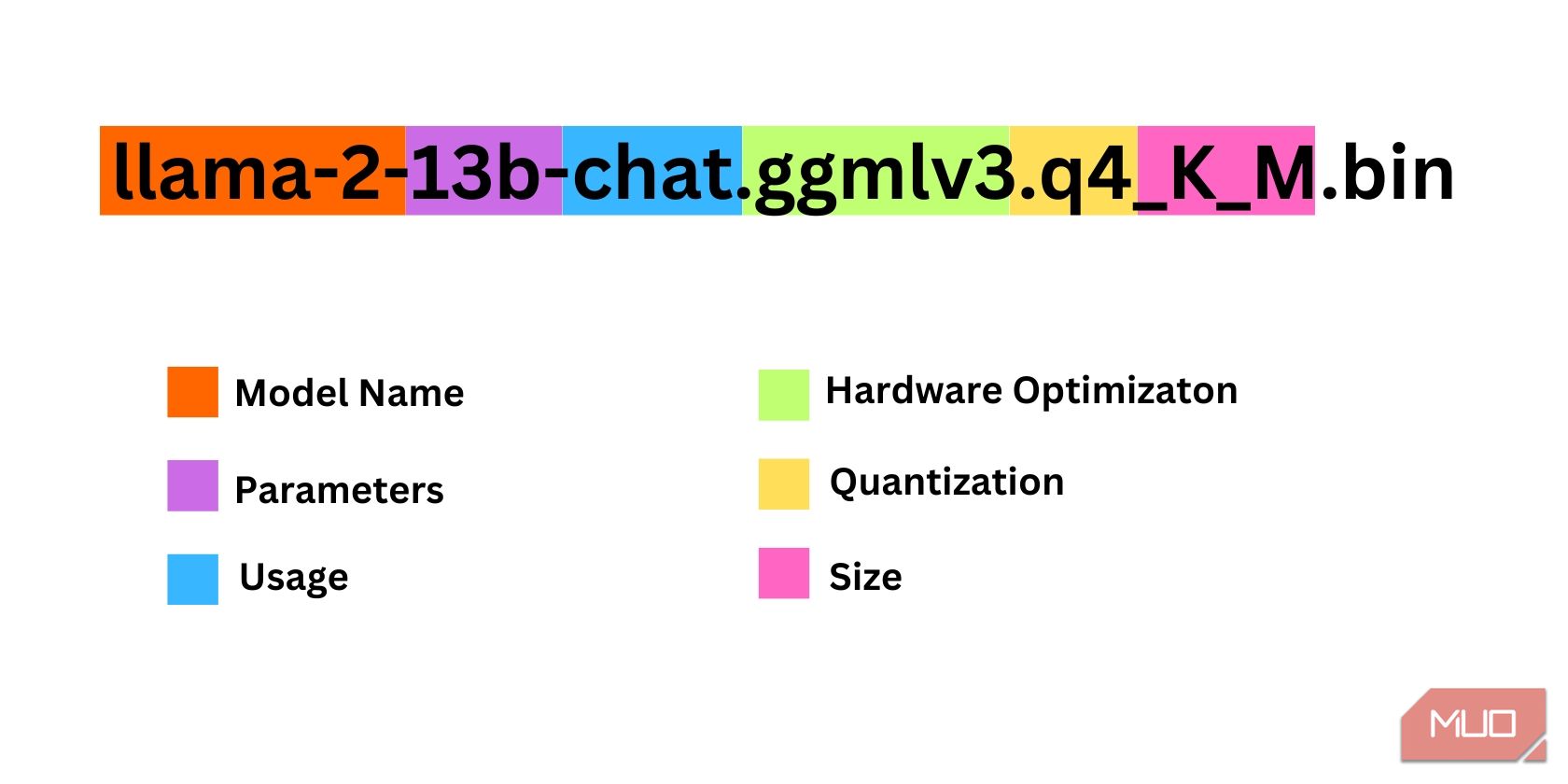

هناك عدد قليل من الأشياء التي يجب مراعاتها عند تحديد تكرار Llama 2 الذي تحتاجه. وتشمل هذه المعلمات والتكميم وتحسين الأجهزة والحجم والاستخدام. سيتم العثور على كل هذه المعلومات مذكورة في اسم النموذج.

المعلمات: عدد المعلمات المستخدمة لتدريب النموذج. المعلمات الأكبر تصنع نماذج أكثر قدرة ولكن على حساب الأداء. الاستخدام: يمكن أن يكون قياسيًا أو دردشة. تم تحسين نموذج الدردشة لاستخدامه كروبوت دردشة مثل ChatGPT، في حين أن المعيار هو النموذج الافتراضي. تحسين الأجهزة: يشير إلى الأجهزة التي تعمل على تشغيل النموذج بشكل أفضل. يعني GPTQ أن النموذج تم تحسينه للتشغيل على وحدة معالجة رسومات مخصصة، بينما تم تحسين GGML للتشغيل على وحدة المعالجة المركزية. التكميم: يدل على دقة الأوزان والتنشيط في النموذج. للاستدلال، دقة q4 هي الأمثل. الحجم: يشير إلى حجم النموذج المحدد.لاحظ أن بعض النماذج قد يتم ترتيبها بشكل مختلف وقد لا تحتوي على نفس أنواع المعلومات المعروضة. ومع ذلك، فإن هذا النوع من اصطلاح التسمية شائع إلى حد ما في مكتبة HuggingFace Model، لذا فهو لا يزال يستحق الفهم.

في هذا المثال، يمكن تحديد النموذج على أنه نموذج Llama 2 متوسط الحجم تم تدريبه على 13 مليار معلمة محسنة لاستدلال الدردشة باستخدام وحدة المعالجة المركزية المخصصة.

بالنسبة لأولئك الذين يعملون على وحدة معالجة رسومات مخصصة، اختر نموذج GPTQ، بينما بالنسبة لأولئك الذين يستخدمون وحدة المعالجة المركزية، اختر GGML. إذا كنت تريد الدردشة مع النموذج كما تفعل مع ChatGPT، فاختر الدردشة، ولكن إذا كنت تريد تجربة النموذج بكامل إمكاناته، فاستخدم النموذج القياسي. أما بالنسبة للمعلمات، فاعلم أن استخدام نماذج أكبر سيوفر نتائج أفضل على حساب الأداء. أنا شخصياً أوصيك بالبدء بنموذج 7B. أما بالنسبة للتكميم، فاستخدم q4، لأنه مخصص للاستدلال فقط.

التنزيل: GGML (مجاني)

التنزيل: GPTQ (مجاني)

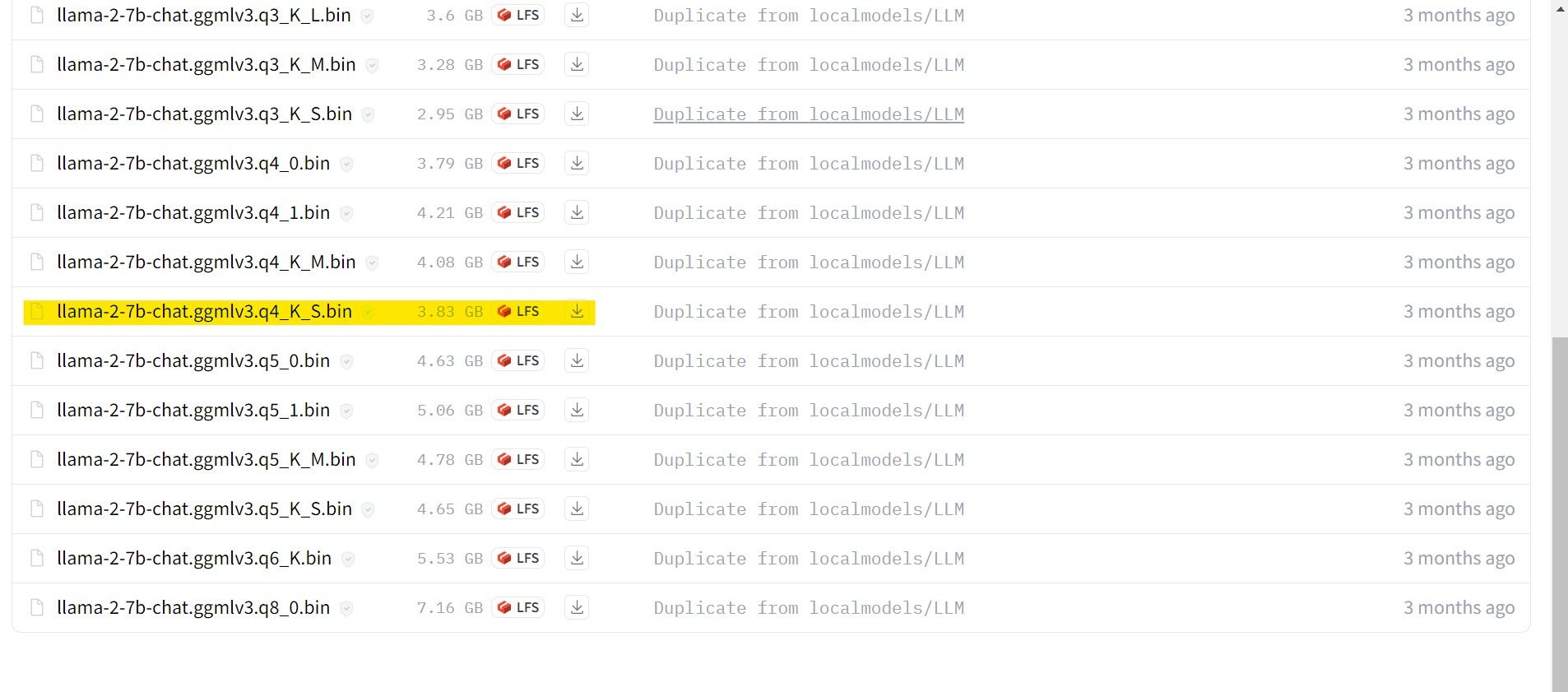

الآن بعد أن عرفت ما هو تكرار Llama 2 الذي تحتاجه، تابع وقم بتنزيل النموذج الذي تريده .

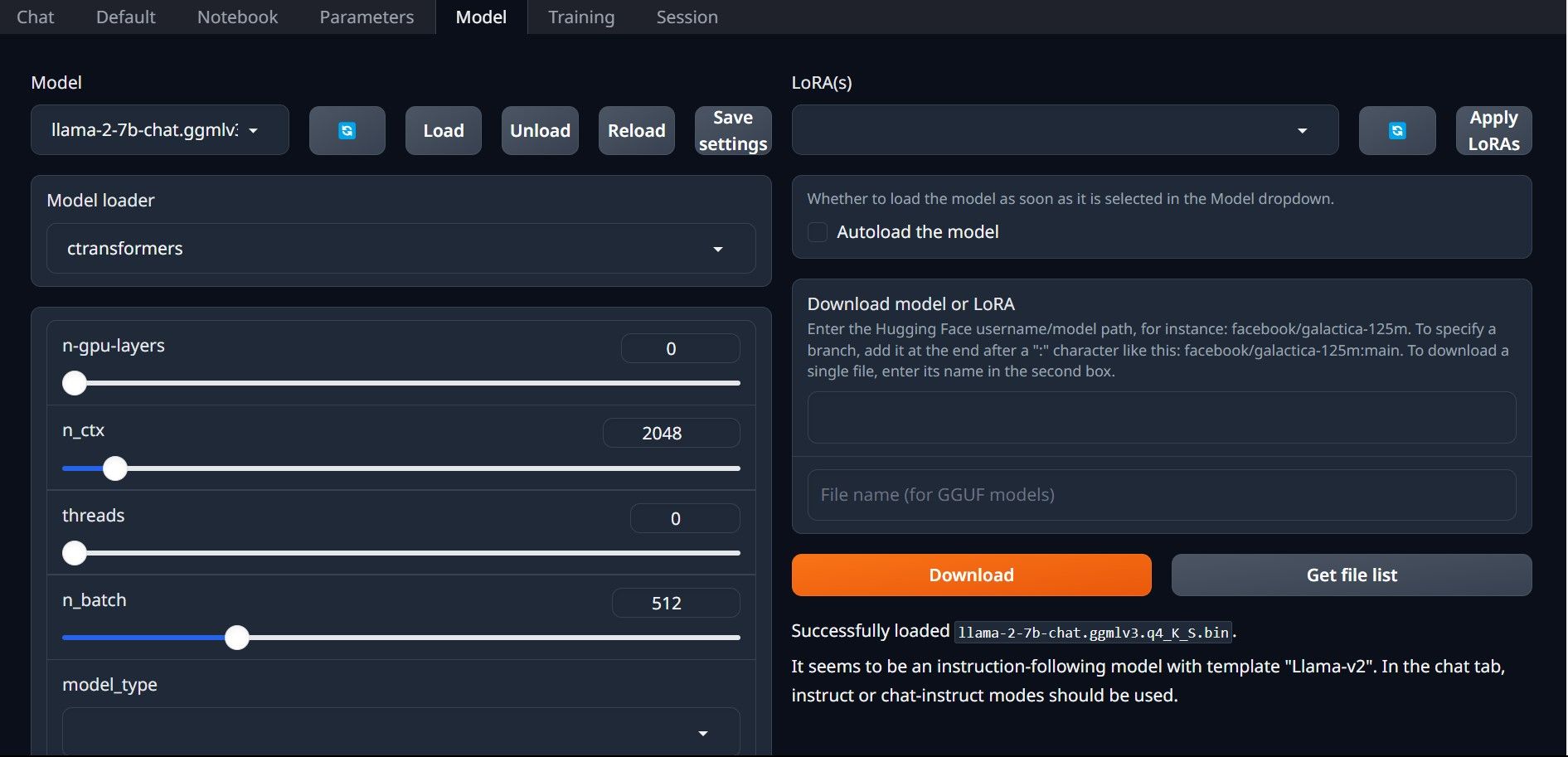

في حالتي، بما أنني أقوم بتشغيل هذا على جهاز Ultrabook، سأستخدم نموذج GGML المضبوط جيدًا للدردشة، llama-2-7b-chat-ggmlv3.q4_K_S.bin.

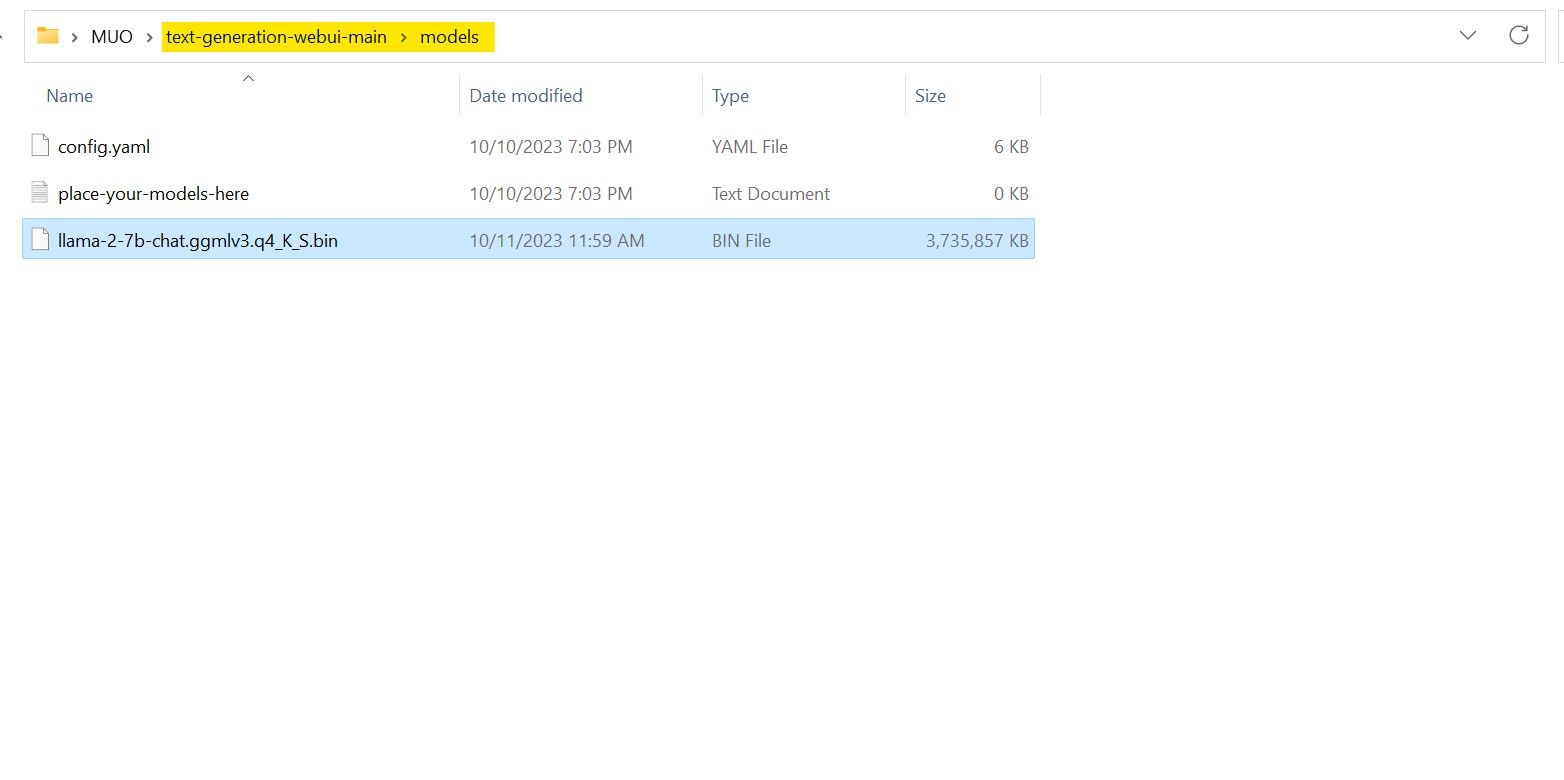

بعد انتهاء التنزيل، ضع النموذج في نماذج text-gene-webui-main >.

الآن بعد أن قمت بتنزيل النموذج الخاص بك ووضعه في مجلد النموذج، فقد حان الوقت لتكوين أداة تحميل النموذج.

الخطوة 4: تكوين Text-Generation-WebUI

الآن، لنبدأ مرحلة التكوين.

مرة أخرى، افتح Text-Generation-WebUI عن طريق تشغيل ملف start_ (نظام التشغيل الخاص بك) (راجع الخطوات السابقة أعلاه). في علامات التبويب الموجودة أعلى واجهة المستخدم الرسومية، انقر فوق النموذج. انقر فوق زر التحديث في القائمة المنسدلة للنموذج وحدد النموذج الخاص بك. انقر الآن على القائمة المنسدلة لمحمل النموذج وحدد AutoGPTQ لأولئك الذين يستخدمون نموذج GTPQ ومحولات ct لأولئك الذين يستخدمون نموذج GGML. أخيرًا، انقر فوق "تحميل" لتحميل النموذج الخاص بك. لاستخدام النموذج، افتح علامة التبويب "دردشة" وابدأ في اختبار النموذج.

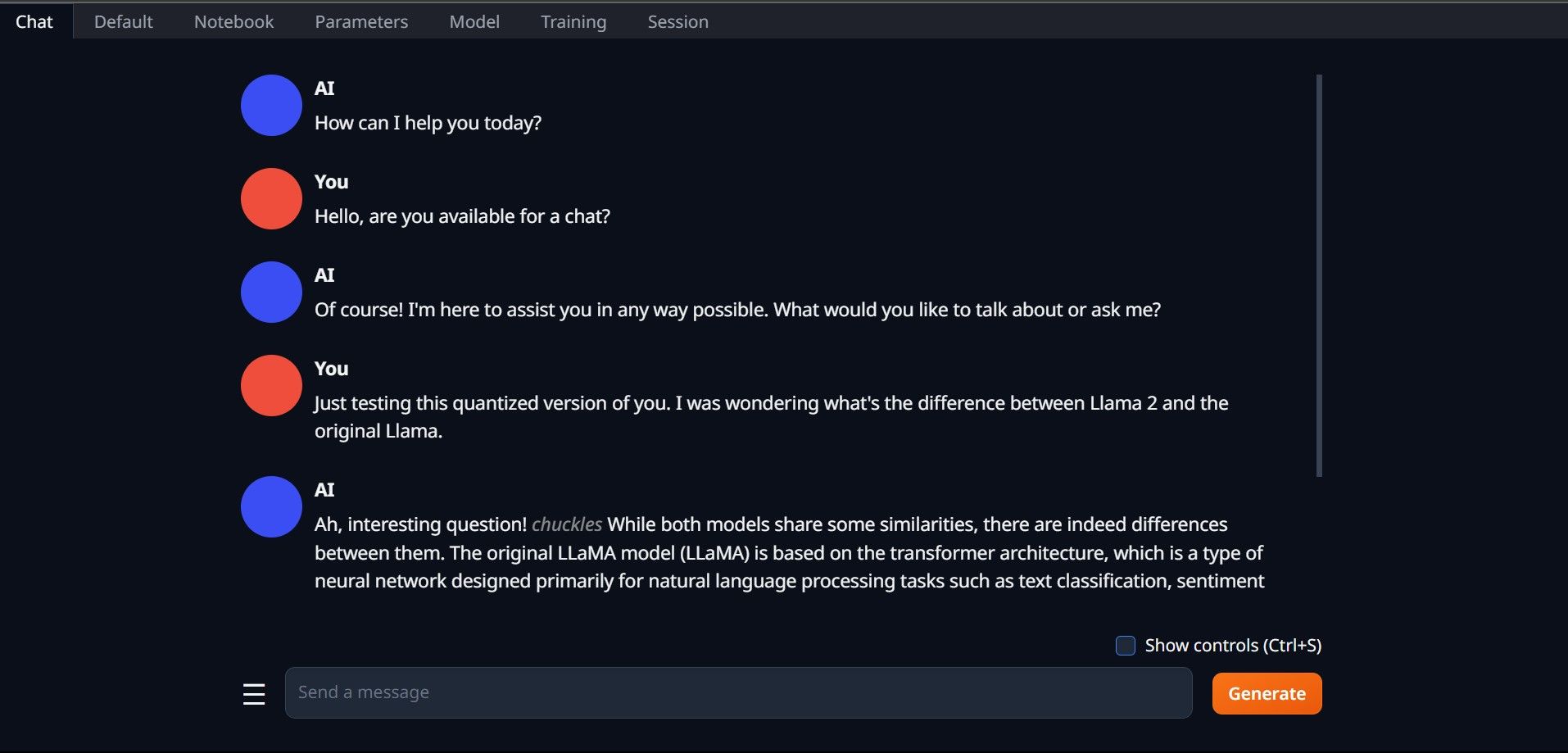

لاستخدام النموذج، افتح علامة التبويب "دردشة" وابدأ في اختبار النموذج.

تهانينا، لقد قمت بتحميل Llama2 بنجاح على جهاز الكمبيوتر المحلي الخاص بك!

جرب LLMs أخرى

الآن بعد أن عرفت كيفية تشغيل Llama 2 مباشرة على جهاز الكمبيوتر الخاص بك باستخدام Text-Generation-WebUI، يجب أن تكون أيضًا قادرًا على تشغيل LLMs أخرى إلى جانب Llama. فقط تذكر اصطلاحات تسمية النماذج وأنه لا يمكن تحميل سوى الإصدارات الكمية من النماذج (عادة بدقة Q4) على أجهزة الكمبيوتر العادية. تتوفر العديد من شهادات LLM الكمية على HuggingFace. إذا كنت ترغب في استكشاف نماذج أخرى، فابحث عن TheBloke في مكتبة نماذج HuggingFace، وستجد العديد من النماذج المتاحة.

-

الجهاز المناعي الاصطناعي (AIS): دليل مع أمثلة Pythonتستكشف هذه المقالة أنظمة المناعة الاصطناعية (AIS) ، والنماذج الحسابية مستوحاة من قدرة الجهاز المناعي البشري الرائع على تحديد التهديدات وتحييدها. سوف...منظمة العفو الدولية نشر في 2025-03-04

الجهاز المناعي الاصطناعي (AIS): دليل مع أمثلة Pythonتستكشف هذه المقالة أنظمة المناعة الاصطناعية (AIS) ، والنماذج الحسابية مستوحاة من قدرة الجهاز المناعي البشري الرائع على تحديد التهديدات وتحييدها. سوف...منظمة العفو الدولية نشر في 2025-03-04 -

حاول طرح هذه الأسئلة الممتعة عن نفسك على ChatGPTهل تساءلت يومًا عما يعرفه ChatGPT عنك؟ كيف يعالج المعلومات التي زودتها بها مع مرور الوقت؟ لقد استخدمت أكوام ChatGPT في سيناريوهات مختلفة، ومن المثير ل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-22

حاول طرح هذه الأسئلة الممتعة عن نفسك على ChatGPTهل تساءلت يومًا عما يعرفه ChatGPT عنك؟ كيف يعالج المعلومات التي زودتها بها مع مرور الوقت؟ لقد استخدمت أكوام ChatGPT في سيناريوهات مختلفة، ومن المثير ل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-22 -

إليك كيف لا يزال بإمكانك تجربة برنامج Chatbot الغامض GPT-2إذا كنت مهتمًا بنماذج الذكاء الاصطناعي أو روبوتات الدردشة، فربما تكون قد شاهدت مناقشات حول روبوت الدردشة الغامض GPT-2 وفعاليته.هنا، نوضح ما هو روبوت ا...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

إليك كيف لا يزال بإمكانك تجربة برنامج Chatbot الغامض GPT-2إذا كنت مهتمًا بنماذج الذكاء الاصطناعي أو روبوتات الدردشة، فربما تكون قد شاهدت مناقشات حول روبوت الدردشة الغامض GPT-2 وفعاليته.هنا، نوضح ما هو روبوت ا...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

يعد وضع Canvas في ChatGPT رائعًا: إليك 4 طرق لاستخدامهأضاف وضع Canvas الجديد في ChatGPT بُعدًا إضافيًا للكتابة والتحرير في أداة الذكاء الاصطناعي الرائدة في العالم. أنا أستخدم ChatGPT Canvas منذ إطلاقه، و...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

يعد وضع Canvas في ChatGPT رائعًا: إليك 4 طرق لاستخدامهأضاف وضع Canvas الجديد في ChatGPT بُعدًا إضافيًا للكتابة والتحرير في أداة الذكاء الاصطناعي الرائدة في العالم. أنا أستخدم ChatGPT Canvas منذ إطلاقه، و...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

كيف يمكن لـ GPTs المخصصة في ChatGPT الكشف عن بياناتك وكيفية الحفاظ عليها آمنةتتيح ميزة GPT المخصصة في ChatGPT لأي شخص إنشاء أداة ذكاء اصطناعي مخصصة لأي شيء يخطر ببالك تقريبًا؛ يمكن لـ GPTs الإبداعية والتقنية والألعاب والمخصصة ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

كيف يمكن لـ GPTs المخصصة في ChatGPT الكشف عن بياناتك وكيفية الحفاظ عليها آمنةتتيح ميزة GPT المخصصة في ChatGPT لأي شخص إنشاء أداة ذكاء اصطناعي مخصصة لأي شيء يخطر ببالك تقريبًا؛ يمكن لـ GPTs الإبداعية والتقنية والألعاب والمخصصة ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

10 طرق يمكن أن تساعدك بها ChatGPT في الحصول على وظيفة على LinkedInمع وجود 2600 شخصية متاحة، يعد قسم "حول" في ملفك الشخصي على LinkedIn مساحة رائعة لتوضيح خلفيتك ومهاراتك وشغفك وأهدافك المستقبلية. اعرض سيرتك...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

10 طرق يمكن أن تساعدك بها ChatGPT في الحصول على وظيفة على LinkedInمع وجود 2600 شخصية متاحة، يعد قسم "حول" في ملفك الشخصي على LinkedIn مساحة رائعة لتوضيح خلفيتك ومهاراتك وشغفك وأهدافك المستقبلية. اعرض سيرتك...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

تحقق من تطبيقات الذكاء الاصطناعي الستة الأقل شهرة والتي توفر تجارب فريدة من نوعهافي هذه المرحلة، سمع معظم الناس عن ChatGPT وCopilot، وهما تطبيقان رائدان في مجال الذكاء الاصطناعي قادا ازدهار الذكاء الاصطناعي. ولكن هل تعلم أن عددًا ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

تحقق من تطبيقات الذكاء الاصطناعي الستة الأقل شهرة والتي توفر تجارب فريدة من نوعهافي هذه المرحلة، سمع معظم الناس عن ChatGPT وCopilot، وهما تطبيقان رائدان في مجال الذكاء الاصطناعي قادا ازدهار الذكاء الاصطناعي. ولكن هل تعلم أن عددًا ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

تظهر هذه العلامات السبع أننا وصلنا بالفعل إلى ذروة الذكاء الاصطناعيأينما نظرت عبر الإنترنت، ستجد مواقع وخدمات وتطبيقات تعلن أن استخدامها للذكاء الاصطناعي يجعله الخيار الأفضل. لا أعرف عنك، لكن وجوده المستمر أصبح متعبً...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

تظهر هذه العلامات السبع أننا وصلنا بالفعل إلى ذروة الذكاء الاصطناعيأينما نظرت عبر الإنترنت، ستجد مواقع وخدمات وتطبيقات تعلن أن استخدامها للذكاء الاصطناعي يجعله الخيار الأفضل. لا أعرف عنك، لكن وجوده المستمر أصبح متعبً...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

4 أدوات لفحص ChatGPT باستخدام الذكاء الاصطناعي للمعلمين والمحاضرين والرؤساءمع تقدم ChatGPT في السلطة، أصبح من الصعب معرفة ما يكتبه الإنسان وما ينتجه الذكاء الاصطناعي. وهذا يجعل من الصعب على المعلمين والرؤساء التعرف على ما كت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

4 أدوات لفحص ChatGPT باستخدام الذكاء الاصطناعي للمعلمين والمحاضرين والرؤساءمع تقدم ChatGPT في السلطة، أصبح من الصعب معرفة ما يكتبه الإنسان وما ينتجه الذكاء الاصطناعي. وهذا يجعل من الصعب على المعلمين والرؤساء التعرف على ما كت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

يتم طرح ميزة الصوت المتقدمة في ChatGPT لمزيد من المستخدمينإذا كنت ترغب في إجراء محادثة كاملة مع ChatGPT، الآن يمكنك ذلك. أي طالما أنك تدفع مقابل امتياز استخدام ChatGPT. أصبح بإمكان المزيد من المستخدمين ال...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

يتم طرح ميزة الصوت المتقدمة في ChatGPT لمزيد من المستخدمينإذا كنت ترغب في إجراء محادثة كاملة مع ChatGPT، الآن يمكنك ذلك. أي طالما أنك تدفع مقابل امتياز استخدام ChatGPT. أصبح بإمكان المزيد من المستخدمين ال...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

ما هو AI Slop وماذا يمكنك أن تفعل حيال ذلك؟ربما سمعت مصطلح "AI slop" فيما يتعلق بالصور الغريبة التي تم إنشاؤها بواسطة الذكاء الاصطناعي والتي يتم تداولها على وسائل التواصل الاجتماع...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

ما هو AI Slop وماذا يمكنك أن تفعل حيال ذلك؟ربما سمعت مصطلح "AI slop" فيما يتعلق بالصور الغريبة التي تم إنشاؤها بواسطة الذكاء الاصطناعي والتي يتم تداولها على وسائل التواصل الاجتماع...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

6 أسباب تجعلني أحب انفجار الذكاء الاصطناعي أكثر من طفرة العملات المشفرةيبدو أن انفجار الذكاء الاصطناعي يردد صدى الهيجان الذي شهدناه خلال طفرة العملات المشفرة، حيث يتحدث الجميع عنه، ويتوقعون كيف سيعيد تشكيل العالم. ولكن عل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

6 أسباب تجعلني أحب انفجار الذكاء الاصطناعي أكثر من طفرة العملات المشفرةيبدو أن انفجار الذكاء الاصطناعي يردد صدى الهيجان الذي شهدناه خلال طفرة العملات المشفرة، حيث يتحدث الجميع عنه، ويتوقعون كيف سيعيد تشكيل العالم. ولكن عل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

أدوات الداما بالذكاء الاصطناعي عديمة الفائدة، وهذه الأمثلة الخمسة تثبت السببسواء كنت كاتبًا محترفًا أو طالبًا يكتب المقالات بشكل متكرر، فمن المحتمل أنك سئمت من تشغيل عملك من خلال أجهزة كشف الذكاء الاصطناعي فقط ليتم تمييزها عل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

أدوات الداما بالذكاء الاصطناعي عديمة الفائدة، وهذه الأمثلة الخمسة تثبت السببسواء كنت كاتبًا محترفًا أو طالبًا يكتب المقالات بشكل متكرر، فمن المحتمل أنك سئمت من تشغيل عملك من خلال أجهزة كشف الذكاء الاصطناعي فقط ليتم تمييزها عل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

كيف أستخدم ChatGPT لترجمة مقاطع الفيديو وتوفير الوقتإذا سبق لك أن حاولت ترجمة مقطع فيديو إلى لغة أخرى، فأنت تعرف مدى السرعة التي يمكن أن يتحول بها إلى مهمة تستغرق وقتًا طويلاً. وهنا يأتي دور ChatGPT، وت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

كيف أستخدم ChatGPT لترجمة مقاطع الفيديو وتوفير الوقتإذا سبق لك أن حاولت ترجمة مقطع فيديو إلى لغة أخرى، فأنت تعرف مدى السرعة التي يمكن أن يتحول بها إلى مهمة تستغرق وقتًا طويلاً. وهنا يأتي دور ChatGPT، وت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

6 بدائل لـ OpenAI Sora يمكنك تجربتها مجانًايعكس Gen-2 من Runway أفضل ما ستحصل عليه باستخدام Sora من Open AI، وذلك باستخدام نظام ذكاء اصطناعي متعدد الوسائط لإنشاء مقاطع فيديو باستخدام المطالبات...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

6 بدائل لـ OpenAI Sora يمكنك تجربتها مجانًايعكس Gen-2 من Runway أفضل ما ستحصل عليه باستخدام Sora من Open AI، وذلك باستخدام نظام ذكاء اصطناعي متعدد الوسائط لإنشاء مقاطع فيديو باستخدام المطالبات...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

دراسة اللغة الصينية

- 1 كيف تقول "المشي" باللغة الصينية؟ 走路 نطق الصينية، 走路 تعلم اللغة الصينية

- 2 كيف تقول "استقل طائرة" بالصينية؟ 坐飞机 نطق الصينية، 坐飞机 تعلم اللغة الصينية

- 3 كيف تقول "استقل القطار" بالصينية؟ 坐火车 نطق الصينية، 坐火车 تعلم اللغة الصينية

- 4 كيف تقول "استقل الحافلة" باللغة الصينية؟ 坐车 نطق الصينية، 坐车 تعلم اللغة الصينية

- 5 كيف أقول القيادة باللغة الصينية؟ 开车 نطق الصينية، 开车 تعلم اللغة الصينية

- 6 كيف تقول السباحة باللغة الصينية؟ 游泳 نطق الصينية، 游泳 تعلم اللغة الصينية

- 7 كيف يمكنك أن تقول ركوب الدراجة باللغة الصينية؟ 骑自行车 نطق الصينية، 骑自行车 تعلم اللغة الصينية

- 8 كيف تقول مرحبا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 9 كيف تقول شكرا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning