构建 Ollama Cloud - 将本地推理扩展到云端

Ollama 主要是 llama.cpp 的包装器,专为本地推理任务而设计。如果您正在寻找尖端的性能或功能,它通常不是您的首选,但它有其用途,特别是在需要考虑外部依赖项的环境中。

本地人工智能开发

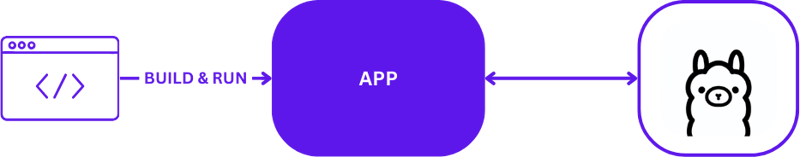

使用 Ollama 进行本地 AI 开发时,设置简单但有效。开发人员通常利用 Ollama 直接在本地计算机上运行推理任务。以下是使用 Ollama 的典型本地开发设置的直观描述:

此配置允许开发人员快速测试和迭代,而无需复杂的远程服务器通信。它非常适合快速周转至关重要的初始原型设计和开发阶段。

从本地到云端

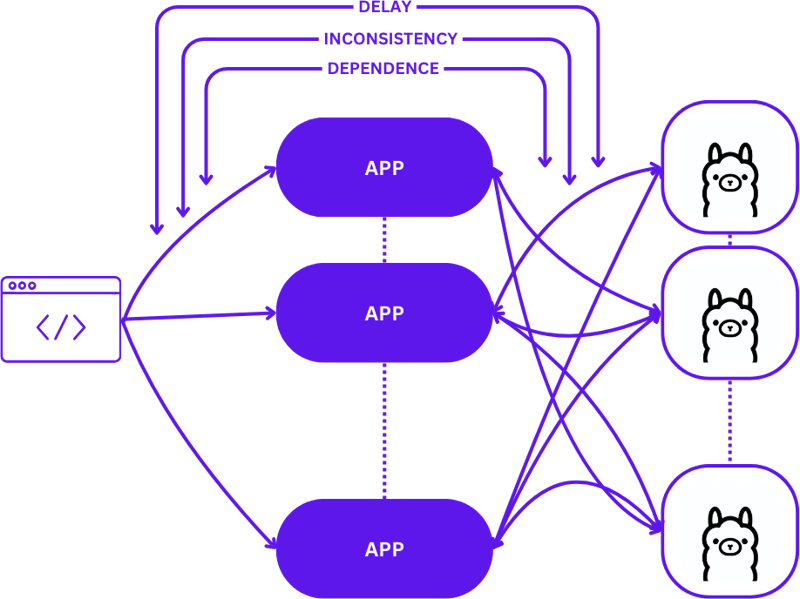

从本地设置过渡到可扩展的云环境涉及从简单的 1:1 设置(一个用户请求到一台推理主机)演变为更复杂的多对多(多个用户请求到多个推理主机)配置。随着需求的增加,这种转变对于保持效率和响应能力是必要的。

以下是从本地开发转向生产时的扩展情况:

在此过渡期间采用简单的方法可能会显着增加应用程序的复杂性,特别是当会话需要在不同状态之间保持一致性时。如果请求未最佳路由到最佳可用推理主机,则可能会出现延迟和效率低下。

此外,分布式应用程序的复杂性使得它们在本地测试变得具有挑战性,这会减慢开发过程并增加生产环境中失败的风险。

无服务器

无服务器计算抽象了服务器管理和基础设施细节,使开发人员能够专注于代码和业务逻辑。通过将请求处理和一致性维护与应用程序解耦,无服务器架构简化了扩展。

这种方法允许应用程序继续专注于提供价值,解决许多常见的扩展挑战,而不会给开发人员带来基础设施复杂性的负担。

网络组装

WebAssembly (Wasm) 通过将应用程序编译成独立的模块来解决依赖管理的挑战。这使得应用程序在本地和云中更容易编排和测试,确保不同环境之间的一致性。

牛头蛋白

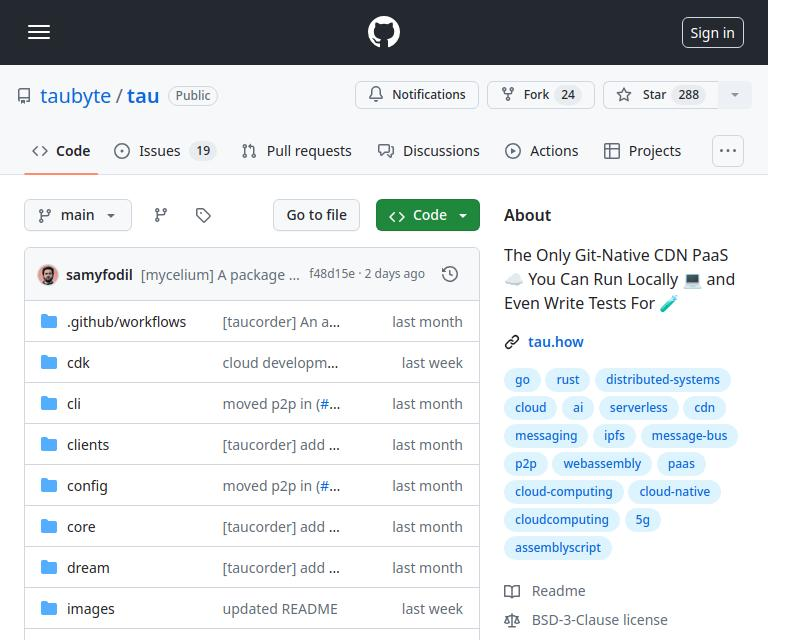

Tau 是一个用于构建低维护和高度可扩展的云计算平台的框架。它在简单性和可扩展性方面表现出色。 Tau 使部署变得简单,并支持运行本地云进行开发,从而允许对云基础设施及其上运行的应用程序进行端到端 (E2E) 测试。

这种方法被 Taubyte 称为“本地编码等于全球生产”,可确保本地工作也能在全球范围内工作,从而显着简化开发和部署流程。

使用 Orbit 插件系统将 Ollama 集成到 Tau 中

Tau 的插件系统(称为 Orbit)通过将服务包装到 WebAssembly 主机模块中,显着简化了将服务转变为可管理组件的过程。这种方法允许 Tau 接管编排职责,简化部署和管理流程。

Ollama 中的导出函数

为了使 Ollama 功能可以在 Tau 生态系统中访问,我们利用 Orbit 系统将 Ollama 的功能导出为可调用端点。以下是在 Go 中导出端点的方法:

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

导出函数的简单示例,可以参考hello_world示例。

一旦定义,这些函数(现在通过卫星调用。导出)可以将 Ollama 无缝集成到 Tau 的环境中:

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

为 Ollama 插件编写测试

测试插件是简化和简单的。以下是如何在 Go 中编写无服务器功能测试:

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

使用 Tau 的测试套件和 Go 构建器工具,您可以构建插件,将其部署在测试环境中,并执行无服务器函数来验证功能:

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

代码

您可以在这里找到完整的代码 https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/tau

下一步是什么?

您现在可以轻松构建 LLM 申请。以下是开始步骤:

- 在本地开始使用 dream:设置本地环境来开发和测试您的应用程序。

- 创建项目:使用 Tau 开始一个新项目,以充分发挥其潜力。

- 创建您的生产云:在生产云环境中部署您的项目。

- 将插件二进制文件拖放到 /tb/plugins 文件夹中。

- 将您的项目导入生产环境

- 炫耀!

-

C++中如何将独占指针作为函数或构造函数参数传递?在构造函数和函数中将唯一的指数管理为参数 unique pointers( unique_ptr [2启示。通过值: base(std :: simelor_ptr n) :next(std :: move(n)){} 此方法将唯一指针的所有权转移到函数/对象。指针的内容被移至功能中,在操作...编程 发布于2025-04-19

C++中如何将独占指针作为函数或构造函数参数传递?在构造函数和函数中将唯一的指数管理为参数 unique pointers( unique_ptr [2启示。通过值: base(std :: simelor_ptr n) :next(std :: move(n)){} 此方法将唯一指针的所有权转移到函数/对象。指针的内容被移至功能中,在操作...编程 发布于2025-04-19 -

Go语言如何高效测试Panic情况?在GO 时,检查panics可能是一项有用的技术。但是,与Java不同,GO没有明确的语法可有选择地处理恐慌。考虑以下示例:此代码尝试使用恢复函数从其他功能性的恐慌中恢复。但是,确定该功能是否完全恐慌或是否没有发生恐慌。解决方案 func testpanic(t *testing.t){ ...编程 发布于2025-04-19

Go语言如何高效测试Panic情况?在GO 时,检查panics可能是一项有用的技术。但是,与Java不同,GO没有明确的语法可有选择地处理恐慌。考虑以下示例:此代码尝试使用恢复函数从其他功能性的恐慌中恢复。但是,确定该功能是否完全恐慌或是否没有发生恐慌。解决方案 func testpanic(t *testing.t){ ...编程 发布于2025-04-19 -

如何使用Regex在PHP中有效地提取括号内的文本php:在括号内提取文本在处理括号内的文本时,找到最有效的解决方案是必不可少的。一种方法是利用PHP的字符串操作函数,如下所示: 作为替代 $ text ='忽略除此之外的一切(text)'; preg_match('#((。 &&& [Regex使用模式来搜索特...编程 发布于2025-04-19

如何使用Regex在PHP中有效地提取括号内的文本php:在括号内提取文本在处理括号内的文本时,找到最有效的解决方案是必不可少的。一种方法是利用PHP的字符串操作函数,如下所示: 作为替代 $ text ='忽略除此之外的一切(text)'; preg_match('#((。 &&& [Regex使用模式来搜索特...编程 发布于2025-04-19 -

CTEs,子查询,临时表,表变量,何时用最优数据库性能在数据库查询的领域中,了解CTE,子征服,临时表和表变量之间的性能差异,技术的选择可能会对性能产生重大影响。在本文中,我们深入研究了特定情况,在效率上CTE,子征服,临时表和表变量出色。 ctes在本质上可以重复使用单个单个Querery。它们的优势在于它们可以用于多次使用的事实,因为数据库引擎可以...编程 发布于2025-04-19

CTEs,子查询,临时表,表变量,何时用最优数据库性能在数据库查询的领域中,了解CTE,子征服,临时表和表变量之间的性能差异,技术的选择可能会对性能产生重大影响。在本文中,我们深入研究了特定情况,在效率上CTE,子征服,临时表和表变量出色。 ctes在本质上可以重复使用单个单个Querery。它们的优势在于它们可以用于多次使用的事实,因为数据库引擎可以...编程 发布于2025-04-19 -

PHP高手必备 | Ctype函数入门指南PHP 的 ctype 函数详解:字符类型验证利器 核心要点 PHP 4.2 及以上版本包含的 ctype 函数族用于验证字符串中字符的类型,常用于数据验证。它们可以检查字符串是否仅包含大写字符、数字、十六进制字符等。但务必确保传入这些函数的始终是字符串。 ctype 函数种类繁多,包括 ctype...编程 发布于2025-04-19

PHP高手必备 | Ctype函数入门指南PHP 的 ctype 函数详解:字符类型验证利器 核心要点 PHP 4.2 及以上版本包含的 ctype 函数族用于验证字符串中字符的类型,常用于数据验证。它们可以检查字符串是否仅包含大写字符、数字、十六进制字符等。但务必确保传入这些函数的始终是字符串。 ctype 函数种类繁多,包括 ctype...编程 发布于2025-04-19 -

在Ubuntu/linux上安装mysql-python时,如何修复\“ mysql_config \”错误?mysql-python安装错误:“ mysql_config找不到”“ 由于缺少MySQL开发库而出现此错误。解决此问题,建议在Ubuntu上使用该分发的存储库。使用以下命令安装Python-MysqldB: sudo apt-get安装python-mysqldb sudo pip in...编程 发布于2025-04-19

在Ubuntu/linux上安装mysql-python时,如何修复\“ mysql_config \”错误?mysql-python安装错误:“ mysql_config找不到”“ 由于缺少MySQL开发库而出现此错误。解决此问题,建议在Ubuntu上使用该分发的存储库。使用以下命令安装Python-MysqldB: sudo apt-get安装python-mysqldb sudo pip in...编程 发布于2025-04-19 -

如何同步迭代并从PHP中的两个等级阵列打印值?同步的迭代和打印值来自相同大小的两个数组使用两个数组相等大小的selectbox时,一个包含country代码的数组,另一个包含乡村代码,另一个包含其相应名称的数组,可能会因不当提供了exply for for for the uncore for the forsion for for ytry...编程 发布于2025-04-19

如何同步迭代并从PHP中的两个等级阵列打印值?同步的迭代和打印值来自相同大小的两个数组使用两个数组相等大小的selectbox时,一个包含country代码的数组,另一个包含乡村代码,另一个包含其相应名称的数组,可能会因不当提供了exply for for for the uncore for the forsion for for ytry...编程 发布于2025-04-19 -

您可以使用CSS在Chrome和Firefox中染色控制台输出吗?在javascript console 中显示颜色是可以使用chrome的控制台显示彩色文本,例如红色的redors,for for for for错误消息?回答是的,可以使用CSS将颜色添加到Chrome和Firefox中的控制台显示的消息(版本31或更高版本)中。要实现这一目标,请使用以下模...编程 发布于2025-04-19

您可以使用CSS在Chrome和Firefox中染色控制台输出吗?在javascript console 中显示颜色是可以使用chrome的控制台显示彩色文本,例如红色的redors,for for for for错误消息?回答是的,可以使用CSS将颜色添加到Chrome和Firefox中的控制台显示的消息(版本31或更高版本)中。要实现这一目标,请使用以下模...编程 发布于2025-04-19 -

Java开发者如何保护数据库凭证免受反编译?在java 在单独的配置文件保护数据库凭证的最有效方法中存储凭据是将它们存储在单独的配置文件中。该文件可以在运行时加载,从而使登录数据从编译的二进制文件中远离。使用prevereness class import java.util.prefs.preferences; 公共类示例{ 首选项...编程 发布于2025-04-19

Java开发者如何保护数据库凭证免受反编译?在java 在单独的配置文件保护数据库凭证的最有效方法中存储凭据是将它们存储在单独的配置文件中。该文件可以在运行时加载,从而使登录数据从编译的二进制文件中远离。使用prevereness class import java.util.prefs.preferences; 公共类示例{ 首选项...编程 发布于2025-04-19 -

如何使用组在MySQL中旋转数据?在关系数据库中使用mySQL组使用mySQL组进行查询结果,在关系数据库中使用MySQL组,转移数据的数据是指重新排列的行和列的重排以增强数据可视化。在这里,我们面对一个共同的挑战:使用组的组将数据从基于行的基于列的转换为基于列。让我们考虑以下查询: select data d.data_ti...编程 发布于2025-04-19

如何使用组在MySQL中旋转数据?在关系数据库中使用mySQL组使用mySQL组进行查询结果,在关系数据库中使用MySQL组,转移数据的数据是指重新排列的行和列的重排以增强数据可视化。在这里,我们面对一个共同的挑战:使用组的组将数据从基于行的基于列的转换为基于列。让我们考虑以下查询: select data d.data_ti...编程 发布于2025-04-19 -

如何正确使用与PDO参数的查询一样?在pdo 中使用类似QUERIES在PDO中的Queries时,您可能会遇到类似疑问中描述的问题:此查询也可能不会返回结果,即使$ var1和$ var2包含有效的搜索词。错误在于不正确包含%符号。通过将变量包含在$ params数组中的%符号中,您确保将%字符正确替换到查询中。没有此修改,PDO...编程 发布于2025-04-19

如何正确使用与PDO参数的查询一样?在pdo 中使用类似QUERIES在PDO中的Queries时,您可能会遇到类似疑问中描述的问题:此查询也可能不会返回结果,即使$ var1和$ var2包含有效的搜索词。错误在于不正确包含%符号。通过将变量包含在$ params数组中的%符号中,您确保将%字符正确替换到查询中。没有此修改,PDO...编程 发布于2025-04-19 -

为什么我会收到MySQL错误#1089:错误的前缀密钥?mySQL错误#1089:错误的前缀键错误descript [#1089-不正确的前缀键在尝试在表中创建一个prefix键时会出现。前缀键旨在索引字符串列的特定前缀长度长度,可以更快地搜索这些前缀。了解prefix keys `这将在整个Movie_ID列上创建标准主键。主密钥对于唯一识别...编程 发布于2025-04-19

为什么我会收到MySQL错误#1089:错误的前缀密钥?mySQL错误#1089:错误的前缀键错误descript [#1089-不正确的前缀键在尝试在表中创建一个prefix键时会出现。前缀键旨在索引字符串列的特定前缀长度长度,可以更快地搜索这些前缀。了解prefix keys `这将在整个Movie_ID列上创建标准主键。主密钥对于唯一识别...编程 发布于2025-04-19 -

如何使用node-mysql在单个查询中执行多个SQL语句?在node-mysql node-mysql文档最初出于安全原因最初禁用多个语句支持,因为它可能导致SQL注入攻击。要启用此功能,您需要在创建连接时将倍增设置设置为true: var connection = mysql.createconnection({{multipleStatement:...编程 发布于2025-04-19

如何使用node-mysql在单个查询中执行多个SQL语句?在node-mysql node-mysql文档最初出于安全原因最初禁用多个语句支持,因为它可能导致SQL注入攻击。要启用此功能,您需要在创建连接时将倍增设置设置为true: var connection = mysql.createconnection({{multipleStatement:...编程 发布于2025-04-19 -

在PHP中如何高效检测空数组?在PHP 中检查一个空数组可以通过各种方法在PHP中确定一个空数组。如果需要验证任何数组元素的存在,则PHP的松散键入允许对数组本身进行直接评估:一种更严格的方法涉及使用count()函数: if(count(count($ playerList)=== 0){ //列表为空。 } 对...编程 发布于2025-04-19

在PHP中如何高效检测空数组?在PHP 中检查一个空数组可以通过各种方法在PHP中确定一个空数组。如果需要验证任何数组元素的存在,则PHP的松散键入允许对数组本身进行直接评估:一种更严格的方法涉及使用count()函数: if(count(count($ playerList)=== 0){ //列表为空。 } 对...编程 发布于2025-04-19

学习中文

- 1 走路用中文怎么说?走路中文发音,走路中文学习

- 2 坐飞机用中文怎么说?坐飞机中文发音,坐飞机中文学习

- 3 坐火车用中文怎么说?坐火车中文发音,坐火车中文学习

- 4 坐车用中文怎么说?坐车中文发音,坐车中文学习

- 5 开车用中文怎么说?开车中文发音,开车中文学习

- 6 游泳用中文怎么说?游泳中文发音,游泳中文学习

- 7 骑自行车用中文怎么说?骑自行车中文发音,骑自行车中文学习

- 8 你好用中文怎么说?你好中文发音,你好中文学习

- 9 谢谢用中文怎么说?谢谢中文发音,谢谢中文学习

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning