Golang:可觀察性和分析如何揭示幾乎無法偵測到的節流

在 Go 的个人项目中,该项目从 Bovespa 获取金融资产信息。

该系统充分利用了 goroutine 的并发性和并行性,每 8 秒更新一次资产信息(以及业务计算)。

最初,没有出现错误或警告,但我注意到一些 goroutine 的执行时间比其他 goroutine 更长。

更具体地说,虽然p99时间为0.03 ms,但在某些时候,它增加到0.9 ms。这促使我进一步调查这个问题。

我发现我使用的是信号量 goroutine 池,它是基于 GOMAXPROCS 变量创建的。

然而,我意识到这种方法有一个问题。

当我们使用 GOMAXPROCS 变量时,它无法正确捕获容器中可用的核心数量。如果容器的可用核心数少于 VM 的总数,则它会考虑 VM 的总数。例如,我的虚拟机有 8 个可用核心,但容器只有 4 个。这导致创建 8 个 goroutine 同时运行,导致限制。

经过一夜的大量研究,我发现 Uber 开发的一个库可以更有效地自动调整 GOMAXPROCS 变量,无论它是否在容器中。事实证明,该解决方案极其稳定且高效:automaxprocs

优步Go

/

自动最大进程

优步Go

/

自动最大进程

自动设置 GOMAXPROCS 以匹配 Linux 容器 CPU 配额。

automaxprocs

自动设置 GOMAXPROCS 以匹配 Linux 容器 CPU 配额。

安装

go get -u go.uber.org/automaxprocs

快速入门

import _ "go.uber.org/automaxprocs"

func main() {

// Your application logic here.

}

表现

数据来自 Uber 的内部负载均衡器。我们以 200% CPU 配额(即 2 个核心)运行负载均衡器:

| GOMAXPROCS | RPS | P50(毫秒) | P99.9(毫秒) |

|---|---|---|---|

| 1 | 28,893.18 | 1.46 | 19.70 |

| 2(等于配额) | 44,715.07 | 0.84 | 26.38 |

| 3 | 44,212.93 | 0.66 | 30.07 |

| 4 | 41,071.15 | 0.57 | 42.94 |

| 8 | 33,111.69 | 0.43 | 64.32 |

| 默认 (24) | 22,191.40 | 0.45 | 76.19 |

当 GOMAXPROCS 增加到 CPU 配额以上时,我们看到 P50 略有下降,但看到 P99 显着增加。我们还看到处理的总 RPS 也在下降。

当 GOMAXPROCS 高于分配的 CPU 配额时,我们还看到了明显的限制:

$ cat /sys/fs/cgroup/cpu,cpuacct/system.slice/[...]/cpu.stat nr_periods 42227334 nr_throttled 131923 throttled_time 88613212216618

一旦 GOMAXPROCS 减少到与 CPU 配额相匹配,我们就没有看到 CPU 限制。

使用该库后,问题得到解决,现在p99时间一直保持在0.02ms。这一经验强调了并发系统中可观察性和分析的重要性。

以下是一个非常简单的示例,但展示了性能差异。

使用Go的原生测试和benckmak包,我创建了两个文件:

benchmarking_with_enhancement_test.go:

package main

import (

_ "go.uber.org/automaxprocs"

"runtime"

"sync"

"testing"

)

// BenchmarkWithEnhancement Função com melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

benchmarking_without_enhancement_test.go:

package main

import (

"runtime"

"sync"

"testing"

)

// BenchmarkWithoutEnhancement Função sem a melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithoutEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

它们之间的区别是使用Uber库导入。

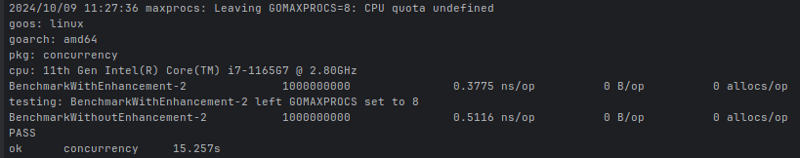

假设使用 2 个 CPU 运行基准测试时,结果是:

ns/op:提供执行特定操作所需时间的平均值(以纳秒为单位)。

请注意,我的 CPU 的可用总数为 8 个核心,这就是 runtime.NumCPU() 属性返回的值。然而,在运行基准测试时,我定义只使用两个 CPU,而没有使用 automaxprocs 的文件定义一次执行限制为 8 个 goroutine,而最高效的为 2 个,因为这样使用更少的分配可以使执行更加高效。

因此,我们的应用程序的可观察性和分析的重要性是显而易见的。

-

版本5.6.5之前,使用current_timestamp與時間戳列的current_timestamp與時間戳列有什麼限制?在時間戳列上使用current_timestamp或MySQL版本中的current_timestamp或在5.6.5 此限制源於遺留實現的關注,這些限制需要對當前的_timestamp功能進行特定的實現。 創建表`foo`( `Productid` int(10)unsigned not ...程式設計 發佈於2025-03-12

版本5.6.5之前,使用current_timestamp與時間戳列的current_timestamp與時間戳列有什麼限制?在時間戳列上使用current_timestamp或MySQL版本中的current_timestamp或在5.6.5 此限制源於遺留實現的關注,這些限制需要對當前的_timestamp功能進行特定的實現。 創建表`foo`( `Productid` int(10)unsigned not ...程式設計 發佈於2025-03-12 -

為什麼儘管有效代碼,為什麼在PHP中捕獲輸入?在php ;?>" method="post">The intention is to capture the input from the text box and display it when the submit button is clicked.但是,輸出...程式設計 發佈於2025-03-12

為什麼儘管有效代碼,為什麼在PHP中捕獲輸入?在php ;?>" method="post">The intention is to capture the input from the text box and display it when the submit button is clicked.但是,輸出...程式設計 發佈於2025-03-12 -

如何使用FormData()處理多個文件上傳?)處理多個文件輸入時,通常需要處理多個文件上傳時,通常是必要的。 The fd.append("fileToUpload[]", files[x]); method can be used for this purpose, allowing you to send multi...程式設計 發佈於2025-03-12

如何使用FormData()處理多個文件上傳?)處理多個文件輸入時,通常需要處理多個文件上傳時,通常是必要的。 The fd.append("fileToUpload[]", files[x]); method can be used for this purpose, allowing you to send multi...程式設計 發佈於2025-03-12 -

\“(1)vs.(;;):編譯器優化是否消除了性能差異?\”答案: 在大多數現代編譯器中,while(1)和(1)和(;;)之間沒有性能差異。編譯器: perl: 1 輸入 - > 2 2 NextState(Main 2 -E:1)V-> 3 9 Leaveloop VK/2-> A 3 toterloop(next-> 8 last-> 9 ...程式設計 發佈於2025-03-12

\“(1)vs.(;;):編譯器優化是否消除了性能差異?\”答案: 在大多數現代編譯器中,while(1)和(1)和(;;)之間沒有性能差異。編譯器: perl: 1 輸入 - > 2 2 NextState(Main 2 -E:1)V-> 3 9 Leaveloop VK/2-> A 3 toterloop(next-> 8 last-> 9 ...程式設計 發佈於2025-03-12 -

如何使用PHP從XML文件中有效地檢索屬性值?從php $xml = simplexml_load_file($file); foreach ($xml->Var[0]->attributes() as $attributeName => $attributeValue) { echo $attributeName,...程式設計 發佈於2025-03-12

如何使用PHP從XML文件中有效地檢索屬性值?從php $xml = simplexml_load_file($file); foreach ($xml->Var[0]->attributes() as $attributeName => $attributeValue) { echo $attributeName,...程式設計 發佈於2025-03-12 -

如何修復\“常規錯誤:2006 MySQL Server在插入數據時已經消失\”?How to Resolve "General error: 2006 MySQL server has gone away" While Inserting RecordsIntroduction:Inserting data into a MySQL database can...程式設計 發佈於2025-03-12

如何修復\“常規錯誤:2006 MySQL Server在插入數據時已經消失\”?How to Resolve "General error: 2006 MySQL server has gone away" While Inserting RecordsIntroduction:Inserting data into a MySQL database can...程式設計 發佈於2025-03-12 -

我可以將加密從McRypt遷移到OpenSSL,並使用OpenSSL遷移MCRYPT加密數據?將我的加密庫從mcrypt升級到openssl 問題:是否可以將我的加密庫從McRypt升級到OpenSSL?如果是這樣,如何? 答案:是的,可以將您的Encryption庫從McRypt升級到OpenSSL。 可以使用openssl。 附加說明: [openssl_decrypt()函數要求...程式設計 發佈於2025-03-12

我可以將加密從McRypt遷移到OpenSSL,並使用OpenSSL遷移MCRYPT加密數據?將我的加密庫從mcrypt升級到openssl 問題:是否可以將我的加密庫從McRypt升級到OpenSSL?如果是這樣,如何? 答案:是的,可以將您的Encryption庫從McRypt升級到OpenSSL。 可以使用openssl。 附加說明: [openssl_decrypt()函數要求...程式設計 發佈於2025-03-12 -

為什麼使用固定定位時,為什麼具有100%網格板柱的網格超越身體?網格超過身體,用100%grid-template-columns 為什麼在grid-template-colms中具有100%的顯示器,當位置設置為設置的位置時,grid-template-colly修復了? 問題: 考慮以下CSS和html: class =“ snippet-code”> ...程式設計 發佈於2025-03-12

為什麼使用固定定位時,為什麼具有100%網格板柱的網格超越身體?網格超過身體,用100%grid-template-columns 為什麼在grid-template-colms中具有100%的顯示器,當位置設置為設置的位置時,grid-template-colly修復了? 問題: 考慮以下CSS和html: class =“ snippet-code”> ...程式設計 發佈於2025-03-12 -

如何使用不同數量列的聯合數據庫表?合併列數不同的表 當嘗試合併列數不同的數據庫表時,可能會遇到挑戰。一種直接的方法是在列數較少的表中,為缺失的列追加空值。 例如,考慮兩個表,表 A 和表 B,其中表 A 的列數多於表 B。為了合併這些表,同時處理表 B 中缺失的列,請按照以下步驟操作: 確定表 B 中缺失的列,並將它們添加到表的...程式設計 發佈於2025-03-12

如何使用不同數量列的聯合數據庫表?合併列數不同的表 當嘗試合併列數不同的數據庫表時,可能會遇到挑戰。一種直接的方法是在列數較少的表中,為缺失的列追加空值。 例如,考慮兩個表,表 A 和表 B,其中表 A 的列數多於表 B。為了合併這些表,同時處理表 B 中缺失的列,請按照以下步驟操作: 確定表 B 中缺失的列,並將它們添加到表的...程式設計 發佈於2025-03-12 -

為什麼PYTZ最初顯示出意外的時區偏移?與pytz 最初從pytz獲得特定的偏移。例如,亞洲/hong_kong最初顯示一個七個小時37分鐘的偏移: 差異源利用本地化將時區分配給日期,使用了適當的時區名稱和偏移量。但是,直接使用DateTime構造器分配時區不允許進行正確的調整。 example pytz.timezone(&#...程式設計 發佈於2025-03-12

為什麼PYTZ最初顯示出意外的時區偏移?與pytz 最初從pytz獲得特定的偏移。例如,亞洲/hong_kong最初顯示一個七個小時37分鐘的偏移: 差異源利用本地化將時區分配給日期,使用了適當的時區名稱和偏移量。但是,直接使用DateTime構造器分配時區不允許進行正確的調整。 example pytz.timezone(&#...程式設計 發佈於2025-03-12 -

為什麼不使用CSS`content'屬性顯示圖像?在Firefox extemers屬性為某些圖像很大,&& && && &&華倍華倍[華氏華倍華氏度]很少見,卻是某些瀏覽屬性很少,尤其是特定於Firefox的某些瀏覽器未能在使用內容屬性引用時未能顯示圖像的情況。這可以在提供的CSS類中看到:。 googlepic { 內容:url(&...程式設計 發佈於2025-03-12

為什麼不使用CSS`content'屬性顯示圖像?在Firefox extemers屬性為某些圖像很大,&& && && &&華倍華倍[華氏華倍華氏度]很少見,卻是某些瀏覽屬性很少,尤其是特定於Firefox的某些瀏覽器未能在使用內容屬性引用時未能顯示圖像的情況。這可以在提供的CSS類中看到:。 googlepic { 內容:url(&...程式設計 發佈於2025-03-12 -

如何在Java字符串中有效替換多個子字符串?在java 中有效地替換多個substring,需要在需要替換一個字符串中的多個substring的情況下,很容易求助於重複應用字符串的刺激力量。 However, this can be inefficient for large strings or when working with nu...程式設計 發佈於2025-03-12

如何在Java字符串中有效替換多個子字符串?在java 中有效地替換多個substring,需要在需要替換一個字符串中的多個substring的情況下,很容易求助於重複應用字符串的刺激力量。 However, this can be inefficient for large strings or when working with nu...程式設計 發佈於2025-03-12 -

如何克服PHP的功能重新定義限制?克服PHP的函數重新定義限制在PHP中,多次定義一個相同名稱的函數是一個no-no。嘗試這樣做,如提供的代碼段所示,將導致可怕的“不能重新列出”錯誤。 但是,PHP工具腰帶中有一個隱藏的寶石:runkit擴展。它使您能夠靈活地重新定義函數。 runkit_function_renction_...程式設計 發佈於2025-03-12

如何克服PHP的功能重新定義限制?克服PHP的函數重新定義限制在PHP中,多次定義一個相同名稱的函數是一個no-no。嘗試這樣做,如提供的代碼段所示,將導致可怕的“不能重新列出”錯誤。 但是,PHP工具腰帶中有一個隱藏的寶石:runkit擴展。它使您能夠靈活地重新定義函數。 runkit_function_renction_...程式設計 發佈於2025-03-12 -

如何用Laravel雄辯地結合結果?使用Laravel Eloquent Question:How can we limit the results with Eloquent?Answer:In older versions of Laravel, you can use a combination of the take() a...程式設計 發佈於2025-03-12

如何用Laravel雄辯地結合結果?使用Laravel Eloquent Question:How can we limit the results with Eloquent?Answer:In older versions of Laravel, you can use a combination of the take() a...程式設計 發佈於2025-03-12 -

如何限制動態大小的父元素中元素的滾動範圍?在交互式接口中實現垂直滾動元素的CSS高度限制問題:考慮一個佈局,其中我們具有與用戶垂直滾動一起移動的可滾動地圖div,同時與固定的固定sidebar保持一致。但是,地圖的滾動無限期擴展,超過了視口的高度,阻止用戶訪問頁面頁腳。 $("#map").css({ margin...程式設計 發佈於2025-03-12

如何限制動態大小的父元素中元素的滾動範圍?在交互式接口中實現垂直滾動元素的CSS高度限制問題:考慮一個佈局,其中我們具有與用戶垂直滾動一起移動的可滾動地圖div,同時與固定的固定sidebar保持一致。但是,地圖的滾動無限期擴展,超過了視口的高度,阻止用戶訪問頁面頁腳。 $("#map").css({ margin...程式設計 發佈於2025-03-12

學習中文

- 1 走路用中文怎麼說? 走路中文發音,走路中文學習

- 2 坐飛機用中文怎麼說? 坐飞机中文發音,坐飞机中文學習

- 3 坐火車用中文怎麼說? 坐火车中文發音,坐火车中文學習

- 4 坐車用中文怎麼說? 坐车中文發音,坐车中文學習

- 5 開車用中文怎麼說? 开车中文發音,开车中文學習

- 6 游泳用中文怎麼說? 游泳中文發音,游泳中文學習

- 7 騎自行車用中文怎麼說? 骑自行车中文發音,骑自行车中文學習

- 8 你好用中文怎麼說? 你好中文發音,你好中文學習

- 9 謝謝用中文怎麼說? 谢谢中文發音,谢谢中文學習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning