титульная страница > программирование > Итак, как же снова работают запросы на включение? экранное меню №3

титульная страница > программирование > Итак, как же снова работают запросы на включение? экранное меню №3

Итак, как же снова работают запросы на включение? экранное меню №3

В моем предыдущем посте я говорил о запуске терминального приложения с открытым исходным кодом на базе GenAI. На этой неделе задачей было добавить новую функцию в проект другого пользователя. Поскольку нам пришлось сотрудничать с кем-то новым, я объединился с Лили, которая разработала приложение с функциями улучшения кода, похожими на мои, но у нее есть крысиный образ!

Если у вас будет время, не стесняйтесь взглянуть на ее проект-крысу-помощницу.

Ее код написан на TypeScript, и, честно говоря, у меня не так уж много опыта в этом. Я немного беспокоился о том, чтобы добавить новые функции, чтобы случайно ничего не сломать. Забавно: TypeScript кажется мне гораздо сложнее по сравнению с другими ООП-языками, такими как Java или C. Но я решил, что это хорошая возможность для обучения, поэтому решил погрузиться в это дело.

Нашей целью было добавить новую опцию (-t) для отображения использования токена как для ответа, так и для приглашения. Итак, я начал с открытия проблемы в ее репозитории, чтобы описать эту функцию, а затем форкнул проект для локальной работы.

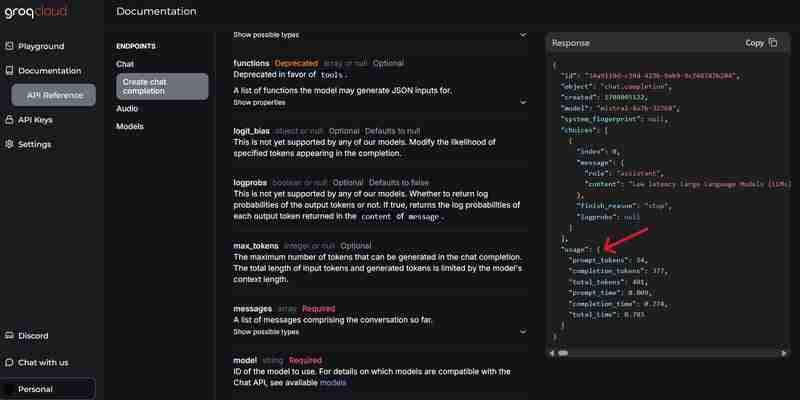

Приложение использовало GROQ API для своих функций LLM, и, к счастью, существовал простой способ получить доступ к информации об использовании токена через поле «использование» в ответе API:

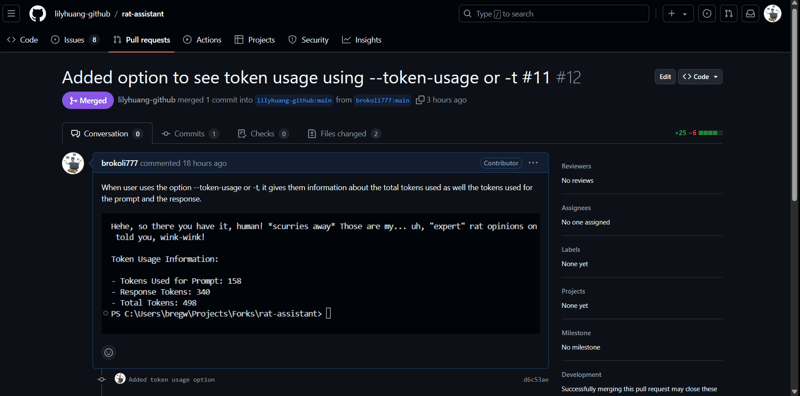

Поскольку приложение использовало yargs для аргументов командной строки, добавить еще один параметр было довольно просто. Я сделал так, чтобы, если пользователь указывал -t или --token-usage, приложение отображало информацию о токене в конце вывода вместе с ответом AI. Я протестировал его несколько раз и убедился, что он не нарушает существующие функции. Когда это было подтверждено, код был отправлен на мою вилку, и я сделал запрос на включение.

Прошло много времени с тех пор, как я делал запрос на включение, поэтому я быстро погуглил команды и обнаружил, что есть простой способ сделать это через VS Code (серьезно, где бы я был без него?).

Я добавил краткое описание новой функции и отправил запрос на включение:

Именно тогда пару часов назад я увидел уведомление о запросе на включение Лили в моем репозитории. Я быстро проверил код, протестировал его локально, и он отлично сработал! Я проверил, есть ли какие-либо проблемы с другими вариантами, и их не было. Я использовал API Gemini, поэтому он отличался от API завершения чата Open AI, обычно используемого другими, но ей все же удалось заставить его работать.

Я не нашел никаких проблем или улучшений, которые можно было бы предложить, поэтому принял ее запрос на включение и объединил его с основной веткой. Было очень весело (и нервно), когда кто-то внес свой вклад в ваш код, потому что вы не знаете, чего ожидать и возникнут ли у него проблемы из-за вашего рунического кода.

Но в итоге все прошло гладко, и это заставило меня оценить, как крупные проекты с открытым исходным кодом сотрудничают и асинхронно совершенствуются с помощью запросов на включение.

-

Причины и решения для сбоя обнаружения лица: ошибка -215обработка ошибок: разрешение «ошибка: (-215)! Empty () в функции DetectMultiscale" в OpenCV при попытке использовать метод DeTectMultisca...программирование Опубликовано в 2025-04-18

Причины и решения для сбоя обнаружения лица: ошибка -215обработка ошибок: разрешение «ошибка: (-215)! Empty () в функции DetectMultiscale" в OpenCV при попытке использовать метод DeTectMultisca...программирование Опубликовано в 2025-04-18 -

PHP Simplexml SAINGING XML Метод с пространством имен толстой кишкиparsing xml с пространством именами Colons в PHP Simplexml столкнулся с трудностями при разборе XML, содержащих теги Colons, такие как элемент...программирование Опубликовано в 2025-04-18

PHP Simplexml SAINGING XML Метод с пространством имен толстой кишкиparsing xml с пространством именами Colons в PHP Simplexml столкнулся с трудностями при разборе XML, содержащих теги Colons, такие как элемент...программирование Опубликовано в 2025-04-18 -

Как создать динамические переменные в Python?динамическое создание переменной в Python способность создавать переменные динамически может быть мощным инструментом, особенно при работе со ...программирование Опубликовано в 2025-04-18

Как создать динамические переменные в Python?динамическое создание переменной в Python способность создавать переменные динамически может быть мощным инструментом, особенно при работе со ...программирование Опубликовано в 2025-04-18 -

Как ограничить диапазон прокрутки элемента в родительском элементе динамического размера?реализация пределов высоты CSS для вертикальных элементов прокрутки В интерактивном интерфейсе, контроль над поведением прокрутки элементов яв...программирование Опубликовано в 2025-04-18

Как ограничить диапазон прокрутки элемента в родительском элементе динамического размера?реализация пределов высоты CSS для вертикальных элементов прокрутки В интерактивном интерфейсе, контроль над поведением прокрутки элементов яв...программирование Опубликовано в 2025-04-18 -

Почему ввод запроса в POST Захват в PHP, несмотря на действительный код?addressing post запрос неисправность в php в представленном фрагменте кода: action='' intement. Вход из нагламента на нажим. Однако выход ...программирование Опубликовано в 2025-04-18

Почему ввод запроса в POST Захват в PHP, несмотря на действительный код?addressing post запрос неисправность в php в представленном фрагменте кода: action='' intement. Вход из нагламента на нажим. Однако выход ...программирование Опубликовано в 2025-04-18 -

Эффективный метод проверки для струн Java, которые не являются пустыми и не нулевыми, если строка не является нулевой и не пустой , чтобы определить, не является ли строка не нулевой и не пустой, Java предоставляет различные мет...программирование Опубликовано в 2025-04-18

Эффективный метод проверки для струн Java, которые не являются пустыми и не нулевыми, если строка не является нулевой и не пустой , чтобы определить, не является ли строка не нулевой и не пустой, Java предоставляет различные мет...программирование Опубликовано в 2025-04-18 -

Решить ошибку MySQL 1153: Пакет превышает лимит MAX_ALLYED_PACKET 'mysql Ошибка 1153: Устранение неполадок Давайте углубимся в виновника и исследуем решения для исправления этой проблемы. понимание ошибки Э...программирование Опубликовано в 2025-04-18

Решить ошибку MySQL 1153: Пакет превышает лимит MAX_ALLYED_PACKET 'mysql Ошибка 1153: Устранение неполадок Давайте углубимся в виновника и исследуем решения для исправления этой проблемы. понимание ошибки Э...программирование Опубликовано в 2025-04-18 -

Причины CodeIgniter подключиться к базе данных MySQL после перехода на MySQLIневозможно подключиться к базе данных MySQL: Сообщение об ошибке устранения неисправностей При попытке переключиться с драйвера MySQL к вашему...программирование Опубликовано в 2025-04-18

Причины CodeIgniter подключиться к базе данных MySQL после перехода на MySQLIневозможно подключиться к базе данных MySQL: Сообщение об ошибке устранения неисправностей При попытке переключиться с драйвера MySQL к вашему...программирование Опубликовано в 2025-04-18 -

Как я могу эффективно генерировать удобные для URL слизняки из строк Unicode в PHP?создание функции для эффективной генерации Slug Создание слизняков, упрощенные представления строк Unicode, используемые в URL, может быть сло...программирование Опубликовано в 2025-04-18

Как я могу эффективно генерировать удобные для URL слизняки из строк Unicode в PHP?создание функции для эффективной генерации Slug Создание слизняков, упрощенные представления строк Unicode, используемые в URL, может быть сло...программирование Опубликовано в 2025-04-18 -

Почему выполнение JavaScript прекращается при использовании кнопки Firefox Back?Проблема истории навигации: Javascript перестает выполнять после использования кнопки Firefox Back пользователи Firefox могут столкнуться с пр...программирование Опубликовано в 2025-04-18

Почему выполнение JavaScript прекращается при использовании кнопки Firefox Back?Проблема истории навигации: Javascript перестает выполнять после использования кнопки Firefox Back пользователи Firefox могут столкнуться с пр...программирование Опубликовано в 2025-04-18 -

Как создать плавную анимацию CSS в левом правом для Div в его контейнере?generic css анимация для левого правого движения В этой статье мы рассмотрим создание общей анимации CSS, чтобы переместить дивирование влево ...программирование Опубликовано в 2025-04-18

Как создать плавную анимацию CSS в левом правом для Div в его контейнере?generic css анимация для левого правого движения В этой статье мы рассмотрим создание общей анимации CSS, чтобы переместить дивирование влево ...программирование Опубликовано в 2025-04-18 -

Можете ли вы использовать CSS для цветной консоли вывода в Chrome и Firefox?отображение цветов в консоли Javascript ] может ли использовать консоль Chrome для отображения цветного текста, такого как красный для ошибок, ...программирование Опубликовано в 2025-04-18

Можете ли вы использовать CSS для цветной консоли вывода в Chrome и Firefox?отображение цветов в консоли Javascript ] может ли использовать консоль Chrome для отображения цветного текста, такого как красный для ошибок, ...программирование Опубликовано в 2025-04-18 -

Как эффективно повторить строковые символы для вдавления в C#?повторяя строку для вдавления , когда обрабатывает строку, основанную на глубине элемента, удобно иметь эффективный способ вернуть строку, повт...программирование Опубликовано в 2025-04-18

Как эффективно повторить строковые символы для вдавления в C#?повторяя строку для вдавления , когда обрабатывает строку, основанную на глубине элемента, удобно иметь эффективный способ вернуть строку, повт...программирование Опубликовано в 2025-04-18 -

Как преодолеть ограничения переопределения функций PHP?преодоление ограничений переосмысления функции PHP в PHP, определение функции с одним и тем же именем несколько раз-нет-нет. Попытка сделать э...программирование Опубликовано в 2025-04-18

Как преодолеть ограничения переопределения функций PHP?преодоление ограничений переосмысления функции PHP в PHP, определение функции с одним и тем же именем несколько раз-нет-нет. Попытка сделать э...программирование Опубликовано в 2025-04-18 -

Как эффективно изменить атрибут CSS «: после» псевдоэлемента с использованием jQuery?понимание ограничений псевдо-элементов в jQuery: доступ к ": после" selector в веб-разработке, псевдо-элементы, такие как ": по...программирование Опубликовано в 2025-04-18

Как эффективно изменить атрибут CSS «: после» псевдоэлемента с использованием jQuery?понимание ограничений псевдо-элементов в jQuery: доступ к ": после" selector в веб-разработке, псевдо-элементы, такие как ": по...программирование Опубликовано в 2025-04-18

Изучайте китайский

- 1 Как сказать «гулять» по-китайски? 走路 Китайское произношение, 走路 Изучение китайского языка

- 2 Как сказать «Сесть на самолет» по-китайски? 坐飞机 Китайское произношение, 坐飞机 Изучение китайского языка

- 3 Как сказать «сесть на поезд» по-китайски? 坐火车 Китайское произношение, 坐火车 Изучение китайского языка

- 4 Как сказать «поехать на автобусе» по-китайски? 坐车 Китайское произношение, 坐车 Изучение китайского языка

- 5 Как сказать «Ездить» по-китайски? 开车 Китайское произношение, 开车 Изучение китайского языка

- 6 Как будет плавание по-китайски? 游泳 Китайское произношение, 游泳 Изучение китайского языка

- 7 Как сказать «кататься на велосипеде» по-китайски? 骑自行车 Китайское произношение, 骑自行车 Изучение китайского языка

- 8 Как поздороваться по-китайски? 你好Китайское произношение, 你好Изучение китайского языка

- 9 Как сказать спасибо по-китайски? 谢谢Китайское произношение, 谢谢Изучение китайского языка

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning