титульная страница > программирование > Создание облака Ollama — масштабирование локального вывода в облако

титульная страница > программирование > Создание облака Ollama — масштабирование локального вывода в облако

Создание облака Ollama — масштабирование локального вывода в облако

Ollama — это, прежде всего, оболочка llama.cpp, предназначенная для локальных задач вывода. Обычно это не лучший выбор, если вы ищете передовую производительность или функции, но он имеет свое применение, особенно в средах, где внешние зависимости вызывают беспокойство.

Локальная разработка искусственного интеллекта

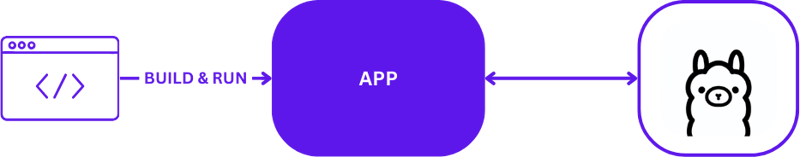

При использовании Ollama для локальной разработки ИИ настройка проста, но эффективна. Разработчики обычно используют Ollama для запуска задач вывода непосредственно на своих локальных компьютерах. Вот визуальное изображение типичной локальной установки разработки с использованием Ollama:

Эта конфигурация позволяет разработчикам быстро тестировать и выполнять итерации без сложностей связи с удаленным сервером. Он идеально подходит для начальных этапов прототипирования и разработки, где скорость выполнения работ имеет решающее значение.

От локального к облаку

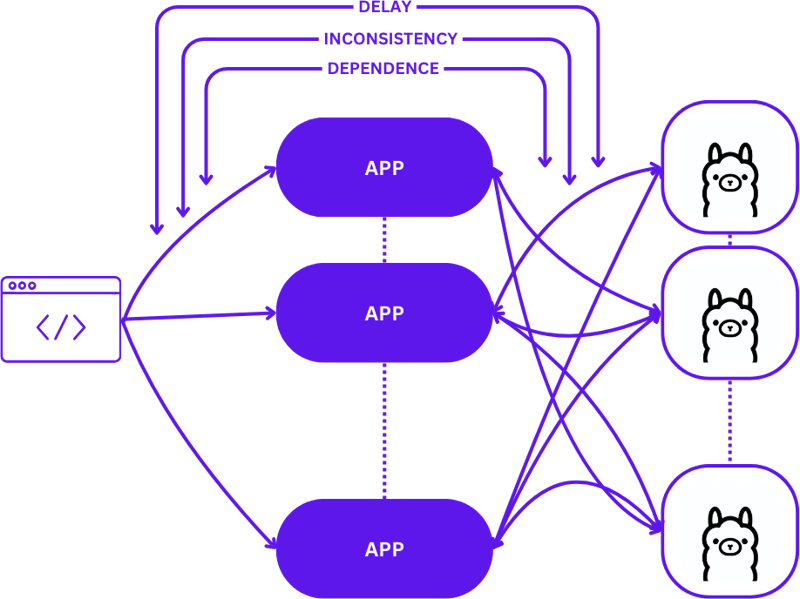

Переход от локальной установки к масштабируемой облачной среде предполагает переход от простой настройки 1:1 (один запрос пользователя к одному хосту вывода) к более сложной конфигурации «многие ко многим» (несколько запросов пользователей к нескольким хостам вывода). . Этот сдвиг необходим для поддержания эффективности и оперативности реагирования по мере роста спроса.

Вот как выглядит это масштабирование при переходе от локальной разработки к производству:

Принятие простого подхода во время этого перехода может значительно повысить сложность приложений, особенно потому, что сеансам необходимо поддерживать согласованность в различных состояниях. Задержки и снижение эффективности могут возникнуть, если запросы не маршрутизируются оптимальным образом на лучший доступный хост вывода.

Более того, сложная природа распределенных приложений затрудняет их локальное тестирование, что может замедлить процесс разработки и увеличить риск сбоев в производственных средах.

Бессерверный

Бессерверные вычисления абстрагируют детали управления сервером и инфраструктурой, позволяя разработчикам сосредоточиться исключительно на коде и бизнес-логике. Отделяя обработку запросов и обеспечение согласованности от приложения, бессерверная архитектура упрощает масштабирование.

Такой подход позволяет приложению сосредоточиться на предоставлении ценности, решая многие распространенные проблемы масштабирования, не обременяя разработчиков сложностями инфраструктуры.

Веб-сборка

WebAssembly (Wasm) решает проблему управления зависимостями, позволяя компилировать приложения в автономные модули. Это упрощает оркестрацию и тестирование приложений как локально, так и в облаке, обеспечивая согласованность в различных средах.

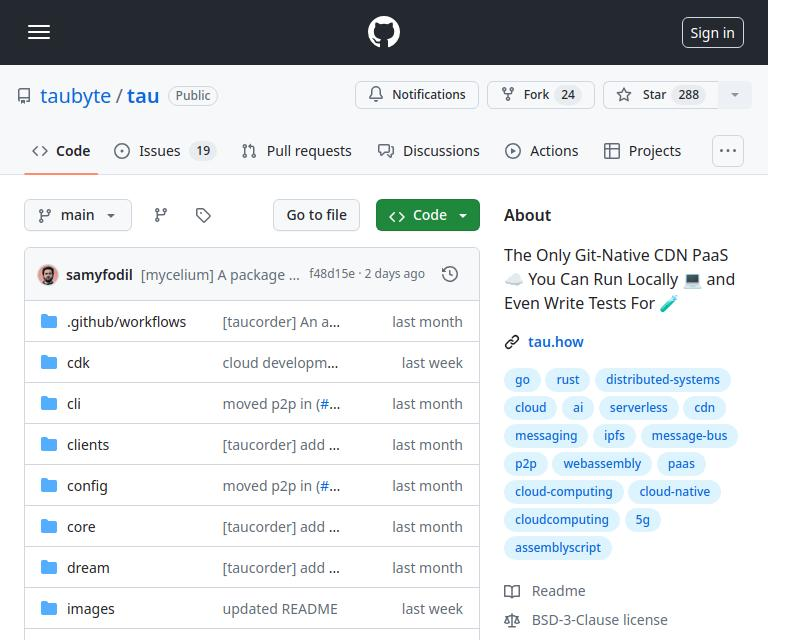

Тау

Tau — это платформа для создания не требующих обслуживания и хорошо масштабируемых платформ облачных вычислений. Он отличается простотой и расширяемостью. Tau упрощает развертывание и поддерживает использование локального облака для разработки, позволяя проводить сквозное (E2E) тестирование как облачной инфраструктуры, так и приложений, работающих в ней.

Этот подход, названный Таубайтом «Локальное кодирование равно глобальному производству», гарантирует, что то, что работает локально, будет работать и глобально, что значительно упрощает процессы разработки и развертывания.

Интеграция Олламы в Тау с помощью системы плагинов Orbit

Система плагинов Tau, известная как Orbit, значительно упрощает превращение сервисов в управляемые компоненты, заключая их в хост-модули WebAssembly. Такой подход позволяет Тау взять на себя обязанности по оркестрации, оптимизируя процесс развертывания и управления.

Экспорт функций в Ollama

Чтобы сделать функции Ollama доступными в экосистеме Тау, мы используем систему Orbit для экспорта возможностей Ollama в качестве вызываемых конечных точек. Вот как вы можете экспортировать конечную точку в Go:

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

Простой пример экспорта функций можно найти в примере hello_world.

После определения эти функции, которые теперь вызываются через спутник.Экспорт, обеспечивают плавную интеграцию Олламы в среду Тау:

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

Написание тестов для плагина Ollama

Тестирование плагина является простым и понятным. Вот как можно написать бессерверный функциональный тест на Go:

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

Используя набор тестов Tau и инструменты Go builder, вы можете создать свой плагин, развернуть его в тестовой среде и выполнить бессерверные функции для проверки функциональности:

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

Код

Полный код можно найти здесь https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/tau

Что дальше?

Теперь вы можете с легкостью создавать приложения LLM. Вот шаги для начала:

- Начните использовать Dream локально: настройте локальную среду для разработки и тестирования вашего приложения.

- Создайте проект: начните новый проект с Тау, чтобы полностью раскрыть его потенциал.

- Создайте свое рабочее облако: разверните свой проект в рабочей облачной среде.

- Поместите двоичный файл плагина в папку /tb/plugins.

- Импортируйте свой проект в рабочую среду

- Выпендриваться!

-

Множествометоды являются FNS, которые можно вызвать на Objects ] Массивы являются объектами, следовательно, они также имеют методы в JS. ] ] Срез (...программирование Опубликовано в 2025-01-31

Множествометоды являются FNS, которые можно вызвать на Objects ] Массивы являются объектами, следовательно, они также имеют методы в JS. ] ] Срез (...программирование Опубликовано в 2025-01-31 -

Объект: обложка не удается в IE и Edge, как исправить?object-fit: cover не удастся в IE и Edge, как исправить? В CSS для поддержания постоянной высоты изображения работает беспрепятственно через брау...программирование Опубликовано в 2025-01-31

Объект: обложка не удается в IE и Edge, как исправить?object-fit: cover не удастся в IE и Edge, как исправить? В CSS для поддержания постоянной высоты изображения работает беспрепятственно через брау...программирование Опубликовано в 2025-01-31 -

Как сортировать данные по длине строки в mySQL с помощью char_length ()?выбор данных по длине строки в mysql для сортировки данных на основе длины строки в mysql, вместо использования string_length (column), рассмо...программирование Опубликовано в 2025-01-31

Как сортировать данные по длине строки в mySQL с помощью char_length ()?выбор данных по длине строки в mysql для сортировки данных на основе длины строки в mysql, вместо использования string_length (column), рассмо...программирование Опубликовано в 2025-01-31 -

Как я могу объединить таблицы базы данных с различным числом столбцов?таблицы с разными номерами объединенных столбцов при попытке таблицы базы данных с различным числом слияний можно столкнуться с проблемами. Прям...программирование Опубликовано в 2025-01-31

Как я могу объединить таблицы базы данных с различным числом столбцов?таблицы с разными номерами объединенных столбцов при попытке таблицы базы данных с различным числом слияний можно столкнуться с проблемами. Прям...программирование Опубликовано в 2025-01-31 -

Почему ввод запроса в POST Захват в PHP, несмотря на действительный код?] адресация адреса запроса в POST в php в представленном фрагменте кода: action='' ] намерение состоит в том, чтобы захватить ввод с текстов...программирование Опубликовано в 2025-01-31

Почему ввод запроса в POST Захват в PHP, несмотря на действительный код?] адресация адреса запроса в POST в php в представленном фрагменте кода: action='' ] намерение состоит в том, чтобы захватить ввод с текстов...программирование Опубликовано в 2025-01-31 -

Как отправить файлы пользователям с PHP -сервера?отправить файл пользователю , когда пользователь взаимодействует со скриптом PHP, вы можете встретить сценарии, где вам нужно передавать файл, ...программирование Опубликовано в 2025-01-31

Как отправить файлы пользователям с PHP -сервера?отправить файл пользователю , когда пользователь взаимодействует со скриптом PHP, вы можете встретить сценарии, где вам нужно передавать файл, ...программирование Опубликовано в 2025-01-31 -

Как динамически установить клавиши в объектах JavaScript?Как создать динамический ключ для переменной объекта Javascript при попытке создать динамический ключ для объекта Javascript, используя этот син...программирование Опубликовано в 2025-01-31

Как динамически установить клавиши в объектах JavaScript?Как создать динамический ключ для переменной объекта Javascript при попытке создать динамический ключ для объекта Javascript, используя этот син...программирование Опубликовано в 2025-01-31 -

Как я могу эффективно заменить несколько подстроков в строке Java?заменить несколько подстроков в строку эффективно в Java , когда сталкивается с необходимостью заменить несколько подстроков в строке, это зама...программирование Опубликовано в 2025-01-31

Как я могу эффективно заменить несколько подстроков в строке Java?заменить несколько подстроков в строку эффективно в Java , когда сталкивается с необходимостью заменить несколько подстроков в строке, это зама...программирование Опубликовано в 2025-01-31 -

Как преодолеть ограничения переопределения функций PHP?преодоление ограничений переосмысления функции PHP в PHP, определение функции с одним и тем же именем несколько раз-нет-нет. Попытка сделать э...программирование Опубликовано в 2025-01-31

Как преодолеть ограничения переопределения функций PHP?преодоление ограничений переосмысления функции PHP в PHP, определение функции с одним и тем же именем несколько раз-нет-нет. Попытка сделать э...программирование Опубликовано в 2025-01-31 -

Могу ли я перенести свой шифрование с McRypt в OpenSSL и расшифровывает данные, заполненные McRypt, используя OpenSSL?Обновление моей библиотеки шифрования с McRypt до OpenSSL Могу ли я обновить свою библиотеку шифрования с McRypt до OpenSSL? В OpenSSL можно л...программирование Опубликовано в 2025-01-31

Могу ли я перенести свой шифрование с McRypt в OpenSSL и расшифровывает данные, заполненные McRypt, используя OpenSSL?Обновление моей библиотеки шифрования с McRypt до OpenSSL Могу ли я обновить свою библиотеку шифрования с McRypt до OpenSSL? В OpenSSL можно л...программирование Опубликовано в 2025-01-31 -

Как разрешить расходы на путь модуля в Go Mod с помощью директивы «Заменить»?. с несоответствием пути между импортированным пакетом GO.MOD и фактическим путем импорта. Это может привести к go mod quicley сбои, как продемонс...программирование Опубликовано в 2025-01-31

Как разрешить расходы на путь модуля в Go Mod с помощью директивы «Заменить»?. с несоответствием пути между импортированным пакетом GO.MOD и фактическим путем импорта. Это может привести к go mod quicley сбои, как продемонс...программирование Опубликовано в 2025-01-31 -

Как снять анонимные обработчики событий JavaScript чисто?] Удаление слушателей анонимных событий Добавление слушателей анонимных событий в элементы обеспечивают гибкость и простоту, но когда пришло врем...программирование Опубликовано в 2025-01-31

Как снять анонимные обработчики событий JavaScript чисто?] Удаление слушателей анонимных событий Добавление слушателей анонимных событий в элементы обеспечивают гибкость и простоту, но когда пришло врем...программирование Опубликовано в 2025-01-31 -

Как я могу эффективно получить значения атрибутов из файлов XML с помощью PHP?получение значений атрибутов из файлов XML в php каждый разработчик сталкивается с необходимостью проанализировать файлы XML и извлекать опред...программирование Опубликовано в 2025-01-31

Как я могу эффективно получить значения атрибутов из файлов XML с помощью PHP?получение значений атрибутов из файлов XML в php каждый разработчик сталкивается с необходимостью проанализировать файлы XML и извлекать опред...программирование Опубликовано в 2025-01-31 -

Как использовать глобальную область в ЛаравелеВ этом уроке я покажу, как использовать глобальную область в Ларавеле. Мы рассмотрим силу глобального масштаба Ларавела, используя практическое п...программирование Опубликовано в 2025-01-31

Как использовать глобальную область в ЛаравелеВ этом уроке я покажу, как использовать глобальную область в Ларавеле. Мы рассмотрим силу глобального масштаба Ларавела, используя практическое п...программирование Опубликовано в 2025-01-31 -

Как правильно вставить Blobs (изображения) в MySQL с помощью PHP?вставьте Blobs в базы данных MySQL с PHP При попытке сохранить изображение в базе данных MySQL, вы можете встретиться с проблема. Это руковод...программирование Опубликовано в 2025-01-31

Как правильно вставить Blobs (изображения) в MySQL с помощью PHP?вставьте Blobs в базы данных MySQL с PHP При попытке сохранить изображение в базе данных MySQL, вы можете встретиться с проблема. Это руковод...программирование Опубликовано в 2025-01-31

Изучайте китайский

- 1 Как сказать «гулять» по-китайски? 走路 Китайское произношение, 走路 Изучение китайского языка

- 2 Как сказать «Сесть на самолет» по-китайски? 坐飞机 Китайское произношение, 坐飞机 Изучение китайского языка

- 3 Как сказать «сесть на поезд» по-китайски? 坐火车 Китайское произношение, 坐火车 Изучение китайского языка

- 4 Как сказать «поехать на автобусе» по-китайски? 坐车 Китайское произношение, 坐车 Изучение китайского языка

- 5 Как сказать «Ездить» по-китайски? 开车 Китайское произношение, 开车 Изучение китайского языка

- 6 Как будет плавание по-китайски? 游泳 Китайское произношение, 游泳 Изучение китайского языка

- 7 Как сказать «кататься на велосипеде» по-китайски? 骑自行车 Китайское произношение, 骑自行车 Изучение китайского языка

- 8 Как поздороваться по-китайски? 你好Китайское произношение, 你好Изучение китайского языка

- 9 Как сказать спасибо по-китайски? 谢谢Китайское произношение, 谢谢Изучение китайского языка

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning