Primeira página > Programação > Construindo um aplicativo RAG com LlamaIndex.ts e Azure OpenAI: primeiros passos!

Primeira página > Programação > Construindo um aplicativo RAG com LlamaIndex.ts e Azure OpenAI: primeiros passos!

Construindo um aplicativo RAG com LlamaIndex.ts e Azure OpenAI: primeiros passos!

À medida que a IA continua a moldar a forma como trabalhamos e interagimos com a tecnologia, muitas empresas procuram formas de aproveitar os seus próprios dados em aplicações inteligentes. Se você já usou ferramentas como ChatGPT ou Azure OpenAI, já sabe como a IA generativa pode melhorar processos e aprimorar as experiências do usuário. Entretanto, para obter respostas verdadeiramente personalizadas e relevantes, seus aplicativos precisam incorporar seus dados proprietários.

É aqui que entra a Geração Aumentada de Recuperação (RAG), fornecendo uma abordagem estruturada para integrar a recuperação de dados com respostas baseadas em IA. Com estruturas como LlamaIndex, você pode facilmente incorporar esse recurso em suas soluções, liberando todo o potencial de seus dados de negócios.

Deseja executar e explorar o aplicativo rapidamente? Clique aqui.

O que é RAG - Geração Aumentada de Recuperação?

Retrieval-Augmented Generation (RAG) é uma estrutura de rede neural que aprimora a geração de texto de IA, incluindo um componente de recuperação para acessar informações relevantes e integrar seus próprios dados. Consiste em duas partes principais:

- Retriever: Um modelo de recuperação denso (por exemplo, baseado em BERT) que pesquisa um grande corpus de documentos para encontrar passagens relevantes ou informações relacionadas a uma determinada consulta.

- Gerador: Um modelo sequência a sequência (por exemplo, baseado em BART ou T5) que recebe a consulta e o texto recuperado como entrada e gera uma resposta coerente e contextualmente enriquecida.

O recuperador encontra documentos relevantes e o gerador os utiliza para criar respostas mais precisas e informativas. Esta combinação permite que o modelo RAG aproveite o conhecimento externo de forma eficaz, melhorando a qualidade e relevância do texto gerado.

Como o LlamaIndex implementa o RAG?

Para implementar um sistema RAG usando LlamaIndex, siga estas etapas gerais:

Ingestão de dados:

- Carregue seus documentos em LlamaIndex.ts usando um carregador de documentos como SimpleDirectoryReader, que ajuda na importação de dados de várias fontes, como PDFs, APIs ou bancos de dados SQL.

- Divida documentos grandes em partes menores e gerenciáveis usando o SentenceSplitter.

Criação de índice:

- Crie um índice vetorial desses pedaços de documentos usando VectorStoreIndex, permitindo pesquisas eficientes de similaridade com base em embeddings.

- Opcionalmente, para conjuntos de dados complexos, use técnicas de recuperação recursivas para gerenciar dados estruturados hierarquicamente e recuperar seções relevantes com base nas consultas do usuário.

Configuração do mecanismo de consulta:

- Converta o índice vetorial em um mecanismo de consulta usando asQueryEngine com parâmetros como similarityTopK para definir quantos documentos principais devem ser recuperados.

- Para configurações mais avançadas, crie um sistema multiagente onde cada agente é responsável por documentos específicos e um agente de nível superior coordena o processo geral de recuperação.

Recuperação e Geração:

- Implemente o pipeline RAG definindo uma função objetivo que recupere partes relevantes do documento com base nas consultas do usuário.

- Use o RetrieverQueryEngine para realizar a recuperação real e o processamento de consultas, com etapas opcionais de pós-processamento, como reclassificar os documentos recuperados usando ferramentas como CohereRerank.

Para um exemplo prático, fornecemos um aplicativo de exemplo para demonstrar uma implementação RAG completa usando Azure OpenAI.

Aplicação prática de amostra RAG

Agora vamos nos concentrar na construção de um aplicativo RAG usando LlamaIndex.ts (a implementação TypeScipt do LlamaIndex) e Azure OpenAI, e implantá-lo como aplicativos Web sem servidor em aplicativos de contêiner do Azure.

Requisitos para executar a amostra

- Azure Developer CLI (azd): uma ferramenta de linha de comando para implantar facilmente todo o seu aplicativo, incluindo back-end, front-end e bancos de dados.

- Conta do Azure: você precisará de uma conta do Azure para implantar o aplicativo. Obtenha uma conta gratuita do Azure com alguns créditos para começar.

Você encontrará o projeto de introdução no GitHub. Recomendamos que você faça um fork deste modelo para poder editá-lo livremente quando necessário:

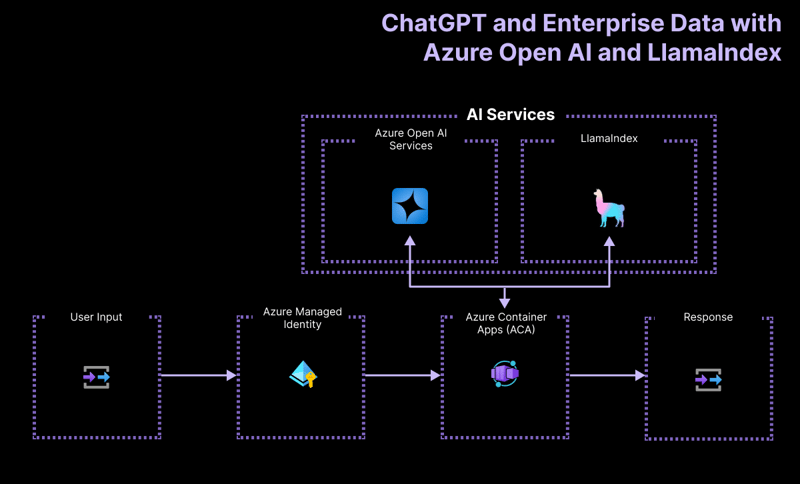

Arquitetura de alto nível

O aplicativo de projeto de introdução é construído com base na seguinte arquitetura:

- Azure OpenAI: o provedor de IA que processa as consultas do usuário.

- LlamaIndex.ts: a estrutura que ajuda a ingerir, transformar e vetorizar conteúdo (PDFs) e criar um índice de pesquisa.

- Aplicativos de contêiner do Azure: o ambiente de contêiner onde o aplicativo sem servidor está hospedado.

- Azure Managed Identity: Garante segurança de alto nível e elimina a necessidade de lidar com credenciais e chaves de API.

Para mais detalhes sobre quais recursos são implantados, verifique a pasta infra disponível em todos os nossos exemplos.

Exemplo de fluxos de trabalho de usuário

O aplicativo de exemplo contém lógica para dois fluxos de trabalho:

-

Ingestão de dados: os dados são buscados, vetorizados e índices de pesquisa são criados. Se você quiser adicionar mais arquivos, como PDFs ou arquivos do Word, é aqui que você deve adicioná-los.

npm run generate

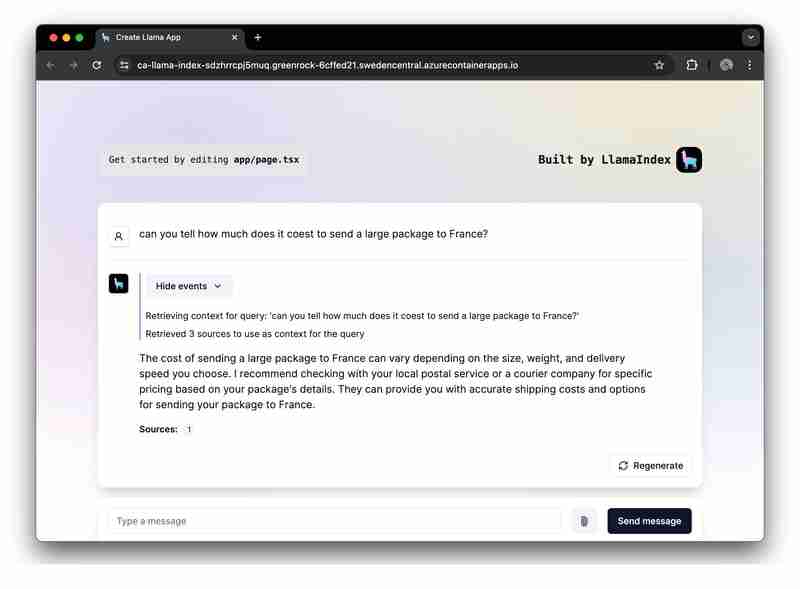

Atendimento de solicitações de prompt: o aplicativo recebe prompts do usuário, os envia para o Azure OpenAI e aumenta esses prompts usando o índice vetorial como um recuperador.

Executando a amostra

Antes de executar o exemplo, certifique-se de ter provisionado os recursos necessários do Azure.

Para executar o modelo GitHub no GitHub Codespace, basta clicar em

Na sua instância do Codespaces, entre na sua conta do Azure, a partir do seu terminal:

azd auth login

Provisione, empacote e implante o aplicativo de exemplo no Azure usando um único comando:

azd up

Para executar e testar o aplicativo localmente, instale as dependências npm e execute o aplicativo:

npm install npm run dev

O aplicativo será executado na porta 3000 em sua instância do Codespaces ou em http://localhost:3000 em seu navegador.

Conclusão

Este guia demonstrou como construir um aplicativo RAG (Retrieval-Augmented Generation) sem servidor usando LlamaIndex.ts e Azure OpenAI, implantado no Microsoft Azure. Ao seguir este guia, você pode aproveitar a infraestrutura do Azure e os recursos do LlamaIndex para criar aplicativos de IA poderosos que fornecem respostas contextualmente enriquecidas com base em seus dados.

Estamos entusiasmados para ver o que você cria com este aplicativo de introdução. Sinta-se à vontade para fazer um fork e curtir o repositório GitHub para receber as atualizações e recursos mais recentes.

-

Revelando se Mysql_real_escape_string pode impedir a injeção de SQLlimitações de mysql_real_escape_string A função MySQL_Real_escape_String no PHP foi criticada por não fornecer uma proteção abrangente contra ...Programação Postado em 2025-04-12

Revelando se Mysql_real_escape_string pode impedir a injeção de SQLlimitações de mysql_real_escape_string A função MySQL_Real_escape_String no PHP foi criticada por não fornecer uma proteção abrangente contra ...Programação Postado em 2025-04-12 -

Como remover emojis das cordas em Python: um guia para iniciantes para corrigir erros comuns?removendo os emojis de strings em python o código Python fornecido para remover emojis falha porque contém syntaxe erros. As cadeias de unicod...Programação Postado em 2025-04-12

Como remover emojis das cordas em Python: um guia para iniciantes para corrigir erros comuns?removendo os emojis de strings em python o código Python fornecido para remover emojis falha porque contém syntaxe erros. As cadeias de unicod...Programação Postado em 2025-04-12 -

Como redirecionar vários tipos de usuários (alunos, professores e administradores) para suas respectivas atividades em um aplicativo Firebase?RED: Como redirecionar vários tipos de usuário para as respectivas atividades compreender o problema e um aplicativo de votamento de que é...Programação Postado em 2025-04-12

Como redirecionar vários tipos de usuários (alunos, professores e administradores) para suas respectivas atividades em um aplicativo Firebase?RED: Como redirecionar vários tipos de usuário para as respectivas atividades compreender o problema e um aplicativo de votamento de que é...Programação Postado em 2025-04-12 -

Você pode usar o CSS para colorir a saída do console no Chrome e no Firefox?exibindo cores no javascript Console é possível usar o console do Chrome para exibir texto colorido, como vermelho para erros, laranja para al...Programação Postado em 2025-04-12

Você pode usar o CSS para colorir a saída do console no Chrome e no Firefox?exibindo cores no javascript Console é possível usar o console do Chrome para exibir texto colorido, como vermelho para erros, laranja para al...Programação Postado em 2025-04-12 -

O Python cria com eficiência arquivos XML: ElementTree, CelementTree ou LXML?como criar arquivos XML em python para criar arquivos xml em python, considere as seguintes opções: elementee (] element) elementTree: ...Programação Postado em 2025-04-12

O Python cria com eficiência arquivos XML: ElementTree, CelementTree ou LXML?como criar arquivos XML em python para criar arquivos xml em python, considere as seguintes opções: elementee (] element) elementTree: ...Programação Postado em 2025-04-12 -

Como posso personalizar otimizações de compilação no compilador Go?personalizando otimizações de compilação no Go Compiler O processo de compilação padrão em Go segue uma estratégia de otimização específica. N...Programação Postado em 2025-04-12

Como posso personalizar otimizações de compilação no compilador Go?personalizando otimizações de compilação no Go Compiler O processo de compilação padrão em Go segue uma estratégia de otimização específica. N...Programação Postado em 2025-04-12 -

Como remover os manipuladores anônimos de eventos JavaScript de maneira limpa?removendo os ouvintes anônimos do evento adicionando ouvintes de eventos anônimos a elementos fornece flexibilidade e simplicidade, mas quando é...Programação Postado em 2025-04-12

Como remover os manipuladores anônimos de eventos JavaScript de maneira limpa?removendo os ouvintes anônimos do evento adicionando ouvintes de eventos anônimos a elementos fornece flexibilidade e simplicidade, mas quando é...Programação Postado em 2025-04-12 -

O Java permite vários tipos de retorno: uma olhada mais próxima dos métodos genéricos?Tipos de retorno múltiplos em java: um equívoco revelado no reino da programação java, e um método peculiar pode surgir, deixando os desenvolv...Programação Postado em 2025-04-12

O Java permite vários tipos de retorno: uma olhada mais próxima dos métodos genéricos?Tipos de retorno múltiplos em java: um equívoco revelado no reino da programação java, e um método peculiar pode surgir, deixando os desenvolv...Programação Postado em 2025-04-12 -

Por que há listras no meu fundo linear de gradiente e como posso consertá -las?banindo as faixas de fundo do gradiente linear Ao empregar a propriedade linear de gradiente para um plano de fundo, você pode encontrar listr...Programação Postado em 2025-04-12

Por que há listras no meu fundo linear de gradiente e como posso consertá -las?banindo as faixas de fundo do gradiente linear Ao empregar a propriedade linear de gradiente para um plano de fundo, você pode encontrar listr...Programação Postado em 2025-04-12 -

Como posso substituir com eficiência várias substringas em uma string java?substituindo várias substâncias em uma string com eficiência em java quando confrontado com a necessidade de substituir várias substringas den...Programação Postado em 2025-04-12

Como posso substituir com eficiência várias substringas em uma string java?substituindo várias substâncias em uma string com eficiência em java quando confrontado com a necessidade de substituir várias substringas den...Programação Postado em 2025-04-12 -

Como posso unindo tabelas de banco de dados com diferentes números de colunas?tabelas combinadas com diferentes colunas ] pode encontrar desafios ao tentar mesclar tabelas de banco de dados com colunas diferentes. Uma man...Programação Postado em 2025-04-12

Como posso unindo tabelas de banco de dados com diferentes números de colunas?tabelas combinadas com diferentes colunas ] pode encontrar desafios ao tentar mesclar tabelas de banco de dados com colunas diferentes. Uma man...Programação Postado em 2025-04-12 -

Como posso iterar de maneira síncrona e imprimir valores de duas matrizes de tamanho igual no PHP?iterando e imprimindo valores de duas matrizes do mesmo tamanho ao criar uma caixa selecionada usando duas matrizes de tamanho igual, um contend...Programação Postado em 2025-04-12

Como posso iterar de maneira síncrona e imprimir valores de duas matrizes de tamanho igual no PHP?iterando e imprimindo valores de duas matrizes do mesmo tamanho ao criar uma caixa selecionada usando duas matrizes de tamanho igual, um contend...Programação Postado em 2025-04-12 -

Por que o DateTime :: Modify do PHP ('+1 mês') produz resultados inesperados?Modificando meses com php dateTime: descobrindo o comportamento pretendido Ao trabalhar com a classe DateTime do PHP, adicionar ou subtrair me...Programação Postado em 2025-04-12

Por que o DateTime :: Modify do PHP ('+1 mês') produz resultados inesperados?Modificando meses com php dateTime: descobrindo o comportamento pretendido Ao trabalhar com a classe DateTime do PHP, adicionar ou subtrair me...Programação Postado em 2025-04-12 -

Como corrigir “Erro geral: o servidor MySQL 2006 desapareceu” ao inserir dados?Como resolver "Erro geral: o servidor MySQL de 2006 desapareceu" ao inserir registrosIntrodução:A inserção de dados em um banco de dados MyS...Programação Postado em 2025-04-12

Como corrigir “Erro geral: o servidor MySQL 2006 desapareceu” ao inserir dados?Como resolver "Erro geral: o servidor MySQL de 2006 desapareceu" ao inserir registrosIntrodução:A inserção de dados em um banco de dados MyS...Programação Postado em 2025-04-12 -

Como posso executar comandos de prompt de comando, incluindo alterações de diretório, em java?Executar comandos do prompt de comando em java Problema: executando comandos de prompt de java pode ser desafio. Embora você possa encontr...Programação Postado em 2025-04-12

Como posso executar comandos de prompt de comando, incluindo alterações de diretório, em java?Executar comandos do prompt de comando em java Problema: executando comandos de prompt de java pode ser desafio. Embora você possa encontr...Programação Postado em 2025-04-12

Estude chinês

- 1 Como se diz “andar” em chinês? 走路 Pronúncia chinesa, 走路 aprendizagem chinesa

- 2 Como se diz “pegar um avião” em chinês? 坐飞机 Pronúncia chinesa, 坐飞机 aprendizagem chinesa

- 3 Como se diz “pegar um trem” em chinês? 坐火车 Pronúncia chinesa, 坐火车 aprendizagem chinesa

- 4 Como se diz “pegar um ônibus” em chinês? 坐车 Pronúncia chinesa, 坐车 aprendizagem chinesa

- 5 Como se diz dirigir em chinês? 开车 Pronúncia chinesa, 开车 aprendizagem chinesa

- 6 Como se diz nadar em chinês? 游泳 Pronúncia chinesa, 游泳 aprendizagem chinesa

- 7 Como se diz andar de bicicleta em chinês? 骑自行车 Pronúncia chinesa, 骑自行车 aprendizagem chinesa

- 8 Como você diz olá em chinês? 你好Pronúncia chinesa, 你好Aprendizagem chinesa

- 9 Como você agradece em chinês? 谢谢Pronúncia chinesa, 谢谢Aprendizagem chinesa

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning