Primeira página > Tutorial de software > 5 novos recursos de acessibilidade no iOS 18 que achamos que todos deveriam usar

Primeira página > Tutorial de software > 5 novos recursos de acessibilidade no iOS 18 que achamos que todos deveriam usar

5 novos recursos de acessibilidade no iOS 18 que achamos que todos deveriam usar

A Apple apresentou recentemente novos recursos de acessibilidade que estarão disponíveis “ainda este ano” com iOS 18 e outras atualizações. Algumas dessas tecnologias assistivas alimentadas por IA são tão úteis que beneficiarão todos os usuários, como navegar no iOS com os olhos, controlar o CarPlay com a voz e usar um iPhone em um veículo em movimento sem enjoar.

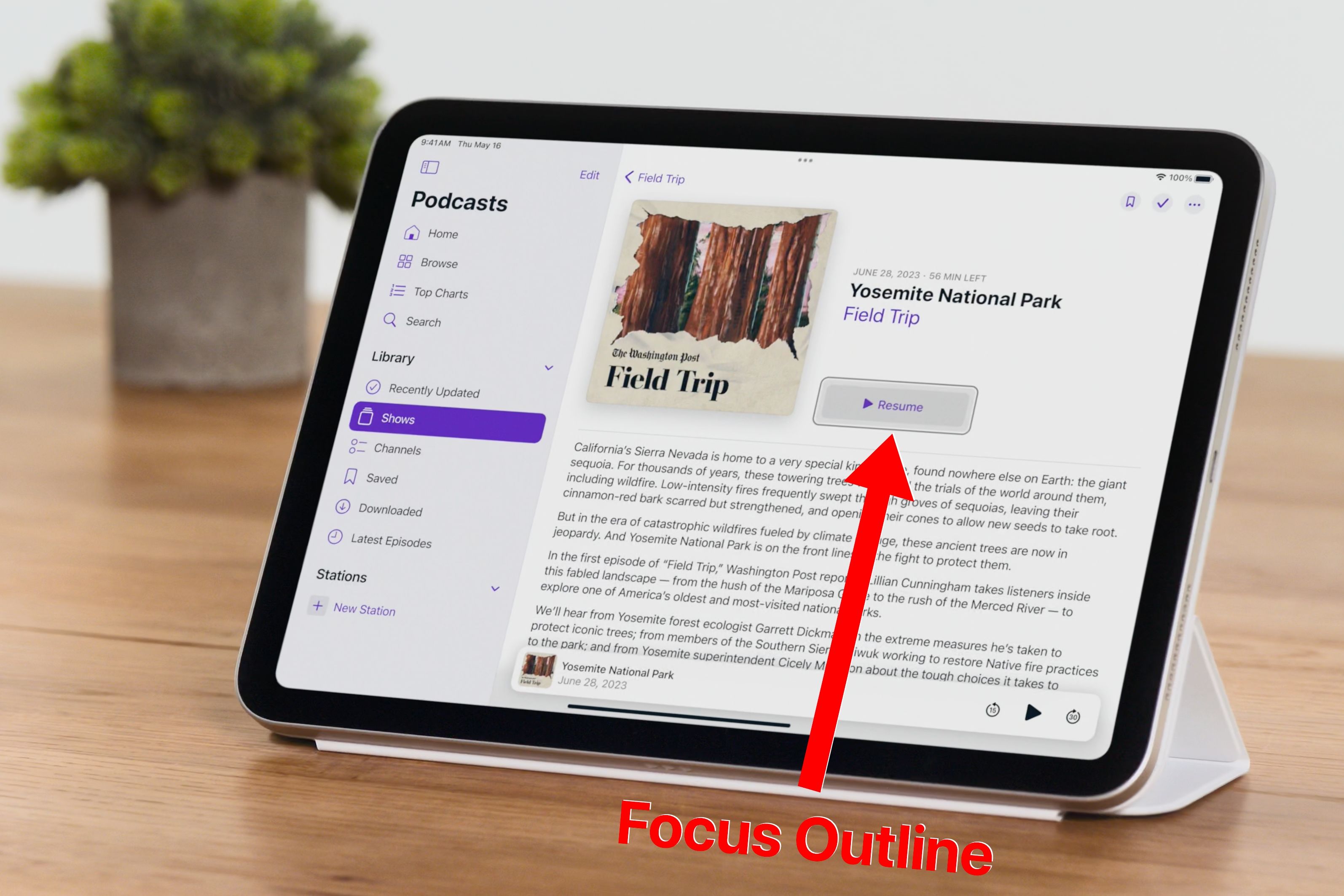

Controle ocular para navegar em um iPhone ou iPad por Gazing

O rastreamento ocular é um dos melhores recursos do visionOS que chegará ao iOS e iPadOS em 2024. A razão pela qual o rastreamento ocular no Apple Vision Pro funciona tão bem graças ao hardware dedicado do fone de ouvido. O Vision Pro usa sensores internos e câmeras para rastrear rapidamente o movimento dos olhos, determinando a direção do seu olhar com notável precisão.

Com o Eye Control, você poderá navegar no sistema operacional e controlar aplicativos com as mãos livres, usando apenas os olhos, sem entrada de toque, acessórios extras ou hardware especial diferente da câmera TrueDepth usada para Face ID.

Deve levar alguns segundos para configurar, calibrar e começar a usar o Eye Control em todos os aplicativos. O vídeo da Apple mostra o uso do recurso para mover-se entre a barra lateral, botões e seções de seu aplicativo Podcasts. Você olha para um elemento na tela e o sistema o destaca.

Para selecioná-lo, mantenha o olhar fixo por alguns segundos. Há também um novo Dwell Control para invocar interações do sistema, como deslizar e fazer gestos com as mãos livres. Não se preocupe com a privacidade: a inteligência artificial e o aprendizado de máquina no dispositivo garantem que os dados de rastreamento ocular sejam protegidos com segurança no dispositivo e não sejam compartilhados com a Apple ou carregados na nuvem.

Sinais de movimento do veículo deixam os passageiros menos enjoados

Meu iPhone sempre me deixa enjoado, então estou feliz que a Apple esteja trabalhando em um recurso para aliviar tonturas, náuseas e vômitos de muitas pessoas sente ao olhar para o telefone em um veículo em movimento.

As dicas de movimento do veículo ajudam a reduzir o enjôo exibindo pontos de vários tamanhos ao longo das bordas da tela que reagem ao movimento do veículo. Quando um veículo vira à esquerda, os pontos mudam para a direita e vice-versa. Da mesma forma, os pontos são animados verticalmente ao acelerar e frear.

O enjôo é causado por uma desconexão entre o que você vê e o que sente. Isso perturba o sistema vestibular do ouvido interno, que envia sinais elétricos ao cérebro (como um giroscópio) para fazer os ajustes necessários para manter o corpo em equilíbrio.

Os sensores dentro do seu iPhone e iPad detectarão quando você estiver em um veículo em movimento, como um carro, trem, avião, barco ou parque de diversões, para ativar dicas de movimento do veículo sob demanda. Além disso, você poderá alternar manualmente o recurso no Centro de Controle, desde que “Sugestões de Movimento do Veículo” tenham sido adicionadas a “Controles Incluídos” em Configurações> Centro de Controle.

Music Haptics permite que você literalmente sinta a música

Music Haptics é outro recurso de acessibilidade futuro que beneficiará a todos, não apenas as pessoas com deficiência auditiva. Além de ouvir sua música e acompanhar as letras sincronizadas com o tempo, você literalmente sentirá isso por meio de toques personalizados, texturas e vibrações refinadas informadas pela música que está ouvindo.

Music Haptics usa o Taptic Engine, o sofisticado motor vibratório do iPhone capaz de produzir uma variedade de padrões de vibração sutis. Como não há Taptic Engines em iPads e Macs, o recurso Music Haptics ficará restrito ao iPhone.

Você pode criar uma vibração personalizada a partir de uma música tocando na tela para combinar com a batida. Vá para Configurações> Sons e tátil, selecione um som como “Tom de texto” e escolha Haptics> Criar nova vibração.

Music Haptics estará disponível para todas as músicas do catálogo da Apple Music. A Apple também fornecerá uma API para que os desenvolvedores tornem a música em seus aplicativos “mais acessível”.

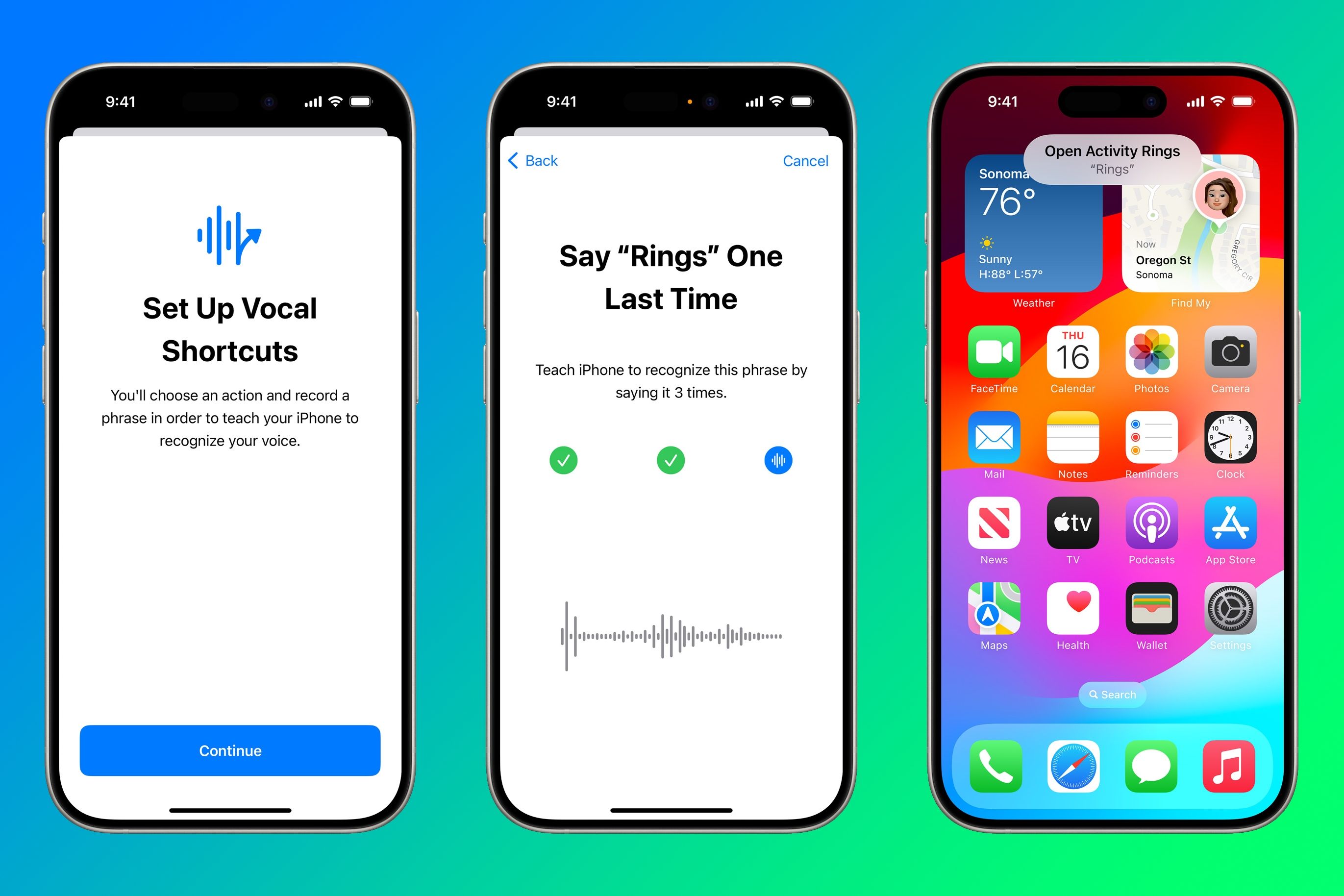

Atalhos vocais para acionar ações sem 'Hey Siri'

O recurso Atalhos vocais melhorará a automação, permitindo que você inicie atalhos com sua voz sem a invocação de “Hey Siri” ou “Siri”. Você gravará uma expressão personalizada e atribuirá a ela uma ação desejada ou uma automação salva no aplicativo Atalhos.

Por exemplo, você pode atribuir “Toques” à ação Mostrar anéis de atividade no aplicativo Atalhos. Então, para visualizar seus anéis de atividade, você diria “Toques” em voz alta sem precisar prefixar o comando de voz com uma invocação “Ei, Siri” ou “Siri”.

Controle de voz para navegação no CarPlay com viva-voz

Você pode realizar muitas ações do CarPlay com as mãos livres com o Siri, como fazer chamadas, enviar mensagens e verificar a previsão do tempo. Com o Controle por Voz, você poderá navegar pela interface do CarPlay, iniciar e alternar entre aplicativos e muito mais com sua voz.

Trazer o controle mãos-livres para o CarPlay tornará o Controle de Voz um importante recurso de segurança.

O Controle de Voz está disponível no iPhone, iPad e Mac há muitos anos. Esse recurso frequentemente esquecido pode ser usado para fazer coisas como desbloquear o iPhone com sua voz. No iOS 18, o Controle de Voz oferece suporte a palavras complexas e vocabulário personalizado.

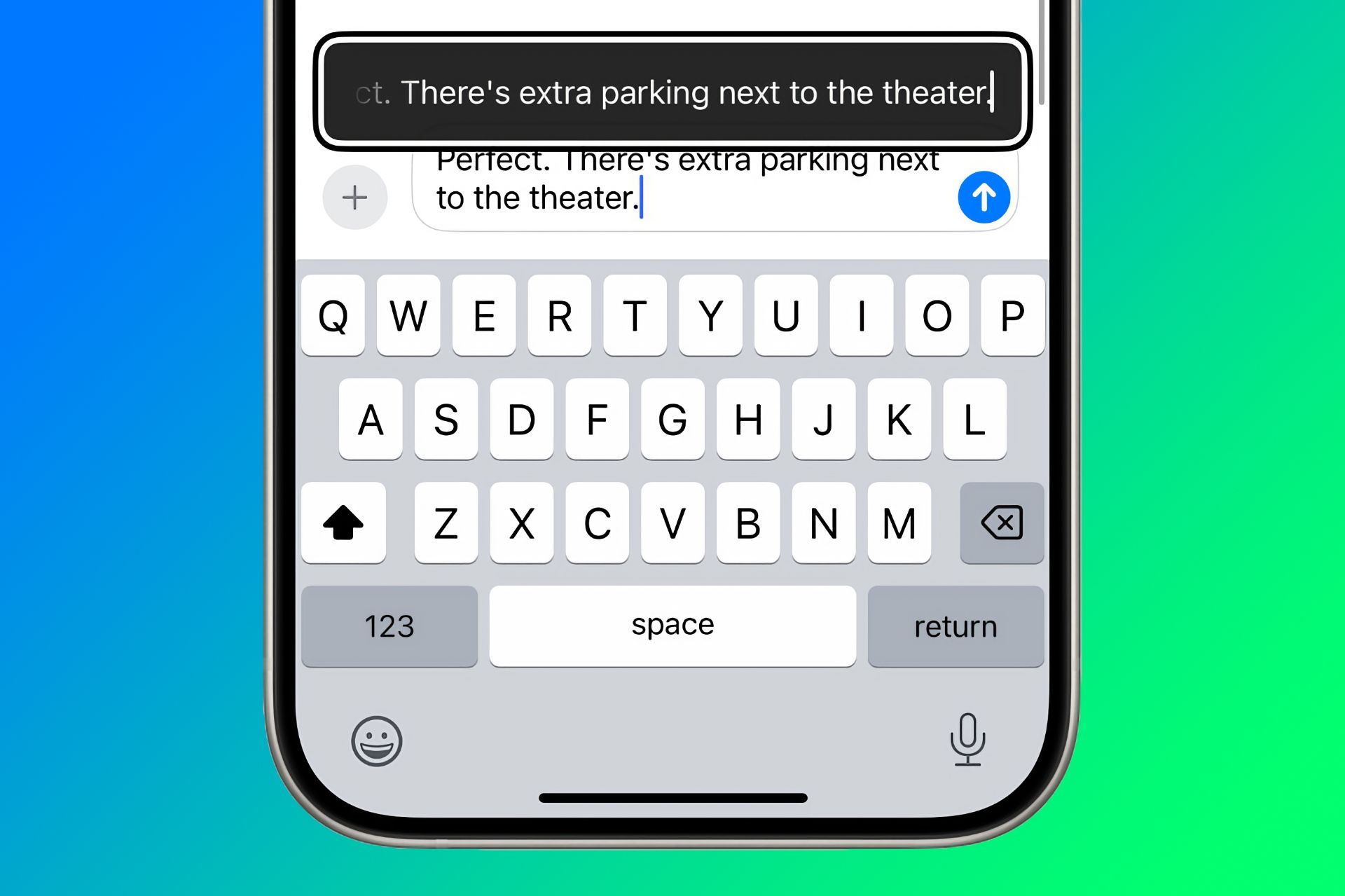

Dicas: Trackpad virtual, digitação flutuante e muito mais

iOS 18, iPadOS 18 e macOS 15 trarão outros recursos de acessibilidade notáveis. O Virtual Trackpad permite definir uma pequena região da tela para funcionar como um trackpad redimensionável (não deve ser confundido com o modo trackpad do teclado existente).

A digitação instantânea mostra um texto maior acima de um campo de texto durante a digitação. Se você não suporta fontes pequenas em formulários da web e campos de texto, como eu, o Hover Typing será um recurso útil.

A Lupa ganhará um Modo Leitor minimalista para transformar texto digitalizado de imagens em texto bruto, como o Modo Leitor no Safari. A Apple também disse que o iOS 18 permitirá que os proprietários do iPhone 15 iniciem a Lupa diretamente no modo de detecção pressionando o botão Ação.

Live Speech funcionará com legendas ao vivo. O Personal Voice estará disponível em mandarim. Os proprietários de Mac poderão personalizar o atalho de teclado do VoiceOver. Outro novo recurso chamado “Ouvir fala atípica” ajudará milhões de pessoas com condições que afetam a fala, como paralisia cerebral, esclerose lateral amiotrófica (ELA) ou acidente vascular cerebral, a ter mais facilidade para conversar com Siri e usar o reconhecimento de fala.

Além do controle de voz, o CarPlay oferece suporte a filtros de cores e reconhecimento de som, que irão alertá-lo sobre buzinas e sirenes de carros por meio de notificações.

Acessibilidade para todos

Por vários anos consecutivos, a Apple revelou os próximos recursos de acessibilidade antes do Dia Global de Conscientização sobre Acessibilidade em maio. Esses anúncios oportunos servem como um prelúdio para a Worldwide Developers Conference (WWDC) anual da Apple em junho, onde a empresa apresenta todos os principais avanços e novos recursos que chegarão às suas plataformas de software.

Todos os olhos estarão voltados para a Apple, já que se espera que a WWDC deste ano seja uma plataforma de lançamento para os rumores de recursos generativos de IA, grandes modelos de linguagem e outras melhorias de IA que chegarão ao iOS 18, iPadOS 18, macOS 15, watchOS 11 , tvOS 18 e visionOS 2 no outono.

-

Como excluir seus dados de um site de pesquisa de pessoaEste artigo foi atualizado pela última vez em 24 de fevereiro de 2025. Muitas pessoas não sabem que uma quantidade significativa de seus dados...Tutorial de software Postado em 2025-04-21

Como excluir seus dados de um site de pesquisa de pessoaEste artigo foi atualizado pela última vez em 24 de fevereiro de 2025. Muitas pessoas não sabem que uma quantidade significativa de seus dados...Tutorial de software Postado em 2025-04-21 -

Como disfarçar um iPad como um laptopEste artigo atualizado (publicado originalmente em 31 de outubro de 2019) explora como transformar seu iPad em uma alternativa de laptop usando os re...Tutorial de software Postado em 2025-04-21

Como disfarçar um iPad como um laptopEste artigo atualizado (publicado originalmente em 31 de outubro de 2019) explora como transformar seu iPad em uma alternativa de laptop usando os re...Tutorial de software Postado em 2025-04-21 -

Como limpar o cache da caixa de correio Mac? Como excluí -lo no Mac?Este guia explica como limpar o cache de email no seu Mac, abordando problemas comuns, como desempenho lento e problemas de carregamento de email. O...Tutorial de software Postado em 2025-04-21

Como limpar o cache da caixa de correio Mac? Como excluí -lo no Mac?Este guia explica como limpar o cache de email no seu Mac, abordando problemas comuns, como desempenho lento e problemas de carregamento de email. O...Tutorial de software Postado em 2025-04-21 -

Como priorizar a alocação de wifi para os dispositivos mais necessáriosAs casas modernas geralmente possuem vários dispositivos conectados às redes de acesso Wi-Fi simultaneamente, o que geralmente leva ao aperto de l...Tutorial de software Postado em 2025-04-19

Como priorizar a alocação de wifi para os dispositivos mais necessáriosAs casas modernas geralmente possuem vários dispositivos conectados às redes de acesso Wi-Fi simultaneamente, o que geralmente leva ao aperto de l...Tutorial de software Postado em 2025-04-19 -

Revisão do software McAfee Antivirus: é suficiente? 【Função, preço】mcAfee: um antivírus veterano, mas é o melhor para Macs? McAfee, um nome de longa data e respeitável na segurança cibernética, oferece uma suíte an...Tutorial de software Postado em 2025-04-19

Revisão do software McAfee Antivirus: é suficiente? 【Função, preço】mcAfee: um antivírus veterano, mas é o melhor para Macs? McAfee, um nome de longa data e respeitável na segurança cibernética, oferece uma suíte an...Tutorial de software Postado em 2025-04-19 -

OnePlus Watch 3 é adiado para abril devido a problemas engraçadosDepois que o tão esperado OnePlus Watch 3 SmartWatch é lançado, o plano de compra pode exigir um pequeno ajuste. Um problema ridículo de produção ...Tutorial de software Postado em 2025-04-19

OnePlus Watch 3 é adiado para abril devido a problemas engraçadosDepois que o tão esperado OnePlus Watch 3 SmartWatch é lançado, o plano de compra pode exigir um pequeno ajuste. Um problema ridículo de produção ...Tutorial de software Postado em 2025-04-19 -

Dicas para aproveitar ao máximo a função da torneira na parte traseira do seu iPhoneAo longo dos anos, a Apple desenvolveu um grande número de ferramentas para tornar o uso de iPhones mais conveniente. Embora o recurso "Tap B...Tutorial de software Postado em 2025-04-18

Dicas para aproveitar ao máximo a função da torneira na parte traseira do seu iPhoneAo longo dos anos, a Apple desenvolveu um grande número de ferramentas para tornar o uso de iPhones mais conveniente. Embora o recurso "Tap B...Tutorial de software Postado em 2025-04-18 -

Obtenha rapidamente as atualizações do Windows 11 24H2, pule a fila de esperaNo guia abrangente, o Minitool o levará a como ignorar o Windows 11 24H2 Waiting Line usando a política e o registro do grupo. Ação Se você deseja fo...Tutorial de software Postado em 2025-04-18

Obtenha rapidamente as atualizações do Windows 11 24H2, pule a fila de esperaNo guia abrangente, o Minitool o levará a como ignorar o Windows 11 24H2 Waiting Line usando a política e o registro do grupo. Ação Se você deseja fo...Tutorial de software Postado em 2025-04-18 -

Dicas para usar pontos de acesso para telefones celulares: como evitar o aumento no tráfego de dadosusando seu telefone como um ponto de acesso para o seu laptop em movimento é conveniente, mas os laptops são porcos de dados. Ao contrário dos telefo...Tutorial de software Postado em 2025-04-18

Dicas para usar pontos de acesso para telefones celulares: como evitar o aumento no tráfego de dadosusando seu telefone como um ponto de acesso para o seu laptop em movimento é conveniente, mas os laptops são porcos de dados. Ao contrário dos telefo...Tutorial de software Postado em 2025-04-18 -

Qual é melhor comparado ao iPhone e Android?Escolha entre iOS e Android: uma comparação detalhada O mercado de telefones celulares é dominado por dois principais players: iOS e Android. Ambo...Tutorial de software Postado em 2025-04-17

Qual é melhor comparado ao iPhone e Android?Escolha entre iOS e Android: uma comparação detalhada O mercado de telefones celulares é dominado por dois principais players: iOS e Android. Ambo...Tutorial de software Postado em 2025-04-17 -

Safari diminui o Mac? O segredo para acelerar o safari!O navegador Safari é executado lentamente? Um guia imperdível para aceleração para usuários de Mac! Safari é um dos navegadores mais rápidos do Mac...Tutorial de software Postado em 2025-04-17

Safari diminui o Mac? O segredo para acelerar o safari!O navegador Safari é executado lentamente? Um guia imperdível para aceleração para usuários de Mac! Safari é um dos navegadores mais rápidos do Mac...Tutorial de software Postado em 2025-04-17 -

Eu pensei que nunca precisaria de uma carteira até que isso acontecesseVocê está em um bom restaurante com seu amado; Talvez vocês dois estejam desfrutando de um bife adorável. Depois de um tempo, você levanta a mão e pe...Tutorial de software Postado em 2025-04-17

Eu pensei que nunca precisaria de uma carteira até que isso acontecesseVocê está em um bom restaurante com seu amado; Talvez vocês dois estejam desfrutando de um bife adorável. Depois de um tempo, você levanta a mão e pe...Tutorial de software Postado em 2025-04-17 -

Comparação entre McAfee e Mackeeper: qual é o melhor? Como escolher o software antivírus?A escolha da solução certa de segurança cibernética para o seu Mac pode ser complicada. Esta comparação de McAfee e Mackeeper ajuda você a decidir e...Tutorial de software Postado em 2025-04-17

Comparação entre McAfee e Mackeeper: qual é o melhor? Como escolher o software antivírus?A escolha da solução certa de segurança cibernética para o seu Mac pode ser complicada. Esta comparação de McAfee e Mackeeper ajuda você a decidir e...Tutorial de software Postado em 2025-04-17 -

7 aplicativos de comunicação de segurança que você deve usarA escolha de um aplicativo de mensagens geralmente se resume ao que seus contatos usam, ignorando um fator crucial: segurança. Compartilhamos inform...Tutorial de software Postado em 2025-04-17

7 aplicativos de comunicação de segurança que você deve usarA escolha de um aplicativo de mensagens geralmente se resume ao que seus contatos usam, ignorando um fator crucial: segurança. Compartilhamos inform...Tutorial de software Postado em 2025-04-17 -

O melhor guia de como rotular qualquer sitealém da estática: anotar páginas da web com facilidade A web não deve ser uma experiência estática. Com as ferramentas certas, você pode se envolv...Tutorial de software Postado em 2025-04-17

O melhor guia de como rotular qualquer sitealém da estática: anotar páginas da web com facilidade A web não deve ser uma experiência estática. Com as ferramentas certas, você pode se envolv...Tutorial de software Postado em 2025-04-17

Estude chinês

- 1 Como se diz “andar” em chinês? 走路 Pronúncia chinesa, 走路 aprendizagem chinesa

- 2 Como se diz “pegar um avião” em chinês? 坐飞机 Pronúncia chinesa, 坐飞机 aprendizagem chinesa

- 3 Como se diz “pegar um trem” em chinês? 坐火车 Pronúncia chinesa, 坐火车 aprendizagem chinesa

- 4 Como se diz “pegar um ônibus” em chinês? 坐车 Pronúncia chinesa, 坐车 aprendizagem chinesa

- 5 Como se diz dirigir em chinês? 开车 Pronúncia chinesa, 开车 aprendizagem chinesa

- 6 Como se diz nadar em chinês? 游泳 Pronúncia chinesa, 游泳 aprendizagem chinesa

- 7 Como se diz andar de bicicleta em chinês? 骑自行车 Pronúncia chinesa, 骑自行车 aprendizagem chinesa

- 8 Como você diz olá em chinês? 你好Pronúncia chinesa, 你好Aprendizagem chinesa

- 9 Como você agradece em chinês? 谢谢Pronúncia chinesa, 谢谢Aprendizagem chinesa

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning