ResNet 対 EfficientNet 対 VGG 対 NN

私は学生として、大学の非効率な遺失物管理システムによって引き起こされるフラストレーションを直接目の当たりにしてきました。現在のプロセスは、拾得物ごとに個別の電子メールに依存しているため、多くの場合、紛失した持ち物とその所有者との間の接続が遅延したり、連絡が取れなかったりすることがあります。

私自身と他の生徒たちのためにこの体験を改善したいという欲求に駆られて、私は忘れ物システムに革命を起こすディープラーニングの可能性を探るプロジェクトに着手しました。 このブログ投稿では、紛失物の識別と分類を自動化するために、事前トレーニング済みモデル (ResNet、EfficientNet、VGG、および NasNet) を評価する私の過程を共有します。

比較分析を通じて、私たちのシステムに統合するのに最適なモデルを特定し、最終的にはキャンパス内のすべての人にとって、より速く、より正確で、ユーザーフレンドリーな忘れ物体験を作成することを目指しています。

レスネット

Inception-ResNet V2 は、Keras で利用可能な強力な畳み込みニューラル ネットワーク アーキテクチャであり、Inception アーキテクチャの強みと ResNet からの残りの接続を組み合わせています。このハイブリッド モデルは、計算効率を維持しながら、画像分類タスクで高い精度を達成することを目的としています。

トレーニング データセット: ImageNet

画像フォーマット: 299 x 299

前処理機能

def readyForResNet(fileName):

pic = load_img(fileName, target_size=(299, 299))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_resnet(expanded)

予測する

data1 = readyForResNet(test_file) prediction = inception_model_resnet.predict(data1) res1 = decode_predictions_resnet(prediction, top=2)

VGG (ビジュアル ジオメトリ グループ)

VGG (Visual Geometry Group) は、画像分類タスクにおけるシンプルさと有効性で知られるディープ畳み込みニューラル ネットワーク アーキテクチャのファミリーです。これらのモデル、特に VGG16 と VGG19 は、2014 年の ImageNet Large Scale Visual Recognition Challenge (ILSVRC) での好成績により人気を博しました。

トレーニング データセット: ImageNet

画像フォーマット: 224 x 224

前処理機能

def readyForVGG(fileName):

pic = load_img(fileName, target_size=(224, 224))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_vgg19(expanded)

予測する

data2 = readyForVGG(test_file) prediction = inception_model_vgg19.predict(data2) res2 = decode_predictions_vgg19(prediction, top=2)

EfficientNet

EfficientNet は、以前のモデルよりも大幅に小型かつ高速でありながら、画像分類タスクで最先端の精度を達成する畳み込みニューラル ネットワーク アーキテクチャのファミリーです。この効率は、ネットワークの深さ、幅、解像度のバランスをとる新しい複合スケーリング方法によって実現されます。

トレーニング データセット: ImageNet

画像フォーマット: 480 x 480

前処理機能

def readyForEF(fileName):

pic = load_img(fileName, target_size=(480, 480))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_EF(expanded)

予測する

data3 = readyForEF(test_file) prediction = inception_model_EF.predict(data3) res3 = decode_predictions_EF(prediction, top=2)

ナスネット

NasNet (Neural Architecture Search Network) は、自動化された検索プロセスを通じてニューラル ネットワーク自体のアーキテクチャを発見するディープ ラーニングにおける画期的なアプローチを表しています。この検索プロセスは、特定のタスクで高いパフォーマンスを達成するために、レイヤーと接続の最適な組み合わせを見つけることを目的としています。

トレーニング データセット: ImageNet

画像フォーマット: 224 x 224

前処理機能

def readyForNN(fileName):

pic = load_img(fileName, target_size=(224, 224))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_NN(expanded)

予測する

data4 = readyForNN(test_file) prediction = inception_model_NN.predict(data4) res4 = decode_predictions_NN(prediction, top=2)

対決

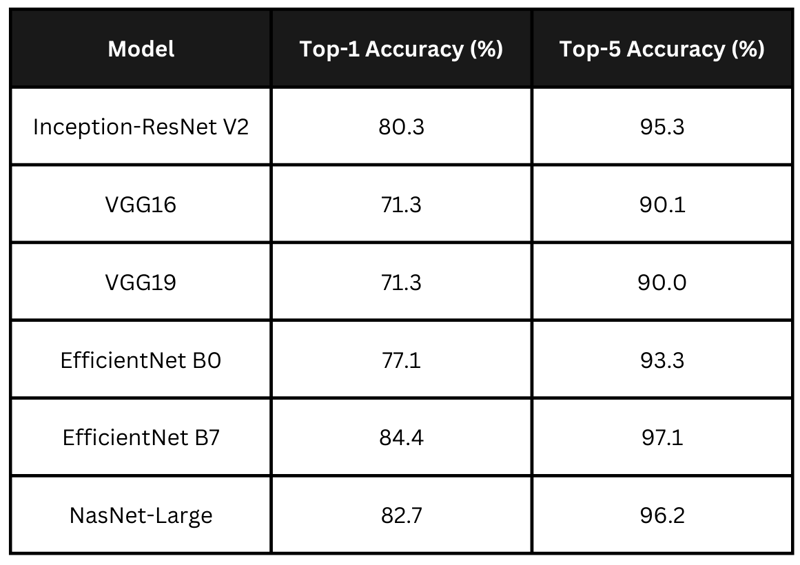

正確さ

表は、上記のモデルの主張される精度スコアをまとめたものです。 EfficientNet B7 が最高の精度でリードし、NasNet-Large と Inception-ResNet V2 が僅差で続きます。 VGG モデルは精度が低くなります。私のアプリケーションでは、処理時間と精度のバランスが取れたモデルを選択したいと考えています。

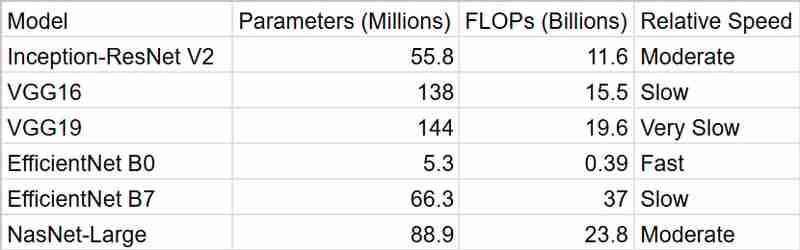

時間

ご覧のとおり、EfficientNetB0 が最も速い結果を提供しますが、精度を考慮すると InceptionResNetV2 の方が優れたパッケージです

まとめ

スマート遺失物システムには、InceptionResNetV2 を使用することにしました。 EfficientNet B7 は最高の精度で魅力的に見えましたが、私はその計算要求について懸念していました。リソースが限られており、リアルタイムのパフォーマンスが望まれることが多い大学の環境では、精度と効率のバランスを取ることが重要であると感じました。 InceptionResNetV2 は完璧に適合しているように思えました。計算量を過度に消費せずに強力なパフォーマンスを提供します。

さらに、ImageNet で事前トレーニングされているという事実により、人々が失う可能性のあるさまざまなオブジェクトを処理できるという自信が得られます。そして、Keras での作業がいかに簡単であるかを忘れないでください。そのおかげで私の決断は間違いなく容易になりました。

全体として、InceptionResNetV2 は私のプロジェクトに精度、効率、実用性の適切な組み合わせを提供すると信じています。紛失したアイテムを持ち主と再会させるのにどのように役立つかを見るのが楽しみです!

-

一意の ID を保持し、重複した名前を処理しながら、PHP で 2 つの連想配列を結合するにはどうすればよいですか?PHP での連想配列の結合PHP では、2 つの連想配列を 1 つの配列に結合するのが一般的なタスクです。次のリクエストを考えてみましょう:問題の説明:提供されたコードは 2 つの連想配列 $array1 と $array2 を定義します。目標は、両方の配列のすべてのキーと値のペアを統合する新しい配...プログラミング 2024 年 12 月 25 日に公開

一意の ID を保持し、重複した名前を処理しながら、PHP で 2 つの連想配列を結合するにはどうすればよいですか?PHP での連想配列の結合PHP では、2 つの連想配列を 1 つの配列に結合するのが一般的なタスクです。次のリクエストを考えてみましょう:問題の説明:提供されたコードは 2 つの連想配列 $array1 と $array2 を定義します。目標は、両方の配列のすべてのキーと値のペアを統合する新しい配...プログラミング 2024 年 12 月 25 日に公開 -

「if」ステートメントを超えて: 明示的な「bool」変換を伴う型をキャストせずに使用できる場所は他にありますか?キャストなしで bool へのコンテキスト変換が可能クラスは bool への明示的な変換を定義し、そのインスタンス 't' を条件文で直接使用できるようにします。ただし、この明示的な変換では、キャストなしで bool として 't' を使用できる場所はどこですか?コン...プログラミング 2024 年 12 月 25 日に公開

「if」ステートメントを超えて: 明示的な「bool」変換を伴う型をキャストせずに使用できる場所は他にありますか?キャストなしで bool へのコンテキスト変換が可能クラスは bool への明示的な変換を定義し、そのインスタンス 't' を条件文で直接使用できるようにします。ただし、この明示的な変換では、キャストなしで bool として 't' を使用できる場所はどこですか?コン...プログラミング 2024 年 12 月 25 日に公開 -

Go で WebSocket を使用してリアルタイム通信を行うチャット アプリケーション、ライブ通知、共同作業ツールなど、リアルタイムの更新が必要なアプリを構築するには、従来の HTTP よりも高速でインタラクティブな通信方法が必要です。そこで WebSocket が登場します。今日は、アプリケーションにリアルタイム機能を追加できるように、Go で WebSo...プログラミング 2024 年 12 月 25 日に公開

Go で WebSocket を使用してリアルタイム通信を行うチャット アプリケーション、ライブ通知、共同作業ツールなど、リアルタイムの更新が必要なアプリを構築するには、従来の HTTP よりも高速でインタラクティブな通信方法が必要です。そこで WebSocket が登場します。今日は、アプリケーションにリアルタイム機能を追加できるように、Go で WebSo...プログラミング 2024 年 12 月 25 日に公開 -

MySQL を使用して今日が誕生日のユーザーを見つけるにはどうすればよいですか?MySQL を使用して今日の誕生日を持つユーザーを識別する方法MySQL を使用して今日がユーザーの誕生日かどうかを判断するには、誕生日が一致するすべての行を検索する必要があります。今日の日付。これは、UNIX タイムスタンプとして保存されている誕生日と今日の日付を比較する単純な MySQL クエリ...プログラミング 2024 年 12 月 25 日に公開

MySQL を使用して今日が誕生日のユーザーを見つけるにはどうすればよいですか?MySQL を使用して今日の誕生日を持つユーザーを識別する方法MySQL を使用して今日がユーザーの誕生日かどうかを判断するには、誕生日が一致するすべての行を検索する必要があります。今日の日付。これは、UNIX タイムスタンプとして保存されている誕生日と今日の日付を比較する単純な MySQL クエリ...プログラミング 2024 年 12 月 25 日に公開 -

macOS 上の Django で「ImproperlyConfigured: MySQLdb モジュールのロード中にエラーが発生しました」を修正する方法?MySQL の不適切な構成: 相対パスの問題Django で python manage.py runserver を実行すると、次のエラーが発生する場合があります:ImproperlyConfigured: Error loading MySQLdb module: dlopen(/Library...プログラミング 2024 年 12 月 25 日に公開

macOS 上の Django で「ImproperlyConfigured: MySQLdb モジュールのロード中にエラーが発生しました」を修正する方法?MySQL の不適切な構成: 相対パスの問題Django で python manage.py runserver を実行すると、次のエラーが発生する場合があります:ImproperlyConfigured: Error loading MySQLdb module: dlopen(/Library...プログラミング 2024 年 12 月 25 日に公開 -

Pandas DataFrame 文字列エントリを別々の行に分解 (分割) する方法は?Pandas DataFrame 文字列エントリを個別の行に分解 (分割) Pandas では、一般的な要件は、カンマ区切りの値を 1 つの行に分割することです。テキスト文字列列を作成し、エントリごとに新しい行を作成します。これは、さまざまな方法で実現できます。Series.explode() また...プログラミング 2024 年 12 月 25 日に公開

Pandas DataFrame 文字列エントリを別々の行に分解 (分割) する方法は?Pandas DataFrame 文字列エントリを個別の行に分解 (分割) Pandas では、一般的な要件は、カンマ区切りの値を 1 つの行に分割することです。テキスト文字列列を作成し、エントリごとに新しい行を作成します。これは、さまざまな方法で実現できます。Series.explode() また...プログラミング 2024 年 12 月 25 日に公開 -

データ挿入時の「一般エラー: 2006 MySQL サーバーが消えました」を修正するにはどうすればよいですか?レコードの挿入中に「一般エラー: 2006 MySQL サーバーが消えました」を解決する方法はじめに:MySQL データベースにデータを挿入すると、「一般エラー: 2006 MySQL サーバーが消えました。」というエラーが発生することがあります。このエラーは、通常、MySQL 構成内の 2 つの変...プログラミング 2024 年 12 月 25 日に公開

データ挿入時の「一般エラー: 2006 MySQL サーバーが消えました」を修正するにはどうすればよいですか?レコードの挿入中に「一般エラー: 2006 MySQL サーバーが消えました」を解決する方法はじめに:MySQL データベースにデータを挿入すると、「一般エラー: 2006 MySQL サーバーが消えました。」というエラーが発生することがあります。このエラーは、通常、MySQL 構成内の 2 つの変...プログラミング 2024 年 12 月 25 日に公開 -

Bootstrap 4 ベータ版の列オフセットはどうなりましたか?Bootstrap 4 ベータ: 列オフセットの削除と復元Bootstrap 4 は、ベータ 1 リリースで、その方法に大幅な変更を導入しました。柱がオフセットされました。ただし、その後の Beta 2 リリースでは、これらの変更は元に戻されました。offset-md-* から ml-autoBoo...プログラミング 2024 年 12 月 25 日に公開

Bootstrap 4 ベータ版の列オフセットはどうなりましたか?Bootstrap 4 ベータ: 列オフセットの削除と復元Bootstrap 4 は、ベータ 1 リリースで、その方法に大幅な変更を導入しました。柱がオフセットされました。ただし、その後の Beta 2 リリースでは、これらの変更は元に戻されました。offset-md-* から ml-autoBoo...プログラミング 2024 年 12 月 25 日に公開 -

Java で Selenium WebDriver を使用してファイルを効率的にアップロードするにはどうすればよいですか?Java の Selenium WebDriver を使用したファイルのアップロード: 詳細ガイドWeb アプリケーションへのファイルのアップロードは、ソフトウェア テスト中の一般的なタスクです。人気のある自動化フレームワークである Selenium WebDriver は、Java コードを使用し...プログラミング 2024 年 12 月 24 日に公開

Java で Selenium WebDriver を使用してファイルを効率的にアップロードするにはどうすればよいですか?Java の Selenium WebDriver を使用したファイルのアップロード: 詳細ガイドWeb アプリケーションへのファイルのアップロードは、ソフトウェア テスト中の一般的なタスクです。人気のある自動化フレームワークである Selenium WebDriver は、Java コードを使用し...プログラミング 2024 年 12 月 24 日に公開 -

GNU Emacs による C 開発Emacs is designed with programming in mind, it supports languages like C, Python, and Lisp natively, offering advanced features such as syntax highli...プログラミング 2024 年 12 月 24 日に公開

GNU Emacs による C 開発Emacs is designed with programming in mind, it supports languages like C, Python, and Lisp natively, offering advanced features such as syntax highli...プログラミング 2024 年 12 月 24 日に公開 -

PHP で単一引用符内の変数を出力するにはどうすればよいですか?一重引用符を含む変数を直接エコーすることはできません一重引用符で囲まれた文字列内の変数を出力する必要がありますか?直接実行することはできません。一重引用符内の変数を出力する方法:方法 1: 連結を使用して追加する これを行うには、ドット演算子を使用して変数を文字列に連結します。echo 'I lov...プログラミング 2024 年 12 月 24 日に公開

PHP で単一引用符内の変数を出力するにはどうすればよいですか?一重引用符を含む変数を直接エコーすることはできません一重引用符で囲まれた文字列内の変数を出力する必要がありますか?直接実行することはできません。一重引用符内の変数を出力する方法:方法 1: 連結を使用して追加する これを行うには、ドット演算子を使用して変数を文字列に連結します。echo 'I lov...プログラミング 2024 年 12 月 24 日に公開 -

std::vector とプレーン配列: パフォーマンスが本当に重要になるのはどのような場合ですか?std::vector とプレーン配列: パフォーマンス評価std::vector は配列と同様に動作すると一般に信じられていますが、最近のテストではこの概念に疑問が投げかけられています。この記事では、std::vector 配列とプレーン配列のパフォーマンスの違いを調べ、根本的な理由を明らかにしま...プログラミング 2024 年 12 月 24 日に公開

std::vector とプレーン配列: パフォーマンスが本当に重要になるのはどのような場合ですか?std::vector とプレーン配列: パフォーマンス評価std::vector は配列と同様に動作すると一般に信じられていますが、最近のテストではこの概念に疑問が投げかけられています。この記事では、std::vector 配列とプレーン配列のパフォーマンスの違いを調べ、根本的な理由を明らかにしま...プログラミング 2024 年 12 月 24 日に公開 -

Double Precision には、宣伝されている 15 桁よりも小数点以下の桁数が多いように見えるのはなぜですか?倍精度と小数点以下の桁精度コンピューター プログラミングでは、倍精度データ型の精度が小数点以下 15 桁であると想定されることがよくあります。ただし、1.0/7.0 などの特定の数値表現は、変数内で内部的に表現すると精度が高くなるように見えます。この記事では、これが発生する理由と、精度が小数点以下 ...プログラミング 2024 年 12 月 24 日に公開

Double Precision には、宣伝されている 15 桁よりも小数点以下の桁数が多いように見えるのはなぜですか?倍精度と小数点以下の桁精度コンピューター プログラミングでは、倍精度データ型の精度が小数点以下 15 桁であると想定されることがよくあります。ただし、1.0/7.0 などの特定の数値表現は、変数内で内部的に表現すると精度が高くなるように見えます。この記事では、これが発生する理由と、精度が小数点以下 ...プログラミング 2024 年 12 月 24 日に公開 -

アロー関数の暗黙的戻り値と明示的戻り値: 中括弧が必要になるのはどのような場合ですか?アロー関数の中括弧: 暗黙的な戻り値と明示的な戻り値アロー関数は、中括弧を使用する場合と使用しない場合の 2 つの方法で記述できます。中括弧が存在しない場合、関数の本体は「簡潔な本体」とみなされ、その中の最後の式が暗黙的に返されます。Implied Return with Concise BodyI...プログラミング 2024 年 12 月 24 日に公開

アロー関数の暗黙的戻り値と明示的戻り値: 中括弧が必要になるのはどのような場合ですか?アロー関数の中括弧: 暗黙的な戻り値と明示的な戻り値アロー関数は、中括弧を使用する場合と使用しない場合の 2 つの方法で記述できます。中括弧が存在しない場合、関数の本体は「簡潔な本体」とみなされ、その中の最後の式が暗黙的に返されます。Implied Return with Concise BodyI...プログラミング 2024 年 12 月 24 日に公開 -

「transform:scale()」を使用した後、Chrome でテキストがぼやけるのはなぜですか?変換後の Chrome のテキストのぼやけ:scale()最近の Chrome の更新で、CSS の変換を使用してテキストがレンダリングされるという奇妙な問題が発生しました。 :scale() プロパティがぼやけて表示されます。この問題は、次の特定のコードを使用したときに発生します。@-webkit...プログラミング 2024 年 12 月 24 日に公開

「transform:scale()」を使用した後、Chrome でテキストがぼやけるのはなぜですか?変換後の Chrome のテキストのぼやけ:scale()最近の Chrome の更新で、CSS の変換を使用してテキストがレンダリングされるという奇妙な問題が発生しました。 :scale() プロパティがぼやけて表示されます。この問題は、次の特定のコードを使用したときに発生します。@-webkit...プログラミング 2024 年 12 月 24 日に公開

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning