Go における確率的早期有効期限切れ

キャッシュスタンピードについて

あれこれキャッシュする必要がある状況に陥ることがよくあります。多くの場合、これらの値は一定期間キャッシュされます。おそらくこのパターンに精通しているでしょう。キャッシュから値を取得しようとして、成功した場合は、その値を呼び出し元に返し、それで終わりです。値が存在しない場合は、(おそらくデータベースから) 値を取得するか、計算してキャッシュに入れます。ほとんどの場合、これはうまく機能します。ただし、キャッシュ エントリに使用しているキーが頻繁にアクセスされ、データの計算操作に時間がかかる場合、複数の並列リクエストが同時にキャッシュ ミスを起こす状況に陥ります。これらのリクエストはすべて、ソースから独立してロードし、値をキャッシュに保存します。これによりリソースが無駄になり、サービス拒否につながる可能性もあります。

例を挙げて説明しましょう。キャッシュには redis を使用し、その上にシンプルな Go http サーバーを使用します。完全なコードは次のとおりです:

package main

import (

"errors"

"log"

"net/http"

"time"

"github.com/redis/go-redis/v9"

)

type handler struct {

rdb *redis.Client

cacheTTL time.Duration

}

func (ch *handler) simple(w http.ResponseWriter, r *http.Request) {

cacheKey := "my_cache_key"

// we'll use 200 to signify a cache hit & 201 to signify a miss

responseCode := http.StatusOK

cachedData, err := ch.rdb.Get(r.Context(), cacheKey).Result()

if err != nil {

if !errors.Is(err, redis.Nil) {

log.Println("could not reach redis", err.Error())

http.Error(w, "could not reach redis", http.StatusInternalServerError)

return

}

// cache miss - fetch & store

res := longRunningOperation()

responseCode = http.StatusCreated

err = ch.rdb.Set(r.Context(), cacheKey, res, ch.cacheTTL).Err()

if err != nil {

log.Println("failed to set cache value", err.Error())

http.Error(w, "failed to set cache value", http.StatusInternalServerError)

return

}

cachedData = res

}

w.WriteHeader(responseCode)

_, _ = w.Write([]byte(cachedData))

}

func longRunningOperation() string {

time.Sleep(time.Millisecond * 500)

return "hello"

}

func main() {

ttl := time.Second * 3

rdb := redis.NewClient(&redis.Options{

Addr: "localhost:6379",

})

handler := &handler{

rdb: rdb,

cacheTTL: ttl,

}

http.HandleFunc("/simple", handler.simple)

if err := http.ListenAndServe(":8080", nil); err != nil {

log.Fatalf("Could not start server: %s\n", err.Error())

}

}

/simple エンドポイントに負荷をかけて、何が起こるかを見てみましょう。これにはベジータを使います。

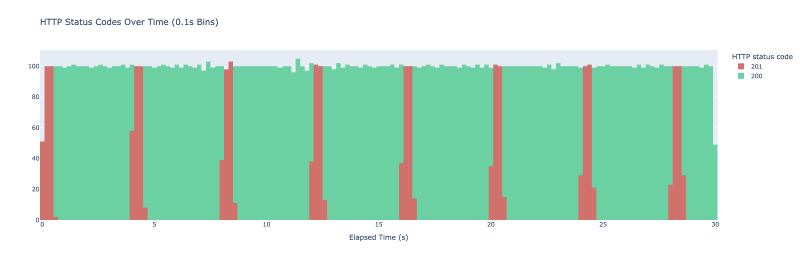

vegeta Attack -duration=30s -rate=500 -targets=./targets_simple.txt > res_simple.bin を実行します。ベジータは、30 秒間毎秒 500 件のリクエストを行うことになります。それぞれ 100 ミリ秒にわたるバケットを含む HTTP 結果コードのヒストグラムとしてグラフ化します。結果は次のグラフです。

実験を開始するとキャッシュは空です。そこには値が格納されていません。大量のリクエストがサーバーに到達すると、最初の殺到が起こります。それらはすべてキャッシュをチェックして何も見つからず、longRunningOperation を呼び出してキャッシュに保存します。 longRunningOperation が完了するまでに最大 500 ミリ秒かかるため、最初の 500 ミリ秒以内に行われたリクエストはすべて、longRunningOperation を呼び出すことになります。リクエストの 1 つが値をキャッシュに保存できると、後続のすべてのリクエストがその値をキャッシュから取得し、ステータス コード 200 のレスポンスが表示され始めます。その後、redis の有効期限メカニズムが開始されると、このパターンが 3 秒ごとに繰り返されます。 &&&]

このおもちゃの例では、これによって問題は発生しませんが、実稼働環境では、システムへの不要な負荷、ユーザー エクスペリエンスの低下、さらには自己誘発的なサービス拒否につながる可能性があります。では、どうすればこれを防ぐことができるでしょうか?まあ、方法はいくつかあります。ロックを導入することもできます。キャッシュ ミスが発生すると、コードがロックを達成しようとします。分散ロックは簡単なことではなく、多くの場合、分散ロックには繊細な処理が必要な微妙なエッジ ケースが存在します。バックグラウンド ジョブを使用して値を定期的に再計算することもできますが、これには追加のプロセスを実行する必要があり、コード内で維持および監視する必要があるさらに別の歯車が導入されます。このアプローチは、動的キャッシュ キーがある場合にも実行できない可能性があります。確率的早期有効期限と呼ばれる別のアプローチがあり、これについてはさらに検討していきたいと考えています。確率的に早い期限切れになる

この手法を使用すると、確率に基づいて値を再計算できます。キャッシュから値をフェッチするときは、確率に基づいてキャッシュ値を再生成する必要があるかどうかも計算します。既存の値の有効期限が近づくほど、確率は高くなります。

私は、A. Vattani、F.Chierichetti、K. Lowenstein による「Optimal Probabilistic Cache Stampede Prevention」の XFetch に基づいて具体的な実装を行っています。

HTTP サーバーに新しいエンドポイントを導入します。これも高価な計算を実行しますが、今回はキャッシュするときに XFetch を使用します。 XFetch が機能するには、高価な操作にかかった時間 (デルタ) とキャッシュ キーの有効期限がいつ切れるかを保存する必要があります。それを達成するために、これらの値とメッセージ自体を保持する構造体を導入します:

type probabilisticValue struct {

Message string

Expiry time.Time

Delta time.Duration

}

元のメッセージをこれらの属性でラップし、redis に保存するためにシリアル化する関数を追加します。

type probabilisticValue struct {

Message string

Expiry time.Time

Delta time.Duration

}

値を再計算して redis に保存するメソッドも書きましょう:

type probabilisticValue struct {

Message string

Expiry time.Time

Delta time.Duration

}

確率に基づいて値を更新する必要があるかどうかを判断するには、probabilisticValue: にメソッドを追加します。

type probabilisticValue struct {

Message string

Expiry time.Time

Delta time.Duration

}

すべてを接続すると、次のハンドラーが完成します:

type probabilisticValue struct {

Message string

Expiry time.Time

Delta time.Duration

}

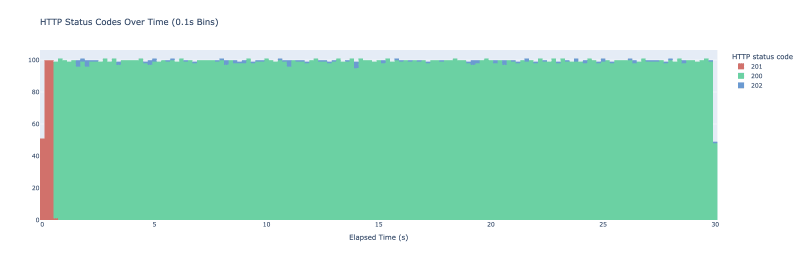

ハンドラーは最初のハンドラーとほぼ同じように動作しますが、キャッシュ ヒットを取得するとサイコロを振ります。結果に応じて、フェッチしたばかりの値を返すか、値を早めに更新します。HTTP ステータス コードを使用して、次の 3 つのケースのどちらかを判断します:

- 200 - キャッシュから値を返しました

- 201 - キャッシュミス、値が存在しません

- 202 - キャッシュ ヒット、トリガーされた確率的更新

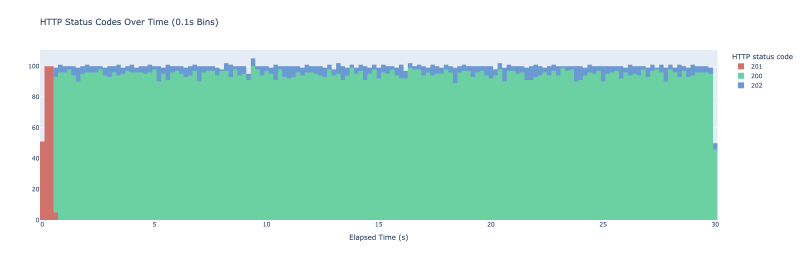

キャッシュをより積極的に行い、値をより頻繁に更新したい場合は、ベータ パラメーターを使用できます。ベータパラメータを 2 に設定した場合の同じ実験は次のようになります:

まとめると、これはキャッシュ スタンピードを回避するのに役立つちょっとしたテクニックです。ただし、これはキャッシュから同じキーを定期的にフェッチしている場合にのみ機能することに注意してください。そうでない場合は、あまりメリットがありません。

キャッシュスタンピードに対処する別の方法はありますか?間違いに気づきましたか?以下のコメント欄でお知らせください!

-

PHP で 2 つの日付の間の月数を効率的に計算するにはどうすればよいですか?日付間の月数を効率的に求めるプログラミングの一般的な課題は、2 つの日付間の月数を決定することです。 PHP では、この問題を解決するための複数のアプローチがあります。DateTime クラスの使用 (PHP >= 5.3):PHP 5.3 で導入された DateTime クラスには便利なメソッドが...プログラミング 2024 年 11 月 8 日に公開

PHP で 2 つの日付の間の月数を効率的に計算するにはどうすればよいですか?日付間の月数を効率的に求めるプログラミングの一般的な課題は、2 つの日付間の月数を決定することです。 PHP では、この問題を解決するための複数のアプローチがあります。DateTime クラスの使用 (PHP >= 5.3):PHP 5.3 で導入された DateTime クラスには便利なメソッドが...プログラミング 2024 年 11 月 8 日に公開 -

ブートストラップ: Navbar の作成とカスタマイズ導入 Bootstrap は、応答性の高いモバイル対応の Web サイトを作成するために Web 開発で広く使用されているオープンソース フレームワークです。 Bootstrap の重要なコンポーネントの 1 つは、Web サイトのコンテンツを整理して移動するために使用される水平ナ...プログラミング 2024 年 11 月 8 日に公開

ブートストラップ: Navbar の作成とカスタマイズ導入 Bootstrap は、応答性の高いモバイル対応の Web サイトを作成するために Web 開発で広く使用されているオープンソース フレームワークです。 Bootstrap の重要なコンポーネントの 1 つは、Web サイトのコンテンツを整理して移動するために使用される水平ナ...プログラミング 2024 年 11 月 8 日に公開 -

Python で WebSocket を使用するWebSocketとは何ですか? WebSocket は、ブラウザとサーバー間のリアルタイムの双方向通信を可能にするプロトコルです。従来の HTTP 通信には、クライアントがリクエストを送信し、サーバーがデータ交換に応答することが含まれます。対照的に、WebSocket では、最初...プログラミング 2024 年 11 月 8 日に公開

Python で WebSocket を使用するWebSocketとは何ですか? WebSocket は、ブラウザとサーバー間のリアルタイムの双方向通信を可能にするプロトコルです。従来の HTTP 通信には、クライアントがリクエストを送信し、サーバーがデータ交換に応答することが含まれます。対照的に、WebSocket では、最初...プログラミング 2024 年 11 月 8 日に公開 -

PHP でサブドメインからドメイン名を抽出するにはどうすればよいですか?PHP でサブドメインからドメイン名を抽出する現代の Web 開発では、サブドメインからであってもドメイン名を解析して取得することが不可欠です。 。簡単な例としては、「here.example.com」や「example.org」などのドメイン名が挙げられます。このニーズに対処するために、特定の入力...プログラミング 2024 年 11 月 8 日に公開

PHP でサブドメインからドメイン名を抽出するにはどうすればよいですか?PHP でサブドメインからドメイン名を抽出する現代の Web 開発では、サブドメインからであってもドメイン名を解析して取得することが不可欠です。 。簡単な例としては、「here.example.com」や「example.org」などのドメイン名が挙げられます。このニーズに対処するために、特定の入力...プログラミング 2024 年 11 月 8 日に公開 -

マルチスレッドプログラミングでベクトルを連結して効率を最適化するには?ベクトルの連結: 詳細な分析マルチスレッド プログラミングでは、結果の統合が一般的な課題です。これには通常、複数のベクトルを単一の包括的なベクトルに結合することが含まれます。最大限の効率を得るためにベクトルを連結するための最適なアプローチを探ってみましょう。最適な連結方法効率的なベクトル連結のベスト...プログラミング 2024 年 11 月 8 日に公開

マルチスレッドプログラミングでベクトルを連結して効率を最適化するには?ベクトルの連結: 詳細な分析マルチスレッド プログラミングでは、結果の統合が一般的な課題です。これには通常、複数のベクトルを単一の包括的なベクトルに結合することが含まれます。最大限の効率を得るためにベクトルを連結するための最適なアプローチを探ってみましょう。最適な連結方法効率的なベクトル連結のベスト...プログラミング 2024 年 11 月 8 日に公開 -

効率的に JSON データを返すために FastAPI を最適化するには?大規模な JSON データを返すための FastAPI の最適化FastAPI を通じて膨大な JSON データセットを返すのは、時間のかかる作業になる可能性があります。このボトルネックに対処するために、パフォーマンスを向上させる代替アプローチを検討します。ボトルネックの特定:json.dumps(...プログラミング 2024 年 11 月 8 日に公開

効率的に JSON データを返すために FastAPI を最適化するには?大規模な JSON データを返すための FastAPI の最適化FastAPI を通じて膨大な JSON データセットを返すのは、時間のかかる作業になる可能性があります。このボトルネックに対処するために、パフォーマンスを向上させる代替アプローチを検討します。ボトルネックの特定:json.dumps(...プログラミング 2024 年 11 月 8 日に公開 -

React: 状態 X 派生状態派生状態とは何ですか?テキストに対して 1 つの状態を考えてから、uppercaseText に対して別の状態を考えてください。 派生状態 function Foo() { const [text, setText] = useState('hello, za warudo!...プログラミング 2024 年 11 月 8 日に公開

React: 状態 X 派生状態派生状態とは何ですか?テキストに対して 1 つの状態を考えてから、uppercaseText に対して別の状態を考えてください。 派生状態 function Foo() { const [text, setText] = useState('hello, za warudo!...プログラミング 2024 年 11 月 8 日に公開 -

カスタム ユーザー タイプを使用して PostgreSQL JSON 列を Hibernate エンティティにマップする方法PostgreSQL JSON 列を Hibernate エンティティにマッピングするPostgreSQL データベースを使用する場合、データを JSON 形式で保存する列に遭遇することがよくあります。 Hibernate を使用してこれらの列を Java エンティティに効果的にマップするには、適切...プログラミング 2024 年 11 月 8 日に公開

カスタム ユーザー タイプを使用して PostgreSQL JSON 列を Hibernate エンティティにマップする方法PostgreSQL JSON 列を Hibernate エンティティにマッピングするPostgreSQL データベースを使用する場合、データを JSON 形式で保存する列に遭遇することがよくあります。 Hibernate を使用してこれらの列を Java エンティティに効果的にマップするには、適切...プログラミング 2024 年 11 月 8 日に公開 -

チーム全体で一貫した Node.js バージョンを確保する.nvmrc と package.json の包括的なガイド 今日の動的な開発状況では、さまざまなプロジェクトにわたって複数の Node.js バージョンを管理することは、多くの場合、複雑でエラーが発生しやすい作業になります。 Node.js のバージョンに一貫性がない場合、予期しない動作からアプリ...プログラミング 2024 年 11 月 8 日に公開

チーム全体で一貫した Node.js バージョンを確保する.nvmrc と package.json の包括的なガイド 今日の動的な開発状況では、さまざまなプロジェクトにわたって複数の Node.js バージョンを管理することは、多くの場合、複雑でエラーが発生しやすい作業になります。 Node.js のバージョンに一貫性がない場合、予期しない動作からアプリ...プログラミング 2024 年 11 月 8 日に公開 -

Promise.reject と JavaScript Promise をスローするのはどのような場合に使用するのですか?JavaScript Promises: Reject と Throw の謎JavaScript Promise を扱うとき、開発者はしばしばジレンマに直面します: Promise を使用すべきか.reject ですか、それとも単にエラーをスローしますか?どちらの方法も同様の目的を果たしますが、その...プログラミング 2024 年 11 月 8 日に公開

Promise.reject と JavaScript Promise をスローするのはどのような場合に使用するのですか?JavaScript Promises: Reject と Throw の謎JavaScript Promise を扱うとき、開発者はしばしばジレンマに直面します: Promise を使用すべきか.reject ですか、それとも単にエラーをスローしますか?どちらの方法も同様の目的を果たしますが、その...プログラミング 2024 年 11 月 8 日に公開 -

HTML 出力がレンダリングされずにプレーン テキストとして表示されるのはなぜですか?HTML 出力が HTML として受信されるのではなく、プレーン テキストとして解釈されるここでの質問は、HTML 出力が代わりにプレーン テキストとしてレンダリングされるシナリオに関するものです。適切な HTML として解析されるかどうか。基本的な Go 実装が提供されていますが、レンダリングされ...プログラミング 2024 年 11 月 8 日に公開

HTML 出力がレンダリングされずにプレーン テキストとして表示されるのはなぜですか?HTML 出力が HTML として受信されるのではなく、プレーン テキストとして解釈されるここでの質問は、HTML 出力が代わりにプレーン テキストとしてレンダリングされるシナリオに関するものです。適切な HTML として解析されるかどうか。基本的な Go 実装が提供されていますが、レンダリングされ...プログラミング 2024 年 11 月 8 日に公開 -

Chrome 拡張機能の構築 : 概要Mods—改造? ゲーム好きなら、改造されたゲームをプレイすることほど楽しいものはないことをご存知でしょう。お気に入りのゲームですが、さらなるパワー、機能、楽しさが備わっています。次に、同じ興奮を Web ブラウジング体験にもたらすことを想像してみてください。ブラウザ拡張機能はまさにそれです。ブラウ...プログラミング 2024 年 11 月 8 日に公開

Chrome 拡張機能の構築 : 概要Mods—改造? ゲーム好きなら、改造されたゲームをプレイすることほど楽しいものはないことをご存知でしょう。お気に入りのゲームですが、さらなるパワー、機能、楽しさが備わっています。次に、同じ興奮を Web ブラウジング体験にもたらすことを想像してみてください。ブラウザ拡張機能はまさにそれです。ブラウ...プログラミング 2024 年 11 月 8 日に公開 -

CSSを使用してテーブルの列幅を設定するにはどうすればよいですか?テーブルの列幅の設定テーブルは一般に表形式のデータを表示するために使用されますが、読みやすさと適切性を確保するには列幅の調整が不可欠です。アライメント。この記事では、CSS を使用してテーブルの列の幅を設定する方法を説明します。CSS の width プロパティを使用する方法テーブルの列の幅は次のよ...プログラミング 2024 年 11 月 8 日に公開

CSSを使用してテーブルの列幅を設定するにはどうすればよいですか?テーブルの列幅の設定テーブルは一般に表形式のデータを表示するために使用されますが、読みやすさと適切性を確保するには列幅の調整が不可欠です。アライメント。この記事では、CSS を使用してテーブルの列の幅を設定する方法を説明します。CSS の width プロパティを使用する方法テーブルの列の幅は次のよ...プログラミング 2024 年 11 月 8 日に公開 -

Python の入れ子関数から非ローカル変数にアクセスする方法入れ子関数スコープでの非ローカル変数へのアクセスPython では、入れ子関数スコープにより、外側のスコープへのアクセスが提供されます。ただし、入れ子になった関数内の囲みスコープ内の変数を変更しようとすると、UnboundLocalError が発生する可能性があります。この問題に対処するには、次の...プログラミング 2024 年 11 月 8 日に公開

Python の入れ子関数から非ローカル変数にアクセスする方法入れ子関数スコープでの非ローカル変数へのアクセスPython では、入れ子関数スコープにより、外側のスコープへのアクセスが提供されます。ただし、入れ子になった関数内の囲みスコープ内の変数を変更しようとすると、UnboundLocalError が発生する可能性があります。この問題に対処するには、次の...プログラミング 2024 年 11 月 8 日に公開 -

CSSを使用してTEXTにグラデーションを適用します。テキストのグラデーション 今ではテキストのグラデーションなどの素敵なトリックがあちこちで見られるようになりました...でも?それらがどのように作られるのか疑問に思ったことはありますか?今日は私が教えてあげましょう。 .text-gradient { background: li...プログラミング 2024 年 11 月 8 日に公開

CSSを使用してTEXTにグラデーションを適用します。テキストのグラデーション 今ではテキストのグラデーションなどの素敵なトリックがあちこちで見られるようになりました...でも?それらがどのように作られるのか疑問に思ったことはありますか?今日は私が教えてあげましょう。 .text-gradient { background: li...プログラミング 2024 年 11 月 8 日に公開

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning