IAMB アルゴリズムによる機能選択: 機械学習へのカジュアルなダイビング

それでは、話は次のとおりです。私は最近、増分相関マルコフブランケット (IAMB) と呼ばれる非常に優れたアルゴリズムを含む Zhuang 教授による学校の課題に取り組みました。私にはデータ サイエンスや統計のバックグラウンドがないので、これは私にとって新しい領域ですが、何か新しいことを学ぶのは大好きです。目標? IAMB を使用してデータセット内の特徴を選択し、それが機械学習モデルのパフォーマンスにどのような影響を与えるかを確認します。

IAMB アルゴリズムの基本を確認し、それを Jason Brownlee のデータセットの ピマ インディアン糖尿病データセット に適用します。このデータセットは女性の健康データを追跡しており、糖尿病の有無も含まれています。 IAMB を使用して、糖尿病の予測に最も重要な特徴 (BMI や血糖値など) を特定します。

IAMB アルゴリズムとは何ですか?また、それを使用する理由は何ですか?

IAMB アルゴリズムは、ミステリーの容疑者リストを整理するのに役立つ友人のようなものです。これは、ターゲットを予測するために本当に重要な変数のみを選択するように設計された特徴選択方法です。この場合、ターゲットは誰かが糖尿病を患っているかどうかです。

- フォワードフェーズ: ターゲットと強く関連する変数を追加します。

- バックワードフェーズ: 実際には役に立たない変数を削除し、最も重要な変数だけを残します。

より簡単に言うと、IAMB は、最も関連性の高い特徴のみを選択することで、データセット内の混乱を避けるのに役立ちます。これは、物事をシンプルにしてモデルのパフォーマンスを向上させ、トレーニング時間を短縮したい場合に特に便利です。

出典: 大規模マルコフブランケット発見のアルゴリズム

このアルファ的なものとは何ですか?なぜそれが重要なのでしょうか?

ここで アルファ が登場します。統計において、アルファ (α) は、何が「統計的に有意」であるかを決定するために設定するしきい値です。教授からの指示の一環として、私はアルファ 0.05 を使用しました。これは、ターゲット変数にランダムに関連付けられる可能性が 5% 未満の特徴だけを保持したいことを意味します。したがって、特徴の p 値 が 0.05 未満の場合、ターゲットと統計的に有意な強力な関連性があることを意味します。

このアルファしきい値を使用することで、最も意味のある変数のみに焦点を当て、「有意性」テストに合格しない変数は無視します。これは、最も関連性の高い機能を保持し、ノイズを取り除くフィルターのようなものです。

実践: ピマ インディアンの糖尿病データセットで IAMB を使用する

セットアップは次のとおりです。ピマ インディアンの糖尿病データセットには、健康に関する特徴 (血圧、年齢、インスリン レベルなど) と、目標である 結果 (誰かが糖尿病であるかどうか) が含まれています。

まず、データをロードしてチェックアウトします:

import pandas as pd # Load and preview the dataset url = 'https://raw.githubusercontent.com/jbrownlee/Datasets/master/pima-indians-diabetes.data.csv' column_names = ['Pregnancies', 'Glucose', 'BloodPressure', 'SkinThickness', 'Insulin', 'BMI', 'DiabetesPedigreeFunction', 'Age', 'Outcome'] data = pd.read_csv(url, names=column_names) print(data.head())

Alpha = 0.05 で IAMB を実装する

これが IAMB アルゴリズムの更新バージョンです。 p 値 を使用してどの特徴を保持するかを決定しているため、アルファ (0.05) より小さい p 値を持つ特徴だけが選択されます。

import pingouin as pg

def iamb(target, data, alpha=0.05):

markov_blanket = set()

# Forward Phase: Add features with a p-value alpha

for feature in list(markov_blanket):

reduced_mb = markov_blanket - {feature}

result = pg.partial_corr(data=data, x=feature, y=target, covar=reduced_mb)

p_value = result.at[0, 'p-val']

if p_value > alpha:

markov_blanket.remove(feature)

return list(markov_blanket)

# Apply the updated IAMB function on the Pima dataset

selected_features = iamb('Outcome', data, alpha=0.05)

print("Selected Features:", selected_features)

これを実行すると、IAMB が糖尿病の転帰に最も密接に関連していると考えた機能の洗練されたリストが表示されました。このリストは、モデルの構築に必要な変数を絞り込むのに役立ちます。

Selected Features: ['BMI', 'DiabetesPedigreeFunction', 'Pregnancies', 'Glucose']

IAMB が選択した機能がモデルのパフォーマンスに与える影響のテスト

選択した特徴を取得したら、実際のテストでは、すべての特徴とIAMB で選択した特徴のモデルのパフォーマンスを比較します。このために、私は単純な ガウス単純ベイズ モデルを使用しました。これは単純であり、確率をうまく扱うためです (ベイジアン全体の雰囲気と結びついています)。

モデルをトレーニングしてテストするコードは次のとおりです:

from sklearn.model_selection import train_test_split

from sklearn.naive_bayes import GaussianNB

from sklearn.metrics import accuracy_score, f1_score, roc_auc_score

# Split data

X = data.drop('Outcome', axis=1)

y = data['Outcome']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# Model with All Features

model_all = GaussianNB()

model_all.fit(X_train, y_train)

y_pred_all = model_all.predict(X_test)

# Model with IAMB-Selected Features

X_train_selected = X_train[selected_features]

X_test_selected = X_test[selected_features]

model_iamb = GaussianNB()

model_iamb.fit(X_train_selected, y_train)

y_pred_iamb = model_iamb.predict(X_test_selected)

# Evaluate models

results = {

'Model': ['All Features', 'IAMB-Selected Features'],

'Accuracy': [accuracy_score(y_test, y_pred_all), accuracy_score(y_test, y_pred_iamb)],

'F1 Score': [f1_score(y_test, y_pred_all, average='weighted'), f1_score(y_test, y_pred_iamb, average='weighted')],

'AUC-ROC': [roc_auc_score(y_test, y_pred_all), roc_auc_score(y_test, y_pred_iamb)]

}

results_df = pd.DataFrame(results)

display(results_df)

結果

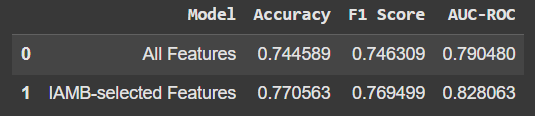

比較は次のようになります:

IAMB が選択した機能のみを使用すると、精度やその他の指標がわずかに向上しました。これは大きな飛躍ではありませんが、機能を減らしてパフォーマンスが向上しているという事実は有望です。さらに、これは、モデルが「ノイズ」や無関係なデータに依存していないことを意味します。

重要なポイント

- IAMB は特徴選択に最適です: ターゲットを予測する上で本当に重要なものだけに焦点を当て、データセットをクリーンアップするのに役立ちます。

- 少ないほど良いことがよくあります: ここで見られるように、モデルの精度がわずかに向上したように、機能が少ないほど良い結果が得られることがあります。

- 学習と実験は楽しい部分です: データ サイエンスの深い背景がなくても、このようなプロジェクトに参加すると、データと機械学習を理解するための新しい方法が開かれます。

これが IAMB へのわかりやすい入門になれば幸いです。興味があれば、試してみてください。これは機械学習ツールボックスに含まれる便利なツールであり、自分のプロジェクトで素晴らしい改善が見られるかもしれません。

出典: 大規模マルコフブランケット発見のアルゴリズム

-

decimal.parse()を使用して指数表記で数値を解析する方法は?指数表記 からの数字を解析する場合、decimal.parse( "1.2345e-02")を使用して指数表記で表現された文字列を解析しようとすると、エラーが発生します。これは、デフォルトの解析方法が指数表記法を認識しないためです。次の例に示すように、numberSty...プログラミング 2025-07-03に投稿されました

decimal.parse()を使用して指数表記で数値を解析する方法は?指数表記 からの数字を解析する場合、decimal.parse( "1.2345e-02")を使用して指数表記で表現された文字列を解析しようとすると、エラーが発生します。これは、デフォルトの解析方法が指数表記法を認識しないためです。次の例に示すように、numberSty...プログラミング 2025-07-03に投稿されました -

なぜLambdaの式には、Javaの「最終」または「有効な最終」変数が必要なのですか?lambda式には、「最終」または「効果的に最終」変数 は、「ラムダ式で使用される変数が最終または効果的に最終的に」を示すことを示します。 final。 //コードがありません cal.getComponents()。getComponents( "vtimez...プログラミング 2025-07-03に投稿されました

なぜLambdaの式には、Javaの「最終」または「有効な最終」変数が必要なのですか?lambda式には、「最終」または「効果的に最終」変数 は、「ラムダ式で使用される変数が最終または効果的に最終的に」を示すことを示します。 final。 //コードがありません cal.getComponents()。getComponents( "vtimez...プログラミング 2025-07-03に投稿されました -

最大カウントを見つけるときにmysqlで\ "無効なグループ関数の使用を解決する方法\"エラーは?mysql を使用して最大カウントを取得する方法mysqlでは、次のコマンドを使用して特定の列によってグループ化された値の最大値を見つけようとする際に問題に遭遇する可能性があります。 emp1グループからmax(count(*))を名前で選択します。 エラー1111(HY000):グル...プログラミング 2025-07-03に投稿されました

最大カウントを見つけるときにmysqlで\ "無効なグループ関数の使用を解決する方法\"エラーは?mysql を使用して最大カウントを取得する方法mysqlでは、次のコマンドを使用して特定の列によってグループ化された値の最大値を見つけようとする際に問題に遭遇する可能性があります。 emp1グループからmax(count(*))を名前で選択します。 エラー1111(HY000):グル...プログラミング 2025-07-03に投稿されました -

匿名のJavaScriptイベントハンドラーをきれいに削除する方法は?匿名イベントリスナーを削除する を追加する要素にリスナーを追加すると、それらを削除する時が来ると、要素自体を置き換えることなく挑戦をもたらすことができます。 element? element.addeventlistener(event、function(){/はここで動作します。ハンド...プログラミング 2025-07-03に投稿されました

匿名のJavaScriptイベントハンドラーをきれいに削除する方法は?匿名イベントリスナーを削除する を追加する要素にリスナーを追加すると、それらを削除する時が来ると、要素自体を置き換えることなく挑戦をもたらすことができます。 element? element.addeventlistener(event、function(){/はここで動作します。ハンド...プログラミング 2025-07-03に投稿されました -

マウスクリック時にDiv内のすべてのテキストをプログラム的に選択するにはどうすればよいですか?マウスクリックでプログラムをプログラム的に選択する 質問 テキストコンテンツのdiv要素が与えられた場合、ユーザーは1つのマウスクリックでdiv内のテキスト全体をプログラム的に選択できますか?これにより、ユーザーは選択したテキストを簡単にドラッグアンドドロップしたり、直接コピーしたりできます。...プログラミング 2025-07-03に投稿されました

マウスクリック時にDiv内のすべてのテキストをプログラム的に選択するにはどうすればよいですか?マウスクリックでプログラムをプログラム的に選択する 質問 テキストコンテンツのdiv要素が与えられた場合、ユーザーは1つのマウスクリックでdiv内のテキスト全体をプログラム的に選択できますか?これにより、ユーザーは選択したテキストを簡単にドラッグアンドドロップしたり、直接コピーしたりできます。...プログラミング 2025-07-03に投稿されました -

動的にサイズの親要素内の要素のスクロール範囲を制限する方法は?垂直スクロール要素のcss高さ制限の実装 インタラクティブインターフェイスで、要素のスクロール挙動を制御することは、ユーザーエクスペリエンスとアクセシビリティを確保するために不可欠です。そのようなシナリオの1つは、動的にサイズの親要素内の要素のスクロール範囲を制限することです。ただし、マッ...プログラミング 2025-07-03に投稿されました

動的にサイズの親要素内の要素のスクロール範囲を制限する方法は?垂直スクロール要素のcss高さ制限の実装 インタラクティブインターフェイスで、要素のスクロール挙動を制御することは、ユーザーエクスペリエンスとアクセシビリティを確保するために不可欠です。そのようなシナリオの1つは、動的にサイズの親要素内の要素のスクロール範囲を制限することです。ただし、マッ...プログラミング 2025-07-03に投稿されました -

右のテーブルの句でフィルタリングするとき、なぜ左結合が接続内に見えるのですか?left join conundrum:witching時間:データベースウィザードの領域で内側の結合 に変わる時間は、左結合を使用して複雑なデータ検索を実行することは一般的な慣行です。ただし、時々、左の結合が予想通りに動作しないことがあります。 A.foo、 B.BAR、 C.Foobar...プログラミング 2025-07-03に投稿されました

右のテーブルの句でフィルタリングするとき、なぜ左結合が接続内に見えるのですか?left join conundrum:witching時間:データベースウィザードの領域で内側の結合 に変わる時間は、左結合を使用して複雑なデータ検索を実行することは一般的な慣行です。ただし、時々、左の結合が予想通りに動作しないことがあります。 A.foo、 B.BAR、 C.Foobar...プログラミング 2025-07-03に投稿されました -

Python Metaclass作業原則とクラスの作成とカスタマイズPythonのメタクラスとは?クラスがインスタンスを作成するのと同じように、Metaclassはクラスを作成します。クラスの作成プロセスを制御する層を提供し、クラスの動作と属性のカスタマイズを可能にします。これは、クラス自体がクラスキーワードを使用してクラスの「説明」から作成されたインスタン...プログラミング 2025-07-03に投稿されました

Python Metaclass作業原則とクラスの作成とカスタマイズPythonのメタクラスとは?クラスがインスタンスを作成するのと同じように、Metaclassはクラスを作成します。クラスの作成プロセスを制御する層を提供し、クラスの動作と属性のカスタマイズを可能にします。これは、クラス自体がクラスキーワードを使用してクラスの「説明」から作成されたインスタン...プログラミング 2025-07-03に投稿されました -

なぜ画像はまだChromeに境界があるのですか? `border:none;`無効な解決策cromeの画像境界を削除する 1つの頻繁な問題は、chromeとie9の画像を操作する際に遭遇する頻繁な問題です。と「国境:なし;」 CSSで。この問題を解決するには、次のアプローチを検討してください。スタイル。これを回避するには、次のCSS IDブロックを使用して、目的のパディング...プログラミング 2025-07-03に投稿されました

なぜ画像はまだChromeに境界があるのですか? `border:none;`無効な解決策cromeの画像境界を削除する 1つの頻繁な問題は、chromeとie9の画像を操作する際に遭遇する頻繁な問題です。と「国境:なし;」 CSSで。この問題を解決するには、次のアプローチを検討してください。スタイル。これを回避するには、次のCSS IDブロックを使用して、目的のパディング...プログラミング 2025-07-03に投稿されました -

なぜ `body {margin:0; } `常にCSSの上限を削除しますか?css の扱います。多くの場合、「ボディ{マージン:0;}」などの提供されたコードは、目的の結果を生成しません。これは、コンテンツの親要素が正のパディング値を持っている場合に発生する可能性があります。特定のマージンの問題に対処することをお勧めします。親要素にパディングがある場合、それを...プログラミング 2025-07-03に投稿されました

なぜ `body {margin:0; } `常にCSSの上限を削除しますか?css の扱います。多くの場合、「ボディ{マージン:0;}」などの提供されたコードは、目的の結果を生成しません。これは、コンテンツの親要素が正のパディング値を持っている場合に発生する可能性があります。特定のマージンの問題に対処することをお勧めします。親要素にパディングがある場合、それを...プログラミング 2025-07-03に投稿されました -

コンパイラエラー「USR/BIN/LD:-L」ソリューションが見つかりませんエラーが発生したエラー: "usr/bin/ld:l " はプログラムをコンパイルしようとすると、次のエラーメッセージに遭遇する可能性があります: -l usr/bin/ld: cannot find -l<nameOfTheLibrary> ld ...プログラミング 2025-07-03に投稿されました

コンパイラエラー「USR/BIN/LD:-L」ソリューションが見つかりませんエラーが発生したエラー: "usr/bin/ld:l " はプログラムをコンパイルしようとすると、次のエラーメッセージに遭遇する可能性があります: -l usr/bin/ld: cannot find -l<nameOfTheLibrary> ld ...プログラミング 2025-07-03に投稿されました -

McRyptからOpenSSLに暗号化を移行し、OpenSSLを使用してMcRyptで暗号化されたデータを復号化できますか?暗号化ライブラリをMcRyptからOpenSSL にアップグレードして、暗号化ライブラリをMcRyptからOpenSLにアップグレードできますか? OpenSSLでは、McRyptで暗号化されたデータを復号化することは可能ですか? 2つの異なる投稿は矛盾する情報を提供します。もしそうなら...プログラミング 2025-07-03に投稿されました

McRyptからOpenSSLに暗号化を移行し、OpenSSLを使用してMcRyptで暗号化されたデータを復号化できますか?暗号化ライブラリをMcRyptからOpenSSL にアップグレードして、暗号化ライブラリをMcRyptからOpenSLにアップグレードできますか? OpenSSLでは、McRyptで暗号化されたデータを復号化することは可能ですか? 2つの異なる投稿は矛盾する情報を提供します。もしそうなら...プログラミング 2025-07-03に投稿されました -

Silverlight linqクエリで「クエリパターンの実装が見つからなかった」エラーを取得するのはなぜですか?Queryパターンの実装不在:「silverlightアプリケーションで「&&&&] を解決する」cleryパターンの不在、linqを使用してデータベース接続を確立しようとする試みは、「クエリパターンの実装」を見つけることができませんでした。このエラーは通常、LINQネームスペースが省略...プログラミング 2025-07-03に投稿されました

Silverlight linqクエリで「クエリパターンの実装が見つからなかった」エラーを取得するのはなぜですか?Queryパターンの実装不在:「silverlightアプリケーションで「&&&&] を解決する」cleryパターンの不在、linqを使用してデータベース接続を確立しようとする試みは、「クエリパターンの実装」を見つけることができませんでした。このエラーは通常、LINQネームスペースが省略...プログラミング 2025-07-03に投稿されました -

偽のウェイクアップは本当にJavaで起こりますか?Javaの偽りの目覚め:現実か神話ですか?そのような動作の可能性は存在しますが、問題は残ります:それらは実際に実際に発生しますか?プロセスが信号を受信すると、EINTRで突然戻ってきて、ブロッキングシステムの呼び出しを早期に終了させる可能性があります。その結果、POSIX信号はスプリアスウェ...プログラミング 2025-07-03に投稿されました

偽のウェイクアップは本当にJavaで起こりますか?Javaの偽りの目覚め:現実か神話ですか?そのような動作の可能性は存在しますが、問題は残ります:それらは実際に実際に発生しますか?プロセスが信号を受信すると、EINTRで突然戻ってきて、ブロッキングシステムの呼び出しを早期に終了させる可能性があります。その結果、POSIX信号はスプリアスウェ...プログラミング 2025-07-03に投稿されました

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning