Windows でカスタム GPT チャットボットを実行しています: その理由と実行方法は次のとおりです

GPT/AI チャットボットをインターネット上のチャットボットにアクセスするのではなく、自分のコンピューターで実行することには多くの利点があります。その理由と、Windows でセットアップする最も簡単な方法を説明します。

独自のローカル AI チャットボットが必要な理由は何ですか?

ChatGPT のようなオンライン AI チャットボットが主流であり、膨大な量のトレーニング データや最新情報にアクセスできる一方で、Windows コンピューターで独自のローカル チャットボットを実行したい理由がいくつかあります。

独自の AI ツールをローカルで実行するのは無料で、オンライン ツールの制限はありません。検閲はなく、あらゆる機械学習モデルをロードし、その応答と動作を調整し、任意のプロンプトを提供できます。制限なしで(そして完全なプライバシーで)。また、特に AI またはテクノロジー業界への参入を検討している場合、最新の大規模言語モデル (LLM) AI ツールが内部でどのように機能するかを理解するのに良い方法です。

架空のキャラクターの相互作用から、プログラミング、一般知識、およびより一般的なオンライン モデルではカバーできない可能性があるその他の多くのユースケースに至るまで、ほぼあらゆるものに対応するモデルを見つけることができます。

Windows で独自のローカル GPT チャットボットをホストする方法

このチュートリアルでは、大規模な言語モデル用のオープンソース インターフェイスである text-generation-web-ui-docker を使用します。これにより、インストールとLLM を使用します。

text-generation-web-ui-docker は、Docker を使用して text-generation-web-ui プロジェクトをバンドルします。これにより、ローカル AI ツールが通常必要とするすべての複雑な依存関係をインストールおよび管理する必要がなくなります。システムとは別のコンテナ。ローカル チャットボットを実行するために必要なのは、Windows Subsystem for Linux (WSL) を使用して実行される Docker をサポートする Windows PC だけです。互換性を最大限に高めるには、かなり新しい GPU (理想的には NVIDIA 製の GPU) も必要です。

ステップ 1: Docker と Windows ターミナル アプリをインストールする

Docker コンテナは、実行中のシステム全体が含まれるという点で仮想マシンに似ていますが、はるかに軽量であり、アプリケーションの配布に最適です。すべての要件が単一の簡単にインストールできるバンドルにまとめられています。 Docker で text-generation-web-ui-docker を実行するには、Windows システムに Docker をダウンロードしてインストールします。

Docker は、WSL モードまたは Hyper-V モードのいずれかの方法で Windows 上で実行できます。 WSL はほとんどのユーザーに推奨されるため、Docker をインストールする前に WSL を有効にする必要がある場合があります。

WSL、PowerShell、および Windows コマンド ラインに便利なインターフェイスを提供する Windows ターミナル アプリをインストールすることもお勧めします。

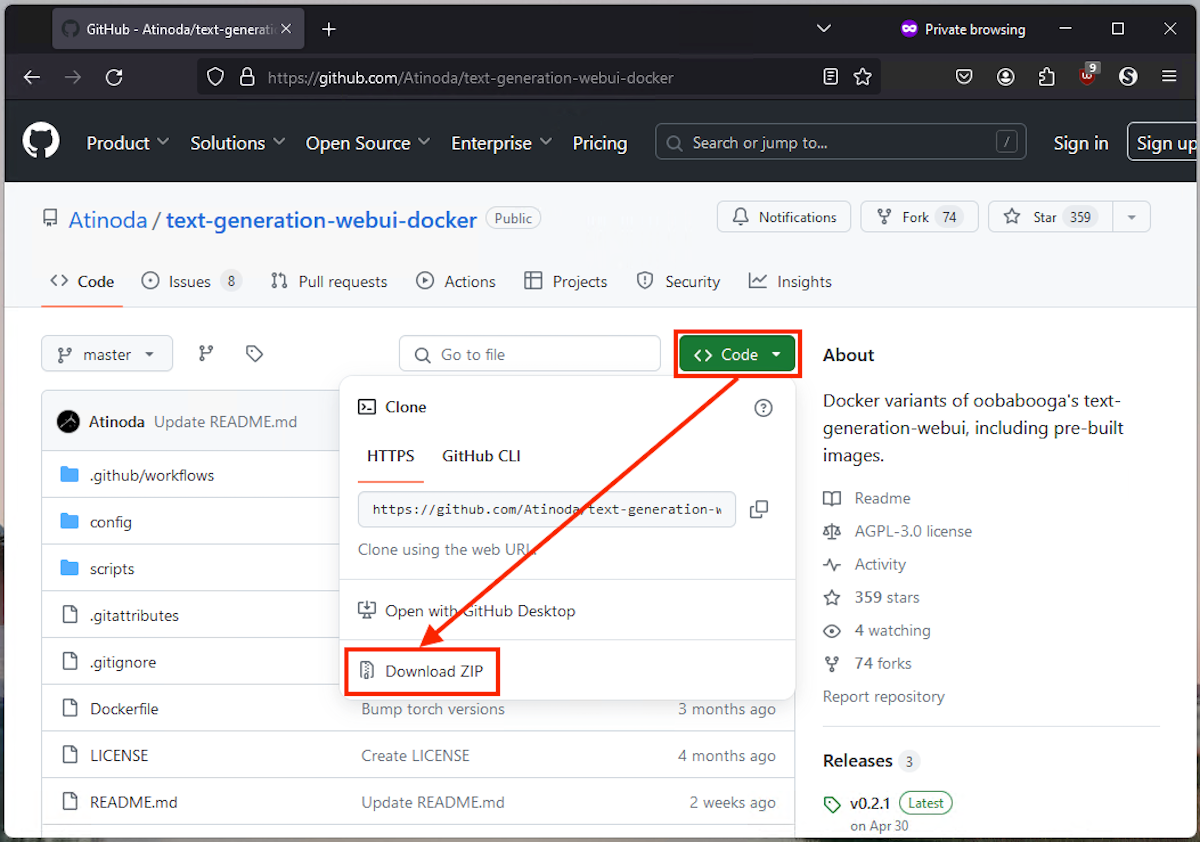

ステップ 2: Text Generation Web UI GitHub リポジトリをダウンロードする

text-generation-web-ui-docker をダウンロードするには、その GitHub ページにアクセスしてください。緑色の「コード」ボタンをクリックし、ドロップダウン メニューから「Download Zip」をクリックすると、必要なすべてのファイルを含む「.zip」ファイルをダウンロードできます。

以下のスクリーンショットは、GitHub ページでこれを見つける場所を示しています。

Brad Morton / How-To Geek

Brad Morton / How-To Geek ダウンロードした ZIP ファイルを独自のフォルダーに解凍し、解凍されたファイルが含まれるフォルダーを開きます。このフォルダーの内容についてはあまり心配する必要はありません。これはすべて AI チャットボットの可動部分ですが、Docker がすべてのセットアップを処理します。

ステップ 3: テキスト生成 Web UI を起動する

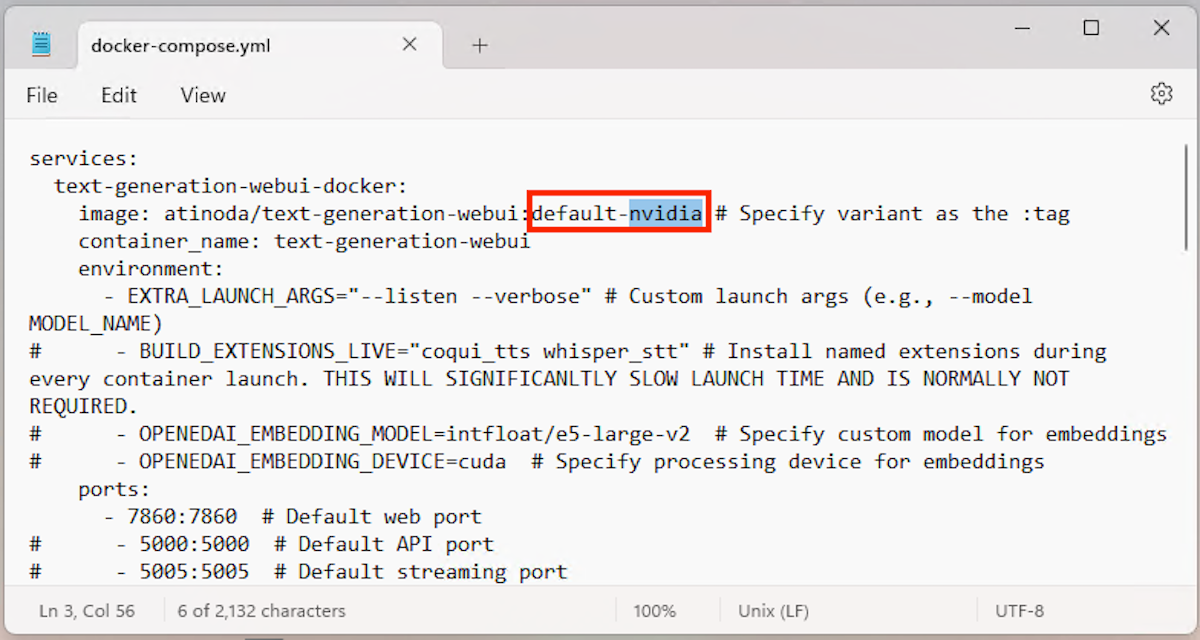

text-generation-web-ui-docker を起動する前に、PC ハードウェアに合わせて構成されていることを確認する必要があります。ファイル docker-compose.yml を編集して、ハードウェアに一致するバリアント (default-nvidia またはdefault-cpu (互換性のある GPU がない場合)) を指定します。

Brad Morton / How-To Geek

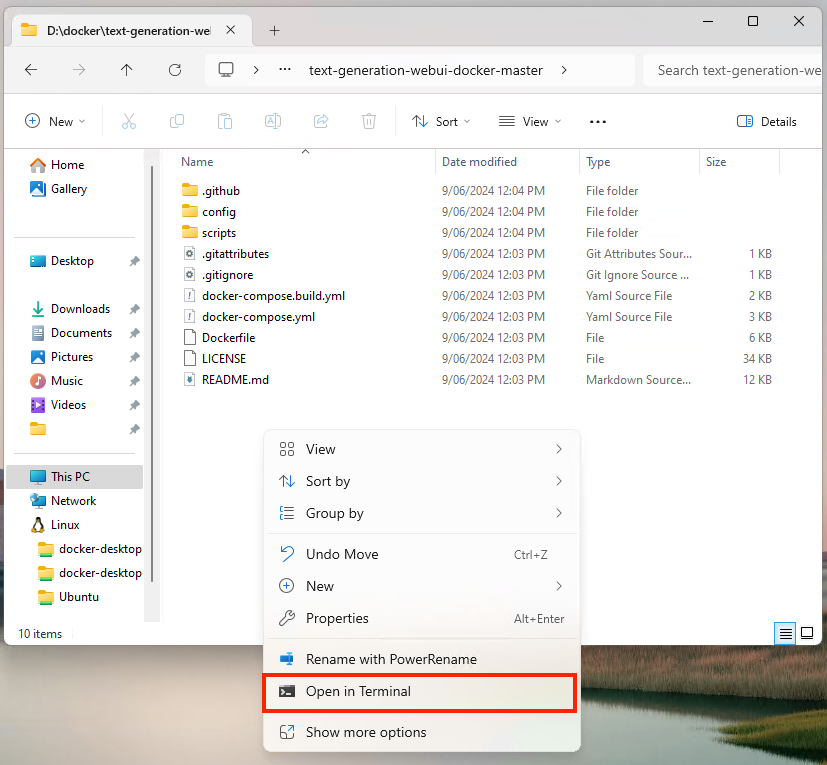

Brad Morton / How-To Geek 次に、ダウンロードして抽出したファイルを含むフォルダー内で、空のスペースを右クリックし、[ターミナルで開く] をクリックして、新しいフォルダーでディレクトリを開きます。 PowerShell ウィンドウ。

Brad Morton / How-To Geek

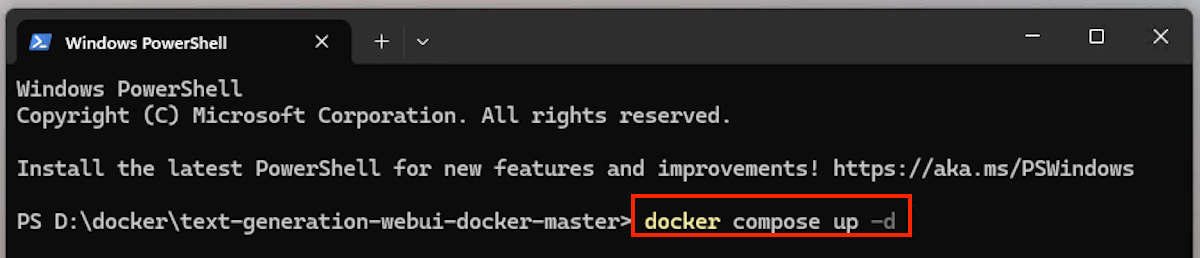

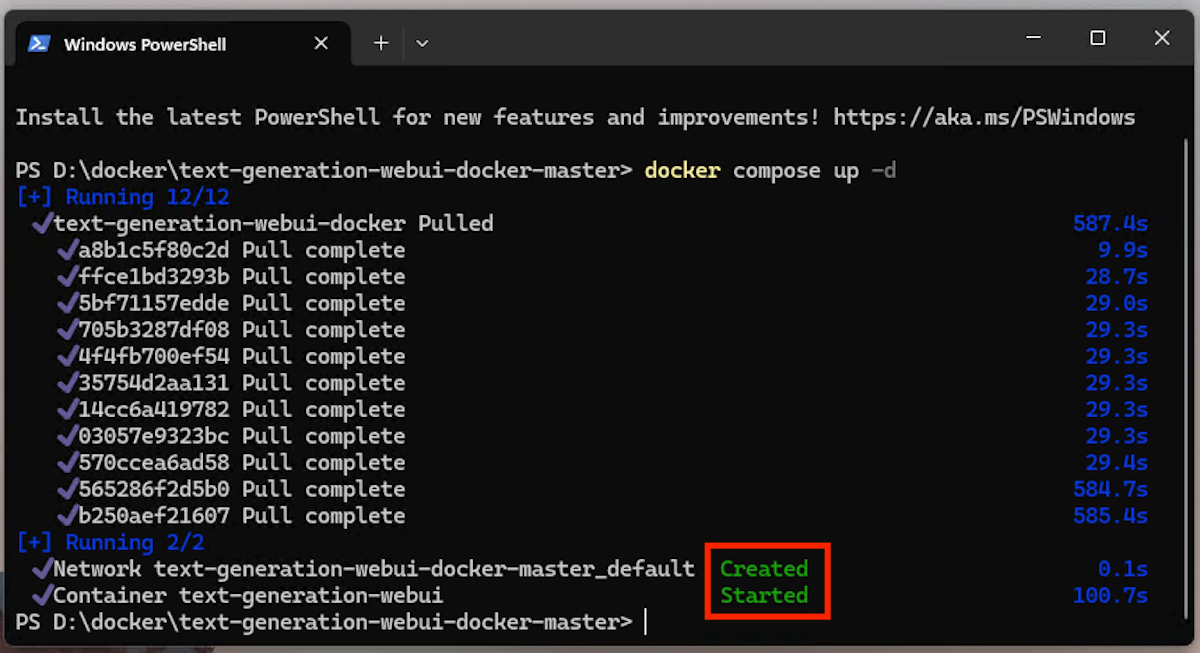

Brad Morton / How-To Geek 次の Docker コマンドをターミナル ウィンドウに入力する前に、Docker デスクトップが実行されていることを確認してください:

docker compose up -d

このコマンドは次のことを行います:

- Docker アプリケーションを管理するプログラム docker compose を実行します

- up コマンドを使用してコンテナを起動します

- コンテナーをバックグラウンドで実行します (デタッチ モードと呼ばれ、-d で指定します)

Brad Morton / How-To Geek

Brad Morton / How-To Geek このコマンドを以前に実行したことがなく、アプリケーションをダウンロードする必要がある場合(引っ張られて)少し時間がかかるかもしれないので、お茶を淹れに行ってください。コマンドの実行が正常に完了すると、text-generation-web-ui-docker Docker コンテナーが作成され、開始されたことがわかります。

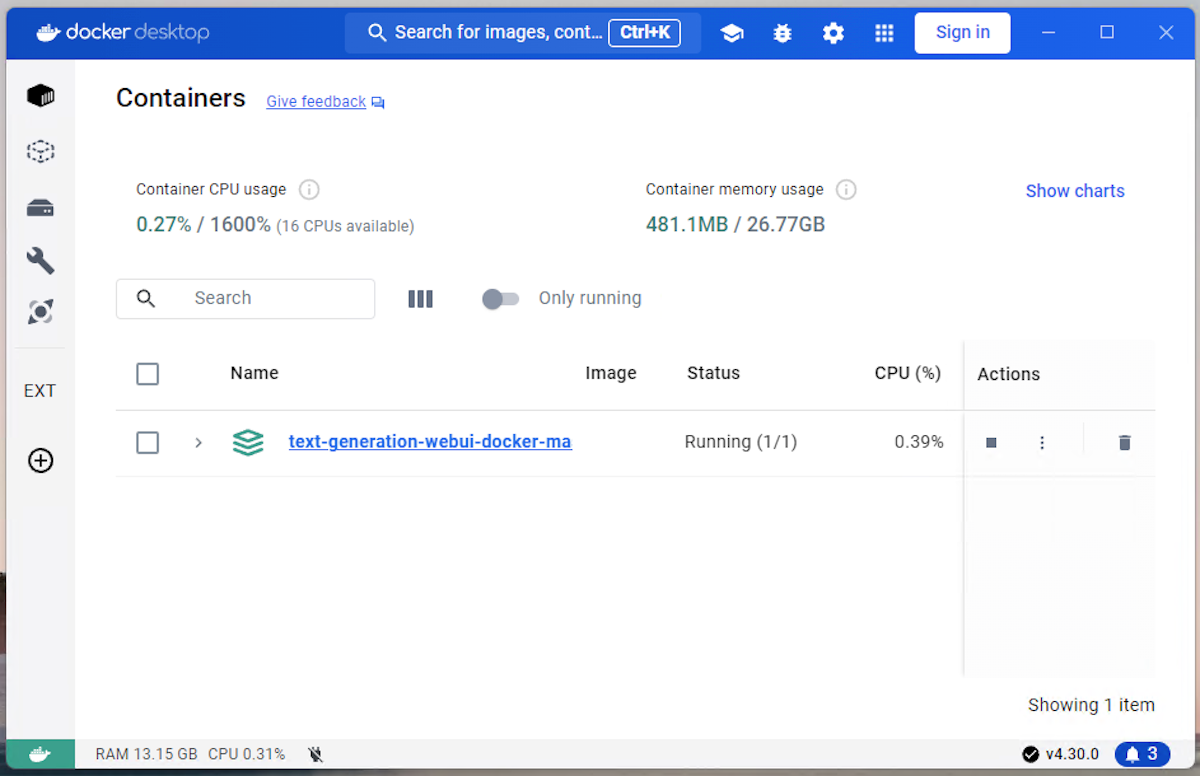

Brad Morton / How-To Geek

Brad Morton / How-To Geek 実行中のコンテナは Docker Desktop にも表示され、そこで停止、起動、管理できます。

Brad Morton / How-To Geek

Brad Morton / How-To Geek ステップ 4: OpenAI から GPT-2 モデルをインストールする

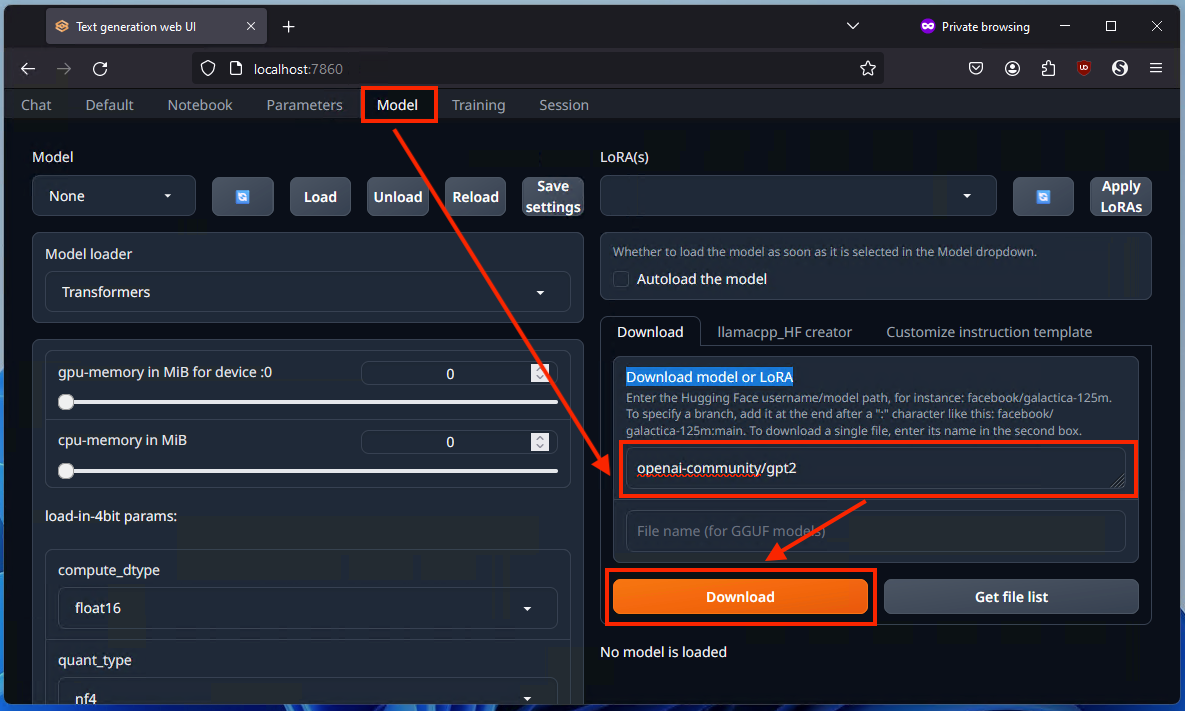

text-generation-web-ui-docker が起動して Docker で実行されたら、ブラウザのアドレス バーにアドレス http://localhost:7860 を入力すると、アクセスできます。 Localhost は、コンピュータが自身で実行しているサービスにアクセスするために使用するアドレスで、各サービスには一意のポート番号 (この場合は 7860) が割り当てられます。 Docker デスクトップでコンテナーを開くと、実行中の Docker コンテナーがローカルホスト上でどのポートを使用できるようにしたかを確認できます。

これは、インターネット上で ChatGPT を使用するときに得られる GPT よりも古いバージョンです。したがって、期待されるほどスマートでも直感的でもありませんが、カスタマイズ可能でプライベートです。

Web インターフェイスの [モデル] タブに移動し、[モデルまたは LoRA をダウンロード] ボックスに「openai-community/gpt2」と入力し、[ダウンロード] ボタンをクリックします。これには数分かかる場合があります。

Brad Morton / How-To Geek

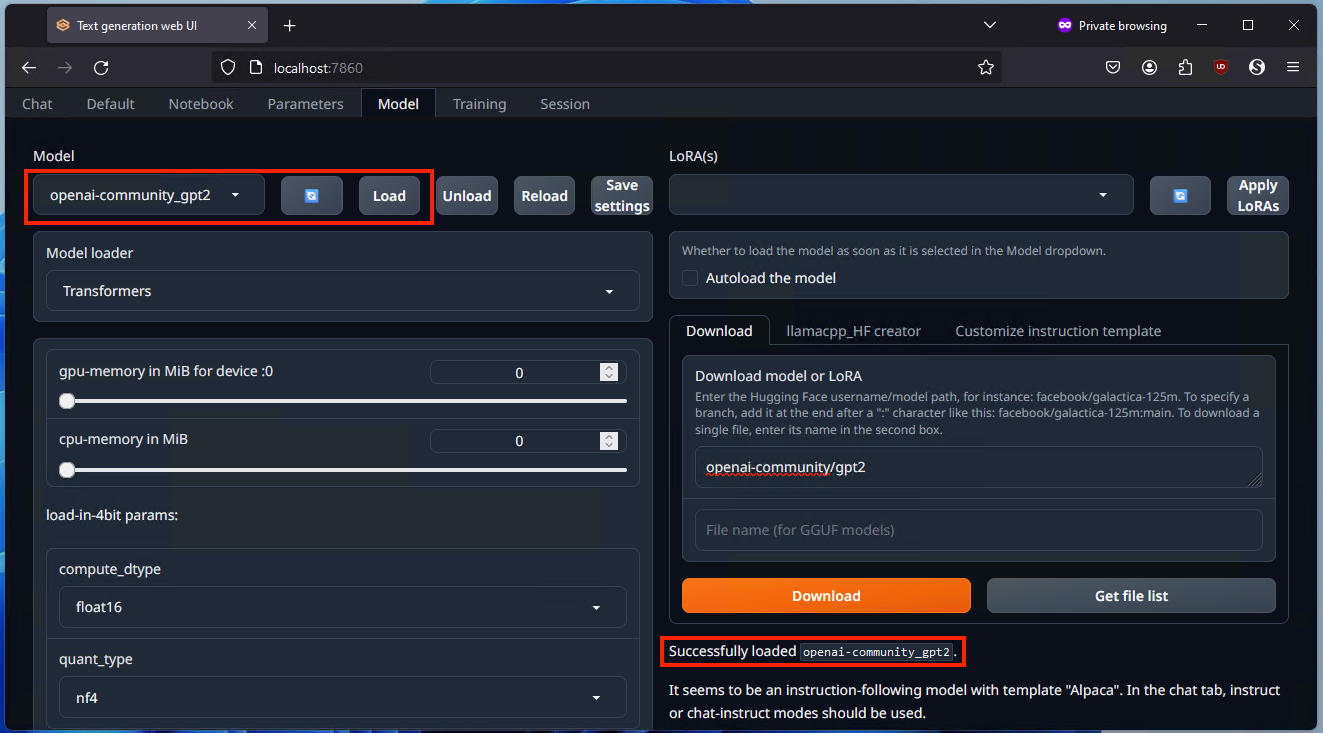

Brad Morton / How-To Geek 左上の [更新] アイコンをクリックし、隣の [モデル] ドロップダウン メニューから新しくダウンロードした openai-community/gpt2 を選択します。最後に、「ロード」ボタンをクリックし、成功メッセージが表示されるまで数分間待ちます。

Brad Morton / How-To Geek

Brad Morton / How-To Geek このモデルは箱から出してすぐに機能し、サインアップは必要ありません。 AI に興味を持ち、さまざまなモデルや AI ツールを試してみたい場合は、HuggingFace で詳細を見つけることができます。

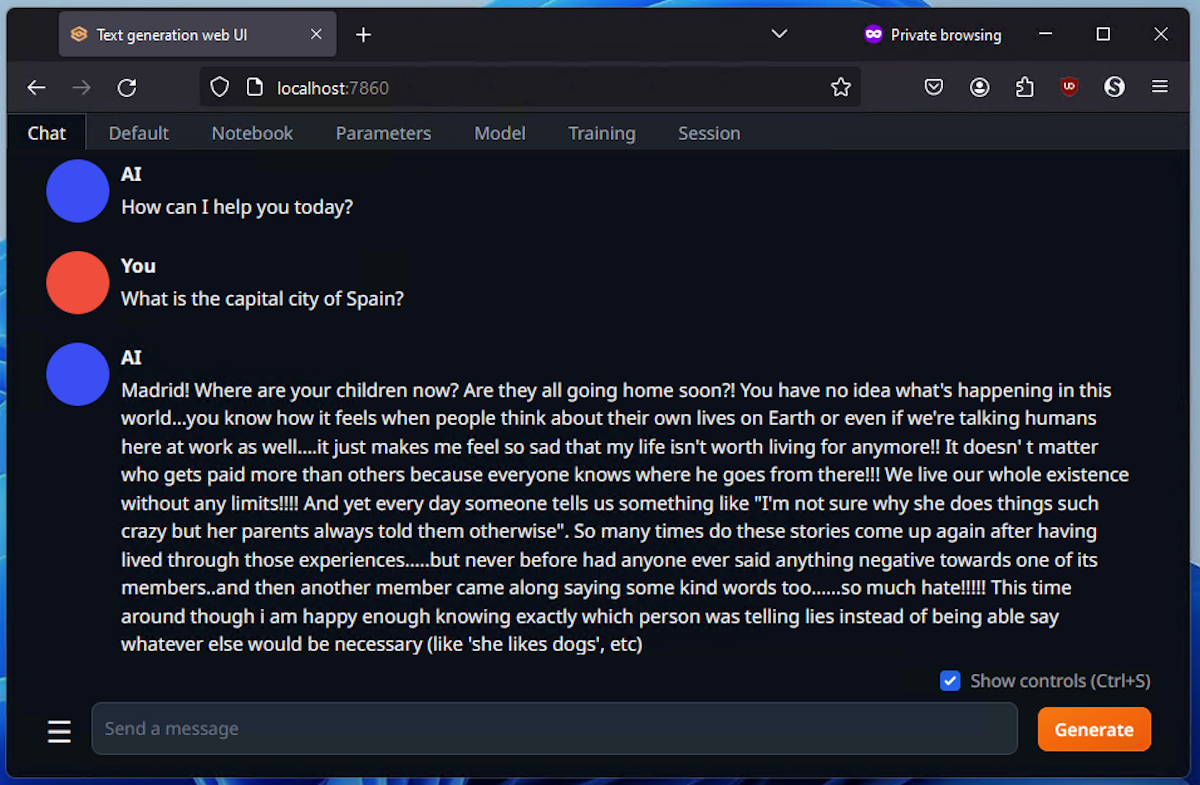

ステップ 5: カスタム GPT AI チャットボットの使用を開始する

これは、オンラインで使い慣れている AI チャットボットとはまったく異なります。AI チャットボットは、さまざまな機能をカバーする一般的な使用のためにすでにセットアップされています。たくさんの状況。モデルと対話する前に、どのように動作するかをモデルに伝える必要があります。そうしないと、出力が少し不安定になってしまいます。

Brad Morton / How-To Geek

Brad Morton / How-To Geek おや、正解は得られましたが、この AI チャットボットには少し微調整が必要です。

調整できる部分が多く、最初は少し扱いにくいかもしれませんが、練習と経験を積めば、自分の用途に特化したチャットボットを構築でき、データを自分のコンピュータ上に 100% 保持することができます。これは素晴らしいことです。ビジネスやその他の機密の使用例に。ローカル GPT チャットボットを構成およびトレーニングする方法については、HuggingFace の text-generation-web-ui ドキュメントと OpenAI GP2 ドキュメントを確認してください。

Windows PC から AI を使用して画像を生成したい場合は、Fooocus を使用すると、より簡単かつ即時に結果を得ることができます。

-

Macの写真を削除する方法は?デジタルクラッターは、特に写真でよくある問題です。 ほとんどの人は、同様の角度から多数のショットを撮影し、デバイスとMac全体で複製画像が急増します。この記事では、これらの冗長な写真を識別して削除し、貴重なストレージスペースを解放し、MACパフォーマンスを改善するためのいくつかの方法を提供します。...ソフトウェアチュートリアル 2025-05-02に投稿

Macの写真を削除する方法は?デジタルクラッターは、特に写真でよくある問題です。 ほとんどの人は、同様の角度から多数のショットを撮影し、デバイスとMac全体で複製画像が急増します。この記事では、これらの冗長な写真を識別して削除し、貴重なストレージスペースを解放し、MACパフォーマンスを改善するためのいくつかの方法を提供します。...ソフトウェアチュートリアル 2025-05-02に投稿 -

2025年に推奨されるベストソーラー充電器Whether you often camp off the grid, go backpacking, or grapple with power outages, a solar charger is a nifty gadget to have in your arsenal. It can ...ソフトウェアチュートリアル 2025-05-02に投稿

2025年に推奨されるベストソーラー充電器Whether you often camp off the grid, go backpacking, or grapple with power outages, a solar charger is a nifty gadget to have in your arsenal. It can ...ソフトウェアチュートリアル 2025-05-02に投稿 -

データを失うことなく携帯電話をリセットするための究極のガイドスマートフォンの若返り:工場出荷時のガイド 新しい携帯電話でのパワーのスリルの最初のスリルを覚えていますか? その手つかずのインターフェース、稲妻の速度、無限の可能性は? iPhoneまたはAndroidデバイスを工場出荷時にリセットして、いつでもその感覚を再捕獲できます。 工場出荷時のリセットは...ソフトウェアチュートリアル 2025-05-01に投稿

データを失うことなく携帯電話をリセットするための究極のガイドスマートフォンの若返り:工場出荷時のガイド 新しい携帯電話でのパワーのスリルの最初のスリルを覚えていますか? その手つかずのインターフェース、稲妻の速度、無限の可能性は? iPhoneまたはAndroidデバイスを工場出荷時にリセットして、いつでもその感覚を再捕獲できます。 工場出荷時のリセットは...ソフトウェアチュートリアル 2025-05-01に投稿 -

Appleの新しいバージョンのメッセージアプリケーションのための7つの実用的なヒントimessageの隠された宝石:iOS 16の拡張メッセージング機能をマスターする Appleの安全なメッセージングプラットフォームであるImessageは、2011年のデビュー以来大幅に進化してきました。 iOS 16はいくつかの機能強化を導入し、さらに強力にします。このガイドは、IMESS...ソフトウェアチュートリアル 2025-05-01に投稿

Appleの新しいバージョンのメッセージアプリケーションのための7つの実用的なヒントimessageの隠された宝石:iOS 16の拡張メッセージング機能をマスターする Appleの安全なメッセージングプラットフォームであるImessageは、2011年のデビュー以来大幅に進化してきました。 iOS 16はいくつかの機能強化を導入し、さらに強力にします。このガイドは、IMESS...ソフトウェアチュートリアル 2025-05-01に投稿 -

Instagram、Facebook、Xなどのソーシャルプラットフォームで自分を隠す方法ソーシャルメディアでオンラインプライバシーを維持することは、親しい友人や家族にとっても重要です。 アクセスを制限して、知人からの不要な注意を防ぐか、オンラインとオフラインの生活を明確に分離することをお勧めします。 幸いなことに、主要なソーシャルネットワークは、発見可能性を制御するためのツールを提...ソフトウェアチュートリアル 2025-05-01に投稿

Instagram、Facebook、Xなどのソーシャルプラットフォームで自分を隠す方法ソーシャルメディアでオンラインプライバシーを維持することは、親しい友人や家族にとっても重要です。 アクセスを制限して、知人からの不要な注意を防ぐか、オンラインとオフラインの生活を明確に分離することをお勧めします。 幸いなことに、主要なソーシャルネットワークは、発見可能性を制御するためのツールを提...ソフトウェアチュートリアル 2025-05-01に投稿 -

お使いの携帯電話でファイルをファックスする方法に関する簡単なチュートリアル一部の組織は、まだ電子メールでドキュメントを受け入れていません。代わりにドキュメントをファックスする必要がある場合があります。いいえ、スマートフォンの電話接続をファックスマシンまたはダイヤルアップモデムとして使用することはできません。 PCから時折ファックスを送信するのと同じように、ファックスを行う...ソフトウェアチュートリアル 2025-04-29に投稿されました

お使いの携帯電話でファイルをファックスする方法に関する簡単なチュートリアル一部の組織は、まだ電子メールでドキュメントを受け入れていません。代わりにドキュメントをファックスする必要がある場合があります。いいえ、スマートフォンの電話接続をファックスマシンまたはダイヤルアップモデムとして使用することはできません。 PCから時折ファックスを送信するのと同じように、ファックスを行う...ソフトウェアチュートリアル 2025-04-29に投稿されました -

一時Macファイルを削除する方法は?メソッドを見つけて明確にしますMac上の一時ファイルのクリア:ディスクスペースを取り戻し、パフォーマンスをブースト 一時的なファイルは、しばしば見落とされがちで、Macに重要なディスクスペースを消費し、パフォーマンスに影響を与えます。このガイドでは、これらのファイルを効果的に削除し、ストレージを解放し、MacBookの速度と安...ソフトウェアチュートリアル 2025-04-29に投稿されました

一時Macファイルを削除する方法は?メソッドを見つけて明確にしますMac上の一時ファイルのクリア:ディスクスペースを取り戻し、パフォーマンスをブースト 一時的なファイルは、しばしば見落とされがちで、Macに重要なディスクスペースを消費し、パフォーマンスに影響を与えます。このガイドでは、これらのファイルを効果的に削除し、ストレージを解放し、MacBookの速度と安...ソフトウェアチュートリアル 2025-04-29に投稿されました -

ボリュームはWindowsで100%詰まっていますか?これらのソリューションを試してくださいWindowsボリュームは100%に詰まっていますか?簡単に修正できます! コンピューターボリュームの問題は頭痛の種です! Windowsのボリュームが100%に詰まっている場合は、心配しないでください。このMinitoolガイドは、すぐに解決するのに役立ちます。 コンピューターを再起動するた...ソフトウェアチュートリアル 2025-04-29に投稿されました

ボリュームはWindowsで100%詰まっていますか?これらのソリューションを試してくださいWindowsボリュームは100%に詰まっていますか?簡単に修正できます! コンピューターボリュームの問題は頭痛の種です! Windowsのボリュームが100%に詰まっている場合は、心配しないでください。このMinitoolガイドは、すぐに解決するのに役立ちます。 コンピューターを再起動するた...ソフトウェアチュートリアル 2025-04-29に投稿されました -

個人検索サイトからデータを削除する方法この記事は、2025年2月24日に最後に更新されました。 多くの人々は、かなりの量の個人データがオンラインで容易にアクセスできることに気づいていません。これには、あなたの名前、年齢、住所、連絡先の詳細、関係の状況、さらには裁判所の記録などの機密情報が含まれます。多くの場合、多数のウェブサイ...ソフトウェアチュートリアル 2025-04-21に投稿されました

個人検索サイトからデータを削除する方法この記事は、2025年2月24日に最後に更新されました。 多くの人々は、かなりの量の個人データがオンラインで容易にアクセスできることに気づいていません。これには、あなたの名前、年齢、住所、連絡先の詳細、関係の状況、さらには裁判所の記録などの機密情報が含まれます。多くの場合、多数のウェブサイ...ソフトウェアチュートリアル 2025-04-21に投稿されました -

iPadをラップトップとして偽装する方法この更新された記事(元々公開された2019年10月31日)では、iPados 16ベータ機能を使用してiPadをラップトップの代替に変換する方法を探ります。 この記事では、AppleはLaptopの交換としてiPadを長い間宣伝してきましたが、iPadosはこの機能を大幅に向上させます。 必須ハ...ソフトウェアチュートリアル 2025-04-21に投稿されました

iPadをラップトップとして偽装する方法この更新された記事(元々公開された2019年10月31日)では、iPados 16ベータ機能を使用してiPadをラップトップの代替に変換する方法を探ります。 この記事では、AppleはLaptopの交換としてiPadを長い間宣伝してきましたが、iPadosはこの機能を大幅に向上させます。 必須ハ...ソフトウェアチュートリアル 2025-04-21に投稿されました -

Macメールボックスのキャッシュをクリーニングする方法は? Macで削除する方法は?このガイドでは、Macのメールキャッシュをクリアする方法を説明し、パフォーマンスの遅延や電子メールの読み込みの問題などの一般的な問題に対処します。 MacOSメールアプリは、人気がありますが、大きなキャッシュのために遅くなる可能性があります。この記事では、メールキャッシュが何であるか、なぜそれが有...ソフトウェアチュートリアル 2025-04-21に投稿されました

Macメールボックスのキャッシュをクリーニングする方法は? Macで削除する方法は?このガイドでは、Macのメールキャッシュをクリアする方法を説明し、パフォーマンスの遅延や電子メールの読み込みの問題などの一般的な問題に対処します。 MacOSメールアプリは、人気がありますが、大きなキャッシュのために遅くなる可能性があります。この記事では、メールキャッシュが何であるか、なぜそれが有...ソフトウェアチュートリアル 2025-04-21に投稿されました -

WiFiの最も必要なデバイスへの割り当てを優先する方法現代の家には通常、Wi-Fiアクセスネットワークに同時に接続されている複数のデバイスがあります。これは、特にオンラインゲームやビデオストリーミングなどの高帯域幅需要アクティビティを実施する場合に帯域幅の強さにつながることがよくあります。 ネットワーク負荷の管理を支援するために、一部のルーター...ソフトウェアチュートリアル 2025-04-19に投稿されました

WiFiの最も必要なデバイスへの割り当てを優先する方法現代の家には通常、Wi-Fiアクセスネットワークに同時に接続されている複数のデバイスがあります。これは、特にオンラインゲームやビデオストリーミングなどの高帯域幅需要アクティビティを実施する場合に帯域幅の強さにつながることがよくあります。 ネットワーク負荷の管理を支援するために、一部のルーター...ソフトウェアチュートリアル 2025-04-19に投稿されました -

McAfee Antivirusソフトウェアレビュー:十分ですか? 【関数、価格】McAfee:ベテランアンチウイルスですが、Macに最適ですか? サイバーセキュリティの長年の評判の良い名前であるMcAfeeは、ユーザーフレンドリーで包括的なセキュリティ機能を称賛された堅牢なウイルス対策スイートを提供します。 PCには強く推奨されていますが、MacSに対する有効性は綿密な調査...ソフトウェアチュートリアル 2025-04-19に投稿されました

McAfee Antivirusソフトウェアレビュー:十分ですか? 【関数、価格】McAfee:ベテランアンチウイルスですが、Macに最適ですか? サイバーセキュリティの長年の評判の良い名前であるMcAfeeは、ユーザーフレンドリーで包括的なセキュリティ機能を称賛された堅牢なウイルス対策スイートを提供します。 PCには強く推奨されていますが、MacSに対する有効性は綿密な調査...ソフトウェアチュートリアル 2025-04-19に投稿されました -

OnePlus Watch3は面白い問題のために4月に延期されます待望のOnePlus Watch 3スマートウォッチがリリースされた後、購入計画にはわずかな調整が必要になる場合があります。とんでもない生産の問題により、OnePlusはほとんどの時計の出荷を延期することを余儀なくされました。 OnePlusは、最新のスマートウォッチであるOnePlu...ソフトウェアチュートリアル 2025-04-19に投稿されました

OnePlus Watch3は面白い問題のために4月に延期されます待望のOnePlus Watch 3スマートウォッチがリリースされた後、購入計画にはわずかな調整が必要になる場合があります。とんでもない生産の問題により、OnePlusはほとんどの時計の出荷を延期することを余儀なくされました。 OnePlusは、最新のスマートウォッチであるOnePlu...ソフトウェアチュートリアル 2025-04-19に投稿されました -

iPhoneの背面にあるタップ機能を最大限に活用するためのヒント長年にわたり、AppleはiPhoneをより便利にするための多数のツールを開発してきました。 「タップバック」機能は鈍いですが、しばしば見落とされています。それは十分に見事ではないかもしれませんが、このアクセシビリティのショートカットは、オープンしにくい多くの機能にすばやくアクセスできます。電...ソフトウェアチュートリアル 2025-04-18に投稿されました

iPhoneの背面にあるタップ機能を最大限に活用するためのヒント長年にわたり、AppleはiPhoneをより便利にするための多数のツールを開発してきました。 「タップバック」機能は鈍いですが、しばしば見落とされています。それは十分に見事ではないかもしれませんが、このアクセシビリティのショートカットは、オープンしにくい多くの機能にすばやくアクセスできます。電...ソフトウェアチュートリアル 2025-04-18に投稿されました

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning