लामा मॉडल चलाते समय मेरा Google Colab सत्र क्रैश क्यों हो गया?

मैं मेटा-लामा/लामा-2-7बी-एचएफ मॉडल का उपयोग करने और इसे अपने परिसर में स्थानीय रूप से चलाने का प्रयास कर रहा हूं लेकिन प्रक्रिया के दौरान सत्र क्रैश हो गया।

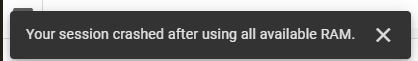

मैं मेटा-लामा/लामा-2-7बी-एचएफ मॉडल का उपयोग करने और इसे अपने परिसर में स्थानीय रूप से चलाने का प्रयास कर रहा हूं। ऐसा करने के लिए, मैं Google Colab का उपयोग कर रहा हूं और हगिंग फेस से एक एक्सेस कुंजी प्राप्त की है। मैं आवश्यक कार्यों के लिए उनकी ट्रांसफॉर्मर लाइब्रेरी का उपयोग कर रहा हूं। प्रारंभ में, मैंने Google Colab पर T4 GPU रनटाइम स्टैक का उपयोग किया, जो 12.7 GB सिस्टम RAM, 15.0 GB GPU RAM और 78.2 GB डिस्क स्थान प्रदान करता था। इन संसाधनों के बावजूद, मेरा सत्र क्रैश हो गया, और मुझे निम्नलिखित त्रुटि का सामना करना पड़ा:

इसके बाद, मैंने टीपीयू वी2 रनटाइम स्टैक पर स्विच किया, जो 334.6 जीबी सिस्टम रैम और 225.3 जीबी डिस्क स्थान प्रदान करता है, लेकिन समस्या बनी रही।

यह मेरा कोड है:

!pip install transformers !pip install --upgrade transformers from huggingface_hub import login login(token='Access Token From Hugging Face') import pandas as pd from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer from torch.utils.data import Dataset # Load pre-trained Meta-Llama-3.1-8B model model_name = "meta-llama/Llama-2-7b-hf" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForSequenceClassification.from_pretrained(model_name)

-

Microsoft Visual C ++ दो-चरण टेम्पलेट तात्कालिकता को सही ढंग से लागू करने में विफल क्यों होता है?चिंता व्यक्त करते हैं कि Microsoft Visual C (MSVC) दो-चरण टेम्पलेट तात्कालिकता को सही ढंग से लागू करने के साथ संघर्ष करता है। तंत्र के कौन से विशिष्ट...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

Microsoft Visual C ++ दो-चरण टेम्पलेट तात्कालिकता को सही ढंग से लागू करने में विफल क्यों होता है?चिंता व्यक्त करते हैं कि Microsoft Visual C (MSVC) दो-चरण टेम्पलेट तात्कालिकता को सही ढंग से लागू करने के साथ संघर्ष करता है। तंत्र के कौन से विशिष्ट...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

मैं एक MySQL तालिका में स्तंभ अस्तित्व के लिए मज़बूती से कैसे जांच कर सकता हूं?अन्य डेटाबेस सिस्टम। सामान्य रूप से प्रयास विधि: यदि मौजूद है (जानकारी से चयन करें * सूचना_ schema.columns से जहां table_name = 'उप...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

मैं एक MySQL तालिका में स्तंभ अस्तित्व के लिए मज़बूती से कैसे जांच कर सकता हूं?अन्य डेटाबेस सिस्टम। सामान्य रूप से प्रयास विधि: यदि मौजूद है (जानकारी से चयन करें * सूचना_ schema.columns से जहां table_name = 'उप...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

क्या जावा कई प्रकार के रिटर्न प्रकार की अनुमति देता है: जेनेरिक तरीकों पर करीब से नज़र डालें?] : getResult (string s); जहां फू एक कस्टम वर्ग है। विधि की घोषणा दो रिटर्न प्रकारों को समेटे हुए है: सूची और ई। लेकिन क्या यह वास्तव में मामला...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

क्या जावा कई प्रकार के रिटर्न प्रकार की अनुमति देता है: जेनेरिक तरीकों पर करीब से नज़र डालें?] : getResult (string s); जहां फू एक कस्टम वर्ग है। विधि की घोषणा दो रिटर्न प्रकारों को समेटे हुए है: सूची और ई। लेकिन क्या यह वास्तव में मामला...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

फिक्स्ड पोजिशनिंग का उपयोग करते समय 100% ग्रिड-टेम्प्लेट-कॉलम के साथ ग्रिड शरीर से परे क्यों फैलता है?] शरीर से परे जब स्थिति निर्धारित होती है फिक्स्ड? समस्या: -hide = "गलत" डेटा-कंसोल = "ट्रू" डेटा-बेबेल = "गलत"> ...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

फिक्स्ड पोजिशनिंग का उपयोग करते समय 100% ग्रिड-टेम्प्लेट-कॉलम के साथ ग्रिड शरीर से परे क्यों फैलता है?] शरीर से परे जब स्थिति निर्धारित होती है फिक्स्ड? समस्या: -hide = "गलत" डेटा-कंसोल = "ट्रू" डेटा-बेबेल = "गलत"> ...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

मैं पासवर्ड प्रॉम्प्ट के बिना Ubuntu पर MySQL कैसे स्थापित कर सकता हूं?कंसोल में एक पासवर्ड, जो स्वचालित के लिए स्क्रिप्ट लिखते समय असुविधाजनक हो सकता है स्थापना। MySQL रूट उपयोगकर्ता। इसके लिए निम्नलिखित चरणों की आवश्यक...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

मैं पासवर्ड प्रॉम्प्ट के बिना Ubuntu पर MySQL कैसे स्थापित कर सकता हूं?कंसोल में एक पासवर्ड, जो स्वचालित के लिए स्क्रिप्ट लिखते समय असुविधाजनक हो सकता है स्थापना। MySQL रूट उपयोगकर्ता। इसके लिए निम्नलिखित चरणों की आवश्यक...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

आप MySQL में डेटा को पिवट करने के लिए समूह का उपयोग कैसे कर सकते हैं?] । यहाँ, हम एक सामान्य चुनौती से संपर्क करते हैं: पंक्ति-आधारित से डेटा को बदलना समूह-आधारित समूह द्वारा समूह का उपयोग करके। सशर्त एकत्रीकरण कार्यों ...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

आप MySQL में डेटा को पिवट करने के लिए समूह का उपयोग कैसे कर सकते हैं?] । यहाँ, हम एक सामान्य चुनौती से संपर्क करते हैं: पंक्ति-आधारित से डेटा को बदलना समूह-आधारित समूह द्वारा समूह का उपयोग करके। सशर्त एकत्रीकरण कार्यों ...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

जेएस और मूल बातें] ] जेएस और कोर प्रोग्रामिंग अवधारणाओं की मूल बातें समझना किसी को भी वेब विकास या सामान्य सॉफ्टवेयर प्रोग्रामिंग में गोता लगाने के लिए आवश्यक है। यह ग...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

जेएस और मूल बातें] ] जेएस और कोर प्रोग्रामिंग अवधारणाओं की मूल बातें समझना किसी को भी वेब विकास या सामान्य सॉफ्टवेयर प्रोग्रामिंग में गोता लगाने के लिए आवश्यक है। यह ग...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

\ "जबकि (1) बनाम के लिए (;;): क्या संकलक अनुकूलन प्रदर्शन अंतर को समाप्त करता है?] ] लूप्स? ] संकलक: perl: दोनों जबकि (1) और (;; ] 1 दर्ज करें -> 2 2 नेक्स्टस्टेट (मुख्य 2 -e: 1) v -> 3 9 लेवेलूप वीके/2 -> ए 3 9 4 नेक्स...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

\ "जबकि (1) बनाम के लिए (;;): क्या संकलक अनुकूलन प्रदर्शन अंतर को समाप्त करता है?] ] लूप्स? ] संकलक: perl: दोनों जबकि (1) और (;; ] 1 दर्ज करें -> 2 2 नेक्स्टस्टेट (मुख्य 2 -e: 1) v -> 3 9 लेवेलूप वीके/2 -> ए 3 9 4 नेक्स...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

क्यों तीर कार्य IE11 में सिंटैक्स त्रुटियों का कारण बनते हैं और मैं उन्हें कैसे ठीक कर सकता हूं?] । IE 11 तीर कार्यों का समर्थन नहीं करता है, एक सिंटैक्स त्रुटि के लिए अग्रणी है। समस्याग्रस्त कोड को फिर से लिखा जाना चाहिए: g.selectall .Appe...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

क्यों तीर कार्य IE11 में सिंटैक्स त्रुटियों का कारण बनते हैं और मैं उन्हें कैसे ठीक कर सकता हूं?] । IE 11 तीर कार्यों का समर्थन नहीं करता है, एक सिंटैक्स त्रुटि के लिए अग्रणी है। समस्याग्रस्त कोड को फिर से लिखा जाना चाहिए: g.selectall .Appe...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

क्या `Exec ()` python 3 में स्थानीय चर को अपडेट करता है, और यदि नहीं, तो इसे कैसे बनाया जा सकता है?] क्या यह किसी फ़ंक्शन के भीतर स्थानीय चर को अपडेट कर सकता है? दुविधा पायथन 3 में, निम्न कोड स्निपेट एक स्थानीय चर को अद्यतन करने में विफल रहता है...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

क्या `Exec ()` python 3 में स्थानीय चर को अपडेट करता है, और यदि नहीं, तो इसे कैसे बनाया जा सकता है?] क्या यह किसी फ़ंक्शन के भीतर स्थानीय चर को अपडेट कर सकता है? दुविधा पायथन 3 में, निम्न कोड स्निपेट एक स्थानीय चर को अद्यतन करने में विफल रहता है...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

पायथन में स्ट्रिंग्स से इमोजी को कैसे निकालें: आम त्रुटियों को ठीक करने के लिए एक शुरुआत का मार्गदर्शिका?] पायथन 2 पर U '' उपसर्ग का उपयोग करके यूनिकोड स्ट्रिंग्स को नामित किया जाना चाहिए। इसके अलावा, re.unicode ध्वज को नियमित अभिव्यक्ति में पारित...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

पायथन में स्ट्रिंग्स से इमोजी को कैसे निकालें: आम त्रुटियों को ठीक करने के लिए एक शुरुआत का मार्गदर्शिका?] पायथन 2 पर U '' उपसर्ग का उपयोग करके यूनिकोड स्ट्रिंग्स को नामित किया जाना चाहिए। इसके अलावा, re.unicode ध्वज को नियमित अभिव्यक्ति में पारित...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

कैसे जांचें कि क्या किसी वस्तु की पायथन में एक विशिष्ट विशेषता है?] निम्नलिखित उदाहरण पर विचार करें जहां एक अपरिभाषित संपत्ति तक पहुंचने का प्रयास एक त्रुटि उठाता है: >>> a = someclass () >>> a.property ट्रेसबैक (स...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

कैसे जांचें कि क्या किसी वस्तु की पायथन में एक विशिष्ट विशेषता है?] निम्नलिखित उदाहरण पर विचार करें जहां एक अपरिभाषित संपत्ति तक पहुंचने का प्रयास एक त्रुटि उठाता है: >>> a = someclass () >>> a.property ट्रेसबैक (स...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

जावास्क्रिप्ट ऑब्जेक्ट्स में गतिशील रूप से चाबियां कैसे सेट करें?] कुंजी 'i} =' उदाहरण '1; काम नहीं करेगा। सही दृष्टिकोण वर्ग कोष्ठक को नियोजित करता है: jsobj ['कुंजी' i] = 'उदाहरण' 1...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

जावास्क्रिप्ट ऑब्जेक्ट्स में गतिशील रूप से चाबियां कैसे सेट करें?] कुंजी 'i} =' उदाहरण '1; काम नहीं करेगा। सही दृष्टिकोण वर्ग कोष्ठक को नियोजित करता है: jsobj ['कुंजी' i] = 'उदाहरण' 1...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

संस्करण 5.6.5 से पहले MySQL में टाइमस्टैम्प कॉलम के साथ current_timestamp का उपयोग करने पर क्या प्रतिबंध थे?] एक प्रतिबंध था जो एक तालिका को केवल एक टाइमस्टैम्प कॉलम के साथ सीमित कर रहा था, या तो डिफ़ॉल्ट current_timestamp या अपडेट पर Current_timestamp क्लॉज...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

संस्करण 5.6.5 से पहले MySQL में टाइमस्टैम्प कॉलम के साथ current_timestamp का उपयोग करने पर क्या प्रतिबंध थे?] एक प्रतिबंध था जो एक तालिका को केवल एक टाइमस्टैम्प कॉलम के साथ सीमित कर रहा था, या तो डिफ़ॉल्ट current_timestamp या अपडेट पर Current_timestamp क्लॉज...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया -

मैं PHP का उपयोग करके XML फ़ाइलों से विशेषता मानों को कैसे प्राप्त कर सकता हूं?] एक XML फ़ाइल के साथ काम करते समय जिसमें प्रदान किए गए उदाहरण जैसे विशेषताएं होती हैं: Var> स्टंप किया गया। इसे हल करने के लिए, PHP सिंप्लेक्...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

मैं PHP का उपयोग करके XML फ़ाइलों से विशेषता मानों को कैसे प्राप्त कर सकता हूं?] एक XML फ़ाइल के साथ काम करते समय जिसमें प्रदान किए गए उदाहरण जैसे विशेषताएं होती हैं: Var> स्टंप किया गया। इसे हल करने के लिए, PHP सिंप्लेक्...प्रोग्रामिंग 2025-02-19 को पोस्ट किया गया

चीनी भाषा का अध्ययन करें

- 1 आप चीनी भाषा में "चलना" कैसे कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 2 आप चीनी भाषा में "विमान ले लो" कैसे कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 3 आप चीनी भाषा में "ट्रेन ले लो" कैसे कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 4 आप चीनी भाषा में "बस ले लो" कैसे कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 5 चीनी भाषा में ड्राइव को क्या कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 6 तैराकी को चीनी भाषा में क्या कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 7 आप चीनी भाषा में साइकिल चलाने को क्या कहते हैं? #का चीनी उच्चारण, #का चीनी सीखना

- 8 आप चीनी भाषा में नमस्ते कैसे कहते हैं? 你好चीनी उच्चारण, 你好चीनी सीखना

- 9 आप चीनी भाषा में धन्यवाद कैसे कहते हैं? 谢谢चीनी उच्चारण, 谢谢चीनी सीखना

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning