ROBOFLOW - entraîner et tester avec python

Roboflow est une plate-forme d'annotation d'images à utiliser dans l'IA de détection d'objets.

J'utilise cette plateforme pour le C2SMR c2smr.fr, mon association de vision par ordinateur pour le sauvetage maritime.

Dans cet article, je vous montre comment utiliser cette plateforme et entraîner votre modèle avec python.

Vous pouvez trouver plus d'exemples de code sur mon github : https://github.com/C2SMR/detector

I - Ensemble de données

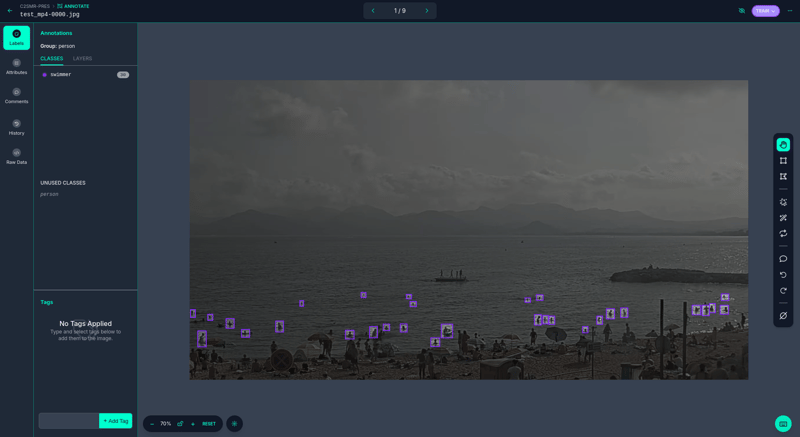

Pour créer votre ensemble de données, accédez à https://app.roboflow.com/ et commencez à annoter votre image comme indiqué dans l'image suivante.

Dans cet exemple, je détourne tous les nageurs pour prédire leur position dans les futures images.

Pour obtenir un bon résultat, recadrez tous les nageurs et placez le cadre de sélection juste après l'objet pour l'entourer correctement.

Vous pouvez déjà utiliser un ensemble de données Roboflow public, pour cette vérification https://universe.roboflow.com/

II - Formation

Pour la phase de formation, vous pouvez utiliser roboflow directement, mais la troisième fois, vous devrez payer, c'est pourquoi je vous montre comment le faire avec votre ordinateur portable.

La première étape consiste à importer votre ensemble de données. Pour ce faire, vous pouvez importer la bibliothèque Roboflow.

pip install roboflow

Pour créer un modèle, vous devez utiliser l'algorithme YOLO, que vous pouvez importer avec la bibliothèque ultralytics.

pip install ultralytics

Dans mon script, j'utilise la commande suivante :

py train.py api-key project-workspace project-name project-version nb-epoch size_model

Vous devez obtenir :

- la clé d'accès

- espace de travail

- nom du projet Roboflow

- version de l'ensemble de données du projet

- nombre d'époques pour entraîner le modèle

- taille du réseau neuronal

Initialement, le script télécharge yolov8-obb.pt, le poids yolo par défaut avec les données pré-entraînement, pour faciliter l'entraînement.

import sys

import os

import random

from roboflow import Roboflow

from ultralytics import YOLO

import yaml

import time

class Main:

rf: Roboflow

project: object

dataset: object

model: object

results: object

model_size: str

def __init__(self):

self.model_size = sys.argv[6]

self.import_dataset()

self.train()

def import_dataset(self):

self.rf = Roboflow(api_key=sys.argv[1])

self.project = self.rf.workspace(sys.argv[2]).project(sys.argv[3])

self.dataset = self.project.version(sys.argv[4]).download("yolov8-obb")

with open(f'{self.dataset.location}/data.yaml', 'r') as file:

data = yaml.safe_load(file)

data['path'] = self.dataset.location

with open(f'{self.dataset.location}/data.yaml', 'w') as file:

yaml.dump(data, file, sort_keys=False)

def train(self):

list_of_models = ["n", "s", "m", "l", "x"]

if self.model_size != "ALL" and self.model_size in list_of_models:

self.model = YOLO(f"yolov8{self.model_size}-obb.pt")

self.results = self.model.train(data=f"{self.dataset.location}/"

f"yolov8-obb.yaml",

epochs=int(sys.argv[5]), imgsz=640)

elif self.model_size == "ALL":

for model_size in list_of_models:

self.model = YOLO(f"yolov8{model_size}.pt")

self.results = self.model.train(data=f"{self.dataset.location}"

f"/yolov8-obb.yaml",

epochs=int(sys.argv[5]),

imgsz=640)

else:

print("Invalid model size")

if __name__ == '__main__':

Main()

III - Affichage

Après avoir entraîné le modèle, vous obtenez les fichiers best.py et last.py, qui correspondent au poids.

Avec la bibliothèque ultralytics, vous pouvez également importer YOLO et charger votre poids puis votre vidéo de test.

Dans cet exemple, j'utilise la fonction de suivi pour obtenir un identifiant pour chaque nageur.

import cv2

from ultralytics import YOLO

import sys

def main():

cap = cv2.VideoCapture(sys.argv[1])

model = YOLO(sys.argv[2])

while True:

ret, frame = cap.read()

results = model.track(frame, persist=True)

res_plotted = results[0].plot()

cv2.imshow("frame", res_plotted)

if cv2.waitKey(1) == 27:

break

cap.release()

cv2.destroyAllWindows()

if __name__ == "__main__":

main()

Pour analyser la prédiction, vous pouvez obtenir le modèle json comme suit.

results = model.track(frame, persist=True) results_json = json.loads(results[0].tojson())

-

Comment formater des nombres avec des virgules en C++ en utilisant std :: locale ?Formatage des nombres avec des virgules en C En C , la classe std::locale fournit un moyen dépendant des paramètres régionaux de formater les nombres ...La programmation Publié le 2024-11-07

Comment formater des nombres avec des virgules en C++ en utilisant std :: locale ?Formatage des nombres avec des virgules en C En C , la classe std::locale fournit un moyen dépendant des paramètres régionaux de formater les nombres ...La programmation Publié le 2024-11-07 -

Comment éviter d’imprimer des nombres impairs dans une séquence de nombres premiers en Python ?Comment imprimer une séquence de nombres premiers en PythonDe nombreux programmeurs ont du mal à créer une fonction qui imprime avec précision les nom...La programmation Publié le 2024-11-07

Comment éviter d’imprimer des nombres impairs dans une séquence de nombres premiers en Python ?Comment imprimer une séquence de nombres premiers en PythonDe nombreux programmeurs ont du mal à créer une fonction qui imprime avec précision les nom...La programmation Publié le 2024-11-07 -

Comment tirer une balle en direction de la souris dans Pygame ?Comment tirer une balle dans la direction de la souris dans PygameDans Pygame, on peut créer une balle qui est tirée dans la direction de la souris. P...La programmation Publié le 2024-11-07

Comment tirer une balle en direction de la souris dans Pygame ?Comment tirer une balle dans la direction de la souris dans PygameDans Pygame, on peut créer une balle qui est tirée dans la direction de la souris. P...La programmation Publié le 2024-11-07 -

Conseils de codage GG pour optimiser les performances : accélérer votre codeDans le monde du développement logiciel, l'optimisation des performances du code est cruciale pour fournir des applications rapides et réactives q...La programmation Publié le 2024-11-07

Conseils de codage GG pour optimiser les performances : accélérer votre codeDans le monde du développement logiciel, l'optimisation des performances du code est cruciale pour fournir des applications rapides et réactives q...La programmation Publié le 2024-11-07 -

Comment trouver la date d'un jour spécifique de la semaine à l'aide de la fonction strtotime() de PHP ?Détermination de la date pour les jours spécifiés de la semaine (lundi, mardi, etc.)Si vous devez vérifier le cachet de date de un jour spécifique de ...La programmation Publié le 2024-11-07

Comment trouver la date d'un jour spécifique de la semaine à l'aide de la fonction strtotime() de PHP ?Détermination de la date pour les jours spécifiés de la semaine (lundi, mardi, etc.)Si vous devez vérifier le cachet de date de un jour spécifique de ...La programmation Publié le 2024-11-07 -

Créez et déployez une application de chat à l'aide de Socket.io et Redis.Dans ce didacticiel, nous allons créer une application de chat à l'aide de sockets Web. Les sockets Web sont très utiles lorsque vous souhaitez cr...La programmation Publié le 2024-11-07

Créez et déployez une application de chat à l'aide de Socket.io et Redis.Dans ce didacticiel, nous allons créer une application de chat à l'aide de sockets Web. Les sockets Web sont très utiles lorsque vous souhaitez cr...La programmation Publié le 2024-11-07 -

À l'intérieur des jointures SQLLes jointures SQL sont fondamentales pour interroger les bases de données, permettant aux utilisateurs de combiner les données de plusieurs tables en ...La programmation Publié le 2024-11-07

À l'intérieur des jointures SQLLes jointures SQL sont fondamentales pour interroger les bases de données, permettant aux utilisateurs de combiner les données de plusieurs tables en ...La programmation Publié le 2024-11-07 -

Fonctionnalités de Javascript que vous devez connaîtreDans cet article, nous explorerons comment éviter les erreurs lors de la tentative d'accès à des données qui pourraient être non définies ou nulle...La programmation Publié le 2024-11-07

Fonctionnalités de Javascript que vous devez connaîtreDans cet article, nous explorerons comment éviter les erreurs lors de la tentative d'accès à des données qui pourraient être non définies ou nulle...La programmation Publié le 2024-11-07 -

Promesses en JavaScript : compréhension, gestion et maîtrise du code asynchroneIntroduction J'ai travaillé en tant que développeur Java et je me souviens pour la première fois du jour où j'ai été en contact avec ...La programmation Publié le 2024-11-07

Promesses en JavaScript : compréhension, gestion et maîtrise du code asynchroneIntroduction J'ai travaillé en tant que développeur Java et je me souviens pour la première fois du jour où j'ai été en contact avec ...La programmation Publié le 2024-11-07 -

Comment intégrer les clés d'accès dans Java Spring BootIntroduction aux clés d'accès dans Java Spring Boot Les clés d'accès offrent un moyen moderne et sécurisé d'authentifier les util...La programmation Publié le 2024-11-07

Comment intégrer les clés d'accès dans Java Spring BootIntroduction aux clés d'accès dans Java Spring Boot Les clés d'accès offrent un moyen moderne et sécurisé d'authentifier les util...La programmation Publié le 2024-11-07 -

L'impact de Mario Roberto Rojas Espino en tant qu'ancien ministre de l'Environnement au GuatemalaEn tant qu'ancien ministre de l'Environnement du Guatemala, Mario Roberto Rojas Espino a joué un rôle crucial dans la mise en œuvre de politiq...La programmation Publié le 2024-11-07

L'impact de Mario Roberto Rojas Espino en tant qu'ancien ministre de l'Environnement au GuatemalaEn tant qu'ancien ministre de l'Environnement du Guatemala, Mario Roberto Rojas Espino a joué un rôle crucial dans la mise en œuvre de politiq...La programmation Publié le 2024-11-07 -

Comment puis-je suivre et accéder à toutes les instances d'une classe pour la collecte de données ?Suivi des instances de classe pour la collecte de donnéesImaginez que vous approchez de la fin de votre programme et que vous devez extraire une varia...La programmation Publié le 2024-11-07

Comment puis-je suivre et accéder à toutes les instances d'une classe pour la collecte de données ?Suivi des instances de classe pour la collecte de donnéesImaginez que vous approchez de la fin de votre programme et que vous devez extraire une varia...La programmation Publié le 2024-11-07 -

Comment rechercher dans un tableau associatif PHP – Conseils rapidesLes tableaux associatifs sont une structure de données fondamentale en PHP, permettant aux développeurs de stocker des paires clé-valeur. Ils sont pol...La programmation Publié le 2024-11-07

Comment rechercher dans un tableau associatif PHP – Conseils rapidesLes tableaux associatifs sont une structure de données fondamentale en PHP, permettant aux développeurs de stocker des paires clé-valeur. Ils sont pol...La programmation Publié le 2024-11-07 -

L'avenir du développement Web : tendances et technologies émergentes que tout développeur devrait connaîtreIntroduction Le développement Web a parcouru un long chemin depuis ses débuts avec des pages HTML statiques et des conceptions CSS simples. A...La programmation Publié le 2024-11-07

L'avenir du développement Web : tendances et technologies émergentes que tout développeur devrait connaîtreIntroduction Le développement Web a parcouru un long chemin depuis ses débuts avec des pages HTML statiques et des conceptions CSS simples. A...La programmation Publié le 2024-11-07 -

Oui, les codeurs Python débutants peuvent utiliser ChatGPTEn tant que développeur Python débutant, vous êtes confronté à d'innombrables défis, de l'écriture de code propre au dépannage des erreurs. C...La programmation Publié le 2024-11-07

Oui, les codeurs Python débutants peuvent utiliser ChatGPTEn tant que développeur Python débutant, vous êtes confronté à d'innombrables défis, de l'écriture de code propre au dépannage des erreurs. C...La programmation Publié le 2024-11-07

Étudier le chinois

- 1 Comment dit-on « marcher » en chinois ? 走路 Prononciation chinoise, 走路 Apprentissage du chinois

- 2 Comment dit-on « prendre l’avion » en chinois ? 坐飞机 Prononciation chinoise, 坐飞机 Apprentissage du chinois

- 3 Comment dit-on « prendre un train » en chinois ? 坐火车 Prononciation chinoise, 坐火车 Apprentissage du chinois

- 4 Comment dit-on « prendre un bus » en chinois ? 坐车 Prononciation chinoise, 坐车 Apprentissage du chinois

- 5 Comment dire conduire en chinois? 开车 Prononciation chinoise, 开车 Apprentissage du chinois

- 6 Comment dit-on nager en chinois ? 游泳 Prononciation chinoise, 游泳 Apprentissage du chinois

- 7 Comment dit-on faire du vélo en chinois ? 骑自行车 Prononciation chinoise, 骑自行车 Apprentissage du chinois

- 8 Comment dit-on bonjour en chinois ? 你好Prononciation chinoise, 你好Apprentissage du chinois

- 9 Comment dit-on merci en chinois ? 谢谢Prononciation chinoise, 谢谢Apprentissage du chinois

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning