Page de garde > La programmation > Évaluation d'un modèle de classification d'apprentissage automatique

Page de garde > La programmation > Évaluation d'un modèle de classification d'apprentissage automatique

Évaluation d'un modèle de classification d'apprentissage automatique

Contour

- Quel est l'objectif de l'évaluation du modèle ?

- Quel est le but de l'évaluation du modèle et quels sont les procédures d'évaluation communes ?

- À quoi sert l'exactitude de la classification et quelles sont ses limites?

- Comment une matrice de confusion décrit-elle les performances d'un classificateur ?

- Quelles métriques peuvent être calculées à partir d'une matrice de confusion ?

Ll'objectif de l'évaluation des modèles est de répondre à la question :

comment choisir entre les différents modèles ?

Le processus d'évaluation d'un apprentissage automatique aide à déterminer dans quelle mesure le modèle est fiable et efficace pour son application. Cela implique d'évaluer différents facteurs tels que ses performances, ses mesures et sa précision pour les prédictions ou la prise de décision.

Quel que soit le modèle que vous choisissez d'utiliser, vous avez besoin d'un moyen de choisir entre les modèles : différents types de modèles, paramètres de réglage et fonctionnalités. Vous avez également besoin d'une procédure d'évaluation du modèle pour estimer dans quelle mesure un modèle se généralisera à des données invisibles. Enfin, vous avez besoin d'une procédure d'évaluation à associer à votre procédure pour quantifier les performances de votre modèle.

Avant de continuer, passons en revue certaines des différentes procédures d'évaluation des modèles et leur fonctionnement.

Modèles de procédures d’évaluation et comment elles fonctionnent.

-

Formation et tests sur les mêmes données

- Récompense les modèles trop complexes qui « surajustent » les données d'entraînement et ne généralisent pas nécessairement

-

Répartition train/test

- Divisez l'ensemble de données en deux parties, afin que le modèle puisse être entraîné et testé sur différentes données

- Meilleure estimation des performances hors échantillon, mais toujours une estimation à « variance élevée »

- Utile en raison de sa rapidité, de sa simplicité et de sa flexibilité

-

Validation croisée K-fold

- Créez systématiquement des répartitions train/test « K » et faites la moyenne des résultats ensemble

- Une estimation encore meilleure des performances hors échantillon

- Exécute "K" fois plus lentement que la répartition train/test.

De ci-dessus, nous pouvons déduire que :

La formation et les tests sur les mêmes données sont une cause classique de surajustement dans laquelle vous construisez un modèle trop complexe qui ne se généralisera pas à de nouvelles données et qui n'est pas réellement utile.

Train_Test_Split fournit une bien meilleure estimation des performances hors échantillon.

La validation croisée K-fold donne de meilleurs résultats en répartissant systématiquement les tests de train K et en faisant la moyenne des résultats ensemble.

En résumé, train_tests_split est toujours rentable pour la validation croisée en raison de sa rapidité et de sa simplicité, et c'est ce que nous utiliserons dans ce guide tutoriel.

Paramètres d'évaluation du modèle :

Vous aurez toujours besoin d'une métrique d'évaluation pour accompagner la procédure que vous avez choisie, et votre choix de métrique dépend du problème que vous abordez. Pour les problèmes de classification, vous pouvez utiliser la précision de la classification. Mais nous nous concentrerons sur d’autres mesures d’évaluation de classification importantes dans ce guide.

Avant d'apprendre de nouvelles mesures d'évaluation, passons en revue la exactitude de la classification et parlons de ses forces et de ses faiblesses.

Précision de la classification

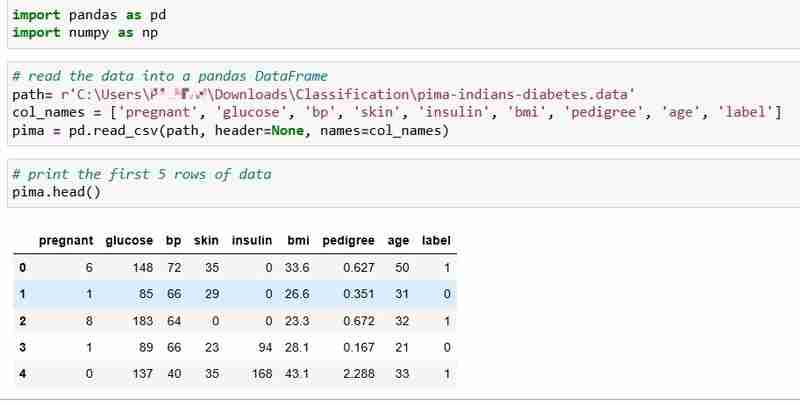

Nous avons choisi l'ensemble de données Pima Indians Diabetes pour ce didacticiel, qui comprend les données de santé et l'état de diabète de 768 patients.

Lisons les données et imprimons les 5 premières lignes des données. La colonne d'étiquette indique 1 si le patient est diabétique et 0 si le patient n'est pas diabétique, et nous avons l'intention de répondre à la question :

Question : Pouvons-nous prédire l'état de diabète d'un patient en fonction de ses mesures de santé ?

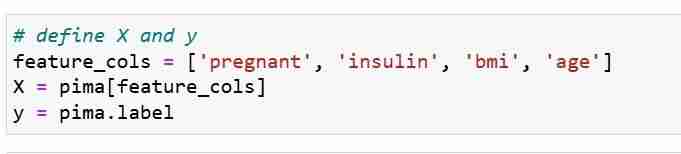

Nous définissons nos métriques de fonctionnalités X et notre vecteur de réponse Y. Nous utilisons train_test_split pour diviser X et Y en ensemble de formation et de test.

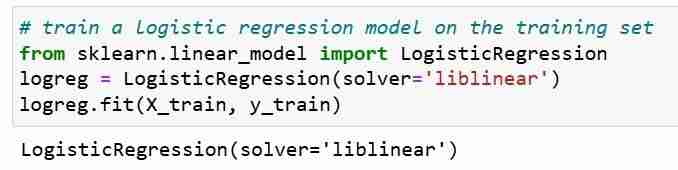

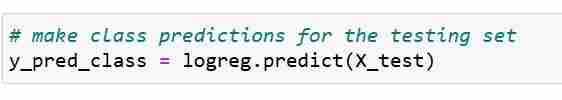

Ensuite, nous formons un modèle de régression logistique sur l'ensemble d'entraînement. Au cours de l'étape d'ajustement, l'objet modèle logreg apprend la relation entre X_train et Y_train. Enfin, nous faisons des prédictions de classe pour les ensembles de tests.

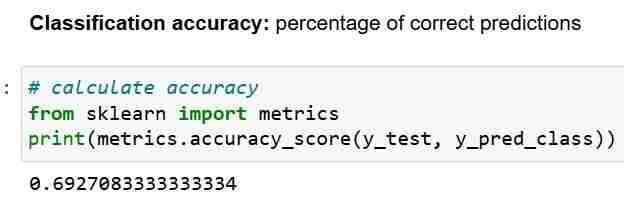

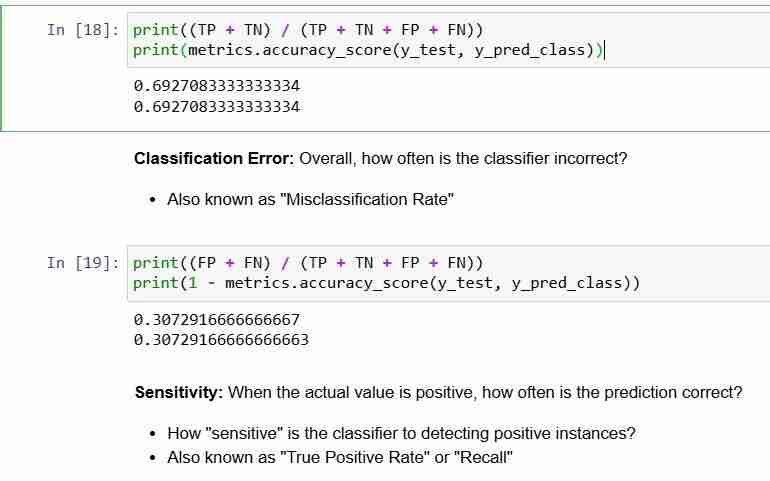

Maintenant, nous avons fait des prédictions pour l'ensemble de tests, nous pouvons calculer la précision de la classification, qui correspond simplement au pourcentage de prédictions correctes.

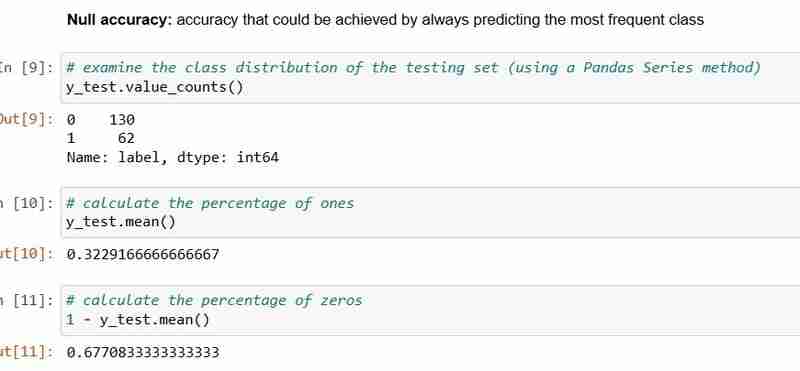

Cependant, chaque fois que vous utilisez la précision de la classification comme mesure d'évaluation, il est important de la comparer avec la Précision nulle, qui est la précision qui pourrait être obtenue en prédisant toujours la classe la plus fréquente.

Précision nulle répond à la question ; si mon modèle devait prédire la classe prédominante 100 % du temps, à quelle fréquence sera-t-il correct ? Dans le scénario ci-dessus, 32 % du y_test sont 1 (uns). En d'autres termes, un modèle stupide qui prédit que les patients souffrent de diabète aurait raison 68 % du temps (ce qui correspond aux zéros). Cela fournit une base de référence par rapport à laquelle nous pourrions vouloir mesurer notre régression logistique. modèle.

Lorsque nous comparons la précision nulle de 68 % et la précision du modèle de 69 %, notre modèle n'a pas l'air très bon. Cela démontre une faiblesse de l’exactitude de la classification en tant que mesure d’évaluation du modèle. L'exactitude de la classification ne nous dit rien sur la distribution sous-jacente du test de test.

En résumé:

- La précision de la classification est la métrique de classification la plus simple à comprendre

- Mais cela ne vous indique pas la distribution sous-jacente des valeurs de réponse

- Et il ne vous indique pas quels "types" d'erreurs votre classificateur fait.

Regardons maintenant la matrice de confusion.

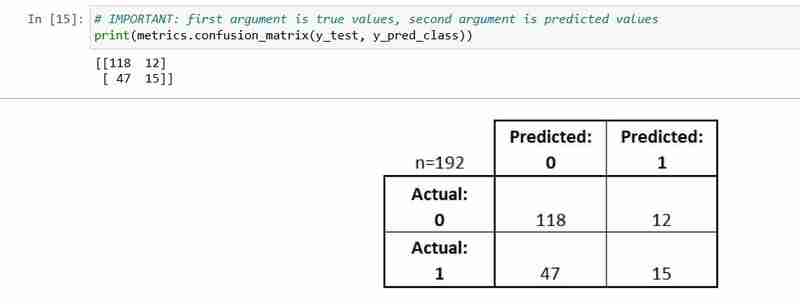

Matrice de confusion

La matrice de confusion est un tableau qui décrit les performances d'un modèle de classification.

Il est utile pour vous aider à comprendre les performances de votre classificateur, mais il ne s'agit pas d'une métrique d'évaluation de modèle ; vous ne pouvez donc pas dire à scikit d'apprendre à choisir le modèle avec la meilleure matrice de confusion. Cependant, de nombreuses mesures peuvent être calculées à partir de la matrice de confusion et celles-ci peuvent être directement utilisées pour choisir entre les modèles.

- Chaque observation de l'ensemble de tests est représentée dans exactement une case

- C'est une matrice 2x2 car il y a 2 classes de réponses

- Le format présenté ici n'est pas universel

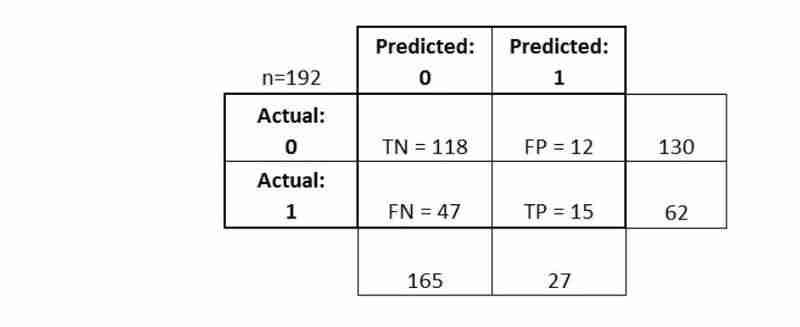

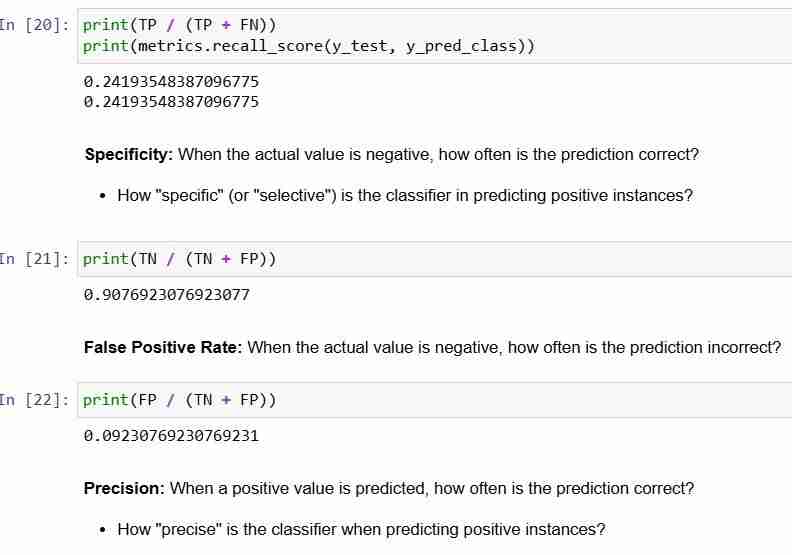

Expliquons certaines de ses terminologies de base.

- Vrais positifs (TP) : nous avons prédit correctement qu'ils souffraient de diabète

- Vrais négatifs (TN) : nous avons prédit correctement qu'ils ne souffraient pas de diabète Faux positifs (FP) :

- nous avons prédit à tort qu'ils souffraient de diabète (une « erreur de type I ») Faux négatifs (FN) : nous avons

- prédit à tort qu'ils ne souffraient pas de diabète (une « erreur de type II ») Voyons comment nous pouvons calculer les métriques

En conclusion:

En conclusion:

La matrice de confusion vous donne une

image plus complète- des performances de votre classificateur

- Vous permet également de calculer diverses métriques de classification , et ces métriques peuvent guider la sélection de votre modèle

-

Comment télécharger des fichiers avec des paramètres supplémentaires à l'aide de java.net.urlconnection et de codage multipart / formulaire de formulaire?Téléchargement des fichiers avec les demandes http pour télécharger des fichiers sur un serveur http tout en soumettant des paramètres supplém...La programmation Publié le 2025-04-12

Comment télécharger des fichiers avec des paramètres supplémentaires à l'aide de java.net.urlconnection et de codage multipart / formulaire de formulaire?Téléchargement des fichiers avec les demandes http pour télécharger des fichiers sur un serveur http tout en soumettant des paramètres supplém...La programmation Publié le 2025-04-12 -

Comment définir dynamiquement les touches dans les objets JavaScript?Comment créer une clé dynamique pour une variable d'objet JavaScript lorsque vous essayez de créer une clé dynamique pour un objet JavaScrip...La programmation Publié le 2025-04-12

Comment définir dynamiquement les touches dans les objets JavaScript?Comment créer une clé dynamique pour une variable d'objet JavaScript lorsque vous essayez de créer une clé dynamique pour un objet JavaScrip...La programmation Publié le 2025-04-12 -

YII Framework construit rapidement des applications CRUD, un incontournable pour les experts PHPYii框架:快速构建高效CRUD应用的指南 Yii是一个高性能的PHP框架,以其速度、安全性以及对Web 2.0应用的良好支持而闻名。它遵循“约定优于配置”的原则,这意味着只要遵循其规范,就能编写比其他框架少得多的代码(更少的代码意味着更少的bug)。此外,Yii还提供了许多开箱即用的便捷功能,例如...La programmation Publié le 2025-04-12

YII Framework construit rapidement des applications CRUD, un incontournable pour les experts PHPYii框架:快速构建高效CRUD应用的指南 Yii是一个高性能的PHP框架,以其速度、安全性以及对Web 2.0应用的良好支持而闻名。它遵循“约定优于配置”的原则,这意味着只要遵循其规范,就能编写比其他框架少得多的代码(更少的代码意味着更少的bug)。此外,Yii还提供了许多开箱即用的便捷功能,例如...La programmation Publié le 2025-04-12 -

Comment convertir efficacement les fuseaux horaires en PHP?Conversion efficace du fuseau horaire en php Dans PHP, la gestion des fuseaux horaires peut être une tâche simple. Ce guide fournira une méthode...La programmation Publié le 2025-04-12

Comment convertir efficacement les fuseaux horaires en PHP?Conversion efficace du fuseau horaire en php Dans PHP, la gestion des fuseaux horaires peut être une tâche simple. Ce guide fournira une méthode...La programmation Publié le 2025-04-12 -

Comment insérer correctement les blobs (images) dans MySQL à l'aide de PHP?Insérez des blobs dans les bases de données MySQL avec PHP Lorsque vous essayez de stocker une image dans une base de données MySQL, vous pou...La programmation Publié le 2025-04-12

Comment insérer correctement les blobs (images) dans MySQL à l'aide de PHP?Insérez des blobs dans les bases de données MySQL avec PHP Lorsque vous essayez de stocker une image dans une base de données MySQL, vous pou...La programmation Publié le 2025-04-12 -

Pourquoi mon image d'arrière-plan CSS apparaît-elle?Troubleshoot: Image d'arrière-plan CSS n'apparaissant pas Vous avez rencontré un problème où votre image d'arrière-plan échoue mal...La programmation Publié le 2025-04-12

Pourquoi mon image d'arrière-plan CSS apparaît-elle?Troubleshoot: Image d'arrière-plan CSS n'apparaissant pas Vous avez rencontré un problème où votre image d'arrière-plan échoue mal...La programmation Publié le 2025-04-12 -

Comment récupérer efficacement la dernière ligne pour chaque identifiant unique dans PostgreSQL?PostgreSQL: Extraction de la dernière ligne pour chaque identifiant unique Dans PostgreSql, vous pouvez rencontrer des situations de données o...La programmation Publié le 2025-04-12

Comment récupérer efficacement la dernière ligne pour chaque identifiant unique dans PostgreSQL?PostgreSQL: Extraction de la dernière ligne pour chaque identifiant unique Dans PostgreSql, vous pouvez rencontrer des situations de données o...La programmation Publié le 2025-04-12 -

Comment pouvez-vous utiliser des données de groupe par pour pivoter dans MySQL?Pivoting des résultats de la requête en utilisant le groupe mysql par Dans une base de données relationnelle, les données pivotant se réfèrent...La programmation Publié le 2025-04-12

Comment pouvez-vous utiliser des données de groupe par pour pivoter dans MySQL?Pivoting des résultats de la requête en utilisant le groupe mysql par Dans une base de données relationnelle, les données pivotant se réfèrent...La programmation Publié le 2025-04-12 -

Comment résoudre les écarts de chemin du module dans GO Mod en utilisant la directive Remplacer?surmonter la divergence du chemin du module dans go mod Lors de l'utilisation de Go Mod, il est possible de rencontrer un conflit où un pa...La programmation Publié le 2025-04-12

Comment résoudre les écarts de chemin du module dans GO Mod en utilisant la directive Remplacer?surmonter la divergence du chemin du module dans go mod Lors de l'utilisation de Go Mod, il est possible de rencontrer un conflit où un pa...La programmation Publié le 2025-04-12 -

Propriétés.settings.Default Paramètres de l'application L'emplacement de stockage révèleComprendre les propriétés.settings.Default Storage Locations C #'s Properties.settings.default fournit un moyen pratique de gérer les para...La programmation Publié le 2025-04-12

Propriétés.settings.Default Paramètres de l'application L'emplacement de stockage révèleComprendre les propriétés.settings.Default Storage Locations C #'s Properties.settings.default fournit un moyen pratique de gérer les para...La programmation Publié le 2025-04-12 -

Comment puis-je syndicrer des tables de base de données avec différents nombres de colonnes?Tables combinées avec différentes colonnes ] peut rencontrer des défis lorsque vous essayez de fusionner les tables de base de données avec dif...La programmation Publié le 2025-04-12

Comment puis-je syndicrer des tables de base de données avec différents nombres de colonnes?Tables combinées avec différentes colonnes ] peut rencontrer des défis lorsque vous essayez de fusionner les tables de base de données avec dif...La programmation Publié le 2025-04-12 -

Plusieurs éléments collants peuvent-ils être empilés les uns sur les autres en CSS pur?Est-il possible d'avoir plusieurs éléments collants empilés les uns sur les autres en pur css? Le comportement souhaité peut être vu Ici:...La programmation Publié le 2025-04-12

Plusieurs éléments collants peuvent-ils être empilés les uns sur les autres en CSS pur?Est-il possible d'avoir plusieurs éléments collants empilés les uns sur les autres en pur css? Le comportement souhaité peut être vu Ici:...La programmation Publié le 2025-04-12 -

Comment ajouter la base de données MySQL à la boîte de dialogue DataSource dans Visual Studio 2012?Ajout de la base de données MySQL à la boîte de dialogue DataSource dans Visual Studio 2012 En travaillant avec Entity Framework et MySQL, l&#...La programmation Publié le 2025-04-12

Comment ajouter la base de données MySQL à la boîte de dialogue DataSource dans Visual Studio 2012?Ajout de la base de données MySQL à la boîte de dialogue DataSource dans Visual Studio 2012 En travaillant avec Entity Framework et MySQL, l&#...La programmation Publié le 2025-04-12 -

Comment gérer la saisie des utilisateurs dans le mode exclusif complet de Java?Gestion de la saisie de l'utilisateur en mode exclusif en plein écran en java introduction Lors de l'exécution d'une application...La programmation Publié le 2025-04-12

Comment gérer la saisie des utilisateurs dans le mode exclusif complet de Java?Gestion de la saisie de l'utilisateur en mode exclusif en plein écran en java introduction Lors de l'exécution d'une application...La programmation Publié le 2025-04-12 -

Pourquoi est-ce que je reçois une erreur "Je n'ai pas trouvé d'implémentation du modèle de requête" dans ma requête Silverlight Linq?Absence d'implémentation du modèle de requête: Résolution "n'a pas pu trouver" Erreurs dans une application Silverlight, une...La programmation Publié le 2025-04-12

Pourquoi est-ce que je reçois une erreur "Je n'ai pas trouvé d'implémentation du modèle de requête" dans ma requête Silverlight Linq?Absence d'implémentation du modèle de requête: Résolution "n'a pas pu trouver" Erreurs dans une application Silverlight, une...La programmation Publié le 2025-04-12

Étudier le chinois

- 1 Comment dit-on « marcher » en chinois ? 走路 Prononciation chinoise, 走路 Apprentissage du chinois

- 2 Comment dit-on « prendre l’avion » en chinois ? 坐飞机 Prononciation chinoise, 坐飞机 Apprentissage du chinois

- 3 Comment dit-on « prendre un train » en chinois ? 坐火车 Prononciation chinoise, 坐火车 Apprentissage du chinois

- 4 Comment dit-on « prendre un bus » en chinois ? 坐车 Prononciation chinoise, 坐车 Apprentissage du chinois

- 5 Comment dire conduire en chinois? 开车 Prononciation chinoise, 开车 Apprentissage du chinois

- 6 Comment dit-on nager en chinois ? 游泳 Prononciation chinoise, 游泳 Apprentissage du chinois

- 7 Comment dit-on faire du vélo en chinois ? 骑自行车 Prononciation chinoise, 骑自行车 Apprentissage du chinois

- 8 Comment dit-on bonjour en chinois ? 你好Prononciation chinoise, 你好Apprentissage du chinois

- 9 Comment dit-on merci en chinois ? 谢谢Prononciation chinoise, 谢谢Apprentissage du chinois

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning