Página delantera > Programación > Golang: cómo la observabilidad y la elaboración de perfiles revelaron una limitación casi indetectable

Página delantera > Programación > Golang: cómo la observabilidad y la elaboración de perfiles revelaron una limitación casi indetectable

Golang: cómo la observabilidad y la elaboración de perfiles revelaron una limitación casi indetectable

En un proyecto personal con Go, que obtiene información sobre activos financieros de Bovespa.

El sistema hace un uso intensivo de la concurrencia y el paralelismo con gorutinas, actualizando la información de los activos (junto con los cálculos comerciales) cada 8 segundos.

Inicialmente, no aparecieron errores ni advertencias, pero noté que algunas rutinas tardaban más que otras en ejecutarse.

Para ser más específicos, mientras que el tiempo p99 fue de 0,03 ms, en algunos puntos aumentó a 0,9 ms. Esto me llevó a investigar más el problema.

Descubrí que estaba usando un grupo de rutinas de semáforo, que se creó en función de la variable GOMAXPROCS.

Sin embargo, me di cuenta de que había un problema con este enfoque.

Cuando usamos la variable GOMAXPROCS, no captura correctamente la cantidad de núcleos disponibles en el contenedor. Si el contenedor tiene menos núcleos disponibles que el total de la VM, considera el total de la VM. Por ejemplo, mi máquina virtual tiene 8 núcleos disponibles, pero el contenedor solo tenía 4. Esto resultó en la creación de 8 gorutinas para ejecutarse al mismo tiempo, lo que provocó una limitación.

Después de mucha investigación durante la noche, encontré una biblioteca desarrollada por Uber que ajusta automáticamente la variable GOMAXPROCS de manera más eficiente, independientemente de si está en un contenedor o no. Esta solución demostró ser extremadamente estable y eficiente: automaxprocs

uber-go

/

automaxprocs

uber-go

/

automaxprocs

Configure automáticamente GOMAXPROCS para que coincida con la cuota de CPU del contenedor de Linux.

automaxprocs

Configura automáticamente GOMAXPROCS para que coincida con la cuota de CPU del contenedor de Linux.

Instalación

ve a buscar -u go.uber.org/automaxprocs

Inicio rápido

import _ "go.uber.org/automaxprocs"

func main() {

// Your application logic here.

}

Actuación

Datos medidos desde el balanceador de carga interno de Uber. Ejecutamos el equilibrador de carga con una cuota de CPU del 200 % (es decir, 2 núcleos):

| GOMAXPROCS | RPS | P50 (ms) | P99.9 (ms) |

|---|---|---|---|

| 1 | 28.893,18 | 1.46 | 19.70 |

| 2 (igual a cuota) | 44.715,07 | 0,84 | 26.38 |

| 3 | 44.212,93 | 0,66 | 30.07 |

| 4 | 41.071,15 | 0,57 | 42,94 |

| 8 | 33.111,69 | 0,43 | 64.32 |

| Predeterminado (24) | 22.191,40 | 0,45 | 76.19 |

Cuando GOMAXPROCS aumenta por encima de la cuota de CPU, vemos que P50 disminuye ligeramente, pero vemos aumentos significativos a P99. También vemos que el total de RPS manejados también disminuye.

Cuando GOMAXPROCS es mayor que la cuota de CPU asignada, también vimos una limitación significativa:

$ cat /sys/fs/cgroup/cpu,cpuacct/system.slice/[...]/cpu.stat nr_periods 42227334 nr_throttled 131923 throttled_time 88613212216618

Una vez que se redujo GOMAXPROCS para igualar la cuota de CPU, no vimos ninguna limitación de CPU.

Después de implementar el uso de esta biblioteca, el problema se resolvió y ahora el tiempo p99 se mantuvo en 0,02 ms constantemente. Esta experiencia destacó la importancia de la observabilidad y la elaboración de perfiles en sistemas concurrentes.

El siguiente es un ejemplo muy simple, pero que demuestra la diferencia en el rendimiento.

Utilizando las pruebas nativas de Go y el paquete benkmak, creé dos archivos:

benchmarking_with_enhancement_test.go:

package main

import (

_ "go.uber.org/automaxprocs"

"runtime"

"sync"

"testing"

)

// BenchmarkWithEnhancement Função com melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

benchmarking_ without_enhancement_test.go:

package main

import (

"runtime"

"sync"

"testing"

)

// BenchmarkWithoutEnhancement Função sem a melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithoutEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

La diferencia entre ellos es que uno usa la importación de la biblioteca de Uber.

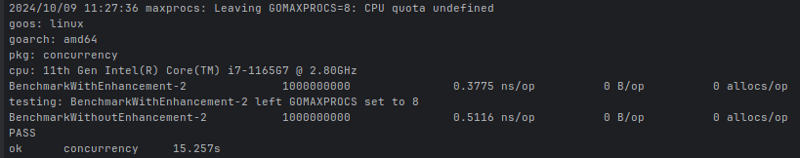

Al ejecutar el punto de referencia suponiendo que se usarían 2 CPU, el resultado fue:

ns/op: proporciona un promedio en nanosegundos de cuánto tiempo lleva realizar una operación específica.

Tenga en cuenta que el total disponible de mi CPU es de 8 núcleos, y eso es lo que devolvió la propiedad runtime.NumCPU(). Sin embargo, al igual que al ejecutar el benchmark, definí que el uso sería solo de dos CPU, y el archivo que no usaba automaxprocs, definí que el límite de ejecución a la vez sería de 8 gorutinas, mientras que la más eficiente sería 2, porque de esta manera, usar menos asignación hace que la ejecución sea más eficiente.

Por lo tanto, la importancia de la observabilidad y la elaboración de perfiles de nuestras aplicaciones es clara.

-

Configuración del usuario de la aplicación Android y la mejor manera de almacenar datos confidencialesAlmacenamiento de la configuración del usuario en aplicaciones de Android: explorar las opciones una de las consideraciones clave al desarrollar...Programación Publicado el 2025-04-19

Configuración del usuario de la aplicación Android y la mejor manera de almacenar datos confidencialesAlmacenamiento de la configuración del usuario en aplicaciones de Android: explorar las opciones una de las consideraciones clave al desarrollar...Programación Publicado el 2025-04-19 -

Eval () vs. AST.LITERAL_EVAL (): ¿Qué función de Python es más segura para la entrada del usuario?pesando eval () y Ast.literal_eval () en Python Security Al manejar la entrada del usuario, es imperativo priorizar la seguridad. eval (), una...Programación Publicado el 2025-04-19

Eval () vs. AST.LITERAL_EVAL (): ¿Qué función de Python es más segura para la entrada del usuario?pesando eval () y Ast.literal_eval () en Python Security Al manejar la entrada del usuario, es imperativo priorizar la seguridad. eval (), una...Programación Publicado el 2025-04-19 -

¿Por qué no se pueden subir mis imágenes a la base de datos MySQL?cargando imágenes en la base de datos MySQL usando el código php en esta pregunta de programación, un usuario encuentra un problema al intentar ...Programación Publicado el 2025-04-19

¿Por qué no se pueden subir mis imágenes a la base de datos MySQL?cargando imágenes en la base de datos MySQL usando el código php en esta pregunta de programación, un usuario encuentra un problema al intentar ...Programación Publicado el 2025-04-19 -

¿Cómo resolver las discrepancias de la ruta del módulo en el mod utilizando la Directiva Reemplazar?Superación del módulo Discrepancia en el mod Al utilizar el mod, es posible encontrar un conflicto en el que un paquete de terceros importe ot...Programación Publicado el 2025-04-19

¿Cómo resolver las discrepancias de la ruta del módulo en el mod utilizando la Directiva Reemplazar?Superación del módulo Discrepancia en el mod Al utilizar el mod, es posible encontrar un conflicto en el que un paquete de terceros importe ot...Programación Publicado el 2025-04-19 -

¿Cómo configurar la carga perezosa para la relación JPA onetoone?Configuración declarativa de recuperación perezosa para las relaciones JPA Onetoone Una optimización común en aplicaciones JPA es para habilit...Programación Publicado el 2025-04-19

¿Cómo configurar la carga perezosa para la relación JPA onetoone?Configuración declarativa de recuperación perezosa para las relaciones JPA Onetoone Una optimización común en aplicaciones JPA es para habilit...Programación Publicado el 2025-04-19 -

¿Qué método es más eficiente para la detección de Point-in-Polygon: Ray Tracing o Matplotlib \ 's Rath.Contains_Points?Detección eficiente de Point-in-Polygon en python determinando si un punto se encuentra dentro de un polígono es una tarea frecuente en la geome...Programación Publicado el 2025-04-19

¿Qué método es más eficiente para la detección de Point-in-Polygon: Ray Tracing o Matplotlib \ 's Rath.Contains_Points?Detección eficiente de Point-in-Polygon en python determinando si un punto se encuentra dentro de un polígono es una tarea frecuente en la geome...Programación Publicado el 2025-04-19 -

FormaciónLos métodos son fns que se pueden llamar a los objetos Las matrices son objetos, por lo tanto, también tienen métodos en js. Slice (Begi...Programación Publicado el 2025-04-19

FormaciónLos métodos son fns que se pueden llamar a los objetos Las matrices son objetos, por lo tanto, también tienen métodos en js. Slice (Begi...Programación Publicado el 2025-04-19 -

¿Puedes usar CSS para la salida de la consola de color en Chrome y Firefox?que muestra los colores en la console JavaScript es posible usar la consola de Chrome para mostrar texto coloreado, como rojo para errores, na...Programación Publicado el 2025-04-19

¿Puedes usar CSS para la salida de la consola de color en Chrome y Firefox?que muestra los colores en la console JavaScript es posible usar la consola de Chrome para mostrar texto coloreado, como rojo para errores, na...Programación Publicado el 2025-04-19 -

¿Cómo distinguir correctamente entre valores unset y nulos en GO?Distinguiendo correctamente entre no establecer Vs. Valores vacíos cuando se trabaja con estructuras en Go, puede ser crucial para diferenciar e...Programación Publicado el 2025-04-19

¿Cómo distinguir correctamente entre valores unset y nulos en GO?Distinguiendo correctamente entre no establecer Vs. Valores vacíos cuando se trabaja con estructuras en Go, puede ser crucial para diferenciar e...Programación Publicado el 2025-04-19 -

¿Cómo acceder dinámicamente a las variables globales en JavaScript?Acceder a variables globales dinámicamente por nombre en javascript a las variables globales durante el tiempo de ejecución puede ser un requisi...Programación Publicado el 2025-04-19

¿Cómo acceder dinámicamente a las variables globales en JavaScript?Acceder a variables globales dinámicamente por nombre en javascript a las variables globales durante el tiempo de ejecución puede ser un requisi...Programación Publicado el 2025-04-19 -

¿Por qué no aparece mi imagen de fondo CSS?Solución de problemas: css La imagen de fondo que no aparece ha encontrado un problema en el que su imagen de fondo no se carga a pesar de las...Programación Publicado el 2025-04-19

¿Por qué no aparece mi imagen de fondo CSS?Solución de problemas: css La imagen de fondo que no aparece ha encontrado un problema en el que su imagen de fondo no se carga a pesar de las...Programación Publicado el 2025-04-19 -

Cuándo evitar campos de Java estáticos y por quéexplorando la naturaleza y los matices de los campos estáticos en java problema: a menudo encuentran la necesidad de compartir datos entre...Programación Publicado el 2025-04-19

Cuándo evitar campos de Java estáticos y por quéexplorando la naturaleza y los matices de los campos estáticos en java problema: a menudo encuentran la necesidad de compartir datos entre...Programación Publicado el 2025-04-19 -

¿Cómo mostrar correctamente la fecha y hora actuales en el formato "DD/MM/YYYY HH: MM: SS.SS" en Java?cómo mostrar la fecha y la hora actuales en "dd/mm/aa radica en el uso de diferentes instancias de SimpleFormat con diferentes patrones de f...Programación Publicado el 2025-04-19

¿Cómo mostrar correctamente la fecha y hora actuales en el formato "DD/MM/YYYY HH: MM: SS.SS" en Java?cómo mostrar la fecha y la hora actuales en "dd/mm/aa radica en el uso de diferentes instancias de SimpleFormat con diferentes patrones de f...Programación Publicado el 2025-04-19 -

¿Cómo enviar una solicitud de publicación en bruto con Curl en PHP?Cómo enviar una solicitud de publicación sin procesar usando curl en php en php, Curl es una biblioteca popular para enviar solicitudes HTTP. ...Programación Publicado el 2025-04-19

¿Cómo enviar una solicitud de publicación en bruto con Curl en PHP?Cómo enviar una solicitud de publicación sin procesar usando curl en php en php, Curl es una biblioteca popular para enviar solicitudes HTTP. ...Programación Publicado el 2025-04-19 -

¿Cómo verificar si un objeto tiene un atributo específico en Python?para determinar el atributo de objeto existencia Esta consulta busca un método para verificar la presencia de un atributo específico dentro de...Programación Publicado el 2025-04-19

¿Cómo verificar si un objeto tiene un atributo específico en Python?para determinar el atributo de objeto existencia Esta consulta busca un método para verificar la presencia de un atributo específico dentro de...Programación Publicado el 2025-04-19

Estudiar chino

- 1 ¿Cómo se dice "caminar" en chino? 走路 pronunciación china, 走路 aprendizaje chino

- 2 ¿Cómo se dice "tomar un avión" en chino? 坐飞机 pronunciación china, 坐飞机 aprendizaje chino

- 3 ¿Cómo se dice "tomar un tren" en chino? 坐火车 pronunciación china, 坐火车 aprendizaje chino

- 4 ¿Cómo se dice "tomar un autobús" en chino? 坐车 pronunciación china, 坐车 aprendizaje chino

- 5 ¿Cómo se dice conducir en chino? 开车 pronunciación china, 开车 aprendizaje chino

- 6 ¿Cómo se dice nadar en chino? 游泳 pronunciación china, 游泳 aprendizaje chino

- 7 ¿Cómo se dice andar en bicicleta en chino? 骑自行车 pronunciación china, 骑自行车 aprendizaje chino

- 8 ¿Cómo se dice hola en chino? 你好Pronunciación china, 你好Aprendizaje chino

- 9 ¿Cómo se dice gracias en chino? 谢谢Pronunciación china, 谢谢Aprendizaje chino

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning