ResNet vs. EfficientNet vs. VGG vs. NN

Als Student habe ich aus erster Hand die Frustration miterlebt, die durch das ineffiziente Fundbüro unserer Universität verursacht wurde. Der aktuelle Prozess, der auf individuellen E-Mails für jeden gefundenen Gegenstand beruht, führt häufig zu Verzögerungen und fehlenden Verbindungen zwischen verlorenen Gegenständen und ihren Besitzern.

Angetrieben von dem Wunsch, diese Erfahrung für mich und meine Kommilitonen zu verbessern, habe ich ein Projekt gestartet, um das Potenzial von Deep Learning für die Revolutionierung unseres Fundbüros zu erkunden. In diesem Blogbeitrag teile ich meine Erfahrung mit der Evaluierung vorab trainierter Modelle – ResNet, EfficientNet, VGG und NasNet – zur Automatisierung der Identifizierung und Kategorisierung verlorener Gegenstände.

Durch eine vergleichende Analyse möchte ich das am besten geeignete Modell für die Integration in unser System ermitteln, um letztendlich ein schnelleres, genaueres und benutzerfreundlicheres Fundraising-Erlebnis für alle auf dem Campus zu schaffen.

ResNet

Inception-ResNet V2 ist eine leistungsstarke Faltungs-Neuronale Netzwerkarchitektur, die in Keras verfügbar ist und die Stärken der Inception-Architektur mit Restverbindungen von ResNet kombiniert. Dieses Hybridmodell zielt darauf ab, eine hohe Genauigkeit bei Bildklassifizierungsaufgaben zu erreichen und gleichzeitig die Recheneffizienz aufrechtzuerhalten.

Trainingsdatensatz: ImageNet

Bildformat: 299 x 299

Vorverarbeitungsfunktion

def readyForResNet(fileName):

pic = load_img(fileName, target_size=(299, 299))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_resnet(expanded)

Vorhersagen

data1 = readyForResNet(test_file) prediction = inception_model_resnet.predict(data1) res1 = decode_predictions_resnet(prediction, top=2)

VGG (Visuelle Geometrie-Gruppe)

VGG (Visual Geometry Group) ist eine Familie tiefer Faltungs-Neuronaler Netzwerkarchitekturen, die für ihre Einfachheit und Effektivität bei Bildklassifizierungsaufgaben bekannt sind. Diese Modelle, insbesondere VGG16 und VGG19, gewannen aufgrund ihrer starken Leistung bei der ImageNet Large Scale Visual Recognition Challenge (ILSVRC) im Jahr 2014 an Popularität.

Trainingsdatensatz: ImageNet

Bildformat: 224 x 224

Vorverarbeitungsfunktion

def readyForVGG(fileName):

pic = load_img(fileName, target_size=(224, 224))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_vgg19(expanded)

Vorhersagen

data2 = readyForVGG(test_file) prediction = inception_model_vgg19.predict(data2) res2 = decode_predictions_vgg19(prediction, top=2)

EfficientNet

EfficientNet ist eine Familie faltender neuronaler Netzwerkarchitekturen, die bei Bildklassifizierungsaufgaben modernste Genauigkeit erreichen und dabei deutlich kleiner und schneller als frühere Modelle sind. Diese Effizienz wird durch eine neuartige zusammengesetzte Skalierungsmethode erreicht, die Netzwerktiefe, -breite und -auflösung ausbalanciert.

Trainingsdatensatz: ImageNet

Bildformat: 480 x 480

Vorverarbeitungsfunktion

def readyForEF(fileName):

pic = load_img(fileName, target_size=(480, 480))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_EF(expanded)

Vorhersagen

data3 = readyForEF(test_file) prediction = inception_model_EF.predict(data3) res3 = decode_predictions_EF(prediction, top=2)

NasNet

NasNet (Neural Architecture Search Network) stellt einen bahnbrechenden Ansatz im Deep Learning dar, bei dem die Architektur des neuronalen Netzwerks selbst durch einen automatisierten Suchprozess entdeckt wird. Ziel dieses Suchprozesses ist es, die optimale Kombination von Schichten und Verbindungen zu finden, um bei einer bestimmten Aufgabe eine hohe Leistung zu erzielen.

Trainingsdatensatz: ImageNet

Bildformat: 224 x 224

Vorverarbeitungsfunktion

def readyForNN(fileName):

pic = load_img(fileName, target_size=(224, 224))

pic_array = img_to_array(pic)

expanded = np.expand_dims(pic_array, axis=0)

return preprocess_input_NN(expanded)

Vorhersagen

data4 = readyForNN(test_file) prediction = inception_model_NN.predict(data4) res4 = decode_predictions_NN(prediction, top=2)

Showdown

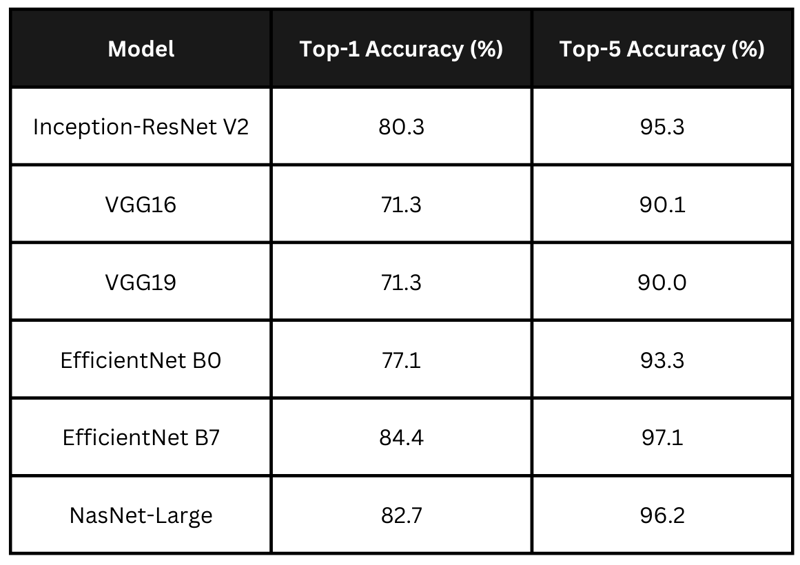

Genauigkeit

Die Tabelle fasst die behaupteten Genauigkeitswerte der oben genannten Modelle zusammen. EfficientNet B7 führt mit der höchsten Genauigkeit, dicht gefolgt von NasNet-Large und Inception-ResNet V2. VGG-Modelle weisen geringere Genauigkeiten auf. Für meine Anwendung möchte ich ein Modell wählen, das ein Gleichgewicht zwischen Bearbeitungszeit und Genauigkeit bietet.

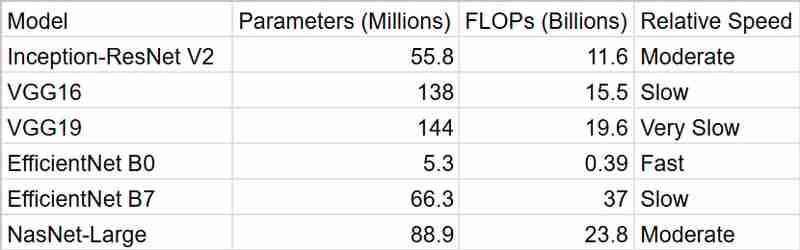

Zeit

Wie wir sehen können, liefert uns EfficientNetB0 die schnellsten Ergebnisse, aber InceptionResNetV2 ist ein besseres Paket, wenn man die Genauigkeit berücksichtigt

Zusammenfassung

Für mein intelligentes Fundbüro-System habe ich mich für InceptionResNetV2 entschieden. Während EfficientNet B7 mit seiner erstklassigen Genauigkeit verlockend aussah, machte ich mir Sorgen wegen seines Rechenaufwands. In einem universitären Umfeld, in dem die Ressourcen möglicherweise begrenzt sind und Echtzeitleistung oft wünschenswert ist, hielt ich es für wichtig, ein Gleichgewicht zwischen Genauigkeit und Effizienz zu finden. InceptionResNetV2 schien die perfekte Lösung zu sein – es bietet eine starke Leistung, ohne übermäßig rechenintensiv zu sein.

Außerdem gibt mir die Tatsache, dass es auf ImageNet vorab trainiert wurde, die Gewissheit, dass es mit der Vielfalt an Objekten umgehen kann, die Menschen verlieren könnten. Und vergessen wir nicht, wie einfach die Arbeit mit Keras ist! Das hat mir die Entscheidung auf jeden Fall erleichtert.

Insgesamt glaube ich, dass InceptionResNetV2 die richtige Mischung aus Genauigkeit, Effizienz und Praktikabilität für mein Projekt bietet. Ich bin gespannt, wie es dabei hilft, verlorene Gegenstände wieder mit ihren Besitzern zusammenzuführen!

-

Wie kombiniere ich zwei assoziative Arrays in PHP und behalte dabei eindeutige IDs bei und verarbeite doppelte Namen?Kombinieren assoziativer Arrays in PHPIn PHP ist das Kombinieren zweier assoziativer Arrays zu einem einzigen Array eine häufige Aufgabe. Betrachten S...Programmierung Veröffentlicht am 25.12.2024

Wie kombiniere ich zwei assoziative Arrays in PHP und behalte dabei eindeutige IDs bei und verarbeite doppelte Namen?Kombinieren assoziativer Arrays in PHPIn PHP ist das Kombinieren zweier assoziativer Arrays zu einem einzigen Array eine häufige Aufgabe. Betrachten S...Programmierung Veröffentlicht am 25.12.2024 -

Jenseits von „if“-Anweisungen: Wo sonst kann ein Typ mit einer expliziten „bool“-Konvertierung ohne Umwandlung verwendet werden?Kontextuelle Konvertierung in „bool“ ohne Umwandlung zulässigIhre Klasse definiert eine explizite Konvertierung in „bool“, sodass Sie ihre Instanz „t“...Programmierung Veröffentlicht am 25.12.2024

Jenseits von „if“-Anweisungen: Wo sonst kann ein Typ mit einer expliziten „bool“-Konvertierung ohne Umwandlung verwendet werden?Kontextuelle Konvertierung in „bool“ ohne Umwandlung zulässigIhre Klasse definiert eine explizite Konvertierung in „bool“, sodass Sie ihre Instanz „t“...Programmierung Veröffentlicht am 25.12.2024 -

Verwendung von WebSockets in Go für EchtzeitkommunikationDas Erstellen von Apps, die Echtzeit-Updates erfordern – wie Chat-Anwendungen, Live-Benachrichtigungen oder Tools für die Zusammenarbeit – erfordert e...Programmierung Veröffentlicht am 25.12.2024

Verwendung von WebSockets in Go für EchtzeitkommunikationDas Erstellen von Apps, die Echtzeit-Updates erfordern – wie Chat-Anwendungen, Live-Benachrichtigungen oder Tools für die Zusammenarbeit – erfordert e...Programmierung Veröffentlicht am 25.12.2024 -

Wie kann ich mit MySQL Benutzer mit den heutigen Geburtstagen finden?So identifizieren Sie Benutzer mit heutigen Geburtstagen mithilfe von MySQLUm mithilfe von MySQL festzustellen, ob heute der Geburtstag eines Benutzer...Programmierung Veröffentlicht am 25.12.2024

Wie kann ich mit MySQL Benutzer mit den heutigen Geburtstagen finden?So identifizieren Sie Benutzer mit heutigen Geburtstagen mithilfe von MySQLUm mithilfe von MySQL festzustellen, ob heute der Geburtstag eines Benutzer...Programmierung Veröffentlicht am 25.12.2024 -

Wie behebt man „Unsachgemäß konfiguriert: Fehler beim Laden des MySQLdb-Moduls“ in Django unter macOS?MySQL falsch konfiguriert: Das Problem mit relativen PfadenBeim Ausführen von python manage.py runserver in Django kann der folgende Fehler auftreten:...Programmierung Veröffentlicht am 25.12.2024

Wie behebt man „Unsachgemäß konfiguriert: Fehler beim Laden des MySQLdb-Moduls“ in Django unter macOS?MySQL falsch konfiguriert: Das Problem mit relativen PfadenBeim Ausführen von python manage.py runserver in Django kann der folgende Fehler auftreten:...Programmierung Veröffentlicht am 25.12.2024 -

Wie kann ich Pandas-DataFrame-String-Einträge in separate Zeilen auflösen (aufteilen)?Pandas-DataFrame-Stringeinträge in separate Zeilen auflösen (aufteilen)In Pandas besteht eine häufige Anforderung darin, durch Kommas getrennte Werte ...Programmierung Veröffentlicht am 25.12.2024

Wie kann ich Pandas-DataFrame-String-Einträge in separate Zeilen auflösen (aufteilen)?Pandas-DataFrame-Stringeinträge in separate Zeilen auflösen (aufteilen)In Pandas besteht eine häufige Anforderung darin, durch Kommas getrennte Werte ...Programmierung Veröffentlicht am 25.12.2024 -

Was ist mit dem Spaltenversatz in Bootstrap 4 Beta passiert?Bootstrap 4 Beta: Die Entfernung und Wiederherstellung des SpaltenversatzesBootstrap 4 führte in seiner Beta-1-Version wesentliche Änderungen an der A...Programmierung Veröffentlicht am 25.12.2024

Was ist mit dem Spaltenversatz in Bootstrap 4 Beta passiert?Bootstrap 4 Beta: Die Entfernung und Wiederherstellung des SpaltenversatzesBootstrap 4 führte in seiner Beta-1-Version wesentliche Änderungen an der A...Programmierung Veröffentlicht am 25.12.2024 -

Wie kann ich Dateien mit Selenium WebDriver in Java effizient hochladen?Hochladen von Dateien mit Selenium WebDriver in Java: Eine detaillierte AnleitungDas Hochladen von Dateien in Webanwendungen ist eine häufige Aufgabe ...Programmierung Veröffentlicht am 24.12.2024

Wie kann ich Dateien mit Selenium WebDriver in Java effizient hochladen?Hochladen von Dateien mit Selenium WebDriver in Java: Eine detaillierte AnleitungDas Hochladen von Dateien in Webanwendungen ist eine häufige Aufgabe ...Programmierung Veröffentlicht am 24.12.2024 -

C-Entwicklung mit GNU EmacsEmacs is designed with programming in mind, it supports languages like C, Python, and Lisp natively, offering advanced features such as syntax highli...Programmierung Veröffentlicht am 24.12.2024

C-Entwicklung mit GNU EmacsEmacs is designed with programming in mind, it supports languages like C, Python, and Lisp natively, offering advanced features such as syntax highli...Programmierung Veröffentlicht am 24.12.2024 -

Wie kann ich eine Variable in einfachen Anführungszeichen in PHP drucken?Eine Variable kann nicht direkt mit einfachen Anführungszeichen wiedergegeben werdenMüssen Sie eine Variable innerhalb einer Zeichenfolge in einfachen...Programmierung Veröffentlicht am 24.12.2024

Wie kann ich eine Variable in einfachen Anführungszeichen in PHP drucken?Eine Variable kann nicht direkt mit einfachen Anführungszeichen wiedergegeben werdenMüssen Sie eine Variable innerhalb einer Zeichenfolge in einfachen...Programmierung Veröffentlicht am 24.12.2024 -

std::vector vs. einfache Arrays: Wann ist Leistung wirklich wichtig?std::vector vs. einfache Arrays: LeistungsbewertungWährend allgemein angenommen wird, dass std::vector ähnlich wie Arrays funktioniert, haben neuere T...Programmierung Veröffentlicht am 24.12.2024

std::vector vs. einfache Arrays: Wann ist Leistung wirklich wichtig?std::vector vs. einfache Arrays: LeistungsbewertungWährend allgemein angenommen wird, dass std::vector ähnlich wie Arrays funktioniert, haben neuere T...Programmierung Veröffentlicht am 24.12.2024 -

Warum scheint Double Precision mehr Dezimalstellen zu haben als die angekündigten 15?Doppelte Genauigkeit und Genauigkeit mit DezimalstellenIn der Computerprogrammierung wird häufig davon ausgegangen, dass der Datentyp mit doppelter Ge...Programmierung Veröffentlicht am 24.12.2024

Warum scheint Double Precision mehr Dezimalstellen zu haben als die angekündigten 15?Doppelte Genauigkeit und Genauigkeit mit DezimalstellenIn der Computerprogrammierung wird häufig davon ausgegangen, dass der Datentyp mit doppelter Ge...Programmierung Veröffentlicht am 24.12.2024 -

Implizite vs. explizite Rückgaben in Pfeilfunktionen: Wann sind geschweifte Klammern notwendig?Geschweifte Klammern in Pfeilfunktionen: Implizite vs. explizite RückgabenPfeilfunktionen können auf zwei Arten geschrieben werden: mit oder ohne gesc...Programmierung Veröffentlicht am 24.12.2024

Implizite vs. explizite Rückgaben in Pfeilfunktionen: Wann sind geschweifte Klammern notwendig?Geschweifte Klammern in Pfeilfunktionen: Implizite vs. explizite RückgabenPfeilfunktionen können auf zwei Arten geschrieben werden: mit oder ohne gesc...Programmierung Veröffentlicht am 24.12.2024 -

Warum ist mein Text in Chrome verschwommen, nachdem ich „transform: scale()“ verwendet habe?Textunschärfe in Chrome nach der Transformation: scale()In den letzten Chrome-Updates ist ein besonderes Problem aufgetreten, bei dem Text mit der CSS...Programmierung Veröffentlicht am 24.12.2024

Warum ist mein Text in Chrome verschwommen, nachdem ich „transform: scale()“ verwendet habe?Textunschärfe in Chrome nach der Transformation: scale()In den letzten Chrome-Updates ist ein besonderes Problem aufgetreten, bei dem Text mit der CSS...Programmierung Veröffentlicht am 24.12.2024 -

Wie können Sie die MDC-Protokollierung in GoLang implementieren?MDC-Protokollierung in GoLangDie MDC-Protokollierung von Java basiert auf lokalem Thread-Speicher, der in GoLang nicht verfügbar ist. Eine ähnliche Fu...Programmierung Veröffentlicht am 23.12.2024

Wie können Sie die MDC-Protokollierung in GoLang implementieren?MDC-Protokollierung in GoLangDie MDC-Protokollierung von Java basiert auf lokalem Thread-Speicher, der in GoLang nicht verfügbar ist. Eine ähnliche Fu...Programmierung Veröffentlicht am 23.12.2024

Chinesisch lernen

- 1 Wie sagt man „gehen“ auf Chinesisch? 走路 Chinesische Aussprache, 走路 Chinesisch lernen

- 2 Wie sagt man auf Chinesisch „Flugzeug nehmen“? 坐飞机 Chinesische Aussprache, 坐飞机 Chinesisch lernen

- 3 Wie sagt man auf Chinesisch „einen Zug nehmen“? 坐火车 Chinesische Aussprache, 坐火车 Chinesisch lernen

- 4 Wie sagt man auf Chinesisch „Bus nehmen“? 坐车 Chinesische Aussprache, 坐车 Chinesisch lernen

- 5 Wie sagt man „Fahren“ auf Chinesisch? 开车 Chinesische Aussprache, 开车 Chinesisch lernen

- 6 Wie sagt man Schwimmen auf Chinesisch? 游泳 Chinesische Aussprache, 游泳 Chinesisch lernen

- 7 Wie sagt man auf Chinesisch „Fahrrad fahren“? 骑自行车 Chinesische Aussprache, 骑自行车 Chinesisch lernen

- 8 Wie sagt man auf Chinesisch Hallo? 你好Chinesische Aussprache, 你好Chinesisch lernen

- 9 Wie sagt man „Danke“ auf Chinesisch? 谢谢Chinesische Aussprache, 谢谢Chinesisch lernen

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning