Titelseite > Programmierung > Entwicklung effizienter Algorithmen – Messung der Algorithmeneffizienz mithilfe der Big-O-Notation

Titelseite > Programmierung > Entwicklung effizienter Algorithmen – Messung der Algorithmeneffizienz mithilfe der Big-O-Notation

Entwicklung effizienter Algorithmen – Messung der Algorithmeneffizienz mithilfe der Big-O-Notation

Algorithmusdesign ist die Entwicklung eines mathematischen Prozesses zur Lösung eines Problems. Bei der Algorithmusanalyse geht es darum, die Leistung eines Algorithmus vorherzusagen. In den beiden vorangegangenen Kapiteln wurden klassische Datenstrukturen (Listen, Stapel, Warteschlangen, Prioritätswarteschlangen, Mengen und Karten) vorgestellt und zur Lösung von Problemen angewendet. In diesem Kapitel werden anhand verschiedener Beispiele gängige algorithmische Techniken (dynamische Programmierung, Divide-and-Conquer und Backtracking) zur Entwicklung effizienter Algorithmen vorgestellt.

Die Big-O-Notation erhält eine Funktion zum Messen der Zeitkomplexität des Algorithmus basierend auf der Eingabegröße. Sie können multiplikative Konstanten und nicht dominierende Terme in der Funktion ignorieren. Angenommen, zwei Algorithmen führen dieselbe Aufgabe aus, beispielsweise eine Suche (lineare Suche vs. binäre Suche). Welches ist besser? Um diese Frage zu beantworten, könnten Sie diese Algorithmen implementieren und die Programme ausführen, um Ausführungszeit zu erhalten. Bei diesem Ansatz gibt es jedoch zwei Probleme:

- Erstens werden viele Aufgaben gleichzeitig auf einem Computer ausgeführt. Die Ausführungszeit eines bestimmten Programms hängt von der Systemlast ab.

- Zweitens hängt die Ausführungszeit von der spezifischen Eingabe ab. Betrachten Sie beispielsweise die lineare Suche und die binäre Suche. Wenn ein zu durchsuchendes Element zufällig das erste in der Liste ist, findet die lineare Suche das Element schneller als die binäre Suche.

Es ist sehr schwierig, Algorithmen durch Messung ihrer Ausführungszeit zu vergleichen. Um diese Probleme zu überwinden, wurde ein theoretischer Ansatz entwickelt, um Algorithmen unabhängig von Computern und spezifischen Eingaben zu analysieren. Dieser Ansatz nähert sich der Auswirkung einer Änderung auf die Größe der Eingabe an. Auf diese Weise können Sie sehen, wie schnell die Ausführungszeit eines Algorithmus mit zunehmender Eingabegröße zunimmt, sodass Sie zwei Algorithmen vergleichen können, indem Sie ihre Wachstumsraten untersuchen.

Erwägen Sie die lineare Suche. Der lineare Suchalgorithmus vergleicht den Schlüssel nacheinander mit den Elementen im Array, bis der Schlüssel gefunden wird oder das Array erschöpft ist. Wenn sich der Schlüssel nicht im Array befindet, sind n Vergleiche für ein Array der Größe n erforderlich. Wenn sich der Schlüssel im Array befindet, sind im Durchschnitt n/2 Vergleiche erforderlich. Die Ausführungszeit des Algorithmus ist proportional zur Größe des Arrays. Wenn Sie die Größe des Arrays verdoppeln, können Sie damit rechnen, dass sich die Anzahl der Vergleiche verdoppelt. Der Algorithmus wächst linear. Die Wachstumsrate liegt in der Größenordnung von n. Informatiker verwenden die Big-O-Notation, um die „Größenordnung“ darzustellen. Unter Verwendung dieser Notation beträgt die Komplexität des linearen Suchalgorithmus O(n), ausgesprochen als „Ordnung von n.“ Wir nennen einen Algorithmus mit einer Zeitkomplexität von O(n) einen linearen Algorithmus und er weist eine lineare Wachstumsrate auf.

Bei gleicher Eingabegröße kann die Ausführungszeit eines Algorithmus je nach Eingabe variieren. Eine Eingabe, die zur kürzesten Ausführungszeit führt, wird als Best-Case-Eingabe bezeichnet, und eine Eingabe, die zur längsten Ausführungszeit führt, ist die Worst-Case-Eingabe. Best-Case-Analyse und

Bei der Worst-Case-Analyse werden die Algorithmen hinsichtlich ihrer Best-Case-Eingabe und Worst-Case-Eingabe analysiert. Best-Case- und Worst-Case-Analysen sind nicht repräsentativ, die Worst-Case-Analyse ist jedoch sehr nützlich. Sie können sicher sein, dass der Algorithmus niemals langsamer sein wird als im schlimmsten Fall.

Eine Durchschnittsfallanalyse versucht, die durchschnittliche Zeitdauer aller möglichen Eingaben derselben Größe zu bestimmen. Eine Durchschnittsfallanalyse ist ideal, aber schwierig durchzuführen, da es bei vielen Problemen schwierig ist, die relativen Wahrscheinlichkeiten und Verteilungen verschiedener Eingabeinstanzen zu bestimmen. Die Worst-Case-Analyse ist einfacher durchzuführen, daher wird die Analyse im Allgemeinen für den Worst-Case durchgeführt.

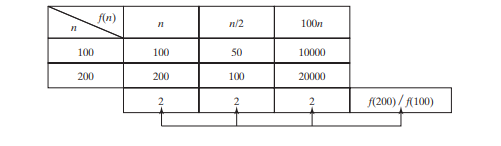

Der lineare Suchalgorithmus erfordert im schlimmsten Fall n Vergleiche und im durchschnittlichen Fall n/2 Vergleiche, wenn Sie fast immer nach etwas suchen, von dem bekannt ist, dass es in der Liste enthalten ist. Bei Verwendung der Big-O-Notation benötigen beide Fälle O(n)-Zeit. Die multiplikative Konstante (1/2) kann weggelassen werden. Die Algorithmusanalyse konzentriert sich auf die Wachstumsrate. Die multiplikativen Konstanten haben keinen Einfluss auf die Wachstumsraten. Die Wachstumsrate für n/2 oder 100_n_ ist dieselbe wie für n, wie in der folgenden Tabelle dargestellt: Wachstumsraten. Daher ist O(n) = O(n/2) = O(100n).

Betrachten Sie den Algorithmus zum Ermitteln der maximalen Anzahl in einem Array mit n Elementen. Um die maximale Anzahl zu ermitteln, wenn n 2 ist, ist ein Vergleich erforderlich. wenn n 3 ist, zwei Vergleiche. Im Allgemeinen sind n–1 Vergleiche erforderlich, um die maximale Anzahl in einer Liste mit n Elementen zu ermitteln. Die Algorithmusanalyse ist für große Eingabegrößen vorgesehen. Wenn die Eingabegröße klein ist, hat die Schätzung der Effizienz eines Algorithmus keine Bedeutung. Wenn n größer wird, dominiert der n-Teil im Ausdruck n - 1 die Komplexität. Mit der Big-O-Notation können Sie den nicht dominierenden Teil ignorieren (z. B. -1 im

Ausdruck n - 1) und markieren Sie den wichtigen Teil (z. B. n im Ausdruck n - 1). Daher beträgt die Komplexität dieses Algorithmus O(n).

Die Big-O-Notation schätzt die Ausführungszeit eines Algorithmus im Verhältnis zur Eingabegröße. Wenn die Zeit nicht mit der Eingabegröße zusammenhängt, sagt man, dass der Algorithmus konstante Zeit mit der Notation O(1) annimmt. Beispielsweise eine Methode, die ein Element an einem bestimmten Index in einem Array abruft

benötigt eine konstante Zeit, da die Zeit nicht mit zunehmender Größe des Arrays wächst.

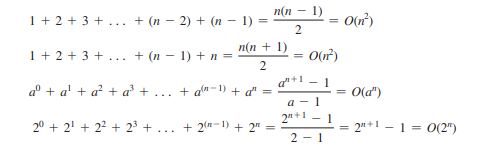

Die folgenden mathematischen Summierungen sind bei der Algorithmusanalyse oft nützlich:

Zeitkomplexität ist ein Maß für die Ausführungszeit unter Verwendung der Big-O-Notation. In ähnlicher Weise können Sie auch die Raumkomplexität mithilfe der Big-O-Notation messen. Speicherplatzkomplexität misst die Menge an Speicherplatz, die von einem Algorithmus verwendet wird. Die Raumkomplexität für die meisten im Buch vorgestellten Algorithmen beträgt O(n). Das heißt, sie weisen eine lineare Wachstumsrate zur Eingabegröße auf. Beispielsweise beträgt die Raumkomplexität für die lineare Suche O(n).

-

Welche Methode ist effizienter für die Erkennung von Punkt-in-Polygon: Strahlenverfolgung oder Matplotlib \ 's path.contains_points?effiziente Punkt-in-Polygon-Erkennung in Python festlegen, ob ein Punkt innerhalb eines Polygons eine häufige Aufgabe in der Computergeometrie i...Programmierung Gepostet am 2025-07-13

Welche Methode ist effizienter für die Erkennung von Punkt-in-Polygon: Strahlenverfolgung oder Matplotlib \ 's path.contains_points?effiziente Punkt-in-Polygon-Erkennung in Python festlegen, ob ein Punkt innerhalb eines Polygons eine häufige Aufgabe in der Computergeometrie i...Programmierung Gepostet am 2025-07-13 -

\ "während (1) gegen (;;): Beseitigt die Compiler -Optimierung Leistungsunterschiede? \"wob führt die Verwendung von (1) statt für (;;) zu einem Leistungsunterschied in Infinite führt Loops? Antwort: In den meisten modernen C...Programmierung Gepostet am 2025-07-13

\ "während (1) gegen (;;): Beseitigt die Compiler -Optimierung Leistungsunterschiede? \"wob führt die Verwendung von (1) statt für (;;) zu einem Leistungsunterschied in Infinite führt Loops? Antwort: In den meisten modernen C...Programmierung Gepostet am 2025-07-13 -

Wie gehe ich mit in Scheiben geschnittener Erinnerung in Go Language Garbage Collection um?Garbage Collection in Go Slices: Eine detaillierte Analyse In Go ist ein Slice ein dynamisches Array, das auf ein zugrunde liegendes Array ver...Programmierung Gepostet am 2025-07-13

Wie gehe ich mit in Scheiben geschnittener Erinnerung in Go Language Garbage Collection um?Garbage Collection in Go Slices: Eine detaillierte Analyse In Go ist ein Slice ein dynamisches Array, das auf ein zugrunde liegendes Array ver...Programmierung Gepostet am 2025-07-13 -

Wie entferte ich anonyme JavaScript -Ereignishandler sauber?entfernen anonymer Ereignis -Hörer Hinzufügen von anonymen Ereignishörern zu Elementen bieten Flexibilität und Einfachheit, aber wenn es Zeit is...Programmierung Gepostet am 2025-07-13

Wie entferte ich anonyme JavaScript -Ereignishandler sauber?entfernen anonymer Ereignis -Hörer Hinzufügen von anonymen Ereignishörern zu Elementen bieten Flexibilität und Einfachheit, aber wenn es Zeit is...Programmierung Gepostet am 2025-07-13 -

Wie kann man die Funktionsbeschränkungen von PHP 'Funktionen überwinden?Überwindung von PHP-Funktionsfunktionen Einschränkungen In PHP sind eine Funktion mit demselben Namen mehrmals ein No-no. Der Versuch, dies zu...Programmierung Gepostet am 2025-07-13

Wie kann man die Funktionsbeschränkungen von PHP 'Funktionen überwinden?Überwindung von PHP-Funktionsfunktionen Einschränkungen In PHP sind eine Funktion mit demselben Namen mehrmals ein No-no. Der Versuch, dies zu...Programmierung Gepostet am 2025-07-13 -

Was ist der Unterschied zwischen verschachtelten Funktionen und Schließungen in PythonNested Functions vs. Closures in PythonWhile nested functions in Python superficially resemble closures, they are fundamentally distinct due to a key ...Programmierung Gepostet am 2025-07-13

Was ist der Unterschied zwischen verschachtelten Funktionen und Schließungen in PythonNested Functions vs. Closures in PythonWhile nested functions in Python superficially resemble closures, they are fundamentally distinct due to a key ...Programmierung Gepostet am 2025-07-13 -

Wie vereinfachen Javas Map.Enty und SimpleEnry das Schlüsselwertpaarmanagement?Eine umfassende Sammlung für Wertpaare: Einführung von Javas map.Entry und SimpleEnry in Java, wenn eine Sammlung definiert wird, bei der jede...Programmierung Gepostet am 2025-07-13

Wie vereinfachen Javas Map.Enty und SimpleEnry das Schlüsselwertpaarmanagement?Eine umfassende Sammlung für Wertpaare: Einführung von Javas map.Entry und SimpleEnry in Java, wenn eine Sammlung definiert wird, bei der jede...Programmierung Gepostet am 2025-07-13 -

Warum kann Microsoft Visual C ++ keine zweiphasige Vorlage-Instanziierung korrekt implementieren?Das Geheimnis von "kaputte" Two-Phase-Vorlage Instantiation in Microsoft visual c Problemanweisung: Benutzer werden häufig besorgt...Programmierung Gepostet am 2025-07-13

Warum kann Microsoft Visual C ++ keine zweiphasige Vorlage-Instanziierung korrekt implementieren?Das Geheimnis von "kaputte" Two-Phase-Vorlage Instantiation in Microsoft visual c Problemanweisung: Benutzer werden häufig besorgt...Programmierung Gepostet am 2025-07-13 -

Warum wird die Anfrage nicht nach dem Erfassen von Eingaben in PHP trotz gültiger Code erfasst?adressieren nach Anfrage Fehlfunktion in php in dem vorgestellten Code -Snippet: action='' Die Intented -In -Intented -Aufnahme. Die Ausg...Programmierung Gepostet am 2025-07-13

Warum wird die Anfrage nicht nach dem Erfassen von Eingaben in PHP trotz gültiger Code erfasst?adressieren nach Anfrage Fehlfunktion in php in dem vorgestellten Code -Snippet: action='' Die Intented -In -Intented -Aufnahme. Die Ausg...Programmierung Gepostet am 2025-07-13 -

Benutzer lokaler Zeitformat und Zeitzonen -Offset -AnzeigehandbuchAnzeige von Datum/Uhrzeit im Gebietsschema-Format des Benutzer mit Zeit offset Bei der Präsentation von Daten und Zeiten den Endbenutzern sind...Programmierung Gepostet am 2025-07-13

Benutzer lokaler Zeitformat und Zeitzonen -Offset -AnzeigehandbuchAnzeige von Datum/Uhrzeit im Gebietsschema-Format des Benutzer mit Zeit offset Bei der Präsentation von Daten und Zeiten den Endbenutzern sind...Programmierung Gepostet am 2025-07-13 -

Können Templatparameter in C ++ 20 -Konstalfunktion von Funktionsparametern abhängen?konstvale Funktionen und Vorlagenparameter, die von Funktionsargumenten abhängen In c 17 kompile-time. c 20 canteval functions c 20 führ...Programmierung Gepostet am 2025-07-13

Können Templatparameter in C ++ 20 -Konstalfunktion von Funktionsparametern abhängen?konstvale Funktionen und Vorlagenparameter, die von Funktionsargumenten abhängen In c 17 kompile-time. c 20 canteval functions c 20 führ...Programmierung Gepostet am 2025-07-13 -

Kann ich meine Verschlüsselung von McRypt nach OpenSSL migrieren und mit OpenSSL von McRypt-verkürzten Daten entschlüsseln?Upgrade meiner Verschlüsselungsbibliothek von McRypt auf OpenSSL Kann ich meine Verschlüsselungsbibliothek von McRypt nach OpenSsl aufrüsten? ...Programmierung Gepostet am 2025-07-13

Kann ich meine Verschlüsselung von McRypt nach OpenSSL migrieren und mit OpenSSL von McRypt-verkürzten Daten entschlüsseln?Upgrade meiner Verschlüsselungsbibliothek von McRypt auf OpenSSL Kann ich meine Verschlüsselungsbibliothek von McRypt nach OpenSsl aufrüsten? ...Programmierung Gepostet am 2025-07-13 -

Ursachen und Lösungen für den Ausfall der Gesichtserkennung: Fehler -215Fehlerbehandlung: Auflösen "Fehler: (-215)! Leere () In Funktion DESTECTMULTICALS" In opencv , wenn Sie versuchen, das Erstellen der ...Programmierung Gepostet am 2025-07-13

Ursachen und Lösungen für den Ausfall der Gesichtserkennung: Fehler -215Fehlerbehandlung: Auflösen "Fehler: (-215)! Leere () In Funktion DESTECTMULTICALS" In opencv , wenn Sie versuchen, das Erstellen der ...Programmierung Gepostet am 2025-07-13 -

Warum haben Bilder noch Grenzen in Chrome? `BORE: Keine;` Ungültige LösungEntfernen des Bildrandes in Chrome Ein häufiges Problem, das bei der Arbeit mit Bildern in Chrome und IE9 das Erscheinen eines anhaltenden dün...Programmierung Gepostet am 2025-07-13

Warum haben Bilder noch Grenzen in Chrome? `BORE: Keine;` Ungültige LösungEntfernen des Bildrandes in Chrome Ein häufiges Problem, das bei der Arbeit mit Bildern in Chrome und IE9 das Erscheinen eines anhaltenden dün...Programmierung Gepostet am 2025-07-13 -

Warum erfordern Lambda -Ausdrücke in Java "endgültige" oder "gültige endgültige" Variablen?Lambda Expressions Require "Final" or "Effectively Final" VariablesThe error message "Variable used in lambda expression shou...Programmierung Gepostet am 2025-07-13

Warum erfordern Lambda -Ausdrücke in Java "endgültige" oder "gültige endgültige" Variablen?Lambda Expressions Require "Final" or "Effectively Final" VariablesThe error message "Variable used in lambda expression shou...Programmierung Gepostet am 2025-07-13

Chinesisch lernen

- 1 Wie sagt man „gehen“ auf Chinesisch? 走路 Chinesische Aussprache, 走路 Chinesisch lernen

- 2 Wie sagt man auf Chinesisch „Flugzeug nehmen“? 坐飞机 Chinesische Aussprache, 坐飞机 Chinesisch lernen

- 3 Wie sagt man auf Chinesisch „einen Zug nehmen“? 坐火车 Chinesische Aussprache, 坐火车 Chinesisch lernen

- 4 Wie sagt man auf Chinesisch „Bus nehmen“? 坐车 Chinesische Aussprache, 坐车 Chinesisch lernen

- 5 Wie sagt man „Fahren“ auf Chinesisch? 开车 Chinesische Aussprache, 开车 Chinesisch lernen

- 6 Wie sagt man Schwimmen auf Chinesisch? 游泳 Chinesische Aussprache, 游泳 Chinesisch lernen

- 7 Wie sagt man auf Chinesisch „Fahrrad fahren“? 骑自行车 Chinesische Aussprache, 骑自行车 Chinesisch lernen

- 8 Wie sagt man auf Chinesisch Hallo? 你好Chinesische Aussprache, 你好Chinesisch lernen

- 9 Wie sagt man „Danke“ auf Chinesisch? 谢谢Chinesische Aussprache, 谢谢Chinesisch lernen

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning