الصفحة الأمامية > منظمة العفو الدولية > كيفية استخدام دردشة Nvidia مع RTX AI Chatbot على جهاز الكمبيوتر الخاص بك

الصفحة الأمامية > منظمة العفو الدولية > كيفية استخدام دردشة Nvidia مع RTX AI Chatbot على جهاز الكمبيوتر الخاص بك

كيفية استخدام دردشة Nvidia مع RTX AI Chatbot على جهاز الكمبيوتر الخاص بك

أطلقت Nvidia برنامج Chat with RXT، وهو روبوت دردشة يعمل بالذكاء الاصطناعي يعمل على جهاز الكمبيوتر الخاص بك ويقدم ميزات مشابهة لـ ChatGPT والمزيد! كل ما تحتاجه هو وحدة معالجة الرسومات Nvidia RTX، وستكون جاهزًا لبدء استخدام برنامج الدردشة الآلي الجديد من Nvidia.

ما هي خدمة Nvidia Chat مع RTX؟

Nvidia Chat with RTX هو برنامج AI يتيح لك تشغيل نموذج لغة كبير (LLM) محليًا على جهاز الكمبيوتر الخاص بك. لذا، بدلاً من الاتصال بالإنترنت لاستخدام روبوت الدردشة المدعم بالذكاء الاصطناعي مثل ChatGPT، يمكنك استخدام الدردشة مع RTX دون الاتصال بالإنترنت وقتما تشاء.

تستخدم الدردشة مع RTX TensorRT-LLM، وتسريع RTX، وMistral 7-B LLM الكمي لتوفير أداء سريع واستجابات عالية الجودة على قدم المساواة مع روبوتات الدردشة الأخرى ذات الذكاء الاصطناعي عبر الإنترنت. كما يوفر أيضًا توليد الاسترجاع المعزز (RAG)، مما يسمح لبرنامج الدردشة الآلي بقراءة ملفاتك وتمكين الإجابات المخصصة بناءً على البيانات التي تقدمها. يتيح لك ذلك تخصيص برنامج الدردشة الآلي لتوفير تجربة شخصية أكثر.

إذا كنت تريد تجربة Nvidia Chat مع RTX، فإليك كيفية تنزيله وتثبيته وتكوينه على جهاز الكمبيوتر الخاص بك.

كيفية تنزيل وتثبيت الدردشة باستخدام RTX

جعلت Nvidia تشغيل LLM محليًا على جهاز الكمبيوتر الخاص بك أسهل بكثير. لتشغيل Chat with RTX، ما عليك سوى تنزيل التطبيق وتثبيته، تمامًا كما تفعل مع أي برنامج آخر. ومع ذلك، فإن Chat with RTX لديها بعض متطلبات المواصفات الدنيا للتثبيت والاستخدام بشكل صحيح.

وحدة معالجة الرسومات RTX 30-Series أو 40-Series وذاكرة الوصول العشوائي (RAM) سعة 16 جيجابايت ومساحة ذاكرة خالية تبلغ 100 جيجابايت نظام التشغيل Windows 11إذا تجاوز جهاز الكمبيوتر الخاص بك الحد الأدنى من متطلبات النظام، فيمكنك المضي قدمًا وتثبيت التطبيق.

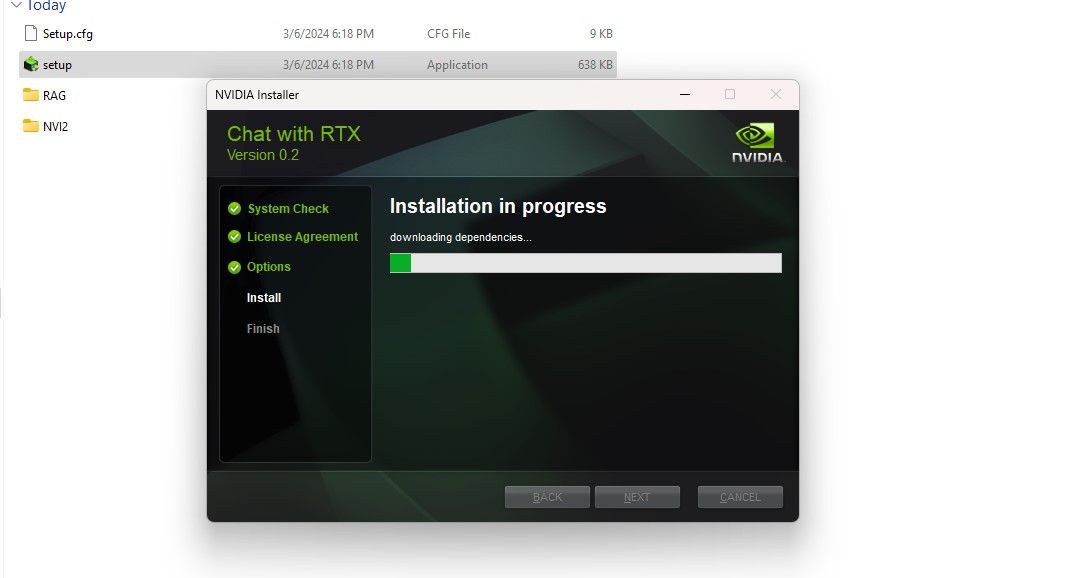

الخطوة 1: قم بتنزيل ملف Chat with RTX ZIP. التنزيل: الدردشة مع RTX (تنزيل مجاني - 35 جيجابايت)الخطوة 2: قم باستخراج ملف ZIP عن طريق النقر بزر الماوس الأيمن واختيار أداة أرشفة الملفات مثل 7Zip أو انقر نقرًا مزدوجًا فوق الملف وتحديد "استخراج الكل". الخطوة 3: افتح المجلد المستخرج وانقر نقرًا مزدوجًا فوق setup.exe. اتبع التعليمات التي تظهر على الشاشة وحدد كافة المربعات أثناء عملية التثبيت المخصصة. بعد الضغط على التالي، سيقوم المثبت بتنزيل وتثبيت LLM وجميع التبعيات.

سيستغرق تثبيت Chat with RTX بعض الوقت للانتهاء حيث يقوم بتنزيل وتثبيت كمية كبيرة من البيانات. بعد عملية التثبيت، اضغط على إغلاق، وبذلك تكون قد انتهيت. والآن حان الوقت لتجربة التطبيق.

كيفية استخدام Nvidia Chat مع RTX

على الرغم من أنه يمكنك استخدام Chat مع RTX مثل chatbot عادي يعمل بالذكاء الاصطناعي عبر الإنترنت، إلا أنني أقترح عليك بشدة التحقق من وظيفة RAG الخاصة به، والتي تمكنك من تخصيص مخرجاته بناءً على على الملفات التي تمنح حق الوصول إليها.

الخطوة 1: إنشاء مجلد RAG

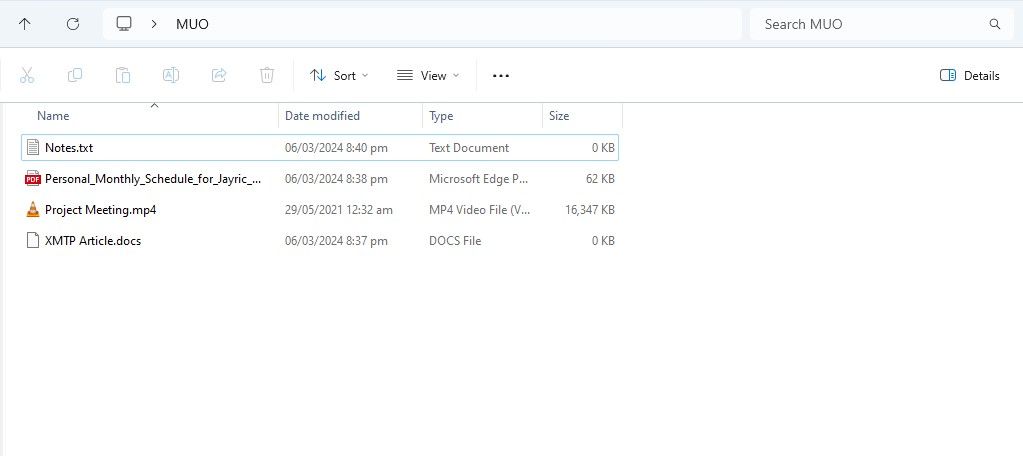

لبدء استخدام RAG في الدردشة مع RTX، قم بإنشاء مجلد جديد لتخزين الملفات التي تريد من الذكاء الاصطناعي تحليلها.

بعد الإنشاء، ضع ملفات البيانات الخاصة بك في المجلد. يمكن أن تغطي البيانات التي تخزنها العديد من المواضيع وأنواع الملفات، مثل المستندات وملفات PDF والنصوص ومقاطع الفيديو. ومع ذلك، قد ترغب في تحديد عدد الملفات التي تضعها في هذا المجلد حتى لا يؤثر على الأداء. المزيد من البيانات للبحث من خلالها يعني أن الدردشة مع RTX ستستغرق وقتًا أطول لإرجاع الردود لاستعلامات محددة (ولكن هذا يعتمد أيضًا على الأجهزة).

الآن أصبحت قاعدة البيانات الخاصة بك جاهزة، يمكنك إعداد الدردشة مع RTX والبدء في استخدامها للإجابة على أسئلتك واستفساراتك.

الخطوة 2: إعداد البيئة

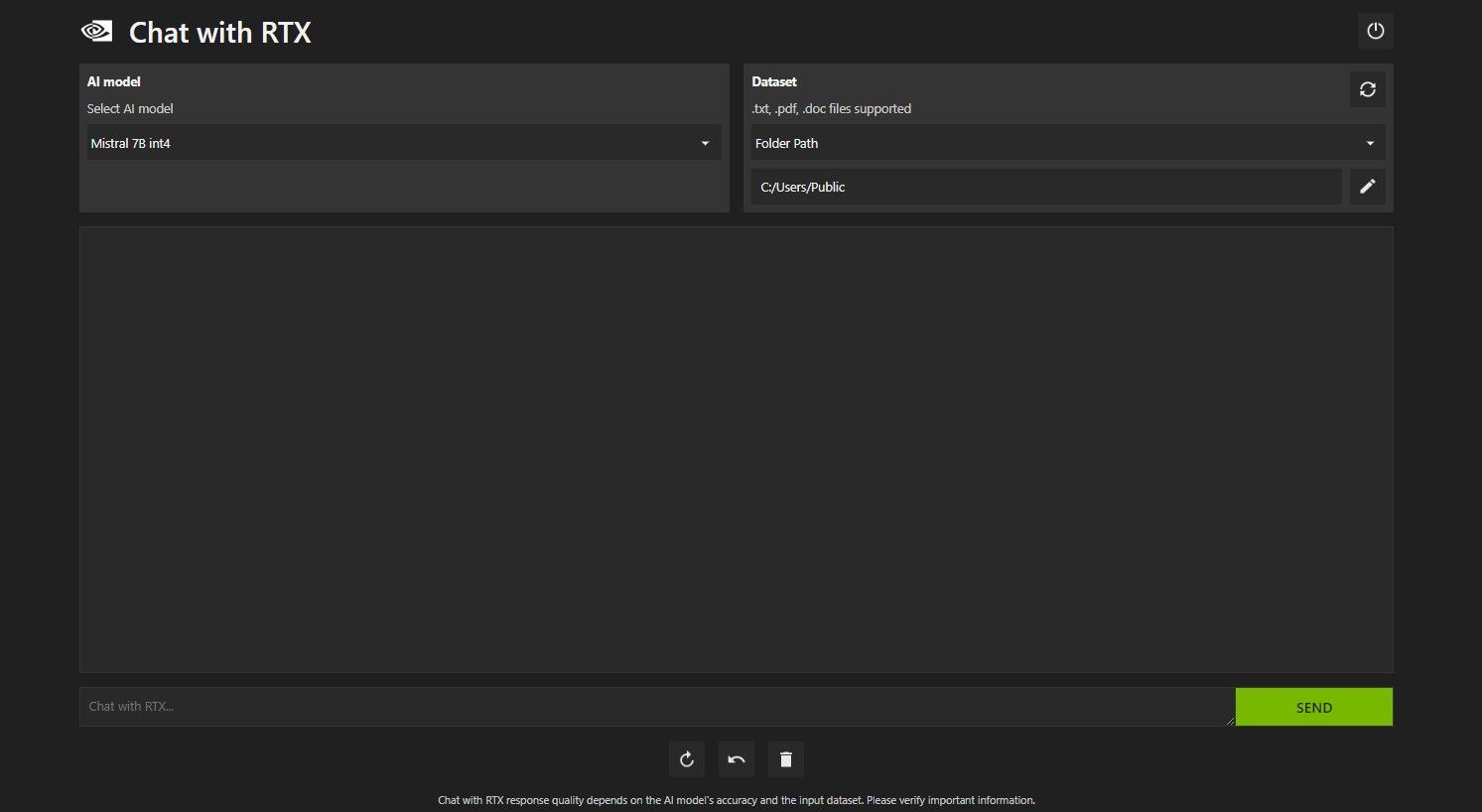

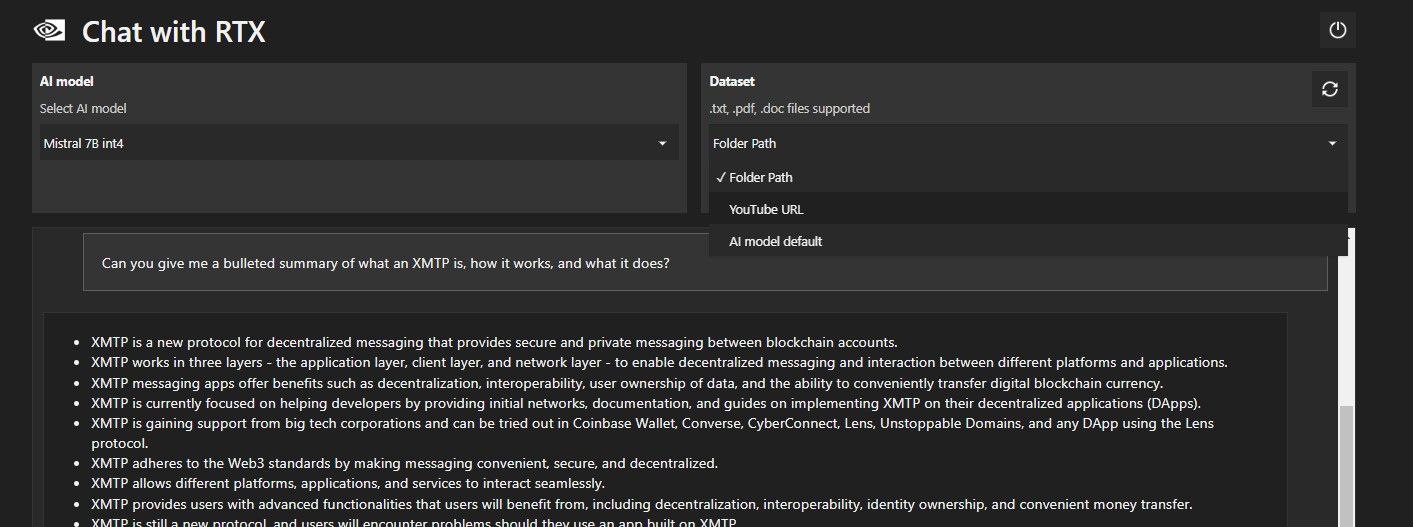

افتح الدردشة مع RTX. يجب أن تبدو مثل الصورة أدناه.

ضمن مجموعة البيانات، تأكد من تحديد خيار مسار المجلد. انقر الآن على أيقونة التحرير أدناه (أيقونة القلم) وحدد المجلد الذي يحتوي على جميع الملفات التي تريد أن تقرأها Chat with RTX. يمكنك أيضًا تغيير نموذج الذكاء الاصطناعي في حالة توفر خيارات أخرى (في وقت كتابة هذا التقرير، يتوفر فقط Mistral 7B).

أنت الآن جاهز لاستخدام الدردشة مع RTX.

الخطوة 3: اطرح أسئلتك عبر الدردشة مع RTX!

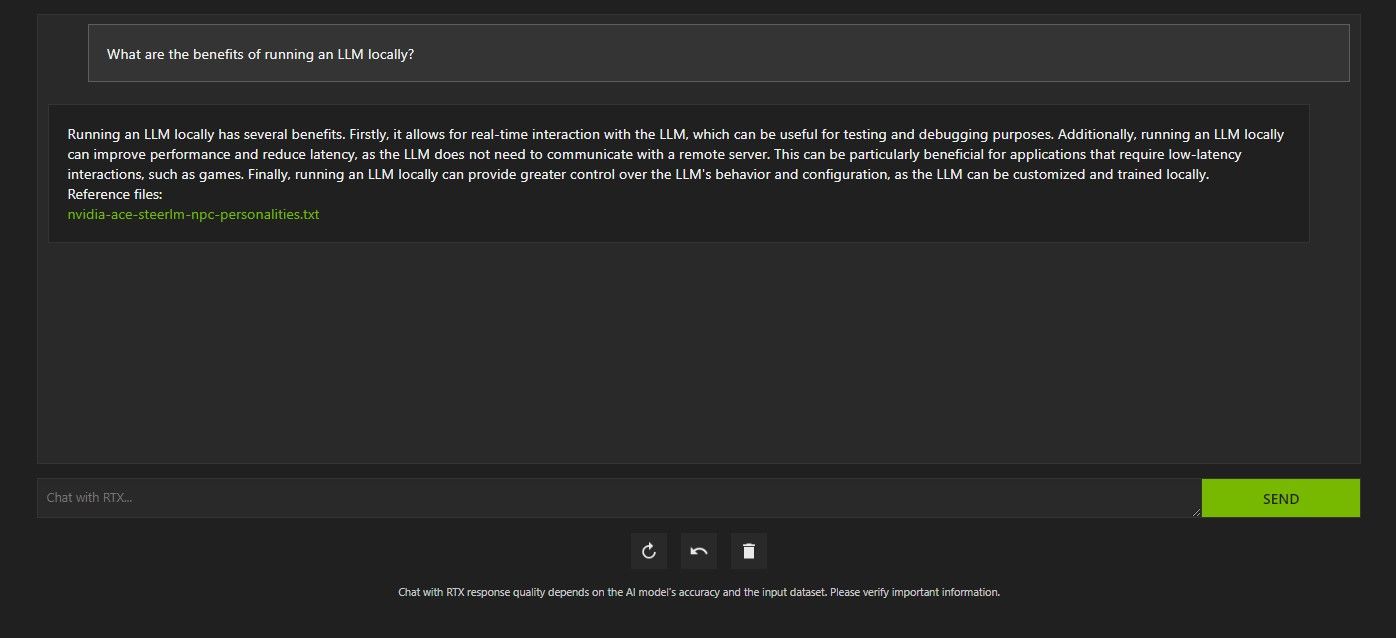

هناك عدة طرق للاستعلام عن الدردشة مع RTX. الأول هو استخدامه مثل برنامج الدردشة الآلي العادي الذي يعمل بالذكاء الاصطناعي. لقد سألت Chat with RTX عن فوائد استخدام LLM محلي وكنت راضيًا عن إجابتها. لم تكن متعمقة للغاية، ولكنها دقيقة بما فيه الكفاية.

ولكن نظرًا لأن Chat with RTX قادر على RAG، فيمكنك أيضًا استخدامه كمساعد AI شخصي.

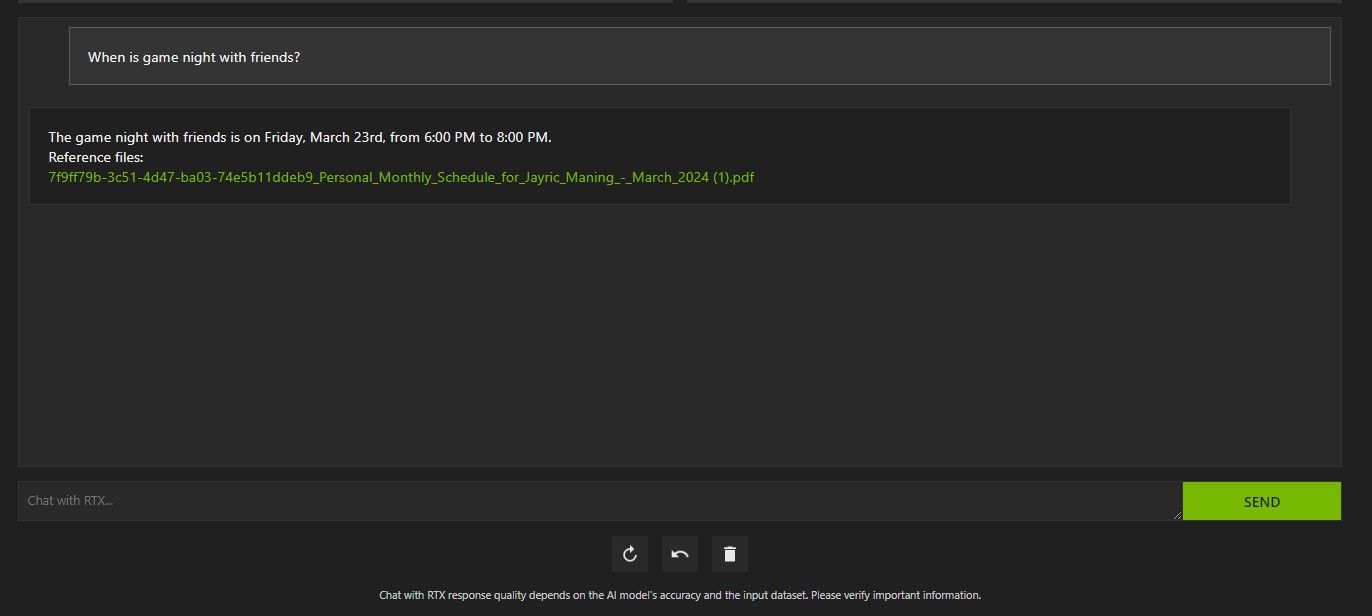

أعلاه، لقد استخدمت الدردشة مع RTX للاستفسار عن جدول أعمالي. جاءت البيانات من ملف PDF يحتوي على الجدول الزمني والتقويم والأحداث والعمل وما إلى ذلك. في هذه الحالة، قامت Chat with RTX بسحب بيانات التقويم الصحيحة من البيانات؛ سيتعين عليك الاحتفاظ بملفات البيانات وتواريخ التقويم الخاصة بك محدثة حتى تعمل ميزات مثل هذه بشكل صحيح حتى يتم التكامل مع التطبيقات الأخرى.

هناك العديد من الطرق التي يمكنك من خلالها استخدام الدردشة مع RTX's RAG لصالحك. على سبيل المثال، يمكنك استخدامه لقراءة الأوراق القانونية وتقديم ملخص، وإنشاء تعليمات برمجية ذات صلة بالبرنامج الذي تقوم بتطويره، والحصول على نقاط بارزة حول مقطع فيديو كنت مشغولاً جدًا بمشاهدته، وغير ذلك الكثير!

الخطوة 4: ميزة المكافأة

بالإضافة إلى مجلد البيانات المحلية، يمكنك استخدام الدردشة مع RTX لتحليل مقاطع فيديو YouTube. للقيام بذلك، ضمن مجموعة البيانات، قم بتغيير مسار المجلد إلى عنوان URL الخاص بموقع YouTube.

انسخ عنوان URL على YouTube الذي تريد تحليله والصقه أسفل القائمة المنسدلة. ثم اسأل بعيدا!

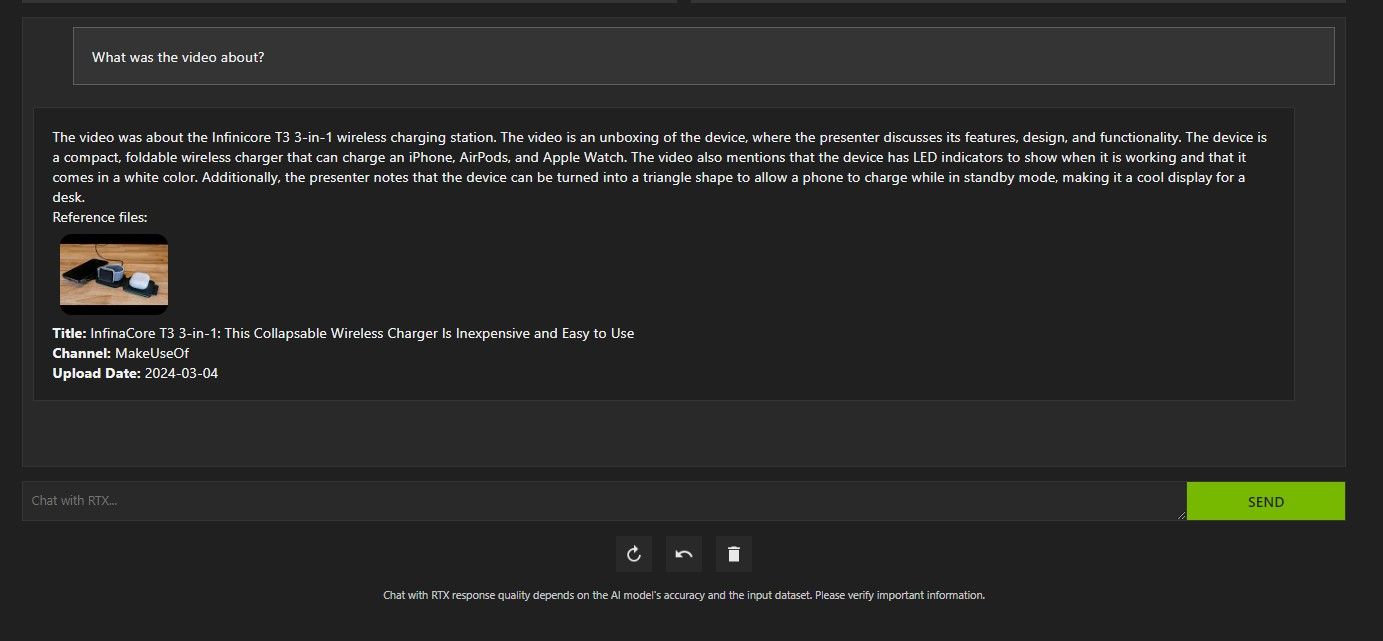

كانت الدردشة مع تحليل فيديو YouTube الخاص بـ RTX جيدة جدًا وقدمت معلومات دقيقة، لذلك يمكن أن تكون مفيدة للبحث والتحليل السريع والمزيد.

هل محادثة Nvidia مع RTX جيدة؟

يوفر ChatGPT وظيفة RAG. تتمتع بعض روبوتات الدردشة المحلية المدعمة بالذكاء الاصطناعي بمتطلبات نظام أقل بكثير. إذًا، هل تستحق Nvidia Chat with RTX استخدامها؟

الجواب نعم! الدردشة مع RTX تستحق الاستخدام على الرغم من المنافسة.

إحدى أكبر نقاط البيع لاستخدام Nvidia Chat مع RTX هي قدرتها على استخدام RAG دون إرسال ملفاتك إلى خادم طرف ثالث. يمكن أن يؤدي تخصيص GPTs من خلال الخدمات عبر الإنترنت إلى كشف بياناتك. ولكن نظرًا لأن الدردشة مع RTX تعمل محليًا وبدون اتصال بالإنترنت، فإن استخدام RAG على Chat with RTX يضمن أن بياناتك الحساسة آمنة ولا يمكن الوصول إليها إلا على جهاز الكمبيوتر الخاص بك.

أما بالنسبة لروبوتات الدردشة الأخرى التي تعمل بالذكاء الاصطناعي والتي تعمل محليًا والتي تعمل بنظام Mistral 7B، فإن أداء الدردشة مع RTX أفضل وأسرع. على الرغم من أن جزءًا كبيرًا من تعزيز الأداء يأتي من استخدام وحدات معالجة الرسومات المتطورة، فإن استخدام Nvidia TensorRT-LLM وتسارع RTX جعل تشغيل Mistral 7B أسرع على Chat with RTX مقارنة بالطرق الأخرى لتشغيل LLM محسّنة للدردشة.

تجدر الإشارة إلى أن إصدار Chat with RTX الذي نستخدمه حاليًا هو إصدار تجريبي. من المرجح أن تصبح الإصدارات اللاحقة من Chat with RTX أكثر تحسينًا وستوفر تعزيزات في الأداء.

ماذا لو لم يكن لدي وحدة معالجة رسومات RTX 30 أو 40 Series؟

تعد الدردشة مع RTX طريقة سهلة وسريعة وآمنة لتشغيل LLM محليًا دون الحاجة إلى اتصال بالإنترنت. إذا كنت مهتمًا أيضًا بتشغيل LLM أو محليًا ولكن ليس لديك وحدة معالجة الرسومات RTX 30 أو 40 Series، فيمكنك تجربة طرق أخرى لتشغيل LLM محليًا. اثنان من أكثرها شيوعًا هما GPT4ALL وText Gen WebUI. جرب GPT4ALL إذا كنت تريد تجربة التوصيل والتشغيل محليًا باستخدام LLM. ولكن إذا كنت تميل إلى التقنية أكثر قليلاً، فإن تشغيل LLMs من خلال Text Gen WebUI سيوفر لك ضبطًا ومرونة أفضل.

-

خوارزميات ذكاء سرب: ثلاثة تطبيقات بيثونImagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...منظمة العفو الدولية نشر في 2025-03-24

خوارزميات ذكاء سرب: ثلاثة تطبيقات بيثونImagine watching a flock of birds in flight. There's no leader, no one giving directions, yet they swoop and glide together in perfect harmony. It may...منظمة العفو الدولية نشر في 2025-03-24 -

كيف تجعل LLM أكثر دقة مع RAG & TUNINGImagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...منظمة العفو الدولية نشر في 2025-03-24

كيف تجعل LLM أكثر دقة مع RAG & TUNINGImagine studying a module at university for a semester. At the end, after an intensive learning phase, you take an exam – and you can recall th...منظمة العفو الدولية نشر في 2025-03-24 -

ما هو Google Gemini؟ كل ما تحتاج لمعرفته حول منافس جوجل chatgptGoogle recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...منظمة العفو الدولية نشر في 2025-03-23

ما هو Google Gemini؟ كل ما تحتاج لمعرفته حول منافس جوجل chatgptGoogle recently released its new Generative AI model, Gemini. It results from a collaborative effort by a range of teams at Google, including members ...منظمة العفو الدولية نشر في 2025-03-23 -

دليل على المطالبة مع DSPYdspy: إطار إعلاني لبناء تطبيقات LLM وتحسينها DSPY (برامج اللغة التعريفية ذاتية التحسين) تحدث ثورة في تطوير تطبيق LLM من خلال استخلاص تعقيدات الهندس...منظمة العفو الدولية نشر في 2025-03-22

دليل على المطالبة مع DSPYdspy: إطار إعلاني لبناء تطبيقات LLM وتحسينها DSPY (برامج اللغة التعريفية ذاتية التحسين) تحدث ثورة في تطوير تطبيق LLM من خلال استخلاص تعقيدات الهندس...منظمة العفو الدولية نشر في 2025-03-22 -

أتمتة المدونة إلى موضوع Twitterتفاصيل هذه المقالة أتمتة تحويل محتوى النمط الطويل (مثل منشورات المدونة) إلى مؤشرات ترابط Twitter باستخدام Google Gemini-2.0 LLM و Chromadb و SPEREMLI...منظمة العفو الدولية نشر في 2025-03-11

أتمتة المدونة إلى موضوع Twitterتفاصيل هذه المقالة أتمتة تحويل محتوى النمط الطويل (مثل منشورات المدونة) إلى مؤشرات ترابط Twitter باستخدام Google Gemini-2.0 LLM و Chromadb و SPEREMLI...منظمة العفو الدولية نشر في 2025-03-11 -

الجهاز المناعي الاصطناعي (AIS): دليل مع أمثلة Pythonتستكشف هذه المقالة أنظمة المناعة الاصطناعية (AIS) ، والنماذج الحسابية مستوحاة من قدرة الجهاز المناعي البشري الرائع على تحديد التهديدات وتحييدها. سوف...منظمة العفو الدولية نشر في 2025-03-04

الجهاز المناعي الاصطناعي (AIS): دليل مع أمثلة Pythonتستكشف هذه المقالة أنظمة المناعة الاصطناعية (AIS) ، والنماذج الحسابية مستوحاة من قدرة الجهاز المناعي البشري الرائع على تحديد التهديدات وتحييدها. سوف...منظمة العفو الدولية نشر في 2025-03-04 -

حاول طرح هذه الأسئلة الممتعة عن نفسك على ChatGPTهل تساءلت يومًا عما يعرفه ChatGPT عنك؟ كيف يعالج المعلومات التي زودتها بها مع مرور الوقت؟ لقد استخدمت أكوام ChatGPT في سيناريوهات مختلفة، ومن المثير ل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-22

حاول طرح هذه الأسئلة الممتعة عن نفسك على ChatGPTهل تساءلت يومًا عما يعرفه ChatGPT عنك؟ كيف يعالج المعلومات التي زودتها بها مع مرور الوقت؟ لقد استخدمت أكوام ChatGPT في سيناريوهات مختلفة، ومن المثير ل...منظمة العفو الدولية تم النشر بتاريخ 2024-11-22 -

إليك كيف لا يزال بإمكانك تجربة برنامج Chatbot الغامض GPT-2إذا كنت مهتمًا بنماذج الذكاء الاصطناعي أو روبوتات الدردشة، فربما تكون قد شاهدت مناقشات حول روبوت الدردشة الغامض GPT-2 وفعاليته.هنا، نوضح ما هو روبوت ا...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

إليك كيف لا يزال بإمكانك تجربة برنامج Chatbot الغامض GPT-2إذا كنت مهتمًا بنماذج الذكاء الاصطناعي أو روبوتات الدردشة، فربما تكون قد شاهدت مناقشات حول روبوت الدردشة الغامض GPT-2 وفعاليته.هنا، نوضح ما هو روبوت ا...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

يعد وضع Canvas في ChatGPT رائعًا: إليك 4 طرق لاستخدامهأضاف وضع Canvas الجديد في ChatGPT بُعدًا إضافيًا للكتابة والتحرير في أداة الذكاء الاصطناعي الرائدة في العالم. أنا أستخدم ChatGPT Canvas منذ إطلاقه، و...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

يعد وضع Canvas في ChatGPT رائعًا: إليك 4 طرق لاستخدامهأضاف وضع Canvas الجديد في ChatGPT بُعدًا إضافيًا للكتابة والتحرير في أداة الذكاء الاصطناعي الرائدة في العالم. أنا أستخدم ChatGPT Canvas منذ إطلاقه، و...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

كيف يمكن لـ GPTs المخصصة في ChatGPT الكشف عن بياناتك وكيفية الحفاظ عليها آمنةتتيح ميزة GPT المخصصة في ChatGPT لأي شخص إنشاء أداة ذكاء اصطناعي مخصصة لأي شيء يخطر ببالك تقريبًا؛ يمكن لـ GPTs الإبداعية والتقنية والألعاب والمخصصة ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

كيف يمكن لـ GPTs المخصصة في ChatGPT الكشف عن بياناتك وكيفية الحفاظ عليها آمنةتتيح ميزة GPT المخصصة في ChatGPT لأي شخص إنشاء أداة ذكاء اصطناعي مخصصة لأي شيء يخطر ببالك تقريبًا؛ يمكن لـ GPTs الإبداعية والتقنية والألعاب والمخصصة ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

10 طرق يمكن أن تساعدك بها ChatGPT في الحصول على وظيفة على LinkedInمع وجود 2600 شخصية متاحة، يعد قسم "حول" في ملفك الشخصي على LinkedIn مساحة رائعة لتوضيح خلفيتك ومهاراتك وشغفك وأهدافك المستقبلية. اعرض سيرتك...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

10 طرق يمكن أن تساعدك بها ChatGPT في الحصول على وظيفة على LinkedInمع وجود 2600 شخصية متاحة، يعد قسم "حول" في ملفك الشخصي على LinkedIn مساحة رائعة لتوضيح خلفيتك ومهاراتك وشغفك وأهدافك المستقبلية. اعرض سيرتك...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

تحقق من تطبيقات الذكاء الاصطناعي الستة الأقل شهرة والتي توفر تجارب فريدة من نوعهافي هذه المرحلة، سمع معظم الناس عن ChatGPT وCopilot، وهما تطبيقان رائدان في مجال الذكاء الاصطناعي قادا ازدهار الذكاء الاصطناعي. ولكن هل تعلم أن عددًا ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

تحقق من تطبيقات الذكاء الاصطناعي الستة الأقل شهرة والتي توفر تجارب فريدة من نوعهافي هذه المرحلة، سمع معظم الناس عن ChatGPT وCopilot، وهما تطبيقان رائدان في مجال الذكاء الاصطناعي قادا ازدهار الذكاء الاصطناعي. ولكن هل تعلم أن عددًا ...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

تظهر هذه العلامات السبع أننا وصلنا بالفعل إلى ذروة الذكاء الاصطناعيأينما نظرت عبر الإنترنت، ستجد مواقع وخدمات وتطبيقات تعلن أن استخدامها للذكاء الاصطناعي يجعله الخيار الأفضل. لا أعرف عنك، لكن وجوده المستمر أصبح متعبً...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

تظهر هذه العلامات السبع أننا وصلنا بالفعل إلى ذروة الذكاء الاصطناعيأينما نظرت عبر الإنترنت، ستجد مواقع وخدمات وتطبيقات تعلن أن استخدامها للذكاء الاصطناعي يجعله الخيار الأفضل. لا أعرف عنك، لكن وجوده المستمر أصبح متعبً...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

4 أدوات لفحص ChatGPT باستخدام الذكاء الاصطناعي للمعلمين والمحاضرين والرؤساءمع تقدم ChatGPT في السلطة، أصبح من الصعب معرفة ما يكتبه الإنسان وما ينتجه الذكاء الاصطناعي. وهذا يجعل من الصعب على المعلمين والرؤساء التعرف على ما كت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

4 أدوات لفحص ChatGPT باستخدام الذكاء الاصطناعي للمعلمين والمحاضرين والرؤساءمع تقدم ChatGPT في السلطة، أصبح من الصعب معرفة ما يكتبه الإنسان وما ينتجه الذكاء الاصطناعي. وهذا يجعل من الصعب على المعلمين والرؤساء التعرف على ما كت...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08 -

يتم طرح ميزة الصوت المتقدمة في ChatGPT لمزيد من المستخدمينإذا كنت ترغب في إجراء محادثة كاملة مع ChatGPT، الآن يمكنك ذلك. أي طالما أنك تدفع مقابل امتياز استخدام ChatGPT. أصبح بإمكان المزيد من المستخدمين ال...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

يتم طرح ميزة الصوت المتقدمة في ChatGPT لمزيد من المستخدمينإذا كنت ترغب في إجراء محادثة كاملة مع ChatGPT، الآن يمكنك ذلك. أي طالما أنك تدفع مقابل امتياز استخدام ChatGPT. أصبح بإمكان المزيد من المستخدمين ال...منظمة العفو الدولية تم النشر بتاريخ 2024-11-08

دراسة اللغة الصينية

- 1 كيف تقول "المشي" باللغة الصينية؟ 走路 نطق الصينية، 走路 تعلم اللغة الصينية

- 2 كيف تقول "استقل طائرة" بالصينية؟ 坐飞机 نطق الصينية، 坐飞机 تعلم اللغة الصينية

- 3 كيف تقول "استقل القطار" بالصينية؟ 坐火车 نطق الصينية، 坐火车 تعلم اللغة الصينية

- 4 كيف تقول "استقل الحافلة" باللغة الصينية؟ 坐车 نطق الصينية، 坐车 تعلم اللغة الصينية

- 5 كيف أقول القيادة باللغة الصينية؟ 开车 نطق الصينية، 开车 تعلم اللغة الصينية

- 6 كيف تقول السباحة باللغة الصينية؟ 游泳 نطق الصينية، 游泳 تعلم اللغة الصينية

- 7 كيف يمكنك أن تقول ركوب الدراجة باللغة الصينية؟ 骑自行车 نطق الصينية، 骑自行车 تعلم اللغة الصينية

- 8 كيف تقول مرحبا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 9 كيف تقول شكرا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning