بناء سحابة أولاما - توسيع نطاق الاستدلال المحلي على السحابة

Ollama هو في الأساس عبارة عن غلاف حول llama.cpp، مصمم لمهام الاستدلال المحلية. إنه ليس خيارك الأول عادةً إذا كنت تبحث عن أداء أو ميزات متطورة، ولكن له استخداماته، خاصة في البيئات التي تشكل فيها التبعيات الخارجية مصدر قلق.

تطوير الذكاء الاصطناعي المحلي

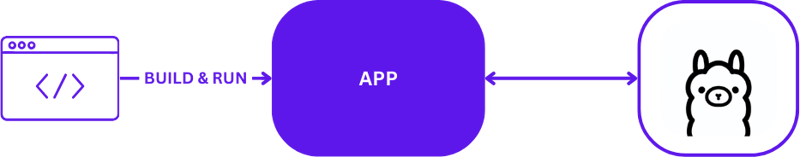

عند استخدام Ollama لتطوير الذكاء الاصطناعي المحلي، يكون الإعداد واضحًا ولكنه فعال. عادةً ما يستفيد المطورون من Ollama لتشغيل مهام الاستدلال مباشرةً على أجهزتهم المحلية. فيما يلي تصوير مرئي لإعداد تطوير محلي نموذجي باستخدام Ollama:

يسمح هذا التكوين للمطورين بالاختبار والتكرار بسرعة دون تعقيدات اتصالات الخادم البعيد. إنها مثالية للنماذج الأولية ومراحل التطوير حيث يكون التحول السريع أمرًا بالغ الأهمية.

من المحلية إلى السحابية

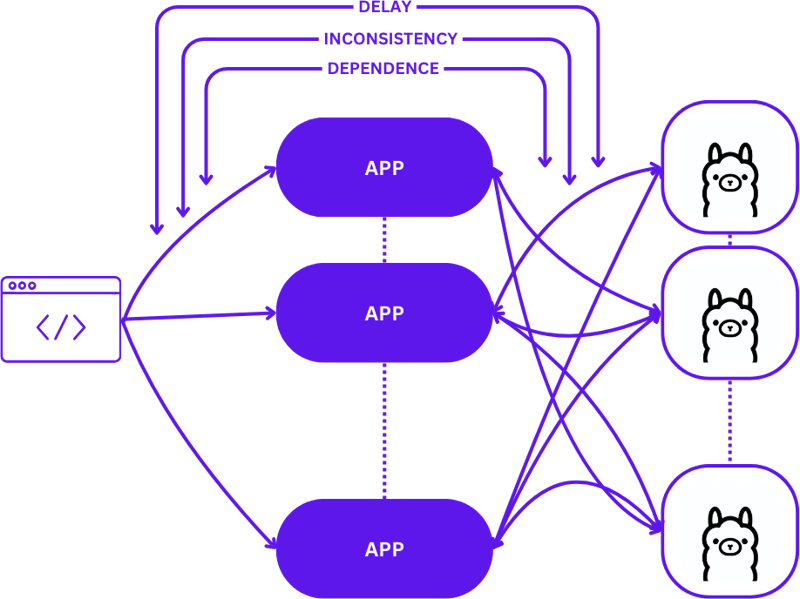

يتضمن الانتقال من الإعداد المحلي إلى بيئة سحابية قابلة للتطوير التطور من إعداد بسيط 1:1 (طلب مستخدم واحد إلى مضيف استدلال واحد) إلى تكوين أكثر تعقيدًا من متعدد إلى متعدد (طلبات مستخدمين متعددة إلى مضيفي استدلال متعددين) . يعد هذا التحول ضروريًا للحفاظ على الكفاءة والاستجابة مع زيادة الطلب.

إليك كيف يبدو هذا التوسع عند الانتقال من التطوير المحلي إلى الإنتاج:

يمكن أن يؤدي اعتماد نهج مباشر خلال هذا التحول إلى زيادة تعقيد التطبيقات بشكل كبير، خاصة وأن الجلسات تحتاج إلى الحفاظ على الاتساق عبر الحالات المختلفة. قد تنشأ تأخيرات وأوجه قصور في الكفاءة إذا لم يتم توجيه الطلبات على النحو الأمثل إلى أفضل مضيف استدلال متاح.

علاوة على ذلك، فإن الطبيعة المعقدة للتطبيقات الموزعة تجعل من الصعب اختبارها محليًا، مما قد يؤدي إلى إبطاء عملية التطوير وزيادة خطر الفشل في بيئات الإنتاج.

بدون خادم

تلخص الحوسبة بدون خادم إدارة الخادم وتفاصيل البنية التحتية، مما يسمح للمطورين بالتركيز فقط على التعليمات البرمجية ومنطق الأعمال. ومن خلال فصل معالجة الطلبات وصيانة الاتساق عن التطبيق، تعمل البنية بدون خادم على تبسيط عملية التوسع.

يسمح هذا النهج للتطبيق بمواصلة التركيز على تقديم القيمة، وحل العديد من تحديات التوسع الشائعة دون إثقال كاهل المطورين بتعقيدات البنية التحتية.

WebAssembly

يعالج WebAssembly (Wasm) التحدي المتمثل في إدارة التبعية من خلال تمكين تجميع التطبيقات في وحدات قائمة بذاتها. وهذا يجعل من السهل تنسيق التطبيقات واختبارها محليًا وفي السحابة، مما يضمن الاتساق عبر البيئات المختلفة.

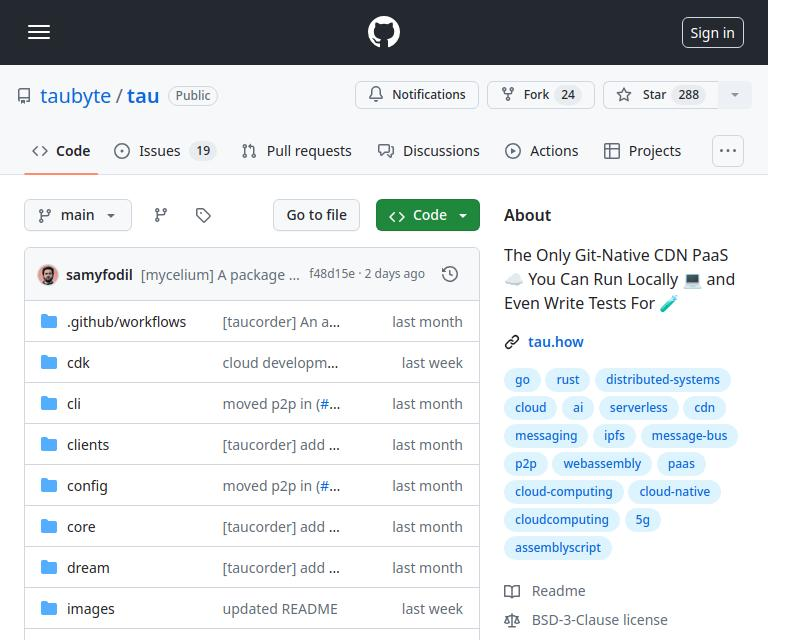

تاو

Tau هو إطار عمل لبناء منصات حوسبة سحابية منخفضة الصيانة وقابلة للتطوير بشكل كبير. إنها تتفوق في البساطة وقابلية التوسع. يجعل Tau النشر سهلاً ويدعم تشغيل سحابة محلية للتطوير، مما يسمح بإجراء اختبار شامل (E2E) لكل من البنية التحتية السحابية والتطبيقات التي تعمل عليها.

هذا النهج، الذي أشار إليه توبايت باسم "الترميز المحلي يساوي الإنتاج العالمي"، يضمن أن ما ينجح محليًا سيعمل عالميًا، مما يسهل بشكل كبير عمليات التطوير والنشر.

دمج Ollama في Tau مع نظام Orbit Plugin

يعمل نظام المكونات الإضافية الخاص بـ Tau، والمعروف باسم Orbit، على تبسيط عملية تحويل الخدمات إلى مكونات يمكن التحكم فيها بشكل كبير عن طريق تجميعها في وحدات مضيف WebAssembly. يسمح هذا الأسلوب لـ Tau بتولي مهام التنسيق، وتبسيط عملية النشر والإدارة.

تصدير الوظائف في أولاما

لإتاحة الوصول إلى وظائف Ollama ضمن نظام Tau البيئي، نستخدم نظام Orbit لتصدير قدرات Ollama كنقاط نهاية قابلة للاستدعاء. إليك كيفية تصدير نقطة النهاية في Go:

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

للحصول على مثال مباشر لتصدير الوظائف، يمكنك الرجوع إلى مثال hello_world.

بمجرد تحديد هذه الوظائف، يتم استدعاؤها الآن عبر القمر الصناعي. التصدير، يتيح التكامل السلس لـ Ollama في بيئة Tau:

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

اختبارات الكتابة للبرنامج المساعد أولاما

تم اختبار البرنامج المساعد بطريقة مبسطة ومباشرة. إليك كيفية كتابة اختبار دالة بدون خادم في Go:

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

باستخدام مجموعة اختبار Tau وأدوات Go builder، يمكنك إنشاء المكون الإضافي الخاص بك ونشره في بيئة اختبار وتنفيذ الوظائف بدون خادم للتحقق من الوظيفة:

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

شفرة

يمكنك العثور على الكود الكامل هنا https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/tau

ماذا بعد؟

يمكنك الآن إنشاء تطبيقات LLM بسهولة. فيما يلي الخطوات للبدء:

- ابدأ محليًا باستخدام الحلم: قم بإعداد بيئتك المحلية لتطوير تطبيقك واختباره.

- إنشاء مشروع: ابدأ مشروعًا جديدًا مع Tau لتسخير إمكاناته الكاملة.

- إنشاء سحابة الإنتاج الخاصة بك: انشر مشروعك في بيئة سحابية للإنتاج.

- أسقط البرنامج المساعد الثنائي في المجلد /tb/plugins.

- استيراد مشروعك إلى مرحلة الإنتاج

- تباهى!

-

كيف تسترجع أحدث مكتبة jQuery من Google APIs؟لاسترداد أحدث إصدار ، كان هناك سابقًا بديلًا لاستخدام رقم إصدار معين ، والذي كان لاستخدام بناء الجملة التالي: /latest/jquery.js Budap &&/////////...برمجة نشرت في 2025-01-31

كيف تسترجع أحدث مكتبة jQuery من Google APIs؟لاسترداد أحدث إصدار ، كان هناك سابقًا بديلًا لاستخدام رقم إصدار معين ، والذي كان لاستخدام بناء الجملة التالي: /latest/jquery.js Budap &&/////////...برمجة نشرت في 2025-01-31 -

كيف يمكنني اتحاد جداول قاعدة البيانات مع أرقام مختلفة من الأعمدة؟جداول ذات أعداد مختلفة من الأعمدة المدمجة عند تجربة جدول قاعدة البيانات بأعداد مختلفة من عمليات الدمج ، يمكن مواجهة التحديات. طريقة مباشرة في ال...برمجة نشرت في 2025-01-31

كيف يمكنني اتحاد جداول قاعدة البيانات مع أرقام مختلفة من الأعمدة؟جداول ذات أعداد مختلفة من الأعمدة المدمجة عند تجربة جدول قاعدة البيانات بأعداد مختلفة من عمليات الدمج ، يمكن مواجهة التحديات. طريقة مباشرة في ال...برمجة نشرت في 2025-01-31 -

ما هي الطريقة الأكثر كفاءة للكشف عن نقطة في polygon: تتبع الأشعة أو matplotlib \'s path.contains_points؟الكشف الفعال في polegon في python تحديد ما إذا كانت النقطة تكمن في مضلع هي مهمة متكررة في الهندسة الحسابية. يعد إيجاد طريقة فعالة لهذه المهمة مف...برمجة نشرت في 2025-01-31

ما هي الطريقة الأكثر كفاءة للكشف عن نقطة في polygon: تتبع الأشعة أو matplotlib \'s path.contains_points؟الكشف الفعال في polegon في python تحديد ما إذا كانت النقطة تكمن في مضلع هي مهمة متكررة في الهندسة الحسابية. يعد إيجاد طريقة فعالة لهذه المهمة مف...برمجة نشرت في 2025-01-31 -

كيفية الحد من نطاق التمرير لعنصر داخل عنصر الوالد الحجم ديناميكي؟إمكانية الوصول. يتضمن أحد هذه السيناريو الحد من نطاق التمرير لعنصر داخل عنصر الوالدين ديناميكيًا. المشكلة: التمرير الرأسي للمستخدم ، مع الحفاظ...برمجة نشرت في 2025-01-31

كيفية الحد من نطاق التمرير لعنصر داخل عنصر الوالد الحجم ديناميكي؟إمكانية الوصول. يتضمن أحد هذه السيناريو الحد من نطاق التمرير لعنصر داخل عنصر الوالدين ديناميكيًا. المشكلة: التمرير الرأسي للمستخدم ، مع الحفاظ...برمجة نشرت في 2025-01-31 -

كيفية فرز البيانات حسب طول السلسلة في MySQL باستخدام char_length ()؟باستخدام دالة char_length () المدمجة. إرجاع عدد الأحرف في سلسلة ، مع الأخذ في الاعتبار ترميز الأحرف متعددة البايت (على سبيل المثال ، UTF-8). قد...برمجة نشرت في 2025-01-31

كيفية فرز البيانات حسب طول السلسلة في MySQL باستخدام char_length ()؟باستخدام دالة char_length () المدمجة. إرجاع عدد الأحرف في سلسلة ، مع الأخذ في الاعتبار ترميز الأحرف متعددة البايت (على سبيل المثال ، UTF-8). قد...برمجة نشرت في 2025-01-31 -

كائن مناسب: فشل الغطاء في IE و Edge ، كيفية إصلاح؟في CSS للحفاظ على ارتفاع الصور المتسق يعمل بسلاسة عبر المتصفحات. ومع ذلك ، في IE و Edge ، تنشأ قضية غريبة. عند تحجيم المتصفح ، تتغير الصورة في العر...برمجة نشرت في 2025-01-31

كائن مناسب: فشل الغطاء في IE و Edge ، كيفية إصلاح؟في CSS للحفاظ على ارتفاع الصور المتسق يعمل بسلاسة عبر المتصفحات. ومع ذلك ، في IE و Edge ، تنشأ قضية غريبة. عند تحجيم المتصفح ، تتغير الصورة في العر...برمجة نشرت في 2025-01-31 -

كيفية إدراج النقط (الصور) بشكل صحيح في MySQL باستخدام PHP؟مشكلة. سيوفر هذا الدليل حلولًا لتخزين بيانات الصور الخاصة بك بنجاح. إصدار ImageId ، صورة) القيم ('$ this- & gt ؛ image_id' ، 'fi...برمجة نشرت في 2025-01-31

كيفية إدراج النقط (الصور) بشكل صحيح في MySQL باستخدام PHP؟مشكلة. سيوفر هذا الدليل حلولًا لتخزين بيانات الصور الخاصة بك بنجاح. إصدار ImageId ، صورة) القيم ('$ this- & gt ؛ image_id' ، 'fi...برمجة نشرت في 2025-01-31 -

\ "بينما (1) مقابل (؛؛): هل يزيل التحسين المترجم اختلافات الأداء؟ \"بينما (1) مقابل (؛؛): هل هناك فرق السرعة؟ هل استخدام بينما (1) بدلاً من (؛؛) يؤدي إلى اختلاف الأداء في حلقات اللانهائي؟ الإجابة: المجمعون ال...برمجة نشرت في 2025-01-31

\ "بينما (1) مقابل (؛؛): هل يزيل التحسين المترجم اختلافات الأداء؟ \"بينما (1) مقابل (؛؛): هل هناك فرق السرعة؟ هل استخدام بينما (1) بدلاً من (؛؛) يؤدي إلى اختلاف الأداء في حلقات اللانهائي؟ الإجابة: المجمعون ال...برمجة نشرت في 2025-01-31 -

كيفية إزالة معالجات أحداث JavaScript المجهولة بشكل نظيف؟نفسه. / هل تعمل هنا /} ، خطأ) ؛ لا توجد طريقة لإزالة معالج أحداث مجهول بشكل نظيف ما لم يتم تخزين إشارة إلى المعالج في الإنشاء. . هذا يسمح بسهولة...برمجة نشرت في 2025-01-31

كيفية إزالة معالجات أحداث JavaScript المجهولة بشكل نظيف؟نفسه. / هل تعمل هنا /} ، خطأ) ؛ لا توجد طريقة لإزالة معالج أحداث مجهول بشكل نظيف ما لم يتم تخزين إشارة إلى المعالج في الإنشاء. . هذا يسمح بسهولة...برمجة نشرت في 2025-01-31 -

كيفية التغلب على قيود وظائف PHP \؟التغلب على قيود دالة PHP إن محاولة القيام بذلك ، كما هو موضح في مقتطف الكود المقدم ، ستؤدي إلى خطأ "لا يمكن إعادة إعادة". } . ] وم...برمجة نشرت في 2025-01-31

كيفية التغلب على قيود وظائف PHP \؟التغلب على قيود دالة PHP إن محاولة القيام بذلك ، كما هو موضح في مقتطف الكود المقدم ، ستؤدي إلى خطأ "لا يمكن إعادة إعادة". } . ] وم...برمجة نشرت في 2025-01-31 -

كيف يمكنك استخدام مجموعة من خلال محور البيانات في MySQL؟. هنا ، نتعامل مع تحد مشترك: تحويل البيانات من الصف إلى الصف إلى الأعمدة باستخدام المجموعة بواسطة. استعلام بواسطة شرط جنبا إلى جنب مع وظائف ا...برمجة نشرت في 2025-01-31

كيف يمكنك استخدام مجموعة من خلال محور البيانات في MySQL؟. هنا ، نتعامل مع تحد مشترك: تحويل البيانات من الصف إلى الصف إلى الأعمدة باستخدام المجموعة بواسطة. استعلام بواسطة شرط جنبا إلى جنب مع وظائف ا...برمجة نشرت في 2025-01-31 -

كيفية حل تباينات مسار الوحدة في GO Mod باستخدام توجيه استبدال؟مع عدم تطابق المسار بين go.mod الممتدة ومسار الاستيراد الفعلي. يمكن أن يؤدي ذلك إلى فشل Mod Mod Tidy ، كما يتضح من الرسائل المرددة: `replace githu...برمجة نشرت في 2025-01-31

كيفية حل تباينات مسار الوحدة في GO Mod باستخدام توجيه استبدال؟مع عدم تطابق المسار بين go.mod الممتدة ومسار الاستيراد الفعلي. يمكن أن يؤدي ذلك إلى فشل Mod Mod Tidy ، كما يتضح من الرسائل المرددة: `replace githu...برمجة نشرت في 2025-01-31 -

كيفية استرداد الصف الأخير بكفاءة لكل معرف فريد في postgresql؟postgresql: استخراج الصف الأخير لكل معرف فريد الصف الأخير المرتبط بكل معرف متميز داخل مجموعة البيانات. ضع في اعتبارك البيانات التالية: select d...برمجة نشرت في 2025-01-31

كيفية استرداد الصف الأخير بكفاءة لكل معرف فريد في postgresql؟postgresql: استخراج الصف الأخير لكل معرف فريد الصف الأخير المرتبط بكل معرف متميز داخل مجموعة البيانات. ضع في اعتبارك البيانات التالية: select d...برمجة نشرت في 2025-01-31 -

لماذا لا يوجد طلب آخر لالتقاط المدخلات في PHP على الرغم من الرمز الصحيح؟_post ['ss'] ؛؟>برمجة نشرت في 2025-01-31

لماذا لا يوجد طلب آخر لالتقاط المدخلات في PHP على الرغم من الرمز الصحيح؟_post ['ss'] ؛؟>برمجة نشرت في 2025-01-31

دراسة اللغة الصينية

- 1 كيف تقول "المشي" باللغة الصينية؟ 走路 نطق الصينية، 走路 تعلم اللغة الصينية

- 2 كيف تقول "استقل طائرة" بالصينية؟ 坐飞机 نطق الصينية، 坐飞机 تعلم اللغة الصينية

- 3 كيف تقول "استقل القطار" بالصينية؟ 坐火车 نطق الصينية، 坐火车 تعلم اللغة الصينية

- 4 كيف تقول "استقل الحافلة" باللغة الصينية؟ 坐车 نطق الصينية، 坐车 تعلم اللغة الصينية

- 5 كيف أقول القيادة باللغة الصينية؟ 开车 نطق الصينية، 开车 تعلم اللغة الصينية

- 6 كيف تقول السباحة باللغة الصينية؟ 游泳 نطق الصينية، 游泳 تعلم اللغة الصينية

- 7 كيف يمكنك أن تقول ركوب الدراجة باللغة الصينية؟ 骑自行车 نطق الصينية، 骑自行车 تعلم اللغة الصينية

- 8 كيف تقول مرحبا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 9 كيف تقول شكرا باللغة الصينية؟ # نطق اللغة الصينية، # تعلّم اللغة الصينية

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning